|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Openai O1やDeepSeek R1などのモデルによって例示されるこのアプローチは、推論中に追加の計算リソースを活用することにより、モデルのパフォーマンスを向上させます。

Recent advancements in AI scaling laws have shifted from merely increasing model size and training data to optimising inference-time computation. This approach, exemplified by models like OpenAI’s GPT-4 and DeepMind's DeepSeek R1, enhances model performance by leveraging additional computational resources during inference.

AIスケーリング法の最近の進歩は、単にモデルサイズとトレーニングデータを増やすことから、推論時間計算の最適化にシフトしました。 OpenaiのGPT-4やDeepmindのDeepSeek R1などのモデルによって例示されるこのアプローチは、推論中に追加の計算リソースを活用することにより、モデルのパフォーマンスを向上させます。

Test-time budget forcing has emerged as an efficient technique in large language models (LLMs), enabling improved performance with minimal token generation. Similarly, inference-time scaling has gained traction in diffusion models, particularly in reward-based sampling, where iterative refinement helps generate outputs that better align with user preferences. This method is crucial for text-to-image generation, where naïve sampling often fails to fully capture intricate specifications, such as object relationships and logical constraints.

テスト時間の予算の強制は、大規模な言語モデル(LLM)の効率的な手法として浮上しており、トークンの生成を最小限に抑えることでパフォーマンスを向上させることができます。同様に、推論時間スケーリングは、拡散モデル、特に報酬ベースのサンプリングで牽引力を獲得しました。このサンプリングでは、反復的な改良がユーザーの好みに合った出力を生成するのに役立ちます。この方法は、テキストからイメージまでの生成に重要です。この方法では、ナイーブなサンプルがオブジェクト関係や論理的制約などの複雑な仕様を完全にキャプチャできないことがよくあります。

Inference-time scaling methods for diffusion models can be broadly categorized into fine-tuning-based and particle-sampling approaches. Fine-tuning improves model alignment with specific tasks but requires retraining for each use case, limiting scalability. In contrast, particle sampling—used in techniques like SVDD and CoDe—selects high-reward samples iteratively during denoising, significantly improving output quality.

拡散モデルの推論時間スケーリング方法は、微調整ベースおよび粒子サンプリングアプローチに広く分類できます。微調整は、特定のタスクとのモデルアラインメントを改善しますが、各ユースケースの再試行が必要であり、スケーラビリティが制限されます。対照的に、SVDDやコードなどの手法で使用される粒子サンプリングは、除去中に高報酬サンプルを繰り返し選択し、出力品質を大幅に改善します。

While these methods have been effective for diffusion models, their application to flow models has been limited due to the deterministic nature of their generation process. Recent work, including SoP, has introduced stochasticity to flow models, enabling particle sampling-based inference-time scaling. This study expands on such efforts by modifying the reverse kernel, further enhancing sampling diversity and effectiveness in flow-based generative models.

これらの方法は拡散モデルに効果的でしたが、それらの生成プロセスの決定的な性質により、フローモデルへの適用は制限されています。 SOPを含む最近の研究は、フローモデルに確率性を導入し、粒子サンプリングベースの推論時間スケーリングを可能にします。この研究は、逆カーネルを変更することにより、このような取り組みを拡大し、フローベースの生成モデルにおけるサンプリングの多様性と有効性をさらに強化します。

Researchers from KAIST propose an inference-time scaling method for pretrained flow models, addressing their limitations in particle sampling due to a deterministic generative process. They introduce three key innovations:

KAISTの研究者は、事前に保護されたフローモデルの推論時間スケーリング方法を提案し、決定論的生成プロセスによる粒子サンプリングの制限に対処します。彼らは3つの重要な革新を紹介します:

1. SDE-based generation to enable stochastic sampling.

1。確率的サンプリングを有効にするSDEベースの世代。

2. VP interpolant conversion for enhancing sample diversity.

2。サンプルの多様性を高めるためのVP補間変換。

3. Rollover Budget Forcing (RBF) for adaptive computational resource allocation.

3。適応的な計算リソース割り当てのためのロールオーバー予算の強制(RBF)。

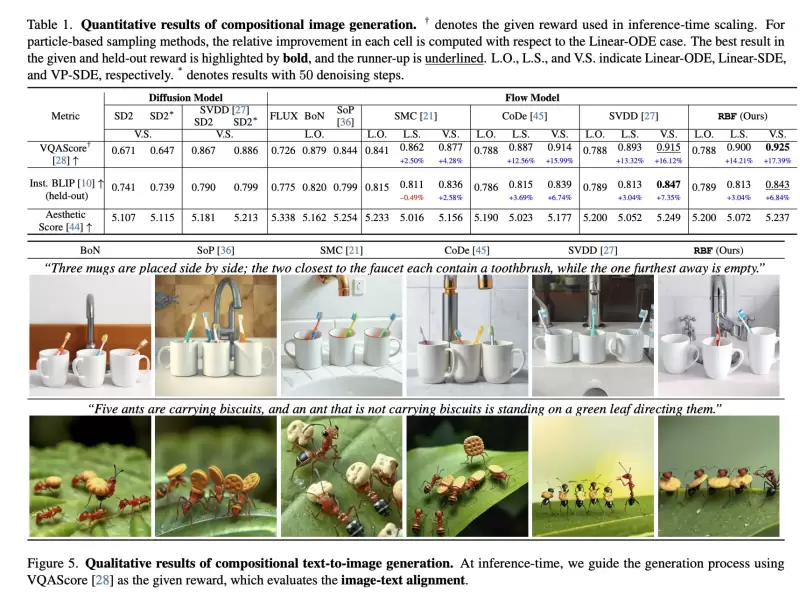

Experimental results on compositional text-to-image generation tasks with FLUX, a pretrained flow model, demonstrate that these techniques effectively improve reward alignment. The proposed approach outperforms prior methods, showcasing the advantages of inference-time scaling in flow models, particularly when combined with gradient-based techniques for differentiable rewards like aesthetic image generation.

前提条件のフローモデルであるフラックスを使用した組成テキストから画像から画像の生成タスクに関する実験結果は、これらの手法が報酬の調整を効果的に改善することを示しています。提案されたアプローチは、フローモデルの推論時間スケーリングの利点を示し、特に美的画像生成のような微分可能な報酬の勾配ベースの手法と組み合わせる場合、以前の方法よりも優れています。

Inference-Time Reward Alignment in Pretrained Flow Models via Particle Sampling

粒子サンプリングを介した前処理されたフローモデルの推論時間報酬アライメント

粒子サンプリングを介した前処理されたフローモデルの推論時間報酬アライメント

The goal of inference-time reward alignment is to generate high-reward samples from a pretrained flow model without any retraining. The objective is defined as follows:

推論時間報酬アライメントの目標は、再訓練なしに、前処理されたフローモデルから高報酬サンプルを生成することです。目的は次のように定義されます。

where R denotes the reward function and p(x) represents the original data distribution, which we aim to minimize using KL divergence to maintain image quality.

ここで、Rは報酬関数を示し、P(x)は元のデータ分布を表します。これは、KLの発散を最小限に抑えて画質を維持することを目指しています。

Since direct sampling from p(x) is challenging, the study adapts particle sampling techniques commonly used in diffusion models. However, flow models rely on deterministic sampling, limiting exploration in new directions despite high-reward samples being found in early iterations. To address this, the researchers introduce inference-time stochastic sampling by converting deterministic processes into stochastic ones.

P(x)からの直接サンプリングは困難であるため、この研究は拡散モデルで一般的に使用される粒子サンプリング手法を適応させます。ただし、フローモデルは決定論的なサンプリングに依存しており、早期の繰り返しで高報酬のサンプルが見つかったにもかかわらず、新しい方向の探索を制限します。これに対処するために、研究者は、決定論的プロセスを確率的プロセスに変換することにより、推論時間の確率的サンプリングを導入します。

Moreover, they propose interpolant conversion to enlarge the search space and improve diversity by aligning flow model sampling with diffusion models. A dynamic compute allocation strategy is employed to enhance efficiency during inference-time scaling.

さらに、彼らは、拡散モデルとフローモデルのサンプリングを調整することにより、検索スペースを拡大し、多様性を改善するために補間的な変換を提案します。動的計算割り当て戦略が採用され、推論時のスケーリング中の効率を高めます。

The study presents experimental results on particle sampling methods for inference-time reward alignment, focusing on compositional text-to-image and quantity-aware image generation tasks using FLUX as the pretrained flow model. Metrics such as VQAScore and RSS are used to assess alignment and accuracy.

この研究では、推論時の報酬アライメントの粒子サンプリング方法に関する実験結果を提示します。 VQASCOREやRSSなどのメトリックは、アラインメントと精度を評価するために使用されます。

The results indicate that inference-time stochastic sampling improves efficiency, and interpolant conversion further enhances performance. Flow-based particle sampling yields high-reward outputs compared to diffusion models without compromising image quality. The proposed RBF method effectively optimizes budget allocation, achieving the best reward alignment and accuracy results.

結果は、推論時間の確率的サンプリングが効率を改善し、補間変換がパフォーマンスをさらに向上させることを示しています。フローベースの粒子サンプリングは、画質を損なうことなく、拡散モデルと比較して高報酬の出力を生成します。提案されたRBFメソッドは、予算の割り当てを効果的に最適化し、最良の報酬の調整と精度の結果を達成します。

Qualitative and quantitative findings confirm the effectiveness of this approach in generating precise, high-quality images.

定性的および定量的な調査結果は、正確で高品質の画像を生成する際のこのアプローチの有効性を確認します。

In summary, this research introduces an inference-time scaling method for flow models, incorporating three key innovations:

要約すると、この研究では、3つの重要な革新を組み込んだフローモデルの推論時間スケーリング方法を紹介します。

1. ODE-to-SDE conversion for enabling particle sampling.

1。粒子サンプリングを有効にするためのODE-to-SDE変換。

2. Linear-to-VP interpolant conversion to enhance diversity and search efficiency.

2。多様性と検索効率を向上させるための線形からVPの補間変換。

3. RBF for adaptive compute allocation.

3。適応計算割り当てのためのRBF。

While diffusion models benefit from stochastic sampling during denoising, flow models require tailored approaches due to their deterministic nature. The proposed VP-SDE-based generation effectively integrates particle sampling, and RBF optimizes compute usage. Experimental results demonstrate that this method surpasses existing inference-time scaling techniques, improving performance while maintaining high-quality outputs in flow-based image and video generation models.

拡散モデルは、除去中の確率的サンプリングの恩恵を受けますが、フローモデルには、決定論的な性質のためにカスタマイズされたアプローチが必要です。提案されているVP-SDEベースの世代は、粒子サンプリングを効果的に統合し、RBFは計算使用量を最適化します。実験結果は、この方法が既存の推論時間スケーリング手法を上回り、フローベースの画像およびビデオ生成モデルの高品質の出力を維持しながらパフォーマンスを向上させることを示しています。

免責事項:info@kdj.com

提供される情報は取引に関するアドバイスではありません。 kdj.com は、この記事で提供される情報に基づいて行われた投資に対して一切の責任を負いません。暗号通貨は変動性が高いため、十分な調査を行った上で慎重に投資することを強くお勧めします。

このウェブサイトで使用されているコンテンツが著作権を侵害していると思われる場合は、直ちに当社 (info@kdj.com) までご連絡ください。速やかに削除させていただきます。

-

-

- Shiba Inu(SHIB)価格分析

- 2025-04-24 04:10:12

- 入力:出力:タイトル:SubBDの分散型クリエータースイートは、デジタルコンテンツの収益化方法を再定義することができます

-

-

-

-

-

-

-