|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

Les progrès récents des lois sur l'échelle de l'IA sont passés de la simple augmentation des données de la taille du modèle et de la formation à l'optimisation du calcul du temps d'inférence

Mar 30, 2025 at 02:48 am

Cette approche, illustrée par des modèles comme OpenAI O1 et Deepseek R1, améliore les performances du modèle en tirant parti des ressources de calcul supplémentaires pendant l'inférence.

Recent advancements in AI scaling laws have shifted from merely increasing model size and training data to optimising inference-time computation. This approach, exemplified by models like OpenAI’s GPT-4 and DeepMind's DeepSeek R1, enhances model performance by leveraging additional computational resources during inference.

Les progrès récents dans les lois sur l'échelle de l'IA sont passés de la simple augmentation des données de la taille du modèle et de la formation à l'optimisation du calcul du temps d'inférence. Cette approche, illustrée par des modèles comme le GPT-4 d'OpenAI et Deepseek R1 de DeepMind, améliore les performances du modèle en tirant parti des ressources de calcul supplémentaires pendant l'inférence.

Test-time budget forcing has emerged as an efficient technique in large language models (LLMs), enabling improved performance with minimal token generation. Similarly, inference-time scaling has gained traction in diffusion models, particularly in reward-based sampling, where iterative refinement helps generate outputs that better align with user preferences. This method is crucial for text-to-image generation, where naïve sampling often fails to fully capture intricate specifications, such as object relationships and logical constraints.

Le forçage budgétaire de test est devenu une technique efficace dans les modèles de grands langues (LLM), permettant une amélioration des performances avec une génération de jetons minimale. De même, la mise à l'échelle du temps d'inférence a gagné du terrain dans les modèles de diffusion, en particulier dans l'échantillonnage basé sur les récompenses, où le raffinement itératif aide à générer des sorties qui s'alignent mieux avec les préférences des utilisateurs. Cette méthode est cruciale pour la génération de texte à l'image, où l'échantillonnage naïf ne parvient souvent pas à capturer pleinement les spécifications complexes, telles que les relations d'objet et les contraintes logiques.

Inference-time scaling methods for diffusion models can be broadly categorized into fine-tuning-based and particle-sampling approaches. Fine-tuning improves model alignment with specific tasks but requires retraining for each use case, limiting scalability. In contrast, particle sampling—used in techniques like SVDD and CoDe—selects high-reward samples iteratively during denoising, significantly improving output quality.

Les méthodes de mise à l'échelle du temps d'inférence pour les modèles de diffusion peuvent être largement classées en approches à base de réglage fin et échantillonnage de particules. Le réglage fin améliore l'alignement du modèle avec des tâches spécifiques mais nécessite un recyclage pour chaque cas d'utilisation, limitant l'évolutivité. En revanche, l'échantillonnage des particules - utilisé dans des techniques telles que le SVDD et le code - sélectionne des échantillons à forte récompense de manière itérative pendant le débarras, améliorant considérablement la qualité de sortie.

While these methods have been effective for diffusion models, their application to flow models has been limited due to the deterministic nature of their generation process. Recent work, including SoP, has introduced stochasticity to flow models, enabling particle sampling-based inference-time scaling. This study expands on such efforts by modifying the reverse kernel, further enhancing sampling diversity and effectiveness in flow-based generative models.

Bien que ces méthodes aient été efficaces pour les modèles de diffusion, leur application aux modèles d'écoulement a été limitée en raison de la nature déterministe de leur processus de génération. Des travaux récents, y compris SOP, ont introduit des modèles de stochasticité à l'écoulement, permettant une échelle de temps d'inférence basée sur l'échantillonnage des particules. Cette étude élargit de tels efforts en modifiant le noyau inversé, améliorant davantage la diversité et l'efficacité de l'échantillonnage dans les modèles génératifs basés sur le débit.

Researchers from KAIST propose an inference-time scaling method for pretrained flow models, addressing their limitations in particle sampling due to a deterministic generative process. They introduce three key innovations:

Les chercheurs de Kaist proposent une méthode de mise à l'échelle du temps d'inférence pour les modèles d'écoulement pré-entraîné, traitant leurs limites d'échantillonnage de particules en raison d'un processus génératif déterministe. Ils introduisent trois innovations clés:

1. SDE-based generation to enable stochastic sampling.

1. Génération basée sur SDE pour permettre l'échantillonnage stochastique.

2. VP interpolant conversion for enhancing sample diversity.

2. Conversion interpolante VP pour améliorer la diversité des échantillons.

3. Rollover Budget Forcing (RBF) for adaptive computational resource allocation.

3. Forçage du budget de roulement (RBF) pour l'allocation adaptative des ressources de calcul.

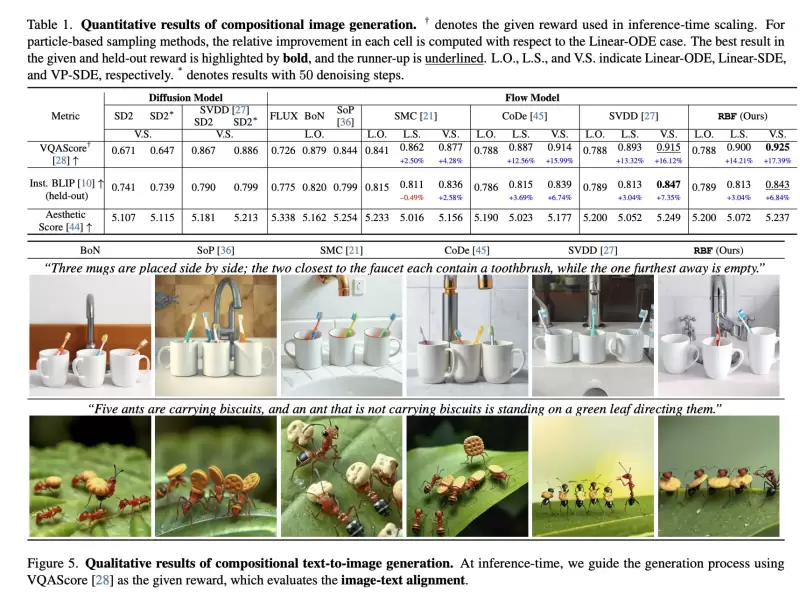

Experimental results on compositional text-to-image generation tasks with FLUX, a pretrained flow model, demonstrate that these techniques effectively improve reward alignment. The proposed approach outperforms prior methods, showcasing the advantages of inference-time scaling in flow models, particularly when combined with gradient-based techniques for differentiable rewards like aesthetic image generation.

Résultats expérimentaux sur les tâches de génération de texte à l'image compositionnelles avec flux, un modèle d'écoulement pré-entraîné, démontrent que ces techniques améliorent efficacement l'alignement de récompense. L'approche proposée surpasse les méthodes antérieures, présentant les avantages de la mise à l'échelle du temps d'inférence dans les modèles de flux, en particulier lorsqu'il est combiné avec des techniques basées sur le gradient pour des récompenses différenciables comme la génération d'images esthétique.

Inference-Time Reward Alignment in Pretrained Flow Models via Particle Sampling

Alignement de récompense du temps d'inférence dans les modèles d'écoulement pré-entraînés via l'échantillonnage des particules

Alignement de récompense du temps d'inférence dans les modèles d'écoulement pré-entraînés via l'échantillonnage des particules

The goal of inference-time reward alignment is to generate high-reward samples from a pretrained flow model without any retraining. The objective is defined as follows:

L'objectif de l'alignement de récompense en temps d'inférence est de générer des échantillons à forte récompense à partir d'un modèle d'écoulement pré-entraîné sans recyclage. L'objectif est défini comme suit:

where R denotes the reward function and p(x) represents the original data distribution, which we aim to minimize using KL divergence to maintain image quality.

où r désigne la fonction de récompense et P (x) représente la distribution des données d'origine, que nous visons à minimiser l'utilisation de la divergence de KL pour maintenir la qualité de l'image.

Since direct sampling from p(x) is challenging, the study adapts particle sampling techniques commonly used in diffusion models. However, flow models rely on deterministic sampling, limiting exploration in new directions despite high-reward samples being found in early iterations. To address this, the researchers introduce inference-time stochastic sampling by converting deterministic processes into stochastic ones.

Étant donné que l'échantillonnage direct de P (x) est difficile, l'étude adapte les techniques d'échantillonnage des particules couramment utilisées dans les modèles de diffusion. Cependant, les modèles d'écoulement reposent sur un échantillonnage déterministe, limitant l'exploration dans de nouvelles directions malgré les échantillons à forte récompense trouvés dans les premières itérations. Pour y remédier, les chercheurs introduisent un échantillonnage stochastique en temps inférieur en convertissant les processus déterministes en produits stochastiques.

Moreover, they propose interpolant conversion to enlarge the search space and improve diversity by aligning flow model sampling with diffusion models. A dynamic compute allocation strategy is employed to enhance efficiency during inference-time scaling.

De plus, ils proposent une conversion interpolante pour élargir l'espace de recherche et améliorer la diversité en alignant l'échantillonnage du modèle d'écoulement avec des modèles de diffusion. Une stratégie d'allocation de calcul dynamique est utilisée pour améliorer l'efficacité pendant la mise à l'échelle du temps d'inférence.

The study presents experimental results on particle sampling methods for inference-time reward alignment, focusing on compositional text-to-image and quantity-aware image generation tasks using FLUX as the pretrained flow model. Metrics such as VQAScore and RSS are used to assess alignment and accuracy.

L'étude présente des résultats expérimentaux sur les méthodes d'échantillonnage des particules pour l'alignement de récompense du temps d'inférence, en se concentrant sur les tâches de génération d'images de texte à l'image à l'image et à la quantité en utilisant le flux comme modèle d'écoulement pré-entraîné. Des mesures telles que VQASCORE et RSS sont utilisées pour évaluer l'alignement et la précision.

The results indicate that inference-time stochastic sampling improves efficiency, and interpolant conversion further enhances performance. Flow-based particle sampling yields high-reward outputs compared to diffusion models without compromising image quality. The proposed RBF method effectively optimizes budget allocation, achieving the best reward alignment and accuracy results.

Les résultats indiquent que l'échantillonnage stochastique en temps d'inférence améliore l'efficacité et que la conversion interpolante améliore encore les performances. L'échantillonnage des particules basé sur le débit fournit des sorties à haute récompense par rapport aux modèles de diffusion sans compromettre la qualité de l'image. La méthode RBF proposée optimise efficacement l'allocation budgétaire, atteignant les meilleurs résultats d'alignement de récompense et de précision.

Qualitative and quantitative findings confirm the effectiveness of this approach in generating precise, high-quality images.

Les résultats qualitatifs et quantitatifs confirment l'efficacité de cette approche pour générer des images précises et de haute qualité.

In summary, this research introduces an inference-time scaling method for flow models, incorporating three key innovations:

En résumé, cette recherche introduit une méthode de mise à l'échelle du temps d'inférence pour les modèles de flux, incorporant trois innovations clés:

1. ODE-to-SDE conversion for enabling particle sampling.

1. Conversion Ode-to-SDE pour l'activation de l'échantillonnage des particules.

2. Linear-to-VP interpolant conversion to enhance diversity and search efficiency.

2. Conversion interpolante linéaire à VP pour améliorer la diversité et l'efficacité de la recherche.

3. RBF for adaptive compute allocation.

3. RBF pour l'allocation de calcul adaptative.

While diffusion models benefit from stochastic sampling during denoising, flow models require tailored approaches due to their deterministic nature. The proposed VP-SDE-based generation effectively integrates particle sampling, and RBF optimizes compute usage. Experimental results demonstrate that this method surpasses existing inference-time scaling techniques, improving performance while maintaining high-quality outputs in flow-based image and video generation models.

Bien que les modèles de diffusion bénéficient d'un échantillonnage stochastique pendant le débroussage, les modèles d'écoulement nécessitent des approches sur mesure en raison de leur nature déterministe. La génération basée sur VP-SDE proposée intègre efficacement l'échantillonnage des particules et RBF optimise l'utilisation de calcul. Les résultats expérimentaux démontrent que cette méthode dépasse les techniques de mise à l'échelle du temps d'inférence existantes, améliorant les performances tout en conservant des sorties de haute qualité dans les modèles d'image et de génération de vidéo basés sur le flux.

Clause de non-responsabilité:info@kdj.com

Les informations fournies ne constituent pas des conseils commerciaux. kdj.com n’assume aucune responsabilité pour les investissements effectués sur la base des informations fournies dans cet article. Les crypto-monnaies sont très volatiles et il est fortement recommandé d’investir avec prudence après une recherche approfondie!

Si vous pensez que le contenu utilisé sur ce site Web porte atteinte à vos droits d’auteur, veuillez nous contacter immédiatement (info@kdj.com) et nous le supprimerons dans les plus brefs délais.

-

- Bitcoin (BTC) Les cycles de moitié peuvent se décomposer, suggérant que le marché évolue - par James Romero

- Apr 24, 2025 at 04:10 am

- Pendant des années, les investisseurs cryptographiques se sont tournés vers le cycle de quatre ans, ancré autour des événements de division de Bitcoin, comme une sorte de feuille de route sacrée.

-

-

- La prévente de Solaxy (Solx) atteint 30 millions de dollars à mesure que le battage médiatique de la pièce meme se construit

- Apr 24, 2025 at 04:05 am

- Le secteur en plein essor des pièces de mèmes a tourné son attention vers la prévente de Solaxy, qui a déjà attiré plus de 30 millions de dollars de financement précoce.

-

-

- La prévente Bitcoin Pepe (BPEP) approche de 7 millions de dollars alors que la demande de monnaie meme reste chaud

- Apr 24, 2025 at 04:00 am

- Tout en s'exprimant mardi à la Maison Blanche, Donald Trump a exprimé son optimisme quant à l'amélioration des relations commerciales avec la Chine. Il a déclaré lors d'une conférence de presse à la Maison Blanche qui a élevé des tarifs sur les produits en provenance de Chine «baisserait considérablement, bien qu'ils ne soient pas réduits à zéro».

-

-

- Les investisseurs institutionnels de Bitcoin (BTC) ont empilé plus de onze fois la moyenne de tous les temps dans les fonds (ETF) de Bitcoin échangeurs de Bitcoin, le 22 avril.

- Apr 24, 2025 at 03:55 am

- De nouvelles données de l'entreprise d'analyse d'Onchain Glassnode confirment que les entrées de 912 millions de dollars ETF équivalent à plus de 500 fois la moyenne quotidienne de 2025.

-

-