|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Nachrichtenartikel zu Kryptowährungen

Die jüngsten Fortschritte bei den KI-Skalierungsgesetzen haben sich von der lediglichen Erhöhung der Modellgröße und der Schulungsdaten zur Optimierung der Inferenzzeitberechnung verlagert

Mar 30, 2025 at 02:48 am

Dieser Ansatz, der durch Modelle wie OpenAI O1 und Deepseek R1 veranschaulicht wird, verbessert die Modellleistung, indem zusätzliche Rechenressourcen während der Inferenz genutzt werden.

Recent advancements in AI scaling laws have shifted from merely increasing model size and training data to optimising inference-time computation. This approach, exemplified by models like OpenAI’s GPT-4 and DeepMind's DeepSeek R1, enhances model performance by leveraging additional computational resources during inference.

Die jüngsten Fortschritte bei den KI-Skalierungsgesetzen haben sich von der lediglichen Erhöhung der Modellgröße und der Schulungsdaten zur Optimierung der Inferenzzeitberechnung verlagert. Dieser Ansatz, der durch Modelle wie GPT-4 von OpenAI und DeepMinds Deepseek R1 veranschaulicht wird, verbessert die Modellleistung, indem zusätzliche Rechenressourcen während der Inferenz genutzt werden.

Test-time budget forcing has emerged as an efficient technique in large language models (LLMs), enabling improved performance with minimal token generation. Similarly, inference-time scaling has gained traction in diffusion models, particularly in reward-based sampling, where iterative refinement helps generate outputs that better align with user preferences. This method is crucial for text-to-image generation, where naïve sampling often fails to fully capture intricate specifications, such as object relationships and logical constraints.

Das Erzwingen des Testzeitbudgets hat sich als effiziente Technik in Großsprachmodellen (LLMs) als effiziente Technik entwickelt, die eine verbesserte Leistung mit minimaler Token-Generation ermöglicht. In ähnlicher Weise hat die Skalierung der Inferenzzeit in Diffusionsmodellen, insbesondere bei Belohnungsbasis, an Traktion gewonnen, bei denen die iterative Verfeinerung dazu beiträgt, Ausgänge zu generieren, die besser mit den Benutzerpräferenzen übereinstimmen. Diese Methode ist für die Erzeugung der Text-zu-Image-Erzeugung von entscheidender Bedeutung, wobei naive Stichproben häufig nicht vollständig komplizierte Spezifikationen wie Objektbeziehungen und logische Einschränkungen erfassen können.

Inference-time scaling methods for diffusion models can be broadly categorized into fine-tuning-based and particle-sampling approaches. Fine-tuning improves model alignment with specific tasks but requires retraining for each use case, limiting scalability. In contrast, particle sampling—used in techniques like SVDD and CoDe—selects high-reward samples iteratively during denoising, significantly improving output quality.

Skalierungsmethoden für Inferenzzeiten für Diffusionsmodelle können weitgehend in feinstimmbasierte und Partikelabtastansätze eingeteilt werden. Die Feinabstimmung verbessert die Modellausrichtung mit spezifischen Aufgaben, erfordert jedoch für jeden Anwendungsfall eine Umschulung, wodurch die Skalierbarkeit eingeschränkt wird. Im Gegensatz dazu wählt die Partikelabtastung-in Techniken wie SVDD und Code-mit hohen Belohnungsproben iterativ während der Denoising aus und verbessert die Ausgangsqualität signifikant.

While these methods have been effective for diffusion models, their application to flow models has been limited due to the deterministic nature of their generation process. Recent work, including SoP, has introduced stochasticity to flow models, enabling particle sampling-based inference-time scaling. This study expands on such efforts by modifying the reverse kernel, further enhancing sampling diversity and effectiveness in flow-based generative models.

Während diese Methoden für Diffusionsmodelle wirksam waren, war ihre Anwendung auf Flussmodelle aufgrund der deterministischen Natur ihres Erzeugungsprozesses begrenzt. Jüngste Arbeiten, einschließlich SOP, haben Stochastizität in Flussmodelle eingeführt, wodurch die auf Partikelabtastbasis basierende Inferenzzeitskalierung ermöglicht wird. Diese Studie erweitert solche Bemühungen, indem der umgekehrte Kernel geändert wird, wodurch die Diversität und Effektivität von Flow-basierten generativen Modellen weiter verbessert wird.

Researchers from KAIST propose an inference-time scaling method for pretrained flow models, addressing their limitations in particle sampling due to a deterministic generative process. They introduce three key innovations:

Forscher von Kaist schlagen eine Skalierungsmethode für die Inferenzzeit für vorbereitete Durchflussmodelle vor, die sich aufgrund eines deterministischen Generativprozesses mit ihren Einschränkungen bei der Teilchenabtastung befassen. Sie führen drei wichtige Innovationen ein:

1. SDE-based generation to enable stochastic sampling.

1. SDE-basierte Generation, um eine stochastische Probenahme zu ermöglichen.

2. VP interpolant conversion for enhancing sample diversity.

2. VP Interpolant Conversion zur Verbesserung der Probenvielfalt.

3. Rollover Budget Forcing (RBF) for adaptive computational resource allocation.

3.. Rollover Budget Forcing (RBF) für die adaptive Computerressourcenzuweisung.

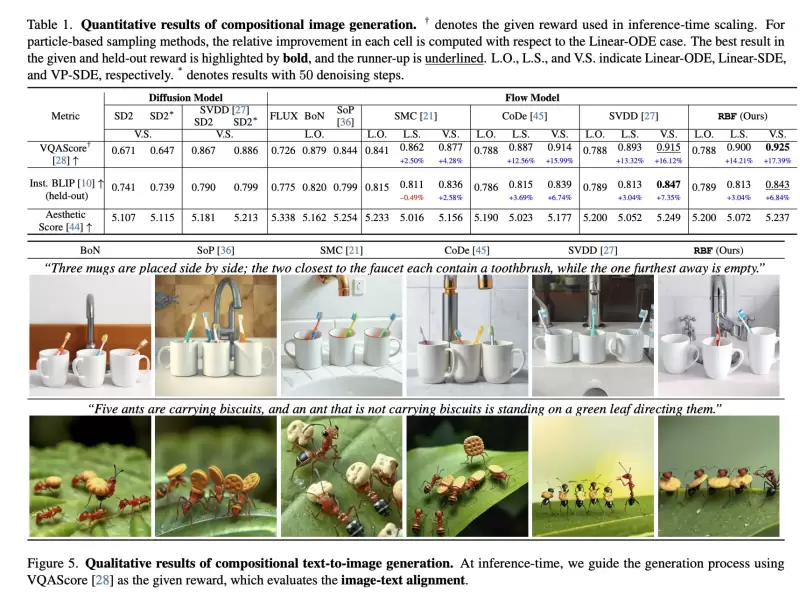

Experimental results on compositional text-to-image generation tasks with FLUX, a pretrained flow model, demonstrate that these techniques effectively improve reward alignment. The proposed approach outperforms prior methods, showcasing the advantages of inference-time scaling in flow models, particularly when combined with gradient-based techniques for differentiable rewards like aesthetic image generation.

Experimentelle Ergebnisse zu Aufgaben zur Erzeugung von Text-zu-im-Im-Im-Im-Im-Im-Im-Im-Image mit Fluss, einem vorgezogenen Flussmodell, zeigen, dass diese Techniken die Belohnungsausrichtung effektiv verbessern. Der vorgeschlagene Ansatz übertrifft frühere Methoden und zeigt die Vorteile der Inferenzzeitskalierung in Flow-Modellen, insbesondere in Kombination mit gradientenbasierten Techniken für differenzierbare Belohnungen wie ästhetischer Bildgenerierung.

Inference-Time Reward Alignment in Pretrained Flow Models via Particle Sampling

Ausrichtung der Inferenzzeit-Belohnung in vorbereiteten Strömungsmodellen über Partikelabtastung

Ausrichtung der Inferenzzeit-Belohnung in vorbereiteten Strömungsmodellen über Partikelabtastung

The goal of inference-time reward alignment is to generate high-reward samples from a pretrained flow model without any retraining. The objective is defined as follows:

Das Ziel der Ausrichtung der Inferenzzeitbelohnung ist es, Proben mit hoher Belohnung aus einem vorbereiteten Flussmodell ohne Umschulung zu erzeugen. Das Ziel ist wie folgt definiert:

where R denotes the reward function and p(x) represents the original data distribution, which we aim to minimize using KL divergence to maintain image quality.

wobei R die Belohnungsfunktion bezeichnet und P (x) die ursprüngliche Datenverteilung darstellt, die wir unter Verwendung der KL -Divergenz minimieren möchten, um die Bildqualität aufrechtzuerhalten.

Since direct sampling from p(x) is challenging, the study adapts particle sampling techniques commonly used in diffusion models. However, flow models rely on deterministic sampling, limiting exploration in new directions despite high-reward samples being found in early iterations. To address this, the researchers introduce inference-time stochastic sampling by converting deterministic processes into stochastic ones.

Da die direkte Probenahme von P (X) eine Herausforderung darstellt, passt die Studie Partikel -Probenahmetechniken an, die üblicherweise in Diffusionsmodellen verwendet werden. Flow-Modelle beruhen jedoch auf deterministische Probenahme und begrenzen die Erforschung in neue Richtungen, obwohl in frühen Iterationen Proben mit hoher Aufwand gefunden wurden. Um dies zu beheben, führen die Forscher eine stochastische Stichprobe für Inferenzzeit ein, indem deterministische Prozesse in stochastische Umwandlung umwandeln.

Moreover, they propose interpolant conversion to enlarge the search space and improve diversity by aligning flow model sampling with diffusion models. A dynamic compute allocation strategy is employed to enhance efficiency during inference-time scaling.

Darüber hinaus schlagen sie eine interpolanische Umwandlung vor, um den Suchraum zu vergrößern und die Vielfalt zu verbessern, indem sie die Abtastung des Durchflussmodells mit Diffusionsmodellen ausrichten. Eine dynamische Strategie zur Allokation der Berechnung wird angewendet, um die Effizienz während der Skalierung der Inferenzzeit zu verbessern.

The study presents experimental results on particle sampling methods for inference-time reward alignment, focusing on compositional text-to-image and quantity-aware image generation tasks using FLUX as the pretrained flow model. Metrics such as VQAScore and RSS are used to assess alignment and accuracy.

In der Studie werden experimentelle Ergebnisse zu Partikel-Probenahmmethoden zur Ausrichtung der Inferenzzeitbelohnung vorgestellt, wobei sich die Aufgaben zur Erzeugung von Zusammensetzungen für Text-zu-Images und Menge unter Verwendung von Flux als vorgezogenem Flussmodell konzentrieren. Metriken wie Vqascore und RSS werden verwendet, um die Ausrichtung und Genauigkeit zu bewerten.

The results indicate that inference-time stochastic sampling improves efficiency, and interpolant conversion further enhances performance. Flow-based particle sampling yields high-reward outputs compared to diffusion models without compromising image quality. The proposed RBF method effectively optimizes budget allocation, achieving the best reward alignment and accuracy results.

Die Ergebnisse zeigen, dass die stochastische Abschlusszeit die Effizienz verbessert und die Interpoleneinheit die Leistung weiter verbessert. Durchflussbasierte Partikelabtastung liefert im Vergleich zu Diffusionsmodellen Hochversande, ohne die Bildqualität zu beeinträchtigen. Die vorgeschlagene RBF -Methode optimiert die Budgetzuweisung effektiv und erzielt die besten Belohnungsausrichtungs- und Genauigkeitsergebnisse.

Qualitative and quantitative findings confirm the effectiveness of this approach in generating precise, high-quality images.

Qualitative und quantitative Ergebnisse bestätigen die Wirksamkeit dieses Ansatzes bei der Erzeugung präziser, hochwertiger Bilder.

In summary, this research introduces an inference-time scaling method for flow models, incorporating three key innovations:

Zusammenfassend lässt sich sagen, dass diese Forschung eine Skalierungsmethode für Inferenzzeit für Flow-Modelle mit drei wichtigen Innovationen einbezieht:

1. ODE-to-SDE conversion for enabling particle sampling.

1. ODE-to-SDE-Umwandlung zum Aktivieren der Partikelabtastung.

2. Linear-to-VP interpolant conversion to enhance diversity and search efficiency.

2. Linear-zu-VP-Interpolanzumwandlung zur Verbesserung der Vielfalt und der Suchffizienz.

3. RBF for adaptive compute allocation.

3.. RBF für adaptive Berechnung zu Allokation.

While diffusion models benefit from stochastic sampling during denoising, flow models require tailored approaches due to their deterministic nature. The proposed VP-SDE-based generation effectively integrates particle sampling, and RBF optimizes compute usage. Experimental results demonstrate that this method surpasses existing inference-time scaling techniques, improving performance while maintaining high-quality outputs in flow-based image and video generation models.

Während Diffusionsmodelle während des Denoisierungsmodells von stochastischer Probenahme profitieren, erfordern Durchflussmodelle aufgrund ihrer deterministischen Natur maßgeschneiderte Ansätze. Die vorgeschlagene Generation auf der VP-SDE-basierten Integration integriert die Partikelabtastung effektiv, und RBF optimiert die Berechnung. Experimentelle Ergebnisse zeigen, dass diese Methode vorhandene Skalierungstechniken der Inferenzzeit übertrifft und die Leistung verbessert und gleichzeitig qualitativ hochwertige Ausgaben in fließbasierten Bild- und Videogenerierungsmodellen aufrechterhalten.

Haftungsausschluss:info@kdj.com

Die bereitgestellten Informationen stellen keine Handelsberatung dar. kdj.com übernimmt keine Verantwortung für Investitionen, die auf der Grundlage der in diesem Artikel bereitgestellten Informationen getätigt werden. Kryptowährungen sind sehr volatil und es wird dringend empfohlen, nach gründlicher Recherche mit Vorsicht zu investieren!

Wenn Sie glauben, dass der auf dieser Website verwendete Inhalt Ihr Urheberrecht verletzt, kontaktieren Sie uns bitte umgehend (info@kdj.com) und wir werden ihn umgehend löschen.

-

-

-

-

-

- Bitcoin Pepe (BPEP) Vorverkauf kostet 7 Mio. USD, da die Meme -Münznachfrage heiß bleibt

- Apr 24, 2025 at 04:00 am

- Während er am Dienstag im Weißen Haus sprach, äußerte Donald Trump optimistisch, die Handelsbeziehungen mit China zu verbessern. Er erklärte auf einer Pressekonferenz des Weißen Hauses, dass die Zölle für Produkte aus China "erheblich sinken werden, obwohl sie nicht auf Null reduziert werden".

-

-

- Institutionelle Anleger von Bitcoin (BTC) stapelten sich am 22. April über elf Mal den Allzeitdurchschnitt in die US-Spot-Bitcoin-Exchange-Fonds (ETFs).

- Apr 24, 2025 at 03:55 am

- Frische Daten des Onchain Analytics -Unternehmens GlassNode bestätigen, dass der ETF -Zustrom von 912 Millionen US -Dollar mehr als das 500 -fache des täglichen 2025 -täglichen Durchschnitts entspricht.

-

-