|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

OpenAi O1 및 DeepSeek R1과 같은 모델로 예시 된이 접근법은 추론 중에 추가 계산 자원을 활용하여 모델 성능을 향상시킵니다.

Recent advancements in AI scaling laws have shifted from merely increasing model size and training data to optimising inference-time computation. This approach, exemplified by models like OpenAI’s GPT-4 and DeepMind's DeepSeek R1, enhances model performance by leveraging additional computational resources during inference.

AI 스케일링 법의 최근 발전은 단순히 모델 크기와 교육 데이터를 증가시키는 것에서 추론 시간 계산을 최적화하는 것으로 바뀌 었습니다. OpenAI의 GPT-4 및 DeepMind의 DeepSeek R1과 같은 모델로 예시 된이 접근법은 추론 중에 추가 계산 리소스를 활용하여 모델 성능을 향상시킵니다.

Test-time budget forcing has emerged as an efficient technique in large language models (LLMs), enabling improved performance with minimal token generation. Similarly, inference-time scaling has gained traction in diffusion models, particularly in reward-based sampling, where iterative refinement helps generate outputs that better align with user preferences. This method is crucial for text-to-image generation, where naïve sampling often fails to fully capture intricate specifications, such as object relationships and logical constraints.

테스트 시간 예산 강제력은 대형 언어 모델 (LLM)에서 효율적인 기술로 등장하여 최소한의 토큰 생성으로 성능 향상을 가능하게했습니다. 마찬가지로, 추론 시간 스케일링은 확산 모델, 특히 보상 기반 샘플링에서 견인력을 얻었으며, 반복 정제는 사용자 선호도에 더 잘 맞는 출력을 생성하는 데 도움이됩니다. 이 방법은 순진한 샘플링이 종종 객체 관계 및 논리적 제약과 같은 복잡한 사양을 완전히 캡처하지 못하는 텍스트-이미지 생성에 중요합니다.

Inference-time scaling methods for diffusion models can be broadly categorized into fine-tuning-based and particle-sampling approaches. Fine-tuning improves model alignment with specific tasks but requires retraining for each use case, limiting scalability. In contrast, particle sampling—used in techniques like SVDD and CoDe—selects high-reward samples iteratively during denoising, significantly improving output quality.

확산 모델에 대한 추론 시간 스케일링 방법은 광범위하게 미세 조정 기반 및 입자 샘플링 접근법으로 분류 될 수 있습니다. 미세 조정은 특정 작업과의 모델 정렬을 향상 시키지만 각 사용 사례에 대해 재교육이 필요하므로 확장 성을 제한합니다. 대조적으로, SVDD 및 코드와 같은 기술에 사용 된 입자 샘플링은 비난 중에 반복적으로 높은 보상 샘플을 선택하여 출력 품질을 크게 향상시킵니다.

While these methods have been effective for diffusion models, their application to flow models has been limited due to the deterministic nature of their generation process. Recent work, including SoP, has introduced stochasticity to flow models, enabling particle sampling-based inference-time scaling. This study expands on such efforts by modifying the reverse kernel, further enhancing sampling diversity and effectiveness in flow-based generative models.

이러한 방법은 확산 모델에 효과적 이었지만, 유동 모델에 대한 적용은 생성 공정의 결정 론적 특성으로 인해 제한되어왔다. SOP를 포함한 최근의 연구는 흐름 모델에 대한 확률 론성을 도입하여 입자 샘플링 기반 추론 시간 스케일링을 가능하게했습니다. 이 연구는 역 커널을 수정하여 이러한 노력을 확장하여 흐름 기반 생성 모델의 샘플링 다양성과 효과를 더욱 향상시킵니다.

Researchers from KAIST propose an inference-time scaling method for pretrained flow models, addressing their limitations in particle sampling due to a deterministic generative process. They introduce three key innovations:

KAIST의 연구원들은 사전 배치 된 흐름 모델에 대한 추론 시간 스케일링 방법을 제안하여 결정 론적 생성 프로세스로 인한 입자 샘플링의 한계를 해결합니다. 그들은 세 가지 주요 혁신을 소개합니다.

1. SDE-based generation to enable stochastic sampling.

1. 확률 샘플링을 가능하게하는 SDE 기반 생성.

2. VP interpolant conversion for enhancing sample diversity.

2. 샘플 다양성을 향상시키기위한 VP 상호 전환.

3. Rollover Budget Forcing (RBF) for adaptive computational resource allocation.

3. 적응 형 계산 자원 할당을위한 롤오버 예산 강제 (RBF).

Experimental results on compositional text-to-image generation tasks with FLUX, a pretrained flow model, demonstrate that these techniques effectively improve reward alignment. The proposed approach outperforms prior methods, showcasing the advantages of inference-time scaling in flow models, particularly when combined with gradient-based techniques for differentiable rewards like aesthetic image generation.

프리릿 흐름 모델 인 Flux를 사용하여 구성 텍스트-이미지 생성 작업에 대한 실험 결과는 이러한 기술이 보상 정렬을 효과적으로 향상 시킨다는 것을 보여줍니다. 제안 된 접근법은 이전 방법을 능가하여 유동 모델에서 추론 시간 스케일링의 장점을 보여줍니다. 특히 미적 이미지 생성과 같은 차별화 가능한 보상을위한 그라디언트 기반 기술과 결합 할 때.

Inference-Time Reward Alignment in Pretrained Flow Models via Particle Sampling

입자 샘플링을 통한 사전 상환 흐름 모델의 추론 시간 보상 정렬

입자 샘플링을 통한 사전 상환 흐름 모델의 추론 시간 보상 정렬

The goal of inference-time reward alignment is to generate high-reward samples from a pretrained flow model without any retraining. The objective is defined as follows:

추론 시간 보상 정렬의 목표는 재교육없이 사전에 사전 보상 흐름 모델로부터 높은 보상 샘플을 생성하는 것입니다. 목표는 다음과 같이 정의됩니다.

where R denotes the reward function and p(x) represents the original data distribution, which we aim to minimize using KL divergence to maintain image quality.

여기서 R은 보상 함수를 나타내고 P (x)는 원래 데이터 분포를 나타내며, 이는 이미지 품질을 유지하기 위해 KL 발산을 사용하여 최소화하는 것을 목표로합니다.

Since direct sampling from p(x) is challenging, the study adapts particle sampling techniques commonly used in diffusion models. However, flow models rely on deterministic sampling, limiting exploration in new directions despite high-reward samples being found in early iterations. To address this, the researchers introduce inference-time stochastic sampling by converting deterministic processes into stochastic ones.

p (x)의 직접 샘플링은 어려운 것이기 때문에, 연구는 확산 모델에서 일반적으로 사용되는 입자 샘플링 기술을 조정합니다. 그러나 흐름 모델은 결정적인 샘플링에 의존하여 초기 반복에서 발견 된 높은 보상 샘플에도 불구하고 새로운 방향으로 탐사를 제한합니다. 이를 해결하기 위해 연구원들은 결정 론적 프로세스를 확률 론적 프로세스로 변환함으로써 추론 시간 확률 샘플링을 도입합니다.

Moreover, they propose interpolant conversion to enlarge the search space and improve diversity by aligning flow model sampling with diffusion models. A dynamic compute allocation strategy is employed to enhance efficiency during inference-time scaling.

또한, 그들은 확산 모델과 흐름 모델 샘플링을 정렬하여 검색 공간을 확대하고 다양성을 향상시키기 위해 간호 변환을 제안합니다. 추론 시간 스케일링 동안 효율성을 높이기 위해 동적 컴퓨팅 할당 전략이 사용됩니다.

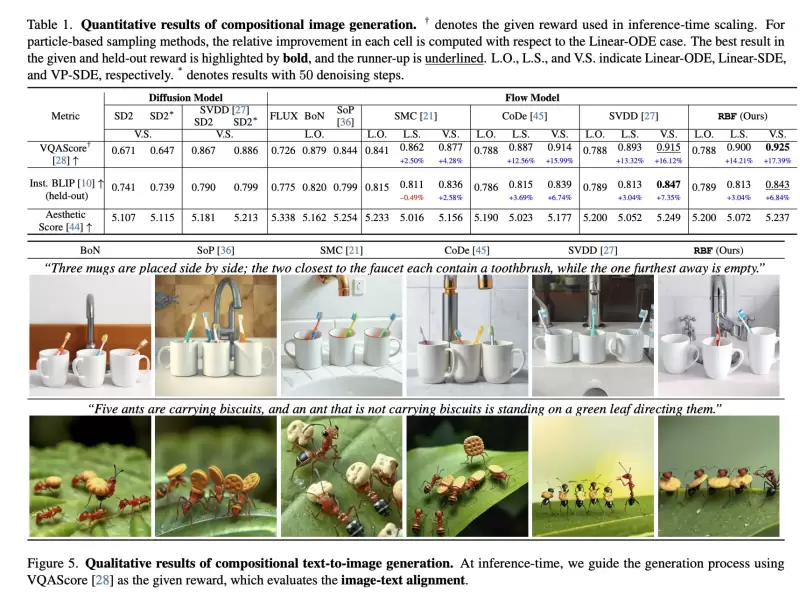

The study presents experimental results on particle sampling methods for inference-time reward alignment, focusing on compositional text-to-image and quantity-aware image generation tasks using FLUX as the pretrained flow model. Metrics such as VQAScore and RSS are used to assess alignment and accuracy.

이 연구는 Flux를 사전에 걸린 흐름 모델로 사용하는 구성 텍스트-이미지 및 수량 인식 이미지 생성 작업에 중점을 둔 추론 시간 보상 정렬을위한 입자 샘플링 방법에 대한 실험 결과를 제시합니다. vqascore 및 RSS와 같은 메트릭은 정렬 및 정확도를 평가하는 데 사용됩니다.

The results indicate that inference-time stochastic sampling improves efficiency, and interpolant conversion further enhances performance. Flow-based particle sampling yields high-reward outputs compared to diffusion models without compromising image quality. The proposed RBF method effectively optimizes budget allocation, achieving the best reward alignment and accuracy results.

결과는 추론 시간 확률 샘플링이 효율성을 향상시키고 간호 변환이 성능을 더욱 향상 시킨다는 것을 나타냅니다. 흐름 기반 입자 샘플링은 이미지 품질을 손상시키지 않은 확산 모델에 비해 높은 보상 출력을 생성합니다. 제안 된 RBF 방법은 예산 할당을 효과적으로 최적화하여 최고의 보상 정렬 및 정확도 결과를 달성합니다.

Qualitative and quantitative findings confirm the effectiveness of this approach in generating precise, high-quality images.

질적 및 정량적 결과는 정확한 고품질 이미지를 생성 할 때이 접근법의 효과를 확인합니다.

In summary, this research introduces an inference-time scaling method for flow models, incorporating three key innovations:

요약하면,이 연구는 세 가지 주요 혁신을 통합 한 흐름 모델에 대한 추론 시간 스케일링 방법을 소개합니다.

1. ODE-to-SDE conversion for enabling particle sampling.

1. 입자 샘플링을 활성화하기위한 ODE-TO-SDE 변환.

2. Linear-to-VP interpolant conversion to enhance diversity and search efficiency.

2. 다양성과 검색 효율성을 향상시키기위한 선형-VP 대기 전환.

3. RBF for adaptive compute allocation.

3. 적응 형 컴퓨팅 할당을위한 RBF.

While diffusion models benefit from stochastic sampling during denoising, flow models require tailored approaches due to their deterministic nature. The proposed VP-SDE-based generation effectively integrates particle sampling, and RBF optimizes compute usage. Experimental results demonstrate that this method surpasses existing inference-time scaling techniques, improving performance while maintaining high-quality outputs in flow-based image and video generation models.

확산 모델은 비난하는 동안 확률 샘플링의 이점이 있지만, 흐름 모델은 결정 론적 특성으로 인해 맞춤형 접근법이 필요합니다. 제안 된 VP-SDE 기반 생성은 입자 샘플링을 효과적으로 통합하고 RBF는 컴퓨팅 사용을 최적화합니다. 실험 결과는이 방법이 기존의 추론 시간 스케일링 기술을 능가하여 성능을 향상시키면서 흐름 기반 이미지 및 비디오 생성 모델에서 고품질 출력을 유지한다는 것을 보여줍니다.

부인 성명:info@kdj.com

제공된 정보는 거래 조언이 아닙니다. kdj.com은 이 기사에 제공된 정보를 기반으로 이루어진 투자에 대해 어떠한 책임도 지지 않습니다. 암호화폐는 변동성이 매우 높으므로 철저한 조사 후 신중하게 투자하는 것이 좋습니다!

본 웹사이트에 사용된 내용이 귀하의 저작권을 침해한다고 판단되는 경우, 즉시 당사(info@kdj.com)로 연락주시면 즉시 삭제하도록 하겠습니다.