|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

FlashInfer : une bibliothèque d'IA et un générateur de noyau adaptés à l'inférence LLM

Jan 05, 2025 at 11:11 am

Les grands modèles linguistiques (LLM) font désormais partie intégrante des applications d'IA modernes, alimentant des outils tels que les chatbots et les générateurs de code. Cependant, le recours croissant à ces modèles a révélé des inefficacités critiques dans les processus d’inférence. Les mécanismes d'attention, tels que FlashAttention et SparseAttention, sont souvent confrontés à des charges de travail diverses, à des modèles de saisie dynamiques et à des limitations de ressources GPU. Ces défis, associés à une latence élevée et à des goulots d'étranglement de mémoire, soulignent la nécessité d'une solution plus efficace et plus flexible pour prendre en charge l'inférence LLM évolutive et réactive.

Large Language Models (LLMs) have become ubiquitous in modern AI applications, powering tools ranging from chatbots to code generators. However, increased reliance on LLMs has highlighted critical inefficiencies in inference processes. Attention mechanisms, such as FlashAttention and SparseAttention, often encounter challenges with diverse workloads, dynamic input patterns, and GPU resource limitations. These hurdles, coupled with high latency and memory bottlenecks, underscore the need for a more efficient and flexible solution to support scalable and responsive LLM inference.

Les grands modèles linguistiques (LLM) sont devenus omniprésents dans les applications d'IA modernes, alimentant des outils allant des chatbots aux générateurs de code. Cependant, le recours accru aux LLM a mis en évidence des inefficacités critiques dans les processus d'inférence. Les mécanismes d'attention, tels que FlashAttention et SparseAttention, rencontrent souvent des défis liés à diverses charges de travail, modèles de saisie dynamiques et limitations des ressources GPU. Ces obstacles, associés à une latence élevée et à des goulots d'étranglement de mémoire, soulignent la nécessité d'une solution plus efficace et plus flexible pour prendre en charge l'inférence LLM évolutive et réactive.

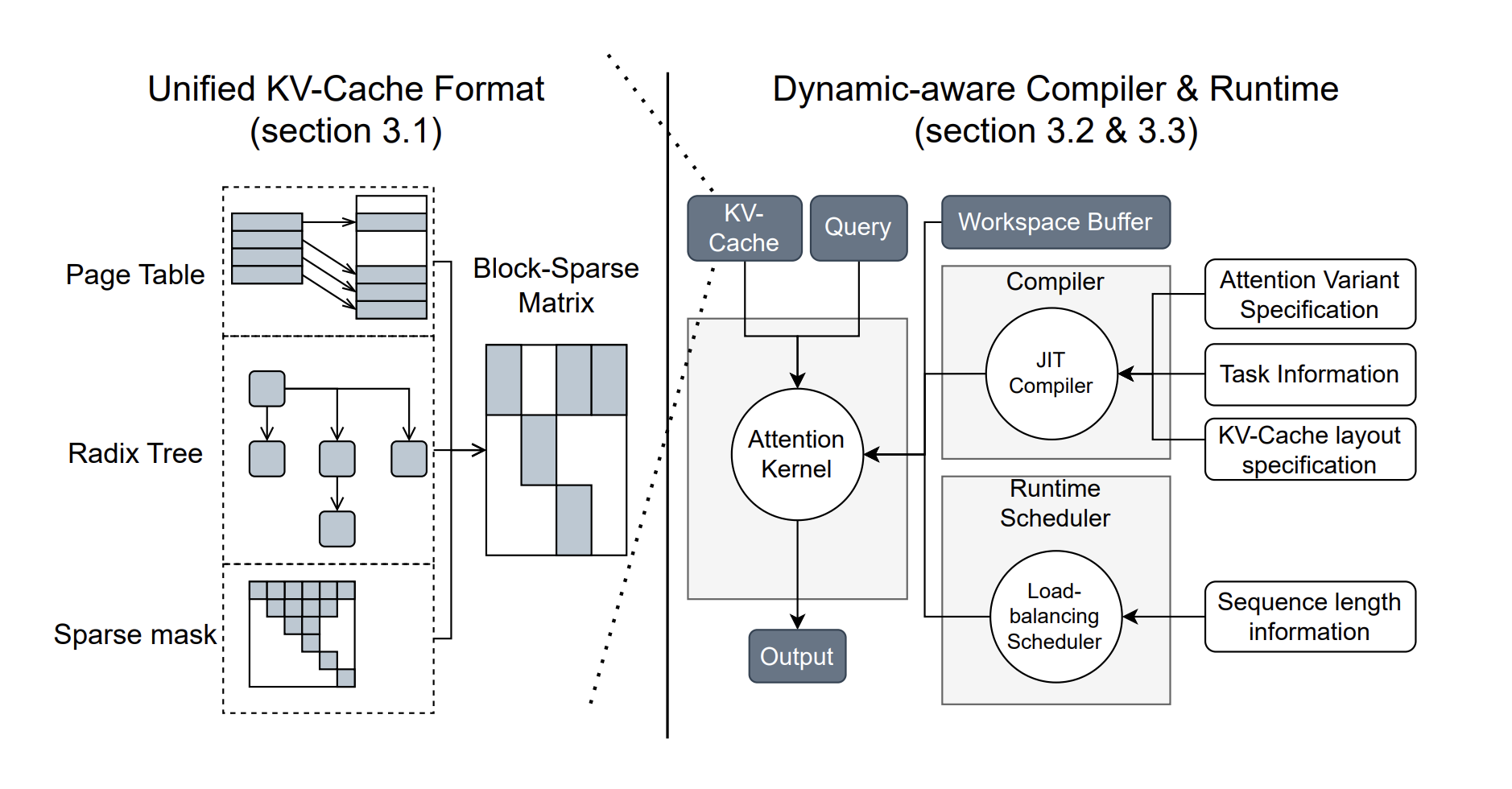

To address these challenges, researchers from the University of Washington, NVIDIA, Perplexity AI, and Carnegie Mellon University have developed FlashInfer, an AI library and kernel generator tailored for LLM inference. FlashInfer provides high-performance GPU kernel implementations for various attention mechanisms, including FlashAttention, SparseAttention, PageAttention, and sampling. Its design prioritizes flexibility and efficiency, addressing key challenges in LLM inference serving.

Pour relever ces défis, des chercheurs de l'Université de Washington, de NVIDIA, de Perplexity AI et de l'Université Carnegie Mellon ont développé FlashInfer, une bibliothèque d'IA et un générateur de noyau adaptés à l'inférence LLM. FlashInfer fournit des implémentations de noyau GPU hautes performances pour divers mécanismes d'attention, notamment FlashAttention, SparseAttention, PageAttention et l'échantillonnage. Sa conception donne la priorité à la flexibilité et à l'efficacité, en répondant aux principaux défis liés au service d'inférence LLM.

FlashInfer incorporates a block-sparse format to handle heterogeneous KV-cache storage efficiently and employs dynamic, load-balanced scheduling to optimize GPU usage. With integration into popular LLM serving frameworks like SGLang, vLLM, and MLC-Engine, FlashInfer offers a practical and adaptable approach to improving inference performance.

FlashInfer intègre un format de blocs fragmentés pour gérer efficacement le stockage de cache KV hétérogène et utilise une planification dynamique et équilibrée en charge pour optimiser l'utilisation du GPU. Grâce à son intégration dans des frameworks de service LLM populaires tels que SGLang, vLLM et MLC-Engine, FlashInfer offre une approche pratique et adaptable pour améliorer les performances d'inférence.

Technical Features and Benefits

Caractéristiques techniques et avantages

FlashInfer introduces several technical innovations:

FlashInfer introduit plusieurs innovations techniques :

Performance Insights

Informations sur les performances

FlashInfer demonstrates notable performance improvements across various benchmarks:

FlashInfer démontre des améliorations notables des performances dans divers tests :

FlashInfer also excels in parallel decoding tasks, with composable formats enabling significant reductions in Time-To-First-Token (TTFT). For instance, tests on the Llama 3.1 model (70B parameters) show up to a 22.86% decrease in TTFT under specific configurations.

FlashInfer excelle également dans les tâches de décodage parallèles, avec des formats composables permettant des réductions significatives du Time-To-First-Token (TTFT). Par exemple, les tests sur le modèle Llama 3.1 (paramètres 70B) montrent une diminution de 22,86 % du TTFT dans des configurations spécifiques.

Conclusion

FlashInfer offers a practical and efficient solution to the challenges of LLM inference, providing significant improvements in performance and resource utilization. Its flexible design and integration capabilities make it a valuable tool for advancing LLM-serving frameworks. By addressing key inefficiencies and offering robust technical solutions, FlashInfer paves the way for more accessible and scalable AI applications. As an open-source project, it invites further collaboration and innovation from the research community, ensuring continuous improvement and adaptation to emerging challenges in AI infrastructure.

FlashInfer offre une solution pratique et efficace aux défis de l'inférence LLM, offrant des améliorations significatives en termes de performances et d'utilisation des ressources. Sa conception flexible et ses capacités d'intégration en font un outil précieux pour faire progresser les cadres de service LLM. En s'attaquant aux principales inefficacités et en proposant des solutions techniques robustes, FlashInfer ouvre la voie à des applications d'IA plus accessibles et évolutives. En tant que projet open source, il invite à davantage de collaboration et d’innovation de la part de la communauté de recherche, garantissant une amélioration continue et une adaptation aux défis émergents de l’infrastructure de l’IA.

Check out the Paper and GitHub Page. All credit for this research goes to the researchers of this project. Also, don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. Don’t Forget to join our 60k+ ML SubReddit.

Consultez la page Paper et GitHub. Tout le mérite de cette recherche revient aux chercheurs de ce projet. N'oubliez pas non plus de nous suivre sur Twitter et de rejoindre notre chaîne Telegram et notre groupe LinkedIn. N'oubliez pas de rejoindre notre SubReddit de plus de 60 000 ML.

🚨 FREE UPCOMING AI WEBINAR (JAN 15, 2025): Boost LLM Accuracy with Synthetic Data and Evaluation Intelligence – Join this webinar to gain actionable insights into boosting LLM model performance and accuracy while safeguarding data privacy.

🚨 WEBINAIRE GRATUIT À VENIR SUR L'IA (15 JANVIER 2025) : Améliorez la précision du LLM grâce aux données synthétiques et à l'intelligence d'évaluation – Rejoignez ce webinaire pour obtenir des informations exploitables sur l'amélioration des performances et de la précision des modèles LLM tout en protégeant la confidentialité des données.

Clause de non-responsabilité:info@kdj.com

Les informations fournies ne constituent pas des conseils commerciaux. kdj.com n’assume aucune responsabilité pour les investissements effectués sur la base des informations fournies dans cet article. Les crypto-monnaies sont très volatiles et il est fortement recommandé d’investir avec prudence après une recherche approfondie!

Si vous pensez que le contenu utilisé sur ce site Web porte atteinte à vos droits d’auteur, veuillez nous contacter immédiatement (info@kdj.com) et nous le supprimerons dans les plus brefs délais.

-

- Bitcoin (BTC) ETF ARKB et FBTC Register net d'entrée de 220,7 millions de dollars malgré les nouveaux tarifs de Trump

- Apr 03, 2025 at 05:25 pm

- Mercredi 2 avril, Trump a annoncé un tarif de référence de 10% sur les importations et les tarifs réciproques sur la plupart des partenaires commerciaux des États-Unis.

-

- Solana (Sol) a du mal à maintenir des niveaux de soutien cruciaux alors que Mutuum Finance (MUTM) capture l'intérêt des investisseurs

- Apr 03, 2025 at 05:25 pm

- Le marché des crypto-monnaies assiste à une période turbulente alors que Solana (Sol) a du mal à maintenir des niveaux de soutien cruciaux tandis qu'un nouvel acteur, Mutuum Finance (MUTM), capture l'intérêt des investisseurs avec ses chiffres de prévente prometteurs.

-

- Les prix du Bitcoin (BTC), Ethereum (ETH) et XRP diminuent à mesure que les ventes de baleines, les sorties ETF et les craintes de récession pèsent sur le marché de la cryptographie.

- Apr 03, 2025 at 05:20 pm

- Le prix du Bitcoin (BTC) a mené le marché altcoin plus large, dirigé par Ethereum (ETH) et XRP, dans une perspective baissière au cours des dernières 24 heures. La pièce phare a baissé plus de 1%

-

-

-

- Standard Chartered Bank prédit Avax Token surperformra Bitcoin et Ethereum d'ici 2029

- Apr 03, 2025 at 05:15 pm

- Geoff Kendrick, qui dirige la division de recherche sur les actifs numériques, a déclaré que le jeton pourrait atteindre 55 $ d'ici 2025, 100 $ pour 2026, 150 $ pour 2027, 200 $ pour 2028 et 250 $ à la fin de 2029.

-

-

-

- Bitcoin (BTC) fait face à des conditions similaires à celles du marché des ours 2022, car les activités américaines voit «un risque très élevé» à venir.

- Apr 03, 2025 at 05:05 pm

- Dans sa dernière analyse, Charles Edwards, le fondateur du Bitcoin quantitatif et du Fonds d'actifs numériques Capriole Investments, a interrogé lorsque les États-Unis commenceraient à imprimer de l'argent.