|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Nachrichtenartikel zu Kryptowährungen

FlashInfer: Eine KI-Bibliothek und ein Kernel-Generator, die auf LLM-Inferenz zugeschnitten sind

Jan 05, 2025 at 11:11 am

Large Language Models (LLMs) sind zu einem integralen Bestandteil moderner KI-Anwendungen geworden und unterstützen Tools wie Chatbots und Codegeneratoren. Die zunehmende Abhängigkeit von diesen Modellen hat jedoch kritische Ineffizienzen bei Inferenzprozessen offenbart. Aufmerksamkeitsmechanismen wie FlashAttention und SparseAttention haben häufig Probleme mit unterschiedlichen Arbeitslasten, dynamischen Eingabemustern und Einschränkungen der GPU-Ressourcen. Diese Herausforderungen, gepaart mit hoher Latenz und Speicherengpässen, unterstreichen die Notwendigkeit einer effizienteren und flexibleren Lösung zur Unterstützung skalierbarer und reaktionsfähiger LLM-Inferenz.

Large Language Models (LLMs) have become ubiquitous in modern AI applications, powering tools ranging from chatbots to code generators. However, increased reliance on LLMs has highlighted critical inefficiencies in inference processes. Attention mechanisms, such as FlashAttention and SparseAttention, often encounter challenges with diverse workloads, dynamic input patterns, and GPU resource limitations. These hurdles, coupled with high latency and memory bottlenecks, underscore the need for a more efficient and flexible solution to support scalable and responsive LLM inference.

Large Language Models (LLMs) sind in modernen KI-Anwendungen allgegenwärtig und unterstützen Tools von Chatbots bis hin zu Codegeneratoren. Allerdings hat die zunehmende Abhängigkeit von LLMs kritische Ineffizienzen bei Inferenzprozessen deutlich gemacht. Aufmerksamkeitsmechanismen wie FlashAttention und SparseAttention stoßen häufig auf Herausforderungen aufgrund unterschiedlicher Arbeitslasten, dynamischer Eingabemuster und GPU-Ressourcenbeschränkungen. Diese Hürden, gepaart mit hoher Latenz und Speicherengpässen, unterstreichen die Notwendigkeit einer effizienteren und flexibleren Lösung zur Unterstützung skalierbarer und reaktionsfähiger LLM-Inferenz.

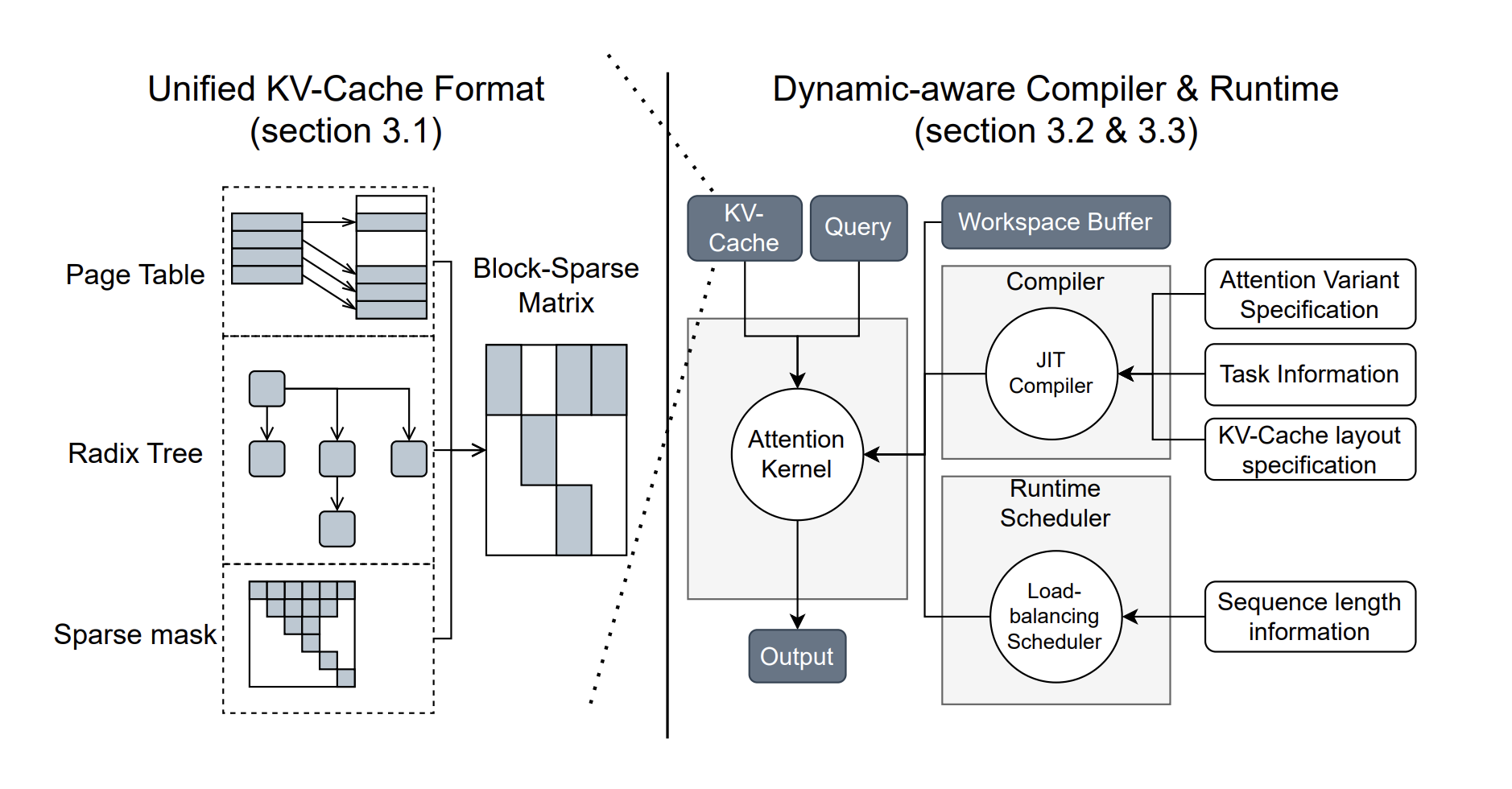

To address these challenges, researchers from the University of Washington, NVIDIA, Perplexity AI, and Carnegie Mellon University have developed FlashInfer, an AI library and kernel generator tailored for LLM inference. FlashInfer provides high-performance GPU kernel implementations for various attention mechanisms, including FlashAttention, SparseAttention, PageAttention, and sampling. Its design prioritizes flexibility and efficiency, addressing key challenges in LLM inference serving.

Um diesen Herausforderungen zu begegnen, haben Forscher der University of Washington, NVIDIA, Perplexity AI und der Carnegie Mellon University FlashInfer entwickelt, eine KI-Bibliothek und einen Kernel-Generator, die auf LLM-Inferenz zugeschnitten sind. FlashInfer bietet leistungsstarke GPU-Kernel-Implementierungen für verschiedene Aufmerksamkeitsmechanismen, einschließlich FlashAttention, SparseAttention, PageAttention und Sampling. Sein Design legt großen Wert auf Flexibilität und Effizienz und geht auf die wichtigsten Herausforderungen bei der LLM-Inferenzbereitstellung ein.

FlashInfer incorporates a block-sparse format to handle heterogeneous KV-cache storage efficiently and employs dynamic, load-balanced scheduling to optimize GPU usage. With integration into popular LLM serving frameworks like SGLang, vLLM, and MLC-Engine, FlashInfer offers a practical and adaptable approach to improving inference performance.

FlashInfer beinhaltet ein blocksparse-Format zur effizienten Handhabung heterogener KV-Cache-Speicherung und nutzt dynamische, lastenausgleichende Planung zur Optimierung der GPU-Nutzung. Durch die Integration in gängige LLM-Serving-Frameworks wie SGLang, vLLM und MLC-Engine bietet FlashInfer einen praktischen und anpassungsfähigen Ansatz zur Verbesserung der Inferenzleistung.

Technical Features and Benefits

Technische Merkmale und Vorteile

FlashInfer introduces several technical innovations:

FlashInfer führt mehrere technische Neuerungen ein:

Performance Insights

Leistungseinblicke

FlashInfer demonstrates notable performance improvements across various benchmarks:

FlashInfer zeigt bemerkenswerte Leistungsverbesserungen in verschiedenen Benchmarks:

FlashInfer also excels in parallel decoding tasks, with composable formats enabling significant reductions in Time-To-First-Token (TTFT). For instance, tests on the Llama 3.1 model (70B parameters) show up to a 22.86% decrease in TTFT under specific configurations.

FlashInfer zeichnet sich auch bei parallelen Decodierungsaufgaben aus, da zusammensetzbare Formate eine erhebliche Reduzierung der Time-To-First-Token (TTFT) ermöglichen. Beispielsweise zeigen Tests mit dem Llama 3.1-Modell (70B-Parameter) einen Rückgang der TTFT um bis zu 22,86 % unter bestimmten Konfigurationen.

Conclusion

Abschluss

FlashInfer offers a practical and efficient solution to the challenges of LLM inference, providing significant improvements in performance and resource utilization. Its flexible design and integration capabilities make it a valuable tool for advancing LLM-serving frameworks. By addressing key inefficiencies and offering robust technical solutions, FlashInfer paves the way for more accessible and scalable AI applications. As an open-source project, it invites further collaboration and innovation from the research community, ensuring continuous improvement and adaptation to emerging challenges in AI infrastructure.

FlashInfer bietet eine praktische und effiziente Lösung für die Herausforderungen der LLM-Inferenz und sorgt für erhebliche Verbesserungen der Leistung und Ressourcennutzung. Sein flexibles Design und seine Integrationsmöglichkeiten machen es zu einem wertvollen Werkzeug für die Weiterentwicklung von LLM-unterstützenden Frameworks. Durch die Beseitigung wichtiger Ineffizienzen und das Angebot robuster technischer Lösungen ebnet FlashInfer den Weg für zugänglichere und skalierbarere KI-Anwendungen. Als Open-Source-Projekt lädt es die Forschungsgemeinschaft zu weiterer Zusammenarbeit und Innovation ein und gewährleistet so eine kontinuierliche Verbesserung und Anpassung an neue Herausforderungen in der KI-Infrastruktur.

Check out the Paper and GitHub Page. All credit for this research goes to the researchers of this project. Also, don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. Don’t Forget to join our 60k+ ML SubReddit.

Schauen Sie sich die Paper- und GitHub-Seite an. Alle Anerkennung für diese Forschung gebührt den Forschern dieses Projekts. Vergessen Sie auch nicht, uns auf Twitter zu folgen und unserem Telegram-Kanal und unserer LinkedIn-Gruppe beizutreten. Vergessen Sie nicht, unserem über 60.000 ML großen SubReddit beizutreten.

🚨 FREE UPCOMING AI WEBINAR (JAN 15, 2025): Boost LLM Accuracy with Synthetic Data and Evaluation Intelligence – Join this webinar to gain actionable insights into boosting LLM model performance and accuracy while safeguarding data privacy.

🚨 KOSTENLOSES KOMMENDES KI-WEBINAR (15. JANUAR 2025): Steigern Sie die LLM-Genauigkeit mit synthetischen Daten und Auswertungsintelligenz – Nehmen Sie an diesem Webinar teil, um umsetzbare Erkenntnisse zur Steigerung der Leistung und Genauigkeit von LLM-Modellen bei gleichzeitiger Wahrung des Datenschutzes zu gewinnen.

Haftungsausschluss:info@kdj.com

Die bereitgestellten Informationen stellen keine Handelsberatung dar. kdj.com übernimmt keine Verantwortung für Investitionen, die auf der Grundlage der in diesem Artikel bereitgestellten Informationen getätigt werden. Kryptowährungen sind sehr volatil und es wird dringend empfohlen, nach gründlicher Recherche mit Vorsicht zu investieren!

Wenn Sie glauben, dass der auf dieser Website verwendete Inhalt Ihr Urheberrecht verletzt, kontaktieren Sie uns bitte umgehend (info@kdj.com) und wir werden ihn umgehend löschen.

-

- Trotz der Versprechen eines hochkarätigen Anreizes hat Trump Memecoin immer noch erhebliche Abflüsse

- Apr 26, 2025 at 08:40 pm

- Trotz Trumps jüngstem Gelübde, das Engagement zu erhöhen, zeigen Blockchain -Daten des Analysebergens Nansen eine atemberaubende Ungleichheit zwischen Verkäufen und Einkäufen.

-

-

- PI Network News entwickelt sich mit neuen DAPP -Zulassungen und Token -Einkäufen, wobei der Konsens 2025 Dynamik aufbaut.

- Apr 26, 2025 at 08:35 pm

- Pi Coin, einst ein steigender Stern im Krypto -Bereich, hat in letzter Zeit erhebliche Rückschläge ausgesetzt, wobei der Preis fast 80% gegenüber dem Höhepunkt von 3 US -Dollar zugunst.

-

- Die NASDAQ fordert die Securities and Exchange Commission (SEC) auf, bestimmte Kryptos wie traditionelle Finanzpapiere zu behandeln.

- Apr 26, 2025 at 08:35 pm

- In einem Brief vom 25. April forderte die NASDAQ die SEC auf, bestimmte Kryptowährungen als „Aktien“ zu klassifizieren, wodurch die Notwendigkeit klarer regulatorischer Standards für digitale Vermögenswerte hervorgehoben wird.

-

-

-

-

- WLFI, die mit der Trump -Familie verbundene Krypto -Firma, machte Wellen, als es Ende letzten Jahres debütierte. Es hat Token angesammelt und Kapital eingesetzt.

- Apr 26, 2025 at 08:25 pm

- World Liberty Financial (WLFI), die mit der Familie des US -Präsidentin Donald Trump verbundene Krypto -Firma, machte Wellen, als es Ende letzten Jahres debütierte.

-

- Während sich die Zeiten ändern, haben sich auch die Einstellungen der Menschen zur Energieveränderung geändert.

- Apr 26, 2025 at 08:20 pm

- Sie verlassen sich auf erneuerbare Energiequellen wie Solar- und Windkraft, um neue Unternehmen für Energiewolkenabbau zu treiben, was die Bergbaukosten minimiert und Strom integriert

![Der Handel folgt, [Review Video] zu folgen, dass Gold Bitcoin -Rohölaufträge profitieren! Der Handel folgt, [Review Video] zu folgen, dass Gold Bitcoin -Rohölaufträge profitieren!](/uploads/2025/04/26/cryptocurrencies-news/videos/trading-follow-review-video-gold-bitcoin-crude-oil-profits/image-1.webp)