|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

大規模言語モデル (LLM) は、現代の AI アプリケーションに不可欠な部分となっており、チャットボットやコード ジェネレーターなどのツールを強化しています。しかし、これらのモデルへの依存度が高まると、推論プロセスにおける重大な非効率性が明らかになりました。 FlashAttention や SparseAttend などのアテンション メカニズムは、多くの場合、多様なワークロード、動的な入力パターン、GPU リソースの制限に悩まされます。これらの課題は、高いレイテンシとメモリのボトルネックと相まって、スケーラブルで応答性の高い LLM 推論をサポートする、より効率的で柔軟なソリューションの必要性を強調しています。

Large Language Models (LLMs) have become ubiquitous in modern AI applications, powering tools ranging from chatbots to code generators. However, increased reliance on LLMs has highlighted critical inefficiencies in inference processes. Attention mechanisms, such as FlashAttention and SparseAttention, often encounter challenges with diverse workloads, dynamic input patterns, and GPU resource limitations. These hurdles, coupled with high latency and memory bottlenecks, underscore the need for a more efficient and flexible solution to support scalable and responsive LLM inference.

大規模言語モデル (LLM) は現代の AI アプリケーションで広く普及しており、チャットボットからコード ジェネレーターに至るまでのツールを強化しています。しかし、LLM への依存度が高まると、推論プロセスにおける重大な非効率性が浮き彫りになります。 FlashAttention や SparseAttend などのアテンション メカニズムは、さまざまなワークロード、動的な入力パターン、GPU リソースの制限といった課題に直面することがよくあります。これらのハードルは、高いレイテンシとメモリのボトルネックと相まって、スケーラブルで応答性の高い LLM 推論をサポートする、より効率的で柔軟なソリューションの必要性を強調しています。

To address these challenges, researchers from the University of Washington, NVIDIA, Perplexity AI, and Carnegie Mellon University have developed FlashInfer, an AI library and kernel generator tailored for LLM inference. FlashInfer provides high-performance GPU kernel implementations for various attention mechanisms, including FlashAttention, SparseAttention, PageAttention, and sampling. Its design prioritizes flexibility and efficiency, addressing key challenges in LLM inference serving.

これらの課題に対処するために、ワシントン大学、NVIDIA、Perplexity AI、カーネギー メロン大学の研究者は、LLM 推論用に調整された AI ライブラリおよびカーネル ジェネレーターである FlashInfer を開発しました。 FlashInfer は、FlashAttendant、SparseAttendant、PageAttendant、サンプリングなどのさまざまなアテンション メカニズム用の高性能 GPU カーネル実装を提供します。その設計は柔軟性と効率を優先し、LLM 推論サービスにおける主要な課題に対処します。

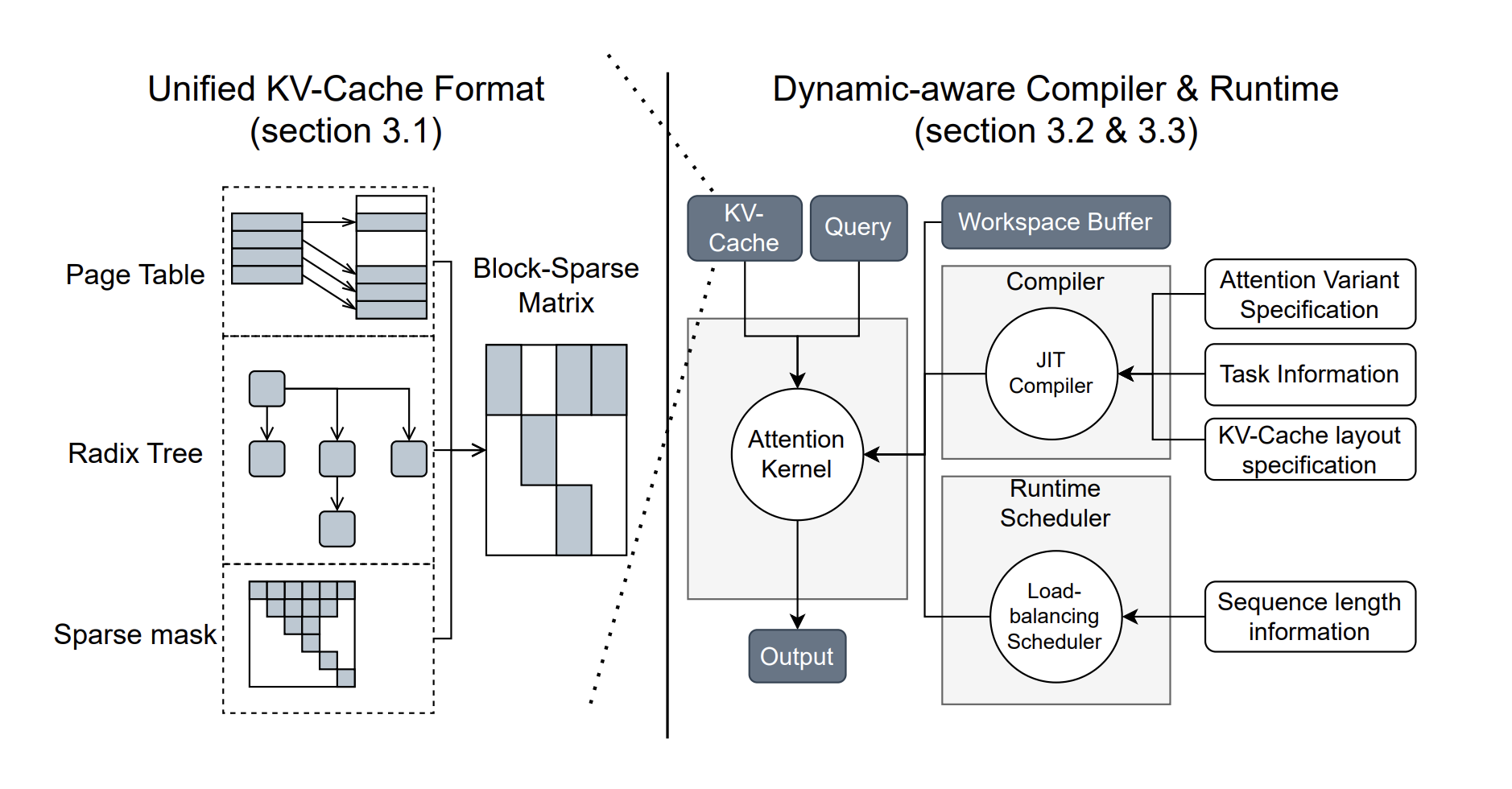

FlashInfer incorporates a block-sparse format to handle heterogeneous KV-cache storage efficiently and employs dynamic, load-balanced scheduling to optimize GPU usage. With integration into popular LLM serving frameworks like SGLang, vLLM, and MLC-Engine, FlashInfer offers a practical and adaptable approach to improving inference performance.

FlashInfer には、異種 KV キャッシュ ストレージを効率的に処理するためにブロック スパース形式が組み込まれており、動的で負荷分散されたスケジューリングを採用して GPU の使用率を最適化します。 SGLang、vLLM、MLC-Engine などの一般的な LLM サービス フレームワークに統合されている FlashInfer は、推論パフォーマンスを向上させるための実用的で適応性のあるアプローチを提供します。

Technical Features and Benefits

技術的な特徴と利点

FlashInfer introduces several technical innovations:

FlashInfer では、いくつかの技術革新が導入されています。

Performance Insights

パフォーマンスに関する洞察

FlashInfer demonstrates notable performance improvements across various benchmarks:

FlashInfer は、さまざまなベンチマークにわたって顕著なパフォーマンスの向上を示しています。

FlashInfer also excels in parallel decoding tasks, with composable formats enabling significant reductions in Time-To-First-Token (TTFT). For instance, tests on the Llama 3.1 model (70B parameters) show up to a 22.86% decrease in TTFT under specific configurations.

FlashInfer は、コンポーザブル形式により、Time-To-First-Token (TTFT) の大幅な短縮を可能にし、並列デコード タスクにも優れています。たとえば、Llama 3.1 モデル (70B パラメータ) のテストでは、特定の構成下で TTFT が最大 22.86% 減少することが示されています。

Conclusion

結論

FlashInfer offers a practical and efficient solution to the challenges of LLM inference, providing significant improvements in performance and resource utilization. Its flexible design and integration capabilities make it a valuable tool for advancing LLM-serving frameworks. By addressing key inefficiencies and offering robust technical solutions, FlashInfer paves the way for more accessible and scalable AI applications. As an open-source project, it invites further collaboration and innovation from the research community, ensuring continuous improvement and adaptation to emerging challenges in AI infrastructure.

FlashInfer は、LLM 推論の課題に対する実用的かつ効率的なソリューションを提供し、パフォーマンスとリソース使用率を大幅に向上させます。その柔軟な設計と統合機能により、LLM 提供フレームワークを進化させるための貴重なツールになります。 FlashInfer は、主要な非効率性に対処し、堅牢な技術ソリューションを提供することで、よりアクセスしやすくスケーラブルな AI アプリケーションへの道を開きます。オープンソース プロジェクトとして、研究コミュニティからのさらなるコラボレーションとイノベーションを招き、AI インフラストラクチャにおける新たな課題への継続的な改善と適応を保証します。

Check out the Paper and GitHub Page. All credit for this research goes to the researchers of this project. Also, don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. Don’t Forget to join our 60k+ ML SubReddit.

Paper と GitHub ページをチェックしてください。この研究の功績はすべて、このプロジェクトの研究者に与えられます。また、Twitter で私たちをフォローし、Telegram チャンネルと LinkedIn グループに参加することも忘れないでください。 60,000 以上の ML SubReddit に忘れずに参加してください。

? FREE UPCOMING AI WEBINAR (JAN 15, 2025): Boost LLM Accuracy with Synthetic Data and Evaluation Intelligence – Join this webinar to gain actionable insights into boosting LLM model performance and accuracy while safeguarding data privacy.

? 今後の無料 AI ウェビナー (2025 年 1 月 15 日): 合成データと評価インテリジェンスによる LLM 精度の向上 – このウェビナーに参加して、データ プライバシーを保護しながら LLM モデルのパフォーマンスと精度を向上させるための実用的な洞察を獲得してください。

免責事項:info@kdj.com

提供される情報は取引に関するアドバイスではありません。 kdj.com は、この記事で提供される情報に基づいて行われた投資に対して一切の責任を負いません。暗号通貨は変動性が高いため、十分な調査を行った上で慎重に投資することを強くお勧めします。

このウェブサイトで使用されているコンテンツが著作権を侵害していると思われる場合は、直ちに当社 (info@kdj.com) までご連絡ください。速やかに削除させていただきます。

![Web3 仮想通貨市場モーニングレポート: 市場は衰退しており、アルトコインは 5% 以上下落し、Binance は補償を受けており、Bnb チェーン上のミームは全体として急落しています [Vic TALK Issue 1444] Web3 仮想通貨市場モーニングレポート: 市場は衰退しており、アルトコインは 5% 以上下落し、Binance は補償を受けており、Bnb チェーン上のミームは全体として急落しています [Vic TALK Issue 1444]](/uploads/2025/10/16/cryptocurrencies-news/videos/web-crypto-market-morning-report-market-decline-altcoins-fallen-binance-compensation-received-memes-bnb-chain-collectively-plummeted-vic-talk-issue/68f043c9c8b44_image_500_375.webp)