|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

LLM(대형 언어 모델)은 챗봇 및 코드 생성기와 같은 도구를 구동하는 최신 AI 애플리케이션의 필수적인 부분이 되었습니다. 그러나 이러한 모델에 대한 의존도가 높아지면서 추론 프로세스에서 심각한 비효율성이 드러났습니다. FlashAttention 및 SparseAttention과 같은 주의 메커니즘은 다양한 워크로드, 동적 입력 패턴 및 GPU 리소스 제한으로 인해 어려움을 겪는 경우가 많습니다. 높은 대기 시간 및 메모리 병목 현상과 결합된 이러한 과제는 확장 가능하고 반응성이 뛰어난 LLM 추론을 지원하기 위한 보다 효율적이고 유연한 솔루션의 필요성을 강조합니다.

Large Language Models (LLMs) have become ubiquitous in modern AI applications, powering tools ranging from chatbots to code generators. However, increased reliance on LLMs has highlighted critical inefficiencies in inference processes. Attention mechanisms, such as FlashAttention and SparseAttention, often encounter challenges with diverse workloads, dynamic input patterns, and GPU resource limitations. These hurdles, coupled with high latency and memory bottlenecks, underscore the need for a more efficient and flexible solution to support scalable and responsive LLM inference.

LLM(대형 언어 모델)은 최신 AI 애플리케이션에서 널리 사용되며 챗봇부터 코드 생성기에 이르는 도구를 지원합니다. 그러나 LLM에 대한 의존도가 높아지면서 추론 프로세스의 심각한 비효율성이 부각되었습니다. FlashAttention 및 SparseAttention과 같은 주의 메커니즘은 다양한 워크로드, 동적 입력 패턴 및 GPU 리소스 제한으로 인해 문제에 직면하는 경우가 많습니다. 높은 대기 시간 및 메모리 병목 현상과 결합된 이러한 장애물은 확장 가능하고 응답성이 뛰어난 LLM 추론을 지원하기 위한 보다 효율적이고 유연한 솔루션의 필요성을 강조합니다.

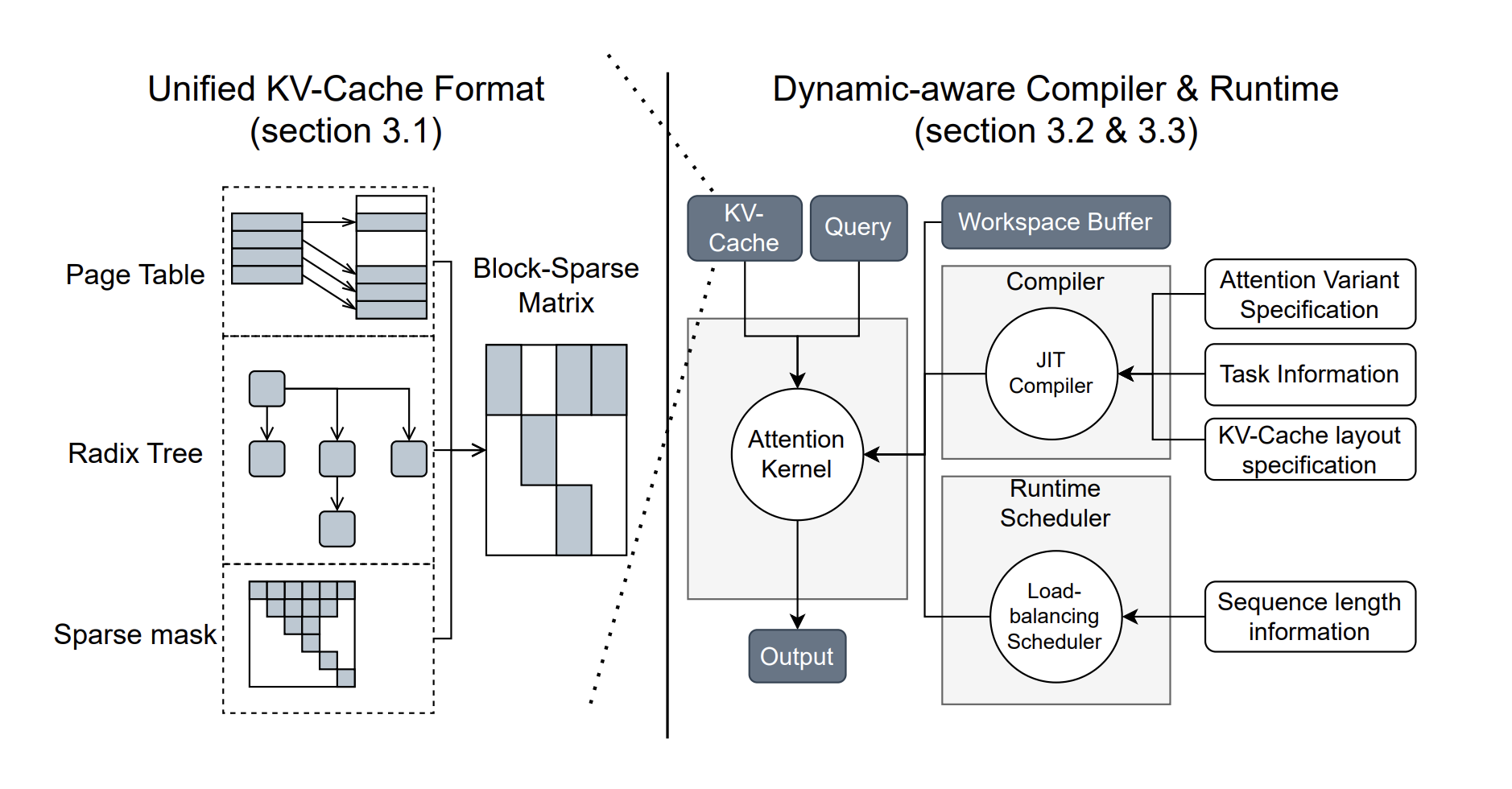

To address these challenges, researchers from the University of Washington, NVIDIA, Perplexity AI, and Carnegie Mellon University have developed FlashInfer, an AI library and kernel generator tailored for LLM inference. FlashInfer provides high-performance GPU kernel implementations for various attention mechanisms, including FlashAttention, SparseAttention, PageAttention, and sampling. Its design prioritizes flexibility and efficiency, addressing key challenges in LLM inference serving.

이러한 문제를 해결하기 위해 워싱턴 대학, NVIDIA, Perplexity AI 및 Carnegie Mellon 대학의 연구원들은 LLM 추론에 맞춰진 AI 라이브러리 및 커널 생성기인 FlashInfer를 개발했습니다. FlashInfer는 FlashAttention, SparseAttention, PageAttention 및 샘플링을 포함한 다양한 주의 메커니즘을 위한 고성능 GPU 커널 구현을 제공합니다. 이 설계는 유연성과 효율성을 우선시하여 LLM 추론 서비스의 주요 과제를 해결합니다.

FlashInfer incorporates a block-sparse format to handle heterogeneous KV-cache storage efficiently and employs dynamic, load-balanced scheduling to optimize GPU usage. With integration into popular LLM serving frameworks like SGLang, vLLM, and MLC-Engine, FlashInfer offers a practical and adaptable approach to improving inference performance.

FlashInfer는 블록 스파스 형식을 통합하여 이기종 KV 캐시 스토리지를 효율적으로 처리하고 동적 로드 밸런싱 스케줄링을 사용하여 GPU 사용을 최적화합니다. SGLang, vLLM 및 MLC-Engine과 같은 널리 사용되는 LLM 서비스 프레임워크에 통합된 FlashInfer는 추론 성능을 향상시키기 위한 실용적이고 적응 가능한 접근 방식을 제공합니다.

Technical Features and Benefits

기술적 특징 및 장점

FlashInfer introduces several technical innovations:

FlashInfer는 몇 가지 기술 혁신을 도입합니다.

Performance Insights

성능 통찰력

FlashInfer demonstrates notable performance improvements across various benchmarks:

FlashInfer는 다양한 벤치마크에서 눈에 띄는 성능 향상을 보여줍니다.

FlashInfer also excels in parallel decoding tasks, with composable formats enabling significant reductions in Time-To-First-Token (TTFT). For instance, tests on the Llama 3.1 model (70B parameters) show up to a 22.86% decrease in TTFT under specific configurations.

FlashInfer는 또한 TTFT(Time-To-First-Token)를 크게 단축할 수 있는 구성 가능한 형식을 사용하여 병렬 디코딩 작업에 탁월합니다. 예를 들어 Llama 3.1 모델(70B 매개변수)에 대한 테스트에서는 특정 구성에서 TTFT가 최대 22.86% 감소한 것으로 나타났습니다.

Conclusion

결론

FlashInfer offers a practical and efficient solution to the challenges of LLM inference, providing significant improvements in performance and resource utilization. Its flexible design and integration capabilities make it a valuable tool for advancing LLM-serving frameworks. By addressing key inefficiencies and offering robust technical solutions, FlashInfer paves the way for more accessible and scalable AI applications. As an open-source project, it invites further collaboration and innovation from the research community, ensuring continuous improvement and adaptation to emerging challenges in AI infrastructure.

FlashInfer는 LLM 추론 문제에 대한 실용적이고 효율적인 솔루션을 제공하여 성능 및 리소스 활용도를 크게 향상시킵니다. 유연한 설계 및 통합 기능을 통해 LLM 제공 프레임워크를 발전시키는 데 유용한 도구가 됩니다. 주요 비효율성을 해결하고 강력한 기술 솔루션을 제공함으로써 FlashInfer는 보다 접근 가능하고 확장 가능한 AI 애플리케이션을 위한 길을 열어줍니다. 오픈 소스 프로젝트로서 연구 커뮤니티의 추가 협력과 혁신을 유도하여 AI 인프라의 새로운 과제에 대한 지속적인 개선과 적응을 보장합니다.

Check out the Paper and GitHub Page. All credit for this research goes to the researchers of this project. Also, don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. Don’t Forget to join our 60k+ ML SubReddit.

Paper 및 GitHub 페이지를 확인하세요. 이 연구에 대한 모든 공로는 이 프로젝트의 연구자에게 돌아갑니다. 또한 Twitter에서 우리를 팔로우하고 Telegram 채널과 LinkedIn 그룹에 가입하는 것을 잊지 마세요. 60,000개가 넘는 ML SubReddit에 가입하는 것을 잊지 마세요.

🚨 FREE UPCOMING AI WEBINAR (JAN 15, 2025): Boost LLM Accuracy with Synthetic Data and Evaluation Intelligence – Join this webinar to gain actionable insights into boosting LLM model performance and accuracy while safeguarding data privacy.

🚨 무료로 예정된 AI 웨비나(2025년 1월 15일): 합성 데이터 및 평가 인텔리전스를 통해 LLM 정확도 향상 - 이 웨비나에 참여하여 데이터 개인 정보를 보호하면서 LLM 모델 성능 및 정확성을 높이는 데 대한 실행 가능한 통찰력을 얻으세요.

부인 성명:info@kdj.com

제공된 정보는 거래 조언이 아닙니다. kdj.com은 이 기사에 제공된 정보를 기반으로 이루어진 투자에 대해 어떠한 책임도 지지 않습니다. 암호화폐는 변동성이 매우 높으므로 철저한 조사 후 신중하게 투자하는 것이 좋습니다!

본 웹사이트에 사용된 내용이 귀하의 저작권을 침해한다고 판단되는 경우, 즉시 당사(info@kdj.com)로 연락주시면 즉시 삭제하도록 하겠습니다.