|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

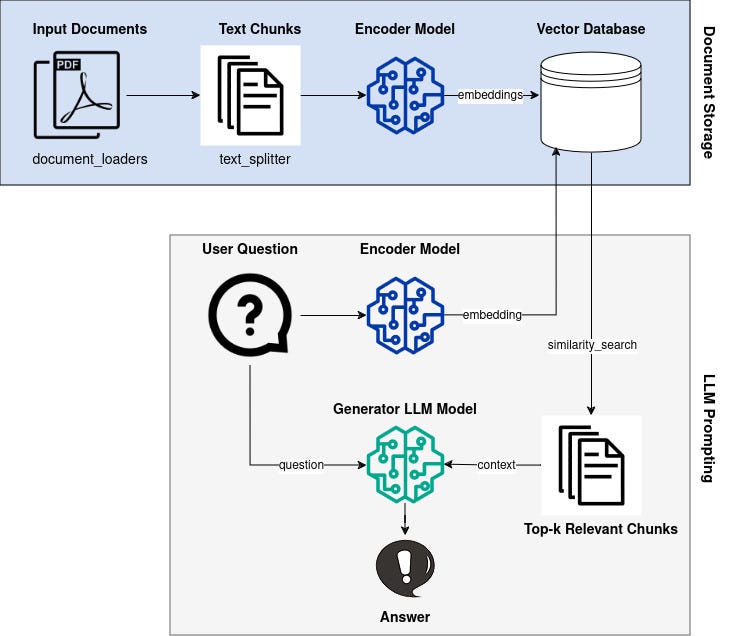

RAG(검색 증강 생성)는 지식 기반의 특정 지식을 통합하여 LLM(대형 언어 모델)을 향상합니다. 이 접근 방식은 벡터 임베딩을 활용하여 관련 정보를 효율적으로 검색하고 LLM의 컨텍스트를 강화합니다. RAG는 질문 답변 중에 특정 정보에 대한 액세스를 제공함으로써 오래된 지식 및 환각과 같은 LLM의 제한 사항을 해결합니다.

Introduction: Enhancing Large Language Models with Retrieval-Augmented Generation (RAG)

소개: 검색 증강 생성(RAG)을 통한 대규모 언어 모델 강화

Large Language Models (LLMs) have demonstrated remarkable capabilities in comprehending and synthesizing vast amounts of knowledge encoded within their numerous parameters. However, they possess two significant limitations: limited knowledge beyond their training dataset and a propensity to generate fictitious information when faced with specific inquiries.

LLM(대형 언어 모델)은 수많은 매개변수 내에 인코딩된 방대한 양의 지식을 이해하고 종합하는 놀라운 기능을 보여주었습니다. 그러나 여기에는 훈련 데이터 세트를 넘어서는 제한된 지식과 특정 문의에 직면할 때 가상의 정보를 생성하는 경향이라는 두 가지 중요한 제한 사항이 있습니다.

Retrieval-Augmented Generation (RAG)

검색 증강 생성(RAG)

Researchers at Facebook AI Research, University College London, and New York University introduced the concept of Retrieval-Augmented Generation (RAG) in 2020. RAG leverages pre-trained LLMs with additional context in the form of specific relevant information, enabling them to generate informed responses to user queries.

Facebook AI Research, University College London 및 New York University의 연구원들은 2020년에 검색 증강 생성(RAG) 개념을 도입했습니다. RAG는 사전 훈련된 LLM을 특정 관련 정보 형태의 추가 컨텍스트와 함께 활용하여 정보를 생성할 수 있도록 합니다. 사용자 쿼리에 대한 응답.

Implementation with Hugging Face Transformers, LangChain, and Faiss

Hugging Face Transformers, LangChain 및 Faiss를 사용한 구현

This article provides a comprehensive guide to implementing Google's LLM Gemma with RAG capabilities using Hugging Face transformers, LangChain, and the Faiss vector database. We will delve into the theoretical underpinnings and practical aspects of the RAG pipeline.

이 문서에서는 Hugging Face 변환기, LangChain 및 Faiss 벡터 데이터베이스를 사용하여 RAG 기능을 갖춘 Google의 LLM Gemma를 구현하는 방법에 대한 포괄적인 가이드를 제공합니다. 우리는 RAG 파이프라인의 이론적 토대와 실제적인 측면을 탐구할 것입니다.

Overview of the RAG Pipeline

RAG 파이프라인 개요

The RAG pipeline comprises the following steps:

RAG 파이프라인은 다음 단계로 구성됩니다.

- Knowledge Base Vectorization: Encode a knowledge base (e.g., Wikipedia documents) into dense vector representations (embeddings).

- Query Vectorization: Convert user queries into vector embeddings using the same encoder model.

- Retrieval: Identify embeddings in the knowledge base that are similar to the query embedding based on a similarity metric.

- Generation: Generate a response using the LLM, augmented with the retrieved context from the knowledge base.

Knowledge Base and Vectorization

지식 베이스 벡터화: 지식 베이스(예: Wikipedia 문서)를 조밀한 벡터 표현(임베딩)으로 인코딩합니다. 쿼리 벡터화: 동일한 인코더 모델을 사용하여 사용자 쿼리를 벡터 임베딩으로 변환합니다. 검색: 지식 베이스에서 유사한 임베딩을 식별합니다. 유사성 측정 기준을 기반으로 한 쿼리 임베딩. 생성: 지식 기반에서 검색된 컨텍스트로 보강된 LLM을 사용하여 응답을 생성합니다.지식 기반 및 벡터화

We begin by selecting an appropriate knowledge base, such as Wikipedia or a domain-specific corpus. Each document z_i in the knowledge base is converted into an embedding vector d(z) using an encoder model.

먼저 Wikipedia나 도메인별 자료와 같은 적절한 지식 기반을 선택합니다. 지식 베이스의 각 문서 z_i는 인코더 모델을 사용하여 임베딩 벡터 d(z)로 변환됩니다.

Query Vectorization

쿼리 벡터화

When a user poses a question x, it is also transformed into an embedding vector q(x) using the same encoder model.

사용자가 질문 x를 제기하면 동일한 인코더 모델을 사용하여 임베딩 벡터 q(x)로 변환됩니다.

Retrieval

검색

To identify relevant documents from the knowledge base, we utilize a similarity metric to measure the distance between q(x) and all available d(z). Documents with similar embeddings are considered relevant to the query.

지식 베이스에서 관련 문서를 식별하기 위해 유사성 측정법을 활용하여 q(x)와 사용 가능한 모든 d(z) 사이의 거리를 측정합니다. 유사한 임베딩이 포함된 문서는 쿼리와 관련된 것으로 간주됩니다.

Generation

세대

The LLM is employed to generate a response to the user query. However, unlike traditional LLMs, Gemma is augmented with the retrieved context. This enables it to incorporate relevant information from the knowledge base into its response, improving accuracy and reducing hallucinations.

LLM은 사용자 쿼리에 대한 응답을 생성하는 데 사용됩니다. 그러나 기존 LLM과 달리 Gemma는 검색된 컨텍스트로 보강됩니다. 이를 통해 지식 기반의 관련 정보를 응답에 통합하여 정확성을 높이고 환각을 줄일 수 있습니다.

Conclusion

결론

By leveraging the Retrieval-Augmented Generation (RAG) technique, we can significantly enhance the capabilities of Large Language Models. By providing LLMs with access to specific relevant information, we can improve the accuracy and consistency of their responses, making them more suitable for real-world applications that require accurate and informative knowledge retrieval.

RAG(Retrieval-Augmented Generation) 기술을 활용하여 대규모 언어 모델의 기능을 크게 향상시킬 수 있습니다. LLM에게 특정 관련 정보에 대한 액세스 권한을 제공함으로써 응답의 정확성과 일관성을 향상시켜 정확하고 유익한 지식 검색이 필요한 실제 응용 프로그램에 더 적합하게 만들 수 있습니다.

부인 성명:info@kdj.com

제공된 정보는 거래 조언이 아닙니다. kdj.com은 이 기사에 제공된 정보를 기반으로 이루어진 투자에 대해 어떠한 책임도 지지 않습니다. 암호화폐는 변동성이 매우 높으므로 철저한 조사 후 신중하게 투자하는 것이 좋습니다!

본 웹사이트에 사용된 내용이 귀하의 저작권을 침해한다고 판단되는 경우, 즉시 당사(info@kdj.com)로 연락주시면 즉시 삭제하도록 하겠습니다.