|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

Déverrouillage de modèles de langage améliorés : génération améliorée de récupération révélée

Apr 01, 2024 at 03:04 am

La génération augmentée par récupération (RAG) améliore les modèles linguistiques étendus (LLM) en intégrant des connaissances spécifiques provenant d'une base de connaissances. Cette approche exploite les intégrations vectorielles pour récupérer efficacement les informations pertinentes et augmenter le contexte du LLM. RAG répond aux limites des LLM, telles que les connaissances obsolètes et les hallucinations, en donnant accès à des informations spécifiques lors de la réponse aux questions.

Introduction: Enhancing Large Language Models with Retrieval-Augmented Generation (RAG)

Introduction : Amélioration des modèles de langage volumineux avec la génération augmentée par récupération (RAG)

Large Language Models (LLMs) have demonstrated remarkable capabilities in comprehending and synthesizing vast amounts of knowledge encoded within their numerous parameters. However, they possess two significant limitations: limited knowledge beyond their training dataset and a propensity to generate fictitious information when faced with specific inquiries.

Les grands modèles linguistiques (LLM) ont démontré des capacités remarquables à comprendre et à synthétiser de grandes quantités de connaissances codées dans leurs nombreux paramètres. Cependant, ils présentent deux limites importantes : des connaissances limitées au-delà de leur ensemble de données de formation et une propension à générer des informations fictives face à des demandes spécifiques.

Retrieval-Augmented Generation (RAG)

Génération augmentée par récupération (RAG)

Researchers at Facebook AI Research, University College London, and New York University introduced the concept of Retrieval-Augmented Generation (RAG) in 2020. RAG leverages pre-trained LLMs with additional context in the form of specific relevant information, enabling them to generate informed responses to user queries.

Des chercheurs de Facebook AI Research, de l'University College de Londres et de l'Université de New York ont introduit le concept de génération augmentée par récupération (RAG) en 2020. RAG exploite des LLM pré-entraînés avec un contexte supplémentaire sous la forme d'informations pertinentes spécifiques, leur permettant de générer des informations éclairées. réponses aux requêtes des utilisateurs.

Implementation with Hugging Face Transformers, LangChain, and Faiss

Implémentation avec Hugging Face Transformers, LangChain et Faiss

This article provides a comprehensive guide to implementing Google's LLM Gemma with RAG capabilities using Hugging Face transformers, LangChain, and the Faiss vector database. We will delve into the theoretical underpinnings and practical aspects of the RAG pipeline.

Cet article fournit un guide complet pour implémenter le LLM Gemma de Google avec les capacités RAG à l'aide des transformateurs Hugging Face, LangChain et la base de données vectorielles Faiss. Nous approfondirons les fondements théoriques et les aspects pratiques du pipeline RAG.

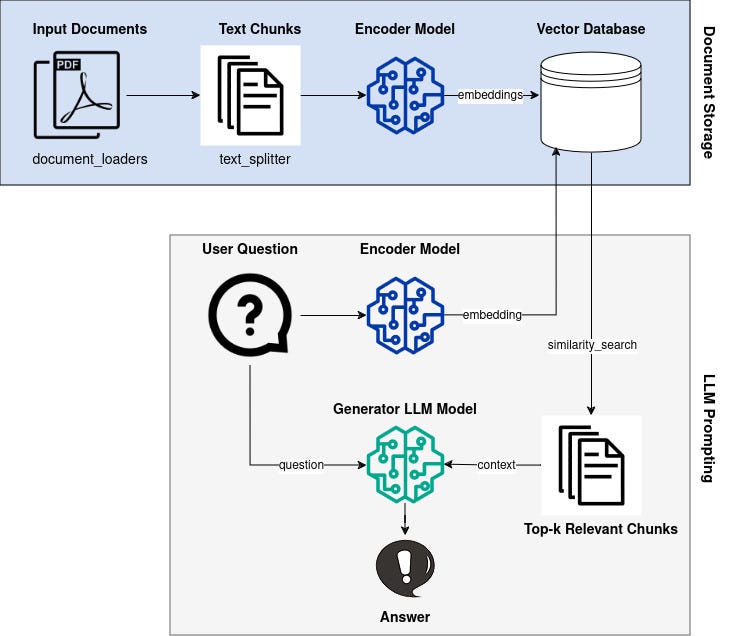

Overview of the RAG Pipeline

Présentation du pipeline RAG

The RAG pipeline comprises the following steps:

Le pipeline RAG comprend les étapes suivantes :

- Knowledge Base Vectorization: Encode a knowledge base (e.g., Wikipedia documents) into dense vector representations (embeddings).

- Query Vectorization: Convert user queries into vector embeddings using the same encoder model.

- Retrieval: Identify embeddings in the knowledge base that are similar to the query embedding based on a similarity metric.

- Generation: Generate a response using the LLM, augmented with the retrieved context from the knowledge base.

Knowledge Base and Vectorization

Vectorisation de la base de connaissances : codez une base de connaissances (par exemple, des documents Wikipédia) en représentations vectorielles denses (intégrations). Vectorisation des requêtes : convertissez les requêtes des utilisateurs en intégrations vectorielles en utilisant le même modèle d'encodeur. Récupération : identifiez les intégrations dans la base de connaissances qui sont similaires à la base de connaissances. intégration de requêtes basée sur une métrique de similarité.Génération : générer une réponse à l'aide du LLM, augmentée du contexte récupéré de la base de connaissances.Base de connaissances et vectorisation

We begin by selecting an appropriate knowledge base, such as Wikipedia or a domain-specific corpus. Each document z_i in the knowledge base is converted into an embedding vector d(z) using an encoder model.

Nous commençons par sélectionner une base de connaissances appropriée, telle que Wikipédia ou un corpus spécifique à un domaine. Chaque document z_i de la base de connaissances est converti en un vecteur de plongement d(z) à l'aide d'un modèle d'encodeur.

Query Vectorization

Vectorisation des requêtes

When a user poses a question x, it is also transformed into an embedding vector q(x) using the same encoder model.

Lorsqu'un utilisateur pose une question x, elle est également transformée en un vecteur d'intégration q(x) en utilisant le même modèle d'encodeur.

Retrieval

Récupération

To identify relevant documents from the knowledge base, we utilize a similarity metric to measure the distance between q(x) and all available d(z). Documents with similar embeddings are considered relevant to the query.

Pour identifier les documents pertinents de la base de connaissances, nous utilisons une métrique de similarité pour mesurer la distance entre q(x) et tous les d(z) disponibles. Les documents avec des intégrations similaires sont considérés comme pertinents pour la requête.

Generation

Génération

The LLM is employed to generate a response to the user query. However, unlike traditional LLMs, Gemma is augmented with the retrieved context. This enables it to incorporate relevant information from the knowledge base into its response, improving accuracy and reducing hallucinations.

Le LLM est utilisé pour générer une réponse à la requête de l'utilisateur. Cependant, contrairement aux LLM traditionnels, Gemma est enrichi du contexte récupéré. Cela lui permet d’incorporer des informations pertinentes de la base de connaissances dans sa réponse, améliorant ainsi la précision et réduisant les hallucinations.

Conclusion

Conclusion

By leveraging the Retrieval-Augmented Generation (RAG) technique, we can significantly enhance the capabilities of Large Language Models. By providing LLMs with access to specific relevant information, we can improve the accuracy and consistency of their responses, making them more suitable for real-world applications that require accurate and informative knowledge retrieval.

En tirant parti de la technique de génération augmentée par récupération (RAG), nous pouvons améliorer considérablement les capacités des grands modèles linguistiques. En fournissant aux LLM un accès à des informations pertinentes spécifiques, nous pouvons améliorer l'exactitude et la cohérence de leurs réponses, les rendant ainsi plus adaptés aux applications du monde réel qui nécessitent une récupération de connaissances précise et informative.

Clause de non-responsabilité:info@kdj.com

Les informations fournies ne constituent pas des conseils commerciaux. kdj.com n’assume aucune responsabilité pour les investissements effectués sur la base des informations fournies dans cet article. Les crypto-monnaies sont très volatiles et il est fortement recommandé d’investir avec prudence après une recherche approfondie!

Si vous pensez que le contenu utilisé sur ce site Web porte atteinte à vos droits d’auteur, veuillez nous contacter immédiatement (info@kdj.com) et nous le supprimerons dans les plus brefs délais.

-

-

-

- Pol (anciennement MATIC) Prédiction des prix: le rallye continuera-t-il ou un retrait est-il imminent?

- Apr 26, 2025 at 02:20 pm

- Le marché des crypto-monnaies connaît une période turbulente, mais au milieu des baisses prudentes, un jeton attire l'attention des investisseurs: Pol (anciennement connu sous le nom de Matic).

-

- Le prix proche du protocole (proche) rebondit alors que le bit en enregistrant un endroit près de l'ETF

- Apr 26, 2025 at 02:20 pm

- Cette semaine, le marché de la cryptographie a connu un revirement haussier alors que la panique entourant la guerre tarifaire s'est calmée. Ainsi, le prix du bitcoin a rebondi au-dessus de la barrière de 95 000 $

-

-

-

- 4 Meilleurs cryptos à investir en 2025: Pourquoi Unstaked, Link, Avax & Ada méritent les projecteurs

- Apr 26, 2025 at 02:10 pm

- La crypto n'est plus une classe d'actifs spéculative, elle est maintenant utilisée pour déplacer de l'argent. Des envois de fonds mondiaux et du commerce en temps réel aux intégrations au niveau du protocole

-

- L'industrie cryptographique constate une séparation claire entre les projets axés sur les plans futurs et ceux qui offrent une véritable interaction aujourd'hui.

- Apr 26, 2025 at 02:10 pm

- Alors que SEI et Zetachain ont mis leur énergie à construire une forte infrastructure et un service public, leurs premiers stades ont raté la participation au détail et les caractéristiques engageantes.

-

- Les entreprises de crypto-monnaie lancent des offres d'investissement plus traditionnelles, rédigeant le fossé entre les actifs financiers et numériques traditionnels.

- Apr 26, 2025 at 02:05 pm

- Les investisseurs recherchent des offres de produits plus flexibles sous une seule plate-forme, la «ligne se floue» entre la finance traditionnelle (Tradfi) et l'espace de crypto-monnaie

![Le trading est de suivre [Revue vidéo] Les commandes de pétrole brut Bitcoin Gold font des bénéfices! Le trading est de suivre [Revue vidéo] Les commandes de pétrole brut Bitcoin Gold font des bénéfices!](/uploads/2025/04/26/cryptocurrencies-news/videos/trading-follow-review-video-gold-bitcoin-crude-oil-profits/image-1.webp)