|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

検索拡張生成 (RAG) は、知識ベースから特定の知識を統合することにより、大規模言語モデル (LLM) を強化します。このアプローチでは、ベクトル埋め込みを活用して、関連情報を効率的に取得し、LLM のコンテキストを強化します。 RAG は、質問応答中に特定の情報へのアクセスを提供することで、古い知識や幻覚などの LLM の制限に対処します。

Introduction: Enhancing Large Language Models with Retrieval-Augmented Generation (RAG)

はじめに: 検索拡張生成 (RAG) による大規模言語モデルの強化

Large Language Models (LLMs) have demonstrated remarkable capabilities in comprehending and synthesizing vast amounts of knowledge encoded within their numerous parameters. However, they possess two significant limitations: limited knowledge beyond their training dataset and a propensity to generate fictitious information when faced with specific inquiries.

大規模言語モデル (LLM) は、その多数のパラメータ内にエンコードされた膨大な量の知識を理解し、合成する際に顕著な能力を実証してきました。ただし、これらには 2 つの重大な制限があります。1 つはトレーニング データセットを超える限られた知識、もう 1 つは特定の問い合わせに直面したときに架空の情報を生成する傾向です。

Retrieval-Augmented Generation (RAG)

検索拡張生成 (RAG)

Researchers at Facebook AI Research, University College London, and New York University introduced the concept of Retrieval-Augmented Generation (RAG) in 2020. RAG leverages pre-trained LLMs with additional context in the form of specific relevant information, enabling them to generate informed responses to user queries.

Facebook AI Research、ユニバーシティ・カレッジ・ロンドン、およびニューヨーク大学の研究者は、2020 年に検索拡張生成 (RAG) の概念を導入しました。RAG は、特定の関連情報の形で追加のコンテキストを備えた事前トレーニング済み LLM を活用し、情報に基づいた情報を生成できるようにします。ユーザーのクエリに対する応答。

Implementation with Hugging Face Transformers, LangChain, and Faiss

ハグフェイストランスフォーマー、LangChain、Faissを使用した実装

This article provides a comprehensive guide to implementing Google's LLM Gemma with RAG capabilities using Hugging Face transformers, LangChain, and the Faiss vector database. We will delve into the theoretical underpinnings and practical aspects of the RAG pipeline.

この記事では、Hugging Face トランスフォーマー、LangChain、および Faiss ベクトル データベースを使用して、RAG 機能を備えた Google の LLM Gemma を実装するための包括的なガイドを提供します。 RAG パイプラインの理論的基礎と実践的な側面を詳しく掘り下げていきます。

Overview of the RAG Pipeline

RAG パイプラインの概要

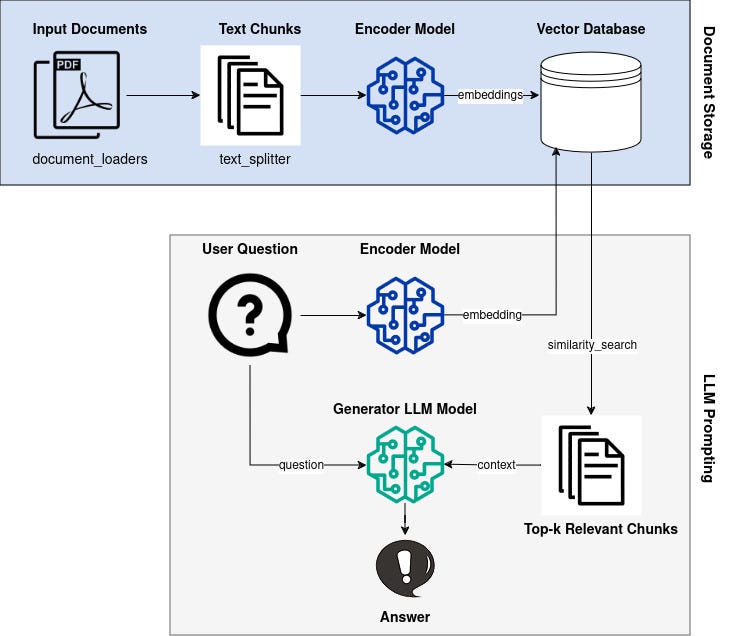

The RAG pipeline comprises the following steps:

RAG パイプラインは次のステップで構成されます。

- Knowledge Base Vectorization: Encode a knowledge base (e.g., Wikipedia documents) into dense vector representations (embeddings).

- Query Vectorization: Convert user queries into vector embeddings using the same encoder model.

- Retrieval: Identify embeddings in the knowledge base that are similar to the query embedding based on a similarity metric.

- Generation: Generate a response using the LLM, augmented with the retrieved context from the knowledge base.

Knowledge Base and Vectorization

ナレッジ ベースのベクトル化: ナレッジ ベース (Wikipedia ドキュメントなど) を高密度ベクトル表現 (埋め込み) にエンコードします。クエリのベクトル化: 同じエンコーダー モデルを使用して、ユーザー クエリをベクトル埋め込みに変換します。検索: ナレッジ ベース内の埋め込みに類似したものを特定します。類似性メトリクスに基づいてクエリを埋め込みます。生成: ナレッジ ベースから取得したコンテキストを追加して、LLM を使用して応答を生成します。ナレッジ ベースとベクトル化

We begin by selecting an appropriate knowledge base, such as Wikipedia or a domain-specific corpus. Each document z_i in the knowledge base is converted into an embedding vector d(z) using an encoder model.

まず、Wikipedia やドメイン固有のコーパスなど、適切な知識ベースを選択します。知識ベース内の各文書 z_i は、エンコーダー モデルを使用して埋め込みベクトル d(z) に変換されます。

Query Vectorization

クエリのベクトル化

When a user poses a question x, it is also transformed into an embedding vector q(x) using the same encoder model.

ユーザーが質問 x を提示すると、同じエンコーダ モデルを使用して、質問 x も埋め込みベクトル q(x) に変換されます。

Retrieval

検索

To identify relevant documents from the knowledge base, we utilize a similarity metric to measure the distance between q(x) and all available d(z). Documents with similar embeddings are considered relevant to the query.

知識ベースから関連する文書を特定するために、類似性メトリックを利用して、q(x) とすべての利用可能な d(z) の間の距離を測定します。同様の埋め込みを含むドキュメントは、クエリに関連しているとみなされます。

Generation

世代

The LLM is employed to generate a response to the user query. However, unlike traditional LLMs, Gemma is augmented with the retrieved context. This enables it to incorporate relevant information from the knowledge base into its response, improving accuracy and reducing hallucinations.

LLM は、ユーザーのクエリに対する応答を生成するために使用されます。ただし、従来の LLM とは異なり、Gemma は取得したコンテキストで拡張されます。これにより、知識ベースからの関連情報を応答に組み込むことができ、精度が向上し、幻覚が軽減されます。

Conclusion

結論

By leveraging the Retrieval-Augmented Generation (RAG) technique, we can significantly enhance the capabilities of Large Language Models. By providing LLMs with access to specific relevant information, we can improve the accuracy and consistency of their responses, making them more suitable for real-world applications that require accurate and informative knowledge retrieval.

検索拡張生成 (RAG) 技術を活用することで、大規模言語モデルの機能を大幅に強化できます。 LLM に特定の関連情報へのアクセスを提供することで、応答の精度と一貫性を向上させ、正確で有益な知識の取得を必要とする現実世界のアプリケーションにより適したものにすることができます。

免責事項:info@kdj.com

提供される情報は取引に関するアドバイスではありません。 kdj.com は、この記事で提供される情報に基づいて行われた投資に対して一切の責任を負いません。暗号通貨は変動性が高いため、十分な調査を行った上で慎重に投資することを強くお勧めします。

このウェブサイトで使用されているコンテンツが著作権を侵害していると思われる場合は、直ちに当社 (info@kdj.com) までご連絡ください。速やかに削除させていただきます。

-

-

-

- 柴犬、AlphaPepe、プレセール: ミームコインの進化

- 2025-10-21 08:00:14

- 柴犬のダイナミクス、AlphaPepe のプレセールの隆盛、ミームコイン投資の進化する状況を探ってください。

-

-

-

-

-

-