|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Transformer 모델의 개발은 인공 지능을 크게 발전시켜 다양한 작업에서 놀라운 성능을 제공합니다. 그러나 이러한 발전에는 종종 엄청난 컴퓨팅 요구 사항이 수반되어 확장성과 효율성에 문제가 발생합니다. 드물게 활성화된 MoE(Mixture-of-Experts) 아키텍처는 비례적인 계산 비용 없이 모델 용량을 늘릴 수 있는 유망한 솔루션을 제공합니다. 그러나 MoE 모델의 기존 TopK+Softmax 라우팅은 주목할만한 한계에 직면해 있습니다. TopK 라우팅의 개별적이고 차별화할 수 없는 특성은 확장성과 최적화를 방해하는 동시에 균형 잡힌 전문가 활용을 보장하는 것이 지속적인 문제로 남아 있어 비효율성과 차선의 성능을 초래합니다.

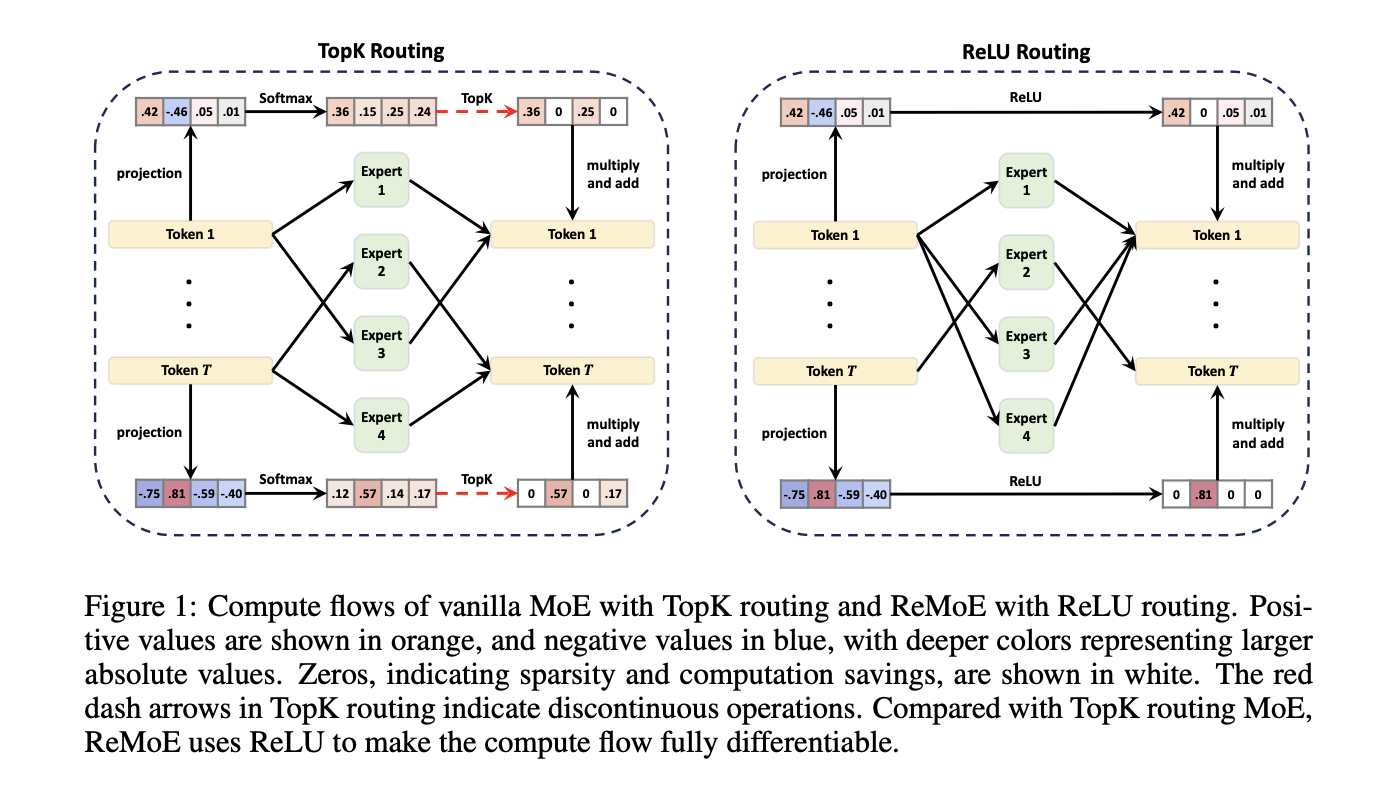

Mixture-of-Experts (MoE) architectures have emerged as a powerful technique to increase the capacity of Transformer models without incurring proportional computational costs. However, traditional TopK+Softmax routing in MoE models presents several limitations, including the discrete and non-differentiable nature of TopK routing, which hampers scalability and optimization, and the difficulty in ensuring balanced expert utilization, leading to inefficiencies and suboptimal performance.

MoE(Mixture-of-Experts) 아키텍처는 비례적인 계산 비용을 발생시키지 않고 Transformer 모델의 용량을 늘리는 강력한 기술로 등장했습니다. 그러나 MoE 모델의 기존 TopK+Softmax 라우팅에는 확장성과 최적화를 방해하는 TopK 라우팅의 개별적이고 차별화할 수 없는 특성, 전문가의 균형 잡힌 활용을 보장하는 데 어려움이 있어 비효율성과 차선의 성능을 초래하는 등 몇 가지 제한 사항이 있습니다.

To address these limitations, researchers at Tsinghua University have proposed a new architecture called ReMoE (ReLU-based Mixture-of-Experts). ReMoE replaces the conventional TopK+Softmax routing with a ReLU-based mechanism, enabling a fully differentiable routing process. This design simplifies the architecture and seamlessly integrates with existing MoE systems.

이러한 제한 사항을 해결하기 위해 Tsinghua University의 연구원들은 ReMoE(ReLU 기반 Mixture-of-Experts)라는 새로운 아키텍처를 제안했습니다. ReMoE는 기존 TopK+Softmax 라우팅을 ReLU 기반 메커니즘으로 대체하여 완전히 차별화 가능한 라우팅 프로세스를 가능하게 합니다. 이 디자인은 아키텍처를 단순화하고 기존 MoE 시스템과 원활하게 통합됩니다.

ReMoE utilizes ReLU activation functions to dynamically determine the active state of experts. In contrast to TopK routing, which activates only the top-k experts based on a discrete probability distribution, ReMoE’s ReLU routing transitions smoothly between active and inactive states. The sparsity of activated experts is controlled using adaptive L1 regularization, ensuring efficient computation while maintaining high performance. This differentiable design also allows for dynamic allocation of resources across tokens and layers, adapting to the complexity of individual inputs.

ReMoE는 ReLU 활성화 기능을 활용하여 전문가의 활성 상태를 동적으로 결정합니다. 개별 확률 분포를 기반으로 상위 k 전문가만 활성화하는 TopK 라우팅과 달리 ReMoE의 ReLU 라우팅은 활성 상태와 비활성 상태 사이를 원활하게 전환합니다. 활성화된 전문가의 희소성은 적응형 L1 정규화를 사용하여 제어되어 고성능을 유지하면서 효율적인 계산을 보장합니다. 또한 이 차별화 가능한 설계를 통해 토큰과 레이어 전반에 걸쳐 리소스를 동적으로 할당하여 개별 입력의 복잡성에 적응할 수 있습니다.

Technical Details and Benefits

기술 세부정보 및 이점

The key innovation of ReMoE lies in its routing mechanism. By replacing the discontinuous TopK operation with a continuous ReLU-based approach, ReMoE eliminates abrupt changes in expert activation, ensuring smoother gradient updates and improved stability during training. Additionally, ReMoE’s dynamic routing mechanism allows for adjusting the number of active experts based on token complexity, promoting efficient resource utilization.

ReMoE의 주요 혁신은 라우팅 메커니즘에 있습니다. 불연속적인 TopK 작업을 지속적인 ReLU 기반 접근 방식으로 대체함으로써 ReMoE는 전문가 활성화의 갑작스러운 변화를 제거하여 훈련 중에 보다 부드러운 그라데이션 업데이트와 향상된 안정성을 보장합니다. 또한 ReMoE의 동적 라우팅 메커니즘을 통해 토큰 복잡성에 따라 활성 전문가 수를 조정하여 효율적인 리소스 활용을 촉진할 수 있습니다.

To address imbalances where some experts might remain underutilized, ReMoE incorporates an adaptive load-balancing strategy into its L1 regularization. This refinement ensures a fairer distribution of token assignments across experts, enhancing the model’s capacity and overall performance. The architecture’s scalability is evident in its ability to handle a larger number of experts and finer levels of granularity compared to traditional MoE models.

일부 전문가의 활용도가 낮은 불균형 문제를 해결하기 위해 ReMoE는 적응형 로드 밸런싱 전략을 L1 정규화에 통합합니다. 이러한 개선을 통해 전문가 간에 토큰 할당이 보다 공정하게 분배되어 모델의 용량과 전반적인 성능이 향상됩니다. 아키텍처의 확장성은 기존 MoE 모델에 비해 더 많은 수의 전문가와 더 미세한 수준의 세분성을 처리할 수 있는 능력에서 분명하게 드러납니다.

Performance Insights and Experimental Results

성능 통찰력 및 실험 결과

Extensive experiments demonstrate that ReMoE consistently outperforms conventional MoE architectures. The researchers tested ReMoE using the LLaMA architecture, training models of varying sizes (182M to 978M parameters) with different numbers of experts (4 to 128). Key findings include:

광범위한 실험을 통해 ReMoE가 기존 MoE 아키텍처보다 지속적으로 뛰어난 성능을 발휘한다는 사실이 입증되었습니다. 연구원들은 다양한 수의 전문가(4~128명)와 함께 다양한 크기(182M~978M 매개변수)의 훈련 모델인 LLaMA 아키텍처를 사용하여 ReMoE를 테스트했습니다. 주요 결과는 다음과 같습니다.

For instance, on downstream tasks like ARC, BoolQ, and LAMBADA, ReMoE showed measurable accuracy improvements over both dense and TopK-routed MoE models. Analyses of training and inference throughput revealed that ReMoE’s differentiable design introduces minimal computational overhead, making it suitable for practical applications.

예를 들어 ARC, BoolQ 및 LAMBADA와 같은 다운스트림 작업에서 ReMoE는 밀도가 높은 MoE 모델과 TopK 라우팅 MoE 모델 모두에 비해 측정 가능한 정확도 향상을 보여주었습니다. 훈련 및 추론 처리량 분석 결과 ReMoE의 미분 가능 설계는 최소한의 계산 오버헤드를 도입하여 실제 애플리케이션에 적합하다는 사실이 밝혀졌습니다.

Conclusion

결론

ReMoE presents a valuable advance in Mixture-of-Experts architectures by addressing the limitations of TopK+Softmax routing. The ReLU-based routing mechanism, combined with adaptive regularization techniques, ensures that ReMoE is both efficient and adaptable. This innovation highlights the potential of revisiting foundational design choices to achieve better scalability and performance. By offering a practical and resource-conscious approach, ReMoE provides a useful tool for advancing AI systems to meet growing computational demands.

ReMoE는 TopK+Softmax 라우팅의 한계를 해결하여 전문가 혼합 아키텍처의 귀중한 발전을 제시합니다. 적응형 정규화 기술과 결합된 ReLU 기반 라우팅 메커니즘은 ReMoE의 효율성과 적응성을 모두 보장합니다. 이 혁신은 더 나은 확장성과 성능을 달성하기 위해 기본 설계 선택을 다시 검토할 수 있는 가능성을 강조합니다. 실용적이고 리소스를 고려한 접근 방식을 제공함으로써 ReMoE는 AI 시스템을 발전시켜 증가하는 컴퓨팅 요구 사항을 충족하는 데 유용한 도구를 제공합니다.

Check out the Paper and GitHub Page. All credit for this research goes to the researchers of this project. Also, don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. Don’t Forget to join our 60k+ ML SubReddit.

Paper 및 GitHub 페이지를 확인하세요. 이 연구에 대한 모든 공로는 이 프로젝트의 연구자에게 돌아갑니다. 또한 Twitter에서 우리를 팔로우하고 Telegram 채널과 LinkedIn 그룹에 가입하는 것을 잊지 마세요. 60,000개가 넘는 ML SubReddit에 가입하는 것을 잊지 마세요.

Trending: LG AI Research Releases EXAONE 3.5: Three Open-Source Bilingual Frontier AI-level Models Delivering Unmatched Instruction Following and Long Context Understanding for Global Leadership in Generative AI Excellence…

동향: LG AI 리서치, EXAONE 3.5 출시: 생성 AI 우수성 분야의 글로벌 리더십을 위해 탁월한 지시 따르기 및 장기적인 상황 이해를 제공하는 세 가지 오픈 소스 이중 언어 프론티어 AI 수준 모델…

부인 성명:info@kdj.com

제공된 정보는 거래 조언이 아닙니다. kdj.com은 이 기사에 제공된 정보를 기반으로 이루어진 투자에 대해 어떠한 책임도 지지 않습니다. 암호화폐는 변동성이 매우 높으므로 철저한 조사 후 신중하게 투자하는 것이 좋습니다!

본 웹사이트에 사용된 내용이 귀하의 저작권을 침해한다고 판단되는 경우, 즉시 당사(info@kdj.com)로 연락주시면 즉시 삭제하도록 하겠습니다.

![거래는 [검토 비디오] 골드 비트 코인 원유 주문을 따르는 것입니다. 거래는 [검토 비디오] 골드 비트 코인 원유 주문을 따르는 것입니다.](/uploads/2025/04/26/cryptocurrencies-news/videos/trading-follow-review-video-gold-bitcoin-crude-oil-profits/image-1.webp)