|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Transformer モデルの開発により、人工知能が大幅に進化し、さまざまなタスクにわたって優れたパフォーマンスを実現します。ただし、これらの進歩には多くの場合、厳しい計算要件が伴い、スケーラビリティと効率の点で課題が生じます。まばらにアクティブ化された専門家混合 (MoE) アーキテクチャは有望なソリューションを提供し、比例した計算コストを発生させることなくモデルの容量を増やすことができます。しかし、MoE モデルにおける従来の TopK+Softmax ルーティングは、顕著な制限に直面しています。 TopK ルーティングの離散的で微分不可能な性質は、スケーラビリティと最適化を妨げる一方で、専門家によるバランスのとれた利用を確保することは依然として永続的な問題であり、非効率性と次善のパフォーマンスにつながります。

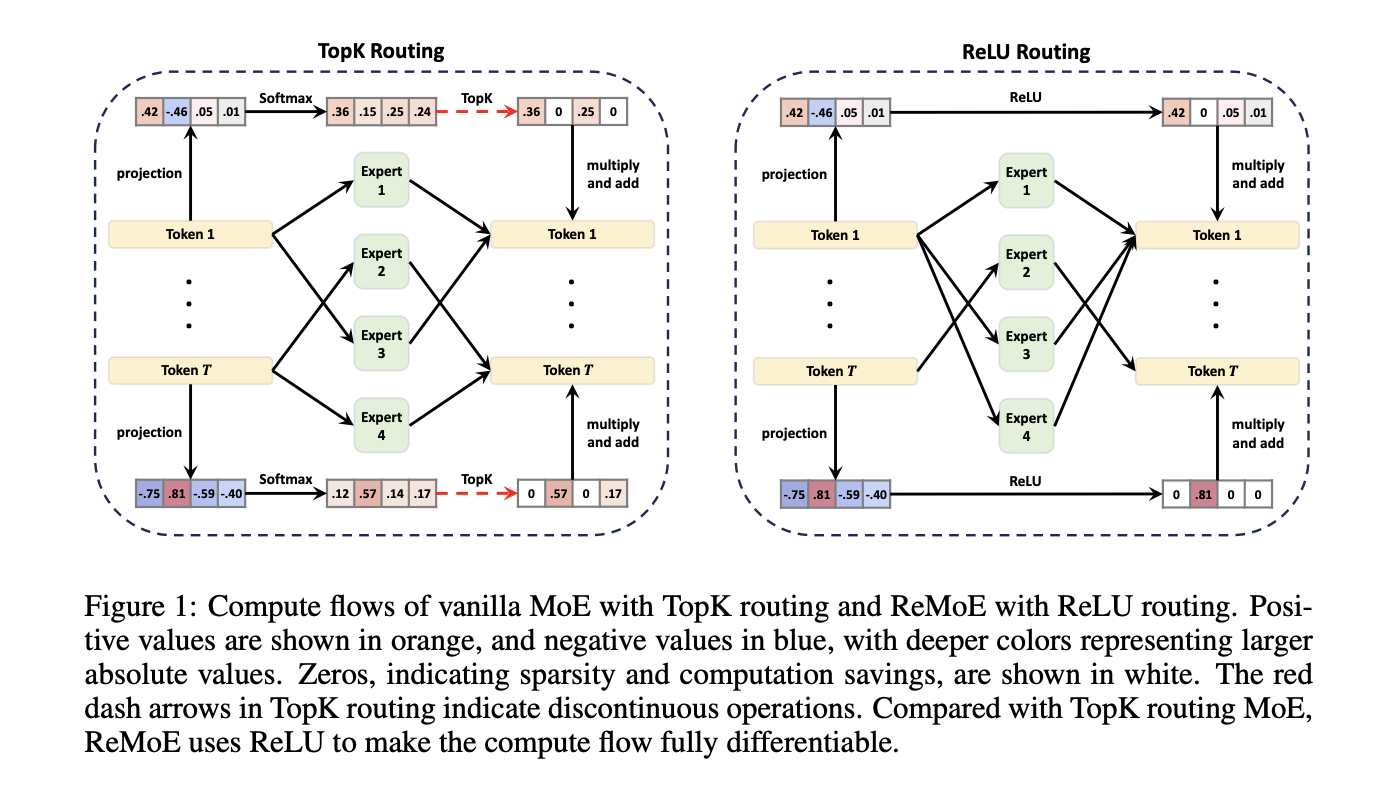

Mixture-of-Experts (MoE) architectures have emerged as a powerful technique to increase the capacity of Transformer models without incurring proportional computational costs. However, traditional TopK+Softmax routing in MoE models presents several limitations, including the discrete and non-differentiable nature of TopK routing, which hampers scalability and optimization, and the difficulty in ensuring balanced expert utilization, leading to inefficiencies and suboptimal performance.

Mixture-of-Experts (MoE) アーキテクチャは、比例した計算コストを発生させることなく Transformer モデルの容量を増やす強力な手法として登場しました。ただし、MoE モデルの従来の TopK+Softmax ルーティングには、スケーラビリティと最適化を妨げる TopK ルーティングの離散的で微分不可能な性質や、バランスの取れた専門家による利用を確保することが困難であり、非効率性や次善のパフォーマンスにつながるなど、いくつかの制限があります。

To address these limitations, researchers at Tsinghua University have proposed a new architecture called ReMoE (ReLU-based Mixture-of-Experts). ReMoE replaces the conventional TopK+Softmax routing with a ReLU-based mechanism, enabling a fully differentiable routing process. This design simplifies the architecture and seamlessly integrates with existing MoE systems.

これらの制限に対処するために、清華大学の研究者は、ReMoE (ReLU ベースの Mixture-of-Experts) と呼ばれる新しいアーキテクチャを提案しました。 ReMoE は、従来の TopK+Softmax ルーティングを ReLU ベースのメカニズムに置き換え、完全に微分可能なルーティング プロセスを可能にします。この設計により、アーキテクチャが簡素化され、既存の MoE システムとシームレスに統合されます。

ReMoE utilizes ReLU activation functions to dynamically determine the active state of experts. In contrast to TopK routing, which activates only the top-k experts based on a discrete probability distribution, ReMoE’s ReLU routing transitions smoothly between active and inactive states. The sparsity of activated experts is controlled using adaptive L1 regularization, ensuring efficient computation while maintaining high performance. This differentiable design also allows for dynamic allocation of resources across tokens and layers, adapting to the complexity of individual inputs.

ReMoE は、ReLU アクティベーション機能を利用して、エキスパートのアクティブ状態を動的に決定します。離散確率分布に基づいて上位 K エキスパートのみをアクティブにする TopK ルーティングとは対照的に、ReMoE の ReLU ルーティングはアクティブ状態と非アクティブ状態の間をスムーズに遷移します。アクティブ化されたエキスパートのまばらさは、適応型 L1 正則化を使用して制御され、高いパフォーマンスを維持しながら効率的な計算を保証します。この微分可能な設計により、個々の入力の複雑さに適応して、トークンとレイヤー全体にリソースを動的に割り当てることもできます。

Technical Details and Benefits

技術的な詳細と利点

The key innovation of ReMoE lies in its routing mechanism. By replacing the discontinuous TopK operation with a continuous ReLU-based approach, ReMoE eliminates abrupt changes in expert activation, ensuring smoother gradient updates and improved stability during training. Additionally, ReMoE’s dynamic routing mechanism allows for adjusting the number of active experts based on token complexity, promoting efficient resource utilization.

ReMoE の主な革新は、そのルーティング メカニズムにあります。 ReMoE は、不連続な TopK 操作を継続的な ReLU ベースのアプローチに置き換えることにより、エキスパートのアクティベーションにおける突然の変化を排除し、よりスムーズな勾配更新とトレーニング中の安定性の向上を保証します。さらに、ReMoE の動的ルーティング メカニズムにより、トークンの複雑さに基づいてアクティブなエキスパートの数を調整でき、リソースの効率的な利用が促進されます。

To address imbalances where some experts might remain underutilized, ReMoE incorporates an adaptive load-balancing strategy into its L1 regularization. This refinement ensures a fairer distribution of token assignments across experts, enhancing the model’s capacity and overall performance. The architecture’s scalability is evident in its ability to handle a larger number of experts and finer levels of granularity compared to traditional MoE models.

一部の専門家が十分に活用されていない不均衡に対処するために、ReMoE は適応型負荷分散戦略を L1 正規化に組み込んでいます。この改良により、エキスパート間でトークン割り当てがより公平に配分され、モデルの能力と全体的なパフォーマンスが向上します。このアーキテクチャのスケーラビリティは、従来の MoE モデルと比較して、多数の専門家とより細かいレベルの粒度を処理できる能力から明らかです。

Performance Insights and Experimental Results

パフォーマンスに関する洞察と実験結果

Extensive experiments demonstrate that ReMoE consistently outperforms conventional MoE architectures. The researchers tested ReMoE using the LLaMA architecture, training models of varying sizes (182M to 978M parameters) with different numbers of experts (4 to 128). Key findings include:

広範な実験により、ReMoE が従来の MoE アーキテクチャよりも常に優れたパフォーマンスを発揮することが実証されています。研究者らは、LLaMA アーキテクチャを使用して ReMoE をテストし、さまざまな数の専門家 (4 ~ 128 人) でさまざまなサイズ (1 億 8,200 万~9 億 7,800 万のパラメーター) のモデルをトレーニングしました。主な調査結果は次のとおりです。

For instance, on downstream tasks like ARC, BoolQ, and LAMBADA, ReMoE showed measurable accuracy improvements over both dense and TopK-routed MoE models. Analyses of training and inference throughput revealed that ReMoE’s differentiable design introduces minimal computational overhead, making it suitable for practical applications.

たとえば、ARC、BoolQ、LAMBADA などのダウンストリーム タスクでは、ReMoE は、高密度 MoE モデルと TopK 配線された MoE モデルの両方に比べて、測定可能な精度の向上を示しました。トレーニングと推論のスループットを分析した結果、ReMoE の微分可能設計により計算オーバーヘッドが最小限に抑えられ、実用的なアプリケーションに適していることが明らかになりました。

Conclusion

結論

ReMoE presents a valuable advance in Mixture-of-Experts architectures by addressing the limitations of TopK+Softmax routing. The ReLU-based routing mechanism, combined with adaptive regularization techniques, ensures that ReMoE is both efficient and adaptable. This innovation highlights the potential of revisiting foundational design choices to achieve better scalability and performance. By offering a practical and resource-conscious approach, ReMoE provides a useful tool for advancing AI systems to meet growing computational demands.

ReMoE は、TopK+Softmax ルーティングの制限に対処することで、専門家混合アーキテクチャにおける貴重な進歩をもたらします。 ReLU ベースのルーティング メカニズムと適応正則化技術を組み合わせることで、ReMoE の効率性と適応性の両方が保証されます。このイノベーションは、基本的な設計の選択を再検討して、より優れたスケーラビリティとパフォーマンスを実現できる可能性を浮き彫りにしています。 ReMoE は、実用的でリソースを意識したアプローチを提供することで、AI システムを進化させて増大する計算需要に対応するための便利なツールを提供します。

Check out the Paper and GitHub Page. All credit for this research goes to the researchers of this project. Also, don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. Don’t Forget to join our 60k+ ML SubReddit.

Paper と GitHub ページをチェックしてください。この研究の功績はすべて、このプロジェクトの研究者に与えられます。また、Twitter で私たちをフォローし、Telegram チャンネルと LinkedIn グループに参加することも忘れないでください。 60,000 以上の ML SubReddit に忘れずに参加してください。

Trending: LG AI Research Releases EXAONE 3.5: Three Open-Source Bilingual Frontier AI-level Models Delivering Unmatched Instruction Following and Long Context Understanding for Global Leadership in Generative AI Excellence…

トレンド: LG AI Research が EXAONE 3.5 をリリース: ジェネレーティブ AI エクセレンスにおける世界的リーダーシップに向けて、比類のない命令追従と長いコンテキスト理解を実現する 3 つのオープンソース バイリンガル フロンティア AI レベル モデル…

免責事項:info@kdj.com

提供される情報は取引に関するアドバイスではありません。 kdj.com は、この記事で提供される情報に基づいて行われた投資に対して一切の責任を負いません。暗号通貨は変動性が高いため、十分な調査を行った上で慎重に投資することを強くお勧めします。

このウェブサイトで使用されているコンテンツが著作権を侵害していると思われる場合は、直ちに当社 (info@kdj.com) までご連絡ください。速やかに削除させていただきます。

-

-

-

-

-

- チャレンジコイン、収集品、軍事記念品: 現代版

- 2025-11-06 07:50:00

- 伝統とeスポーツNFTのような現代の収集品を融合させた、チャレンジコインや軍事記念品の進化する世界を探索してください。

-

-

-

-