|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

ReMoE : architecture de mélange d'experts basée sur ReLU pour une formation évolutive et efficace

Dec 29, 2024 at 04:05 pm

Le développement des modèles Transformer a considérablement avancé l’intelligence artificielle, offrant des performances remarquables dans diverses tâches. Cependant, ces avancées s’accompagnent souvent d’exigences informatiques élevées, ce qui présente des défis en termes d’évolutivité et d’efficacité. Les architectures de mélange d'experts (MoE) peu activées constituent une solution prometteuse, permettant une capacité de modèle accrue sans coûts de calcul proportionnels. Pourtant, le routage traditionnel TopK+Softmax dans les modèles MoE se heurte à des limites notables. La nature discrète et non différenciable du routage TopK entrave l'évolutivité et l'optimisation, tandis que garantir une utilisation experte équilibrée reste un problème persistant, conduisant à des inefficacités et à des performances sous-optimales.

Mixture-of-Experts (MoE) architectures have emerged as a powerful technique to increase the capacity of Transformer models without incurring proportional computational costs. However, traditional TopK+Softmax routing in MoE models presents several limitations, including the discrete and non-differentiable nature of TopK routing, which hampers scalability and optimization, and the difficulty in ensuring balanced expert utilization, leading to inefficiencies and suboptimal performance.

Les architectures mixtes d'experts (MoE) sont apparues comme une technique puissante pour augmenter la capacité des modèles Transformer sans encourir de coûts de calcul proportionnels. Cependant, le routage TopK+Softmax traditionnel dans les modèles MoE présente plusieurs limites, notamment la nature discrète et non différenciable du routage TopK, qui entrave l'évolutivité et l'optimisation, et la difficulté d'assurer une utilisation experte équilibrée, conduisant à des inefficacités et des performances sous-optimales.

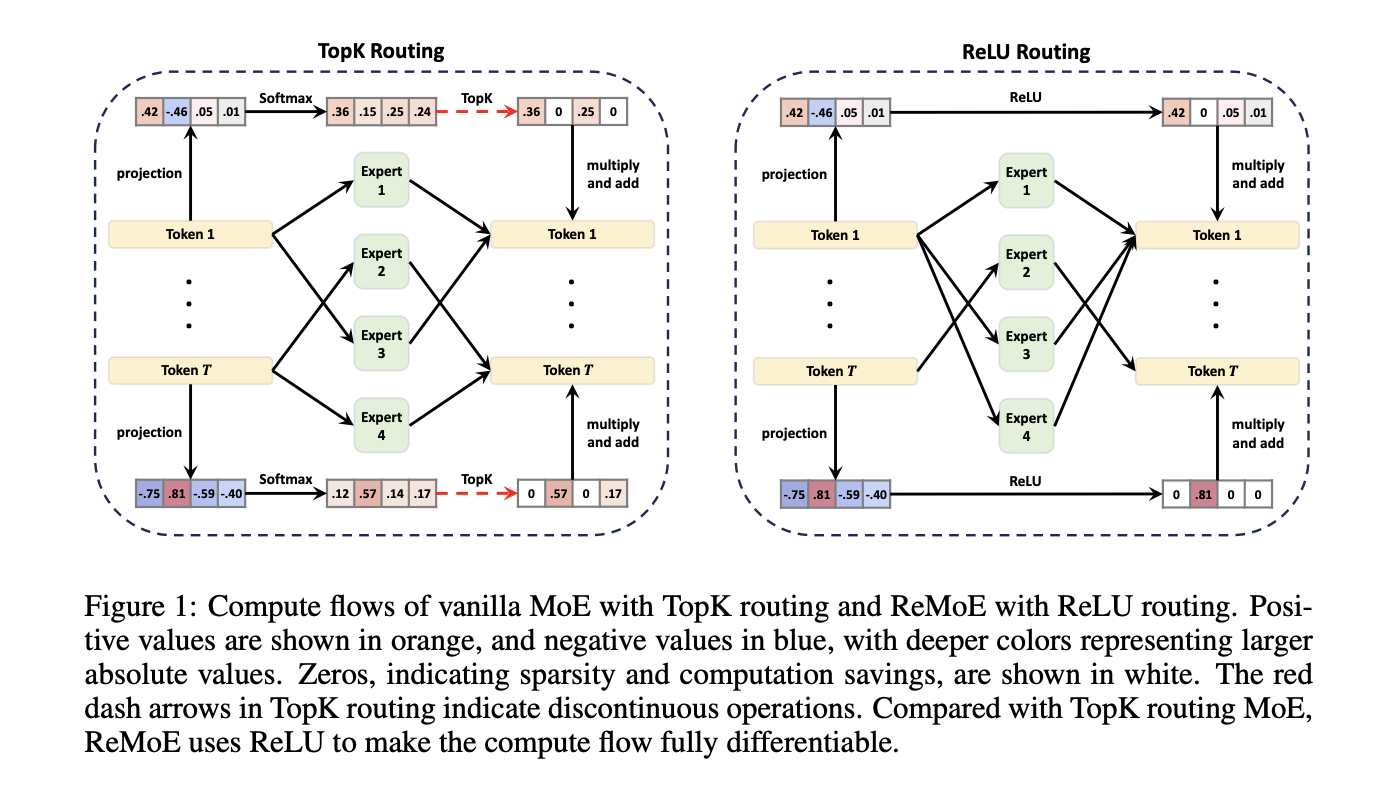

To address these limitations, researchers at Tsinghua University have proposed a new architecture called ReMoE (ReLU-based Mixture-of-Experts). ReMoE replaces the conventional TopK+Softmax routing with a ReLU-based mechanism, enabling a fully differentiable routing process. This design simplifies the architecture and seamlessly integrates with existing MoE systems.

Pour remédier à ces limitations, des chercheurs de l'Université Tsinghua ont proposé une nouvelle architecture appelée ReMoE (ReLU-based Mixture-of-Experts). ReMoE remplace le routage conventionnel TopK+Softmax par un mécanisme basé sur ReLU, permettant un processus de routage entièrement différenciable. Cette conception simplifie l'architecture et s'intègre parfaitement aux systèmes MoE existants.

ReMoE utilizes ReLU activation functions to dynamically determine the active state of experts. In contrast to TopK routing, which activates only the top-k experts based on a discrete probability distribution, ReMoE’s ReLU routing transitions smoothly between active and inactive states. The sparsity of activated experts is controlled using adaptive L1 regularization, ensuring efficient computation while maintaining high performance. This differentiable design also allows for dynamic allocation of resources across tokens and layers, adapting to the complexity of individual inputs.

ReMoE utilise les fonctions d'activation ReLU pour déterminer dynamiquement l'état actif des experts. Contrairement au routage TopK, qui active uniquement les experts top-k sur la base d'une distribution de probabilité discrète, le routage ReLU de ReMoE effectue une transition fluide entre les états actif et inactif. La rareté des experts activés est contrôlée à l’aide d’une régularisation adaptative L1, garantissant un calcul efficace tout en maintenant des performances élevées. Cette conception différenciable permet également une allocation dynamique des ressources entre les jetons et les couches, s'adaptant à la complexité des entrées individuelles.

Technical Details and Benefits

Détails techniques et avantages

The key innovation of ReMoE lies in its routing mechanism. By replacing the discontinuous TopK operation with a continuous ReLU-based approach, ReMoE eliminates abrupt changes in expert activation, ensuring smoother gradient updates and improved stability during training. Additionally, ReMoE’s dynamic routing mechanism allows for adjusting the number of active experts based on token complexity, promoting efficient resource utilization.

L'innovation clé de ReMoE réside dans son mécanisme de routage. En remplaçant le fonctionnement discontinu de TopK par une approche continue basée sur ReLU, ReMoE élimine les changements brusques dans l'activation des experts, garantissant ainsi des mises à jour de gradient plus fluides et une meilleure stabilité pendant l'entraînement. De plus, le mécanisme de routage dynamique de ReMoE permet d'ajuster le nombre d'experts actifs en fonction de la complexité des jetons, favorisant ainsi une utilisation efficace des ressources.

To address imbalances where some experts might remain underutilized, ReMoE incorporates an adaptive load-balancing strategy into its L1 regularization. This refinement ensures a fairer distribution of token assignments across experts, enhancing the model’s capacity and overall performance. The architecture’s scalability is evident in its ability to handle a larger number of experts and finer levels of granularity compared to traditional MoE models.

Pour remédier aux déséquilibres où certains experts pourraient rester sous-utilisés, ReMoE intègre une stratégie d'équilibrage de charge adaptative dans sa régularisation L1. Cet affinement garantit une répartition plus équitable des attributions de jetons entre les experts, améliorant ainsi la capacité et les performances globales du modèle. L'évolutivité de l'architecture est évidente dans sa capacité à gérer un plus grand nombre d'experts et des niveaux de granularité plus fins par rapport aux modèles MoE traditionnels.

Performance Insights and Experimental Results

Informations sur les performances et résultats expérimentaux

Extensive experiments demonstrate that ReMoE consistently outperforms conventional MoE architectures. The researchers tested ReMoE using the LLaMA architecture, training models of varying sizes (182M to 978M parameters) with different numbers of experts (4 to 128). Key findings include:

Des expériences approfondies démontrent que ReMoE surpasse systématiquement les architectures MoE conventionnelles. Les chercheurs ont testé ReMoE en utilisant l'architecture LLaMA, en formant des modèles de différentes tailles (182 M à 978 M de paramètres) avec différents nombres d'experts (4 à 128). Les principales conclusions comprennent :

For instance, on downstream tasks like ARC, BoolQ, and LAMBADA, ReMoE showed measurable accuracy improvements over both dense and TopK-routed MoE models. Analyses of training and inference throughput revealed that ReMoE’s differentiable design introduces minimal computational overhead, making it suitable for practical applications.

Par exemple, sur les tâches en aval telles que ARC, BoolQ et LAMBADA, ReMoE a montré des améliorations mesurables en termes de précision par rapport aux modèles MoE denses et acheminés par TopK. Les analyses du débit de formation et d'inférence ont révélé que la conception différenciable de ReMoE introduit une surcharge de calcul minimale, ce qui la rend adaptée aux applications pratiques.

Conclusion

ReMoE presents a valuable advance in Mixture-of-Experts architectures by addressing the limitations of TopK+Softmax routing. The ReLU-based routing mechanism, combined with adaptive regularization techniques, ensures that ReMoE is both efficient and adaptable. This innovation highlights the potential of revisiting foundational design choices to achieve better scalability and performance. By offering a practical and resource-conscious approach, ReMoE provides a useful tool for advancing AI systems to meet growing computational demands.

ReMoE présente une avancée précieuse dans les architectures mixtes d'experts en répondant aux limites du routage TopK+Softmax. Le mécanisme de routage basé sur ReLU, combiné à des techniques de régularisation adaptative, garantit que ReMoE est à la fois efficace et adaptable. Cette innovation met en évidence le potentiel de revisiter les choix de conception fondamentaux pour obtenir une meilleure évolutivité et de meilleures performances. En proposant une approche pratique et soucieuse des ressources, ReMoE fournit un outil utile pour faire progresser les systèmes d’IA afin de répondre aux demandes informatiques croissantes.

Check out the Paper and GitHub Page. All credit for this research goes to the researchers of this project. Also, don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. Don’t Forget to join our 60k+ ML SubReddit.

Consultez la page Paper et GitHub. Tout le mérite de cette recherche revient aux chercheurs de ce projet. N'oubliez pas non plus de nous suivre sur Twitter et de rejoindre notre chaîne Telegram et notre groupe LinkedIn. N'oubliez pas de rejoindre notre SubReddit de plus de 60 000 ML.

Trending: LG AI Research Releases EXAONE 3.5: Three Open-Source Bilingual Frontier AI-level Models Delivering Unmatched Instruction Following and Long Context Understanding for Global Leadership in Generative AI Excellence…

Tendance : LG AI Research publie EXAONE 3.5 : trois modèles de niveau IA Frontier bilingues open source offrant un suivi d'instructions inégalé et une longue compréhension du contexte pour un leadership mondial en matière d'excellence en IA générative…

Clause de non-responsabilité:info@kdj.com

Les informations fournies ne constituent pas des conseils commerciaux. kdj.com n’assume aucune responsabilité pour les investissements effectués sur la base des informations fournies dans cet article. Les crypto-monnaies sont très volatiles et il est fortement recommandé d’investir avec prudence après une recherche approfondie!

Si vous pensez que le contenu utilisé sur ce site Web porte atteinte à vos droits d’auteur, veuillez nous contacter immédiatement (info@kdj.com) et nous le supprimerons dans les plus brefs délais.

-

-

-

-

-

-

- Ray Dalio, Bitcoin et perturbations: naviguer dans l'avenir de la finance

- Jul 05, 2025 at 11:10 pm

- Ray Dalio met en garde contre les «perturbations douloureuses» en raison de l'explosion de la dette américaine. Bitcoin, en particulier les projets comme Bitcoin Hyper ($ hyper), la réponse? Plongeons-nous.

-

-

- Les blocs de morts-vivants augmentent à nouveau: Avalanche Blockchain, Blackhole Partnership et une feuille de route jusqu'en 2026

- Jul 05, 2025 at 10:55 pm

- Les blocs de morts-vivants relancent sur Avalanche avec Blackhole, offrant de nouvelles fonctionnalités et une feuille de route jusqu'en 2026. Préparez-vous pour le meurtre de zombies et le gain de crypto!

-