|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Nachrichtenartikel zu Kryptowährungen

ReMoE: ReLU-basierte Mixture-of-Experts-Architektur für skalierbares und effizientes Training

Dec 29, 2024 at 04:05 pm

Die Entwicklung von Transformer-Modellen hat die künstliche Intelligenz erheblich weiterentwickelt und eine bemerkenswerte Leistung bei verschiedenen Aufgaben erbracht. Diese Fortschritte gehen jedoch oft mit hohen Rechenanforderungen einher und stellen Herausforderungen in Bezug auf Skalierbarkeit und Effizienz dar. Sparsam aktivierte Mixture-of-Experts (MoE)-Architekturen stellen eine vielversprechende Lösung dar und ermöglichen eine erhöhte Modellkapazität ohne proportionale Rechenkosten. Dennoch weist das herkömmliche TopK+Softmax-Routing in MoE-Modellen erhebliche Einschränkungen auf. Die diskrete und nicht differenzierbare Natur des TopK-Routings behindert die Skalierbarkeit und Optimierung, während die Gewährleistung einer ausgewogenen Expertenauslastung weiterhin ein anhaltendes Problem darstellt, das zu Ineffizienzen und suboptimaler Leistung führt.

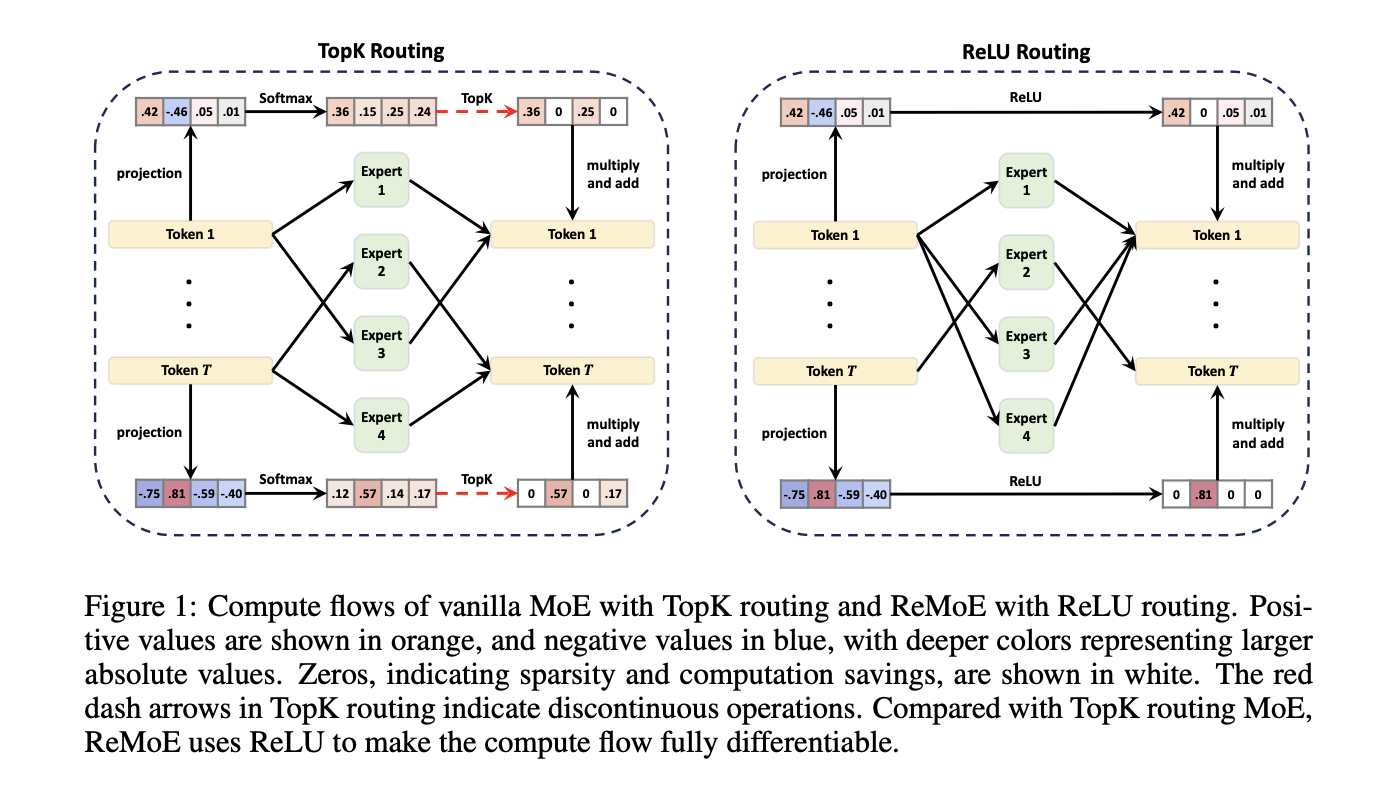

Mixture-of-Experts (MoE) architectures have emerged as a powerful technique to increase the capacity of Transformer models without incurring proportional computational costs. However, traditional TopK+Softmax routing in MoE models presents several limitations, including the discrete and non-differentiable nature of TopK routing, which hampers scalability and optimization, and the difficulty in ensuring balanced expert utilization, leading to inefficiencies and suboptimal performance.

Mixture-of-Experts (MoE)-Architekturen haben sich als leistungsstarke Technik zur Erhöhung der Kapazität von Transformer-Modellen erwiesen, ohne dass entsprechende Rechenkosten anfallen. Das herkömmliche TopK+Softmax-Routing in MoE-Modellen weist jedoch mehrere Einschränkungen auf, darunter die diskrete und nicht differenzierbare Natur des TopK-Routings, die die Skalierbarkeit und Optimierung beeinträchtigt, und die Schwierigkeit, eine ausgewogene Expertennutzung sicherzustellen, was zu Ineffizienzen und suboptimaler Leistung führt.

To address these limitations, researchers at Tsinghua University have proposed a new architecture called ReMoE (ReLU-based Mixture-of-Experts). ReMoE replaces the conventional TopK+Softmax routing with a ReLU-based mechanism, enabling a fully differentiable routing process. This design simplifies the architecture and seamlessly integrates with existing MoE systems.

Um diese Einschränkungen zu beseitigen, haben Forscher der Tsinghua-Universität eine neue Architektur namens ReMoE (ReLU-based Mixture-of-Experts) vorgeschlagen. ReMoE ersetzt das herkömmliche TopK+Softmax-Routing durch einen ReLU-basierten Mechanismus und ermöglicht so einen vollständig differenzierbaren Routing-Prozess. Dieses Design vereinfacht die Architektur und lässt sich nahtlos in bestehende MoE-Systeme integrieren.

ReMoE utilizes ReLU activation functions to dynamically determine the active state of experts. In contrast to TopK routing, which activates only the top-k experts based on a discrete probability distribution, ReMoE’s ReLU routing transitions smoothly between active and inactive states. The sparsity of activated experts is controlled using adaptive L1 regularization, ensuring efficient computation while maintaining high performance. This differentiable design also allows for dynamic allocation of resources across tokens and layers, adapting to the complexity of individual inputs.

ReMoE nutzt ReLU-Aktivierungsfunktionen, um den aktiven Status von Experten dynamisch zu bestimmen. Im Gegensatz zum TopK-Routing, das nur die Top-K-Experten auf der Grundlage einer diskreten Wahrscheinlichkeitsverteilung aktiviert, wechselt das ReLU-Routing von ReMoE reibungslos zwischen aktiven und inaktiven Zuständen. Die geringe Anzahl aktivierter Experten wird mithilfe der adaptiven L1-Regularisierung gesteuert, wodurch eine effiziente Berechnung bei gleichzeitig hoher Leistung gewährleistet wird. Dieses differenzierbare Design ermöglicht auch eine dynamische Zuweisung von Ressourcen über Token und Schichten hinweg und passt sich so der Komplexität einzelner Eingaben an.

Technical Details and Benefits

Technische Details und Vorteile

The key innovation of ReMoE lies in its routing mechanism. By replacing the discontinuous TopK operation with a continuous ReLU-based approach, ReMoE eliminates abrupt changes in expert activation, ensuring smoother gradient updates and improved stability during training. Additionally, ReMoE’s dynamic routing mechanism allows for adjusting the number of active experts based on token complexity, promoting efficient resource utilization.

Die wichtigste Innovation von ReMoE liegt in seinem Routing-Mechanismus. Durch den Ersatz des diskontinuierlichen TopK-Betriebs durch einen kontinuierlichen ReLU-basierten Ansatz eliminiert ReMoE abrupte Änderungen bei der Expertenaktivierung und sorgt so für reibungslosere Gradientenaktualisierungen und eine verbesserte Stabilität während des Trainings. Darüber hinaus ermöglicht der dynamische Routing-Mechanismus von ReMoE die Anpassung der Anzahl aktiver Experten basierend auf der Token-Komplexität und fördert so eine effiziente Ressourcennutzung.

To address imbalances where some experts might remain underutilized, ReMoE incorporates an adaptive load-balancing strategy into its L1 regularization. This refinement ensures a fairer distribution of token assignments across experts, enhancing the model’s capacity and overall performance. The architecture’s scalability is evident in its ability to handle a larger number of experts and finer levels of granularity compared to traditional MoE models.

Um Ungleichgewichte zu beheben, bei denen einige Experten möglicherweise nicht ausreichend ausgelastet sind, integriert ReMoE eine adaptive Lastausgleichsstrategie in seine L1-Regularisierung. Diese Verfeinerung sorgt für eine gerechtere Verteilung der Token-Zuweisungen unter den Experten und verbessert so die Kapazität und Gesamtleistung des Modells. Die Skalierbarkeit der Architektur zeigt sich darin, dass sie im Vergleich zu herkömmlichen MoE-Modellen eine größere Anzahl von Experten und eine feinere Granularität bewältigen kann.

Performance Insights and Experimental Results

Leistungseinblicke und experimentelle Ergebnisse

Extensive experiments demonstrate that ReMoE consistently outperforms conventional MoE architectures. The researchers tested ReMoE using the LLaMA architecture, training models of varying sizes (182M to 978M parameters) with different numbers of experts (4 to 128). Key findings include:

Umfangreiche Experimente zeigen, dass ReMoE herkömmliche MoE-Architekturen durchweg übertrifft. Die Forscher testeten ReMoE mithilfe der LLaMA-Architektur und trainierten Modelle unterschiedlicher Größe (182 Mio. bis 978 Mio. Parameter) mit einer unterschiedlichen Anzahl von Experten (4 bis 128). Zu den wichtigsten Erkenntnissen gehören:

For instance, on downstream tasks like ARC, BoolQ, and LAMBADA, ReMoE showed measurable accuracy improvements over both dense and TopK-routed MoE models. Analyses of training and inference throughput revealed that ReMoE’s differentiable design introduces minimal computational overhead, making it suitable for practical applications.

Beispielsweise zeigte ReMoE bei Downstream-Aufgaben wie ARC, BoolQ und LAMBADA messbare Genauigkeitsverbesserungen gegenüber dichten und TopK-gerouteten MoE-Modellen. Analysen des Trainings- und Inferenzdurchsatzes ergaben, dass das differenzierbare Design von ReMoE einen minimalen Rechenaufwand mit sich bringt und es für praktische Anwendungen geeignet macht.

Conclusion

Abschluss

ReMoE presents a valuable advance in Mixture-of-Experts architectures by addressing the limitations of TopK+Softmax routing. The ReLU-based routing mechanism, combined with adaptive regularization techniques, ensures that ReMoE is both efficient and adaptable. This innovation highlights the potential of revisiting foundational design choices to achieve better scalability and performance. By offering a practical and resource-conscious approach, ReMoE provides a useful tool for advancing AI systems to meet growing computational demands.

ReMoE stellt einen wertvollen Fortschritt in Mixture-of-Experts-Architekturen dar, indem es die Einschränkungen des TopK+Softmax-Routings beseitigt. Der ReLU-basierte Routing-Mechanismus stellt in Kombination mit adaptiven Regularisierungstechniken sicher, dass ReMoE sowohl effizient als auch anpassungsfähig ist. Diese Innovation unterstreicht das Potenzial einer Überarbeitung grundlegender Designentscheidungen, um eine bessere Skalierbarkeit und Leistung zu erreichen. Durch den praktischen und ressourcenschonenden Ansatz bietet ReMoE ein nützliches Werkzeug zur Weiterentwicklung von KI-Systemen, um den wachsenden Rechenanforderungen gerecht zu werden.

Check out the Paper and GitHub Page. All credit for this research goes to the researchers of this project. Also, don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. Don’t Forget to join our 60k+ ML SubReddit.

Schauen Sie sich die Paper- und GitHub-Seite an. Alle Anerkennung für diese Forschung gebührt den Forschern dieses Projekts. Vergessen Sie auch nicht, uns auf Twitter zu folgen und unserem Telegram-Kanal und unserer LinkedIn-Gruppe beizutreten. Vergessen Sie nicht, unserem über 60.000 ML großen SubReddit beizutreten.

Trending: LG AI Research Releases EXAONE 3.5: Three Open-Source Bilingual Frontier AI-level Models Delivering Unmatched Instruction Following and Long Context Understanding for Global Leadership in Generative AI Excellence…

Trend: LG AI Research veröffentlicht EXAONE 3.5: Drei Open-Source-Modelle auf zweisprachiger Frontier-KI-Ebene, die unübertroffene Anleitungsfolge und langes Kontextverständnis für eine weltweite Führung in generativer KI-Exzellenz bieten …

Haftungsausschluss:info@kdj.com

Die bereitgestellten Informationen stellen keine Handelsberatung dar. kdj.com übernimmt keine Verantwortung für Investitionen, die auf der Grundlage der in diesem Artikel bereitgestellten Informationen getätigt werden. Kryptowährungen sind sehr volatil und es wird dringend empfohlen, nach gründlicher Recherche mit Vorsicht zu investieren!

Wenn Sie glauben, dass der auf dieser Website verwendete Inhalt Ihr Urheberrecht verletzt, kontaktieren Sie uns bitte umgehend (info@kdj.com) und wir werden ihn umgehend löschen.

-

- Seltene Münzauktion Manie: £ 150.000 Schätze und darüber hinaus!

- Sep 18, 2025 at 02:00 pm

- Tauchen Sie in die aufregende Welt der seltenen Münzauktionen ein, in der Geschichte und Numismatik kollidieren, wobei Stücke Preise über 150.000 Pfund erzielen. Entdecken Sie die wichtigsten Trends und Erkenntnisse, die diesen aufregenden Markt vorantreiben.

-

-

-

- V23 -Upgrade von Pi Network: ebnen Sie den Weg für Leistung und Skalierbarkeit?

- Sep 18, 2025 at 01:30 pm

- Das V23 -Upgrade markiert einen wesentlichen Schritt für das PI -Netzwerk, wodurch die Leistung, Skalierbarkeit und Compliance verbessert und es für eine breitere Akzeptanz in der Web3 -Landschaft positioniert wird. Aber ist es genug?

-

-

- Der Versorgungsunterbrecher des PI -Netzwerks: Pioniere treiben die Zukunft voran

- Sep 18, 2025 at 01:20 pm

- Das PI -Netzwerk wechselt von einem spekulativen Experiment zu einer Plattform mit echtem Nutzen, das von seinen speziellen Pionieren angetrieben wird. Der Oktober markiert einen entscheidenden Moment.

-

-

-

- Golden Trump Bitcoin Statue Sparks Krypto -Debatte inmitten der Fed -Ratenkürzung

- Sep 18, 2025 at 12:56 pm

- In der Nähe des Kapitols erschien eine goldene Statue von Trump, die ein Bitcoin in der Nähe des Capitols erschien, und zündete die Krypto -Debatte zusammen mit einer Fed -Rate -Kürzung an. Was ist die wahre Botschaft?