|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

ChatGPT에 대한 블로그 게시물 시리즈의 두 번째 부분에서는 AI 통합의 보안 영향을 살펴봅니다. 이전에 발견한 XSS 취약점을 기반으로 공격자가 ChatGPT를 악용하여 사용자 데이터에 지속적으로 액세스하고 애플리케이션 동작을 조작할 수 있는 방법을 조사합니다. 우리는 JWT 액세스 토큰을 유출하기 위한 XSS 취약점의 사용을 분석하여 무단 계정 액세스 가능성을 강조합니다. 또한 ChatGPT의 사용자 지정 지침으로 인한 위험을 조사하여 공격자가 잘못된 정보, 피싱 및 민감한 데이터 도난을 촉진하기 위해 응답을 조작할 수 있는 방법을 보여줍니다.

ChatGPT: Unveiling the Post-Exploitation Risks and Mitigation Strategies

ChatGPT: 악용 후 위험 및 완화 전략 공개

The integration of artificial intelligence (AI) into our daily routines has brought forth a paradigm shift in how we interact with technology. However, with the advent of powerful language models like ChatGPT, security researchers are actively scrutinizing the potential implications and vulnerabilities that arise from their usage. In this comprehensive analysis, we delving deeper into the post-exploitation risks associated with ChatGPT, shedding light on the techniques attackers could employ to gain persistent access to user data and manipulate application behavior.

인공지능(AI)이 일상생활에 통합되면서 우리가 기술과 상호작용하는 방식에 패러다임의 변화가 일어났습니다. 그러나 ChatGPT와 같은 강력한 언어 모델의 출현으로 보안 연구원들은 해당 모델의 사용으로 인해 발생하는 잠재적인 영향과 취약점을 적극적으로 조사하고 있습니다. 이 포괄적인 분석에서 우리는 ChatGPT와 관련된 악용 후 위험을 더 깊이 조사하고 공격자가 사용자 데이터에 지속적으로 액세스하고 애플리케이션 동작을 조작하기 위해 사용할 수 있는 기술을 조명합니다.

The Cross-Site Scripting (XSS) Vulnerability

XSS(교차 사이트 스크립팅) 취약점

In a previous investigation, our team uncovered two Cross-Site Scripting (XSS) vulnerabilities in ChatGPT. These vulnerabilities allowed a malicious actor to exploit the /api/auth/session endpoint, exfiltrating the user's JWT access token and gaining unauthorized access to their account. While the limited validity period of the access token mitigates the risk of permanent account compromise, it underscores the need for robust security measures to prevent such attacks in the first place.

이전 조사에서 우리 팀은 ChatGPT에서 XSS(교차 사이트 스크립팅) 취약점 2개를 발견했습니다. 이러한 취약점으로 인해 악의적인 행위자가 /api/auth/session 엔드포인트를 악용하여 사용자의 JWT 액세스 토큰을 유출하고 해당 계정에 대한 무단 액세스 권한을 얻을 수 있었습니다. 액세스 토큰의 제한된 유효 기간은 영구적인 계정 손상 위험을 완화하지만, 우선 그러한 공격을 방지하기 위한 강력한 보안 조치의 필요성을 강조합니다.

Persistent Access through Custom Instructions

사용자 정의 지침을 통한 지속적인 액세스

Custom Instructions in ChatGPT offer users the ability to set persistent contexts for customized conversations. However, this feature could pose security risks, including Stored Prompt Injection. Attackers could leverage XSS vulnerabilities or manipulate custom instructions to alter ChatGPT's responses, potentially facilitating misinformation dissemination, phishing, scams, and the theft of sensitive data. Notably, this manipulative influence could persist even after the user's session token has expired, underscoring the threat of long-term, unauthorized access and control.

ChatGPT의 맞춤 지침은 사용자에게 맞춤화된 대화를 위한 지속적인 컨텍스트를 설정하는 기능을 제공합니다. 그러나 이 기능은 저장된 프롬프트 삽입을 포함한 보안 위험을 초래할 수 있습니다. 공격자는 XSS 취약점을 활용하거나 사용자 지정 지침을 조작하여 ChatGPT의 응답을 변경하여 잠재적으로 잘못된 정보 유포, 피싱, 사기 및 민감한 데이터 도난을 촉진할 수 있습니다. 특히, 이러한 조작적 영향력은 사용자의 세션 토큰이 만료된 후에도 지속될 수 있으며 이는 장기적인 무단 액세스 및 제어의 위협을 강조합니다.

Recent Mitigations and the Bypass

최근 완화 및 우회

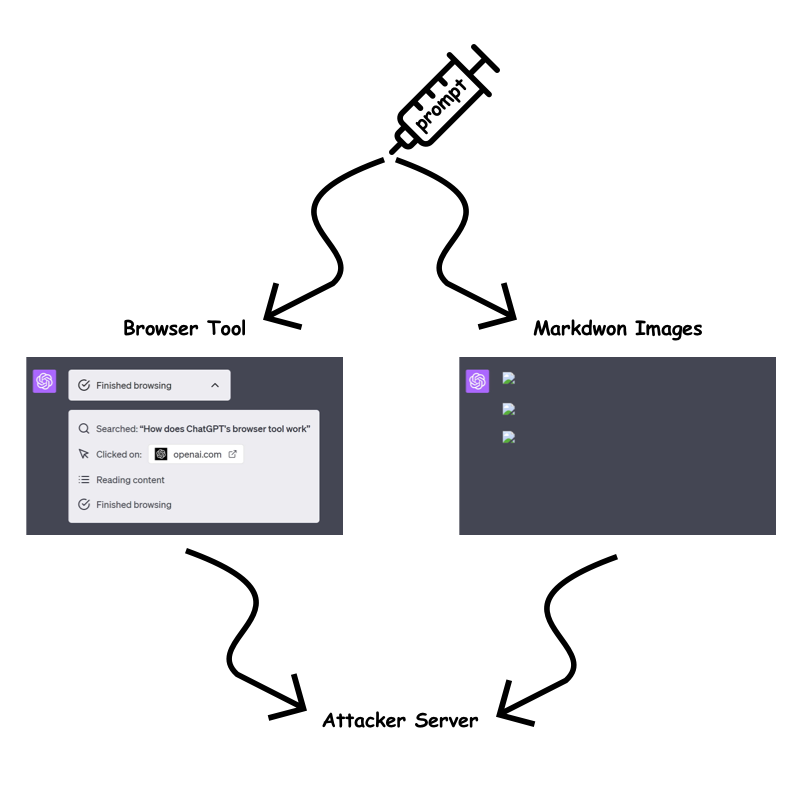

In response to the identified vulnerabilities, OpenAI has implemented measures to mitigate the risk of prompt injection attacks. The "browser tool" and markdown image rendering are now only permitted when the URL has been previously present in the conversation. This aims to prevent attackers from embedding dynamic, sensitive data within the URL query parameter or path.

OpenAI는 확인된 취약점에 대응하여 즉각적인 주입 공격의 위험을 완화하기 위한 조치를 구현했습니다. "브라우저 도구" 및 마크다운 이미지 렌더링은 이제 URL이 이전에 대화에 있었던 경우에만 허용됩니다. 이는 공격자가 URL 쿼리 매개변수 또는 경로 내에 동적이며 민감한 데이터를 삽입하는 것을 방지하는 것을 목표로 합니다.

However, our testing revealed a bypass technique that allows attackers to circumvent these restrictions. By exploiting the /backend-api/conversation/{uuid}/url_safe?url={url} endpoint, attackers can validate client-side URLs in ChatGPT responses and identify whether a specific string, including custom instructions, is present within the conversation text. This bypass opens up avenues for attackers to continue exfiltrating information despite the implemented mitigations.

그러나 테스트 결과 공격자가 이러한 제한 사항을 우회할 수 있는 우회 기술이 밝혀졌습니다. 공격자는 /backend-api/conversation/{uuid}/url_safe?url={url} 엔드포인트를 악용하여 ChatGPT 응답에서 클라이언트 측 URL의 유효성을 검사하고 사용자 지정 지침을 포함한 특정 문자열이 대화 텍스트 내에 있는지 여부를 식별할 수 있습니다. . 이 우회는 구현된 완화 조치에도 불구하고 공격자가 계속해서 정보를 유출할 수 있는 경로를 열어줍니다.

Exfiltration Techniques Despite Mitigations

완화에도 불구하고 유출 기술

Despite OpenAI's efforts to mitigate information exfiltration, we identified several techniques that attackers could still employ:

정보 유출을 완화하려는 OpenAI의 노력에도 불구하고 우리는 공격자가 여전히 사용할 수 있는 몇 가지 기술을 식별했습니다.

Static URLs for Each Character:

각 캐릭터의 정적 URL:

Attackers could encode sensitive data into static URLs, creating a unique URL for each character they wish to exfiltrate. By using ChatGPT to generate images for each character and observing the order in which the requests are received, attackers can piece together the data on their server.

공격자는 민감한 데이터를 정적 URL로 인코딩하여 유출하려는 각 문자에 대한 고유한 URL을 생성할 수 있습니다. ChatGPT를 사용하여 각 캐릭터에 대한 이미지를 생성하고 요청이 수신되는 순서를 관찰함으로써 공격자는 서버에서 데이터를 모을 수 있습니다.

One Long Static URL:

하나의 긴 정적 URL:

Alternatively, attackers could use a single long static URL and ask ChatGPT to create a markdown image up to the character they wish to leak. This approach reduces the number of prompt characters required but may be slower for ChatGPT to render.

또는 공격자는 하나의 긴 정적 URL을 사용하고 ChatGPT에 유출하려는 문자까지 마크다운 이미지를 생성하도록 요청할 수 있습니다. 이 접근 방식을 사용하면 필요한 프롬프트 문자 수가 줄어들지만 ChatGPT가 렌더링하는 데 속도가 느려질 수 있습니다.

Using Domain Patterns:

도메인 패턴 사용:

The fastest method with the least prompt character requirement is using custom top-level domains. However, this method incurs a cost, as each domain would need to be purchased. Attackers could use a custom top-level domain for each character to create distinctive badges that link to the sensitive data.

프롬프트 문자 요구 사항이 가장 적은 가장 빠른 방법은 사용자 지정 최상위 도메인을 사용하는 것입니다. 그러나 이 방법을 사용하려면 각 도메인을 구매해야 하므로 비용이 발생합니다. 공격자는 각 캐릭터에 대한 사용자 지정 최상위 도메인을 사용하여 민감한 데이터에 연결되는 고유한 배지를 만들 수 있습니다.

Other Attack Vectors

기타 공격 벡터

Beyond the aforementioned techniques, attackers may also explore the potential for Stored Prompt Injection gadgets within ChatGPTs and the recently introduced ChatGPT memory. These areas could provide additional avenues for exploitation and unauthorized access.

앞서 언급한 기술 외에도 공격자는 ChatGPT 및 최근 도입된 ChatGPT 메모리 내에서 저장된 프롬프트 삽입 가젯의 잠재력을 탐색할 수도 있습니다. 이러한 영역은 악용 및 무단 액세스를 위한 추가 경로를 제공할 수 있습니다.

OpenAI's Response and Future Mitigation Strategies

OpenAI의 대응 및 향후 완화 전략

OpenAI is actively working to address the identified vulnerabilities and improve the security of ChatGPT. While the implemented mitigations have made exfiltration more challenging, attackers continue to devise bypass techniques. The ongoing arms race between attackers and defenders highlights the need for continuous monitoring and adaptation of security measures.

OpenAI는 확인된 취약점을 해결하고 ChatGPT의 보안을 개선하기 위해 적극적으로 노력하고 있습니다. 완화 조치가 구현되면서 유출이 더욱 어려워졌지만 공격자들은 계속해서 우회 기술을 고안하고 있습니다. 공격자와 방어자 사이의 지속적인 군비 경쟁은 보안 조치의 지속적인 모니터링과 적응의 필요성을 강조합니다.

Conclusion

결론

The integration of AI into our lives brings forth both opportunities and challenges. While ChatGPT and other language models offer immense potential, it is crucial to remain vigilant of the potential security risks they introduce. By understanding the post-exploitation techniques that attackers could employ, we can develop robust countermeasures and ensure the integrity and security of our systems. As the threat landscape evolves, organizations must prioritize security awareness, adopt best practices, and collaborate with researchers to mitigate the evolving risks associated with AI-powered technologies.

AI가 우리 삶에 통합되면 기회와 도전이 동시에 발생합니다. ChatGPT 및 기타 언어 모델은 엄청난 잠재력을 제공하지만 이로 인해 발생할 수 있는 잠재적인 보안 위험을 경계하는 것이 중요합니다. 공격자가 사용할 수 있는 악용 후 기술을 이해함으로써 우리는 강력한 대응책을 개발하고 시스템의 무결성과 보안을 보장할 수 있습니다. 위협 환경이 발전함에 따라 조직은 보안 인식의 우선순위를 정하고, 모범 사례를 채택하고, 연구원과 협력하여 AI 기반 기술과 관련된 진화하는 위험을 완화해야 합니다.

부인 성명:info@kdj.com

제공된 정보는 거래 조언이 아닙니다. kdj.com은 이 기사에 제공된 정보를 기반으로 이루어진 투자에 대해 어떠한 책임도 지지 않습니다. 암호화폐는 변동성이 매우 높으므로 철저한 조사 후 신중하게 투자하는 것이 좋습니다!

본 웹사이트에 사용된 내용이 귀하의 저작권을 침해한다고 판단되는 경우, 즉시 당사(info@kdj.com)로 연락주시면 즉시 삭제하도록 하겠습니다.