|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

Vulnérabilité ChatGPT : accès persistant et risque de violation de données exposé

Mar 28, 2024 at 09:00 pm

Dans la deuxième partie de notre série d'articles de blog sur ChatGPT, nous explorons les implications de sécurité de l'intégration de l'IA. Sur la base de notre précédente découverte de vulnérabilités XSS, nous examinons comment les attaquants pourraient exploiter ChatGPT pour obtenir un accès persistant aux données utilisateur et manipuler le comportement des applications. Nous analysons l'utilisation des vulnérabilités XSS pour exfiltrer les jetons d'accès JWT, mettant en évidence le potentiel d'accès non autorisé aux comptes. Nous étudions également les risques posés par les instructions personnalisées dans ChatGPT, démontrant comment les attaquants peuvent manipuler les réponses pour faciliter la désinformation, le phishing et le vol de données sensibles.

ChatGPT: Unveiling the Post-Exploitation Risks and Mitigation Strategies

ChatGPT : dévoiler les risques post-exploitation et les stratégies d'atténuation

The integration of artificial intelligence (AI) into our daily routines has brought forth a paradigm shift in how we interact with technology. However, with the advent of powerful language models like ChatGPT, security researchers are actively scrutinizing the potential implications and vulnerabilities that arise from their usage. In this comprehensive analysis, we delving deeper into the post-exploitation risks associated with ChatGPT, shedding light on the techniques attackers could employ to gain persistent access to user data and manipulate application behavior.

L’intégration de l’intelligence artificielle (IA) dans nos routines quotidiennes a entraîné un changement de paradigme dans la façon dont nous interagissons avec la technologie. Cependant, avec l’avènement de modèles linguistiques puissants comme ChatGPT, les chercheurs en sécurité examinent activement les implications et vulnérabilités potentielles qui découlent de leur utilisation. Dans cette analyse complète, nous approfondissons les risques post-exploitation associés à ChatGPT, mettant en lumière les techniques que les attaquants pourraient utiliser pour obtenir un accès persistant aux données des utilisateurs et manipuler le comportement des applications.

The Cross-Site Scripting (XSS) Vulnerability

La vulnérabilité de script intersite (XSS)

In a previous investigation, our team uncovered two Cross-Site Scripting (XSS) vulnerabilities in ChatGPT. These vulnerabilities allowed a malicious actor to exploit the /api/auth/session endpoint, exfiltrating the user's JWT access token and gaining unauthorized access to their account. While the limited validity period of the access token mitigates the risk of permanent account compromise, it underscores the need for robust security measures to prevent such attacks in the first place.

Lors d'une enquête précédente, notre équipe a découvert deux vulnérabilités Cross-Site Scripting (XSS) dans ChatGPT. Ces vulnérabilités ont permis à un acteur malveillant d'exploiter le point de terminaison /api/auth/session, en exfiltrant le jeton d'accès JWT de l'utilisateur et en obtenant un accès non autorisé à son compte. Bien que la période de validité limitée du jeton d'accès atténue le risque de compromission permanente du compte, elle souligne la nécessité de mesures de sécurité robustes pour prévenir de telles attaques en premier lieu.

Persistent Access through Custom Instructions

Accès persistant via des instructions personnalisées

Custom Instructions in ChatGPT offer users the ability to set persistent contexts for customized conversations. However, this feature could pose security risks, including Stored Prompt Injection. Attackers could leverage XSS vulnerabilities or manipulate custom instructions to alter ChatGPT's responses, potentially facilitating misinformation dissemination, phishing, scams, and the theft of sensitive data. Notably, this manipulative influence could persist even after the user's session token has expired, underscoring the threat of long-term, unauthorized access and control.

Les instructions personnalisées dans ChatGPT offrent aux utilisateurs la possibilité de définir des contextes persistants pour des conversations personnalisées. Cependant, cette fonctionnalité pourrait présenter des risques de sécurité, notamment l'injection d'invites stockées. Les attaquants pourraient exploiter les vulnérabilités XSS ou manipuler des instructions personnalisées pour modifier les réponses de ChatGPT, facilitant potentiellement la diffusion de fausses informations, le phishing, les escroqueries et le vol de données sensibles. Notamment, cette influence manipulatrice pourrait persister même après l'expiration du jeton de session de l'utilisateur, soulignant la menace d'un accès et d'un contrôle non autorisés à long terme.

Recent Mitigations and the Bypass

Atténuations récentes et contournement

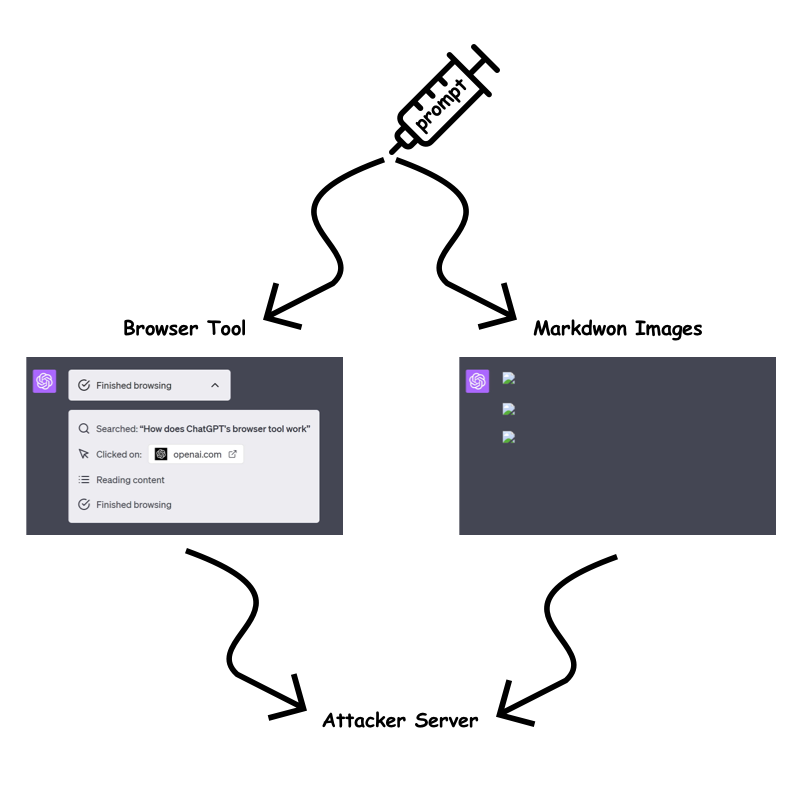

In response to the identified vulnerabilities, OpenAI has implemented measures to mitigate the risk of prompt injection attacks. The "browser tool" and markdown image rendering are now only permitted when the URL has been previously present in the conversation. This aims to prevent attackers from embedding dynamic, sensitive data within the URL query parameter or path.

En réponse aux vulnérabilités identifiées, OpenAI a mis en œuvre des mesures pour atténuer le risque d'attaques par injection rapide. L'"outil de navigation" et le rendu des images markdown ne sont désormais autorisés que lorsque l'URL a été préalablement présente dans la conversation. Cela vise à empêcher les attaquants d'intégrer des données dynamiques et sensibles dans le paramètre ou le chemin de la requête URL.

However, our testing revealed a bypass technique that allows attackers to circumvent these restrictions. By exploiting the /backend-api/conversation/{uuid}/url_safe?url={url} endpoint, attackers can validate client-side URLs in ChatGPT responses and identify whether a specific string, including custom instructions, is present within the conversation text. This bypass opens up avenues for attackers to continue exfiltrating information despite the implemented mitigations.

Cependant, nos tests ont révélé une technique de contournement qui permet aux attaquants de contourner ces restrictions. En exploitant le point de terminaison /backend-api/conversation/{uuid}/url_safe?url={url}, les attaquants peuvent valider les URL côté client dans les réponses ChatGPT et identifier si une chaîne spécifique, y compris des instructions personnalisées, est présente dans le texte de la conversation. . Ce contournement ouvre la voie aux attaquants pour continuer à exfiltrer des informations malgré les mesures d'atténuation mises en œuvre.

Exfiltration Techniques Despite Mitigations

Exfiltration Techniques Despite Mitigations

Despite OpenAI's efforts to mitigate information exfiltration, we identified several techniques that attackers could still employ:

Malgré les efforts d'OpenAI pour atténuer l'exfiltration d'informations, nous avons identifié plusieurs techniques que les attaquants pourraient encore utiliser :

Static URLs for Each Character:

URL statiques pour chaque personnage :

Attackers could encode sensitive data into static URLs, creating a unique URL for each character they wish to exfiltrate. By using ChatGPT to generate images for each character and observing the order in which the requests are received, attackers can piece together the data on their server.

Les attaquants pourraient coder des données sensibles dans des URL statiques, créant ainsi une URL unique pour chaque personnage qu'ils souhaitent exfiltrer. En utilisant ChatGPT pour générer des images pour chaque personnage et en observant l'ordre dans lequel les requêtes sont reçues, les attaquants peuvent rassembler les données sur leur serveur.

One Long Static URL:

Une longue URL statique :

Alternatively, attackers could use a single long static URL and ask ChatGPT to create a markdown image up to the character they wish to leak. This approach reduces the number of prompt characters required but may be slower for ChatGPT to render.

Alternativement, les attaquants pourraient utiliser une seule URL statique longue et demander à ChatGPT de créer une image markdown correspondant au caractère qu'ils souhaitent divulguer. Cette approche réduit le nombre de caractères d'invite requis, mais peut être plus lente à rendre le rendu de ChatGPT.

Using Domain Patterns:

Utilisation de modèles de domaine :

The fastest method with the least prompt character requirement is using custom top-level domains. However, this method incurs a cost, as each domain would need to be purchased. Attackers could use a custom top-level domain for each character to create distinctive badges that link to the sensitive data.

La méthode la plus rapide avec le moins d’exigences de caractères d’invite consiste à utiliser des domaines de premier niveau personnalisés. Cependant, cette méthode entraîne un coût, car chaque domaine devra être acheté. Les attaquants pourraient utiliser un domaine de premier niveau personnalisé pour chaque personnage afin de créer des badges distinctifs liés aux données sensibles.

Other Attack Vectors

Autres vecteurs d'attaque

Beyond the aforementioned techniques, attackers may also explore the potential for Stored Prompt Injection gadgets within ChatGPTs and the recently introduced ChatGPT memory. These areas could provide additional avenues for exploitation and unauthorized access.

Au-delà des techniques susmentionnées, les attaquants peuvent également explorer le potentiel des gadgets d'injection d'invites stockées dans les ChatGPT et la mémoire ChatGPT récemment introduite. Ces zones pourraient offrir des voies supplémentaires d’exploitation et d’accès non autorisé.

OpenAI's Response and Future Mitigation Strategies

Réponse d'OpenAI et futures stratégies d'atténuation

OpenAI is actively working to address the identified vulnerabilities and improve the security of ChatGPT. While the implemented mitigations have made exfiltration more challenging, attackers continue to devise bypass techniques. The ongoing arms race between attackers and defenders highlights the need for continuous monitoring and adaptation of security measures.

OpenAI travaille activement pour corriger les vulnérabilités identifiées et améliorer la sécurité de ChatGPT. Même si les mesures d’atténuation mises en œuvre ont rendu l’exfiltration plus difficile, les attaquants continuent de concevoir des techniques de contournement. La course aux armements en cours entre attaquants et défenseurs met en évidence la nécessité d’une surveillance continue et d’une adaptation des mesures de sécurité.

Conclusion

Conclusion

The integration of AI into our lives brings forth both opportunities and challenges. While ChatGPT and other language models offer immense potential, it is crucial to remain vigilant of the potential security risks they introduce. By understanding the post-exploitation techniques that attackers could employ, we can develop robust countermeasures and ensure the integrity and security of our systems. As the threat landscape evolves, organizations must prioritize security awareness, adopt best practices, and collaborate with researchers to mitigate the evolving risks associated with AI-powered technologies.

L’intégration de l’IA dans nos vies présente à la fois des opportunités et des défis. Bien que ChatGPT et d’autres modèles linguistiques offrent un immense potentiel, il est crucial de rester vigilant quant aux risques de sécurité potentiels qu’ils introduisent. En comprenant les techniques de post-exploitation que les attaquants pourraient utiliser, nous pouvons développer des contre-mesures robustes et garantir l'intégrité et la sécurité de nos systèmes. À mesure que le paysage des menaces évolue, les organisations doivent donner la priorité à la sensibilisation à la sécurité, adopter les meilleures pratiques et collaborer avec les chercheurs pour atténuer les risques évolutifs associés aux technologies basées sur l’IA.

Clause de non-responsabilité:info@kdj.com

Les informations fournies ne constituent pas des conseils commerciaux. kdj.com n’assume aucune responsabilité pour les investissements effectués sur la base des informations fournies dans cet article. Les crypto-monnaies sont très volatiles et il est fortement recommandé d’investir avec prudence après une recherche approfondie!

Si vous pensez que le contenu utilisé sur ce site Web porte atteinte à vos droits d’auteur, veuillez nous contacter immédiatement (info@kdj.com) et nous le supprimerons dans les plus brefs délais.

-

-

-

- Dogwifhat (WIF), un memecoin populaire construit sur la blockchain Solana, montre des signes forts d'une évasion haussier

- Apr 12, 2025 at 11:50 pm

- Au cours des dernières 24 heures, WIF a gagné près de 14%, signalant un renouvellement des intérêts des investisseurs et de l'élan dans le secteur de Memecoin.

-

-

- Les francs suisses et l'or sont devenus parmi les meilleurs actifs de sécurité sûr à mesure que les troubles du marché des actions et des obligations se poursuivent

- Apr 12, 2025 at 11:45 pm

- Les francs suisses et l'or sont devenus parmi les meilleurs actifs à houx de sécurité alors que les troubles du marché des actions et des obligations se poursuivent. Le taux de change USD / CHF a chuté à 0,8100 vendredi

-

-

- Solana (Sol) Price semble primordial pour un rallye de 45% selon un Top Crypto Trader

- Apr 12, 2025 at 11:40 pm

- Ses prévisions haussières interviennent après que la Commission américaine des Securities and Exchange (SEC) a rejeté une poursuite contre l'hélium, un protocole qui se déroule sur la blockchain Sol.

-

-

- Shiba Inu (Shib) fait une fois de plus la une des journaux alors que l'élan haussier pousse le jeton plus près de son niveau de résistance clé

- Apr 12, 2025 at 11:35 pm

- Au cours du temps de presse au prix de 0,00001228 $, Shib a vu une augmentation de 2,66% au cours des dernières 24 heures, attirant l'attention de plus de commerçants.