|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Nachrichtenartikel zu Kryptowährungen

ChatGPT-Sicherheitslücke: Dauerhafter Zugriff und Risiko einer Datenschutzverletzung offengelegt

Mar 28, 2024 at 09:00 pm

Im zweiten Teil unserer Blogbeitragsreihe zu ChatGPT untersuchen wir die Sicherheitsauswirkungen der KI-Integration. Basierend auf unserer früheren Entdeckung von XSS-Schwachstellen untersuchen wir, wie Angreifer ChatGPT ausnutzen könnten, um dauerhaften Zugriff auf Benutzerdaten zu erhalten und das Anwendungsverhalten zu manipulieren. Wir analysieren die Nutzung von XSS-Schwachstellen zur Ausschleusung von JWT-Zugriffstokens und verdeutlichen das Potenzial für unbefugten Kontozugriff. Wir untersuchen auch die Risiken, die von benutzerdefinierten Anweisungen in ChatGPT ausgehen, und zeigen, wie Angreifer Antworten manipulieren können, um Fehlinformationen, Phishing und den Diebstahl sensibler Daten zu erleichtern.

ChatGPT: Unveiling the Post-Exploitation Risks and Mitigation Strategies

ChatGPT: Aufdeckung der Risiken und Minderungsstrategien nach der Ausbeutung

The integration of artificial intelligence (AI) into our daily routines has brought forth a paradigm shift in how we interact with technology. However, with the advent of powerful language models like ChatGPT, security researchers are actively scrutinizing the potential implications and vulnerabilities that arise from their usage. In this comprehensive analysis, we delving deeper into the post-exploitation risks associated with ChatGPT, shedding light on the techniques attackers could employ to gain persistent access to user data and manipulate application behavior.

Die Integration künstlicher Intelligenz (KI) in unseren Alltag hat einen Paradigmenwechsel in der Art und Weise, wie wir mit Technologie interagieren, herbeigeführt. Mit dem Aufkommen leistungsstarker Sprachmodelle wie ChatGPT untersuchen Sicherheitsforscher jedoch aktiv die potenziellen Auswirkungen und Schwachstellen, die sich aus ihrer Verwendung ergeben. In dieser umfassenden Analyse befassen wir uns eingehender mit den mit ChatGPT verbundenen Post-Exploitation-Risiken und beleuchten die Techniken, die Angreifer einsetzen könnten, um dauerhaften Zugriff auf Benutzerdaten zu erlangen und das Anwendungsverhalten zu manipulieren.

The Cross-Site Scripting (XSS) Vulnerability

Die Cross-Site Scripting (XSS)-Schwachstelle

In a previous investigation, our team uncovered two Cross-Site Scripting (XSS) vulnerabilities in ChatGPT. These vulnerabilities allowed a malicious actor to exploit the /api/auth/session endpoint, exfiltrating the user's JWT access token and gaining unauthorized access to their account. While the limited validity period of the access token mitigates the risk of permanent account compromise, it underscores the need for robust security measures to prevent such attacks in the first place.

In einer früheren Untersuchung hat unser Team zwei Cross-Site Scripting (XSS)-Schwachstellen in ChatGPT aufgedeckt. Diese Schwachstellen ermöglichten es einem böswilligen Akteur, den Endpunkt /api/auth/session auszunutzen, das JWT-Zugriffstoken des Benutzers zu exfiltrieren und sich unbefugten Zugriff auf sein Konto zu verschaffen. Die begrenzte Gültigkeitsdauer des Zugriffstokens verringert zwar das Risiko einer dauerhaften Kontokompromittierung, unterstreicht jedoch die Notwendigkeit robuster Sicherheitsmaßnahmen, um solche Angriffe von vornherein zu verhindern.

Persistent Access through Custom Instructions

Permanenter Zugriff durch benutzerdefinierte Anweisungen

Custom Instructions in ChatGPT offer users the ability to set persistent contexts for customized conversations. However, this feature could pose security risks, including Stored Prompt Injection. Attackers could leverage XSS vulnerabilities or manipulate custom instructions to alter ChatGPT's responses, potentially facilitating misinformation dissemination, phishing, scams, and the theft of sensitive data. Notably, this manipulative influence could persist even after the user's session token has expired, underscoring the threat of long-term, unauthorized access and control.

Benutzerdefinierte Anweisungen in ChatGPT bieten Benutzern die Möglichkeit, dauerhafte Kontexte für benutzerdefinierte Konversationen festzulegen. Diese Funktion könnte jedoch Sicherheitsrisiken bergen, einschließlich Stored Prompt Injection. Angreifer könnten XSS-Schwachstellen ausnutzen oder benutzerdefinierte Anweisungen manipulieren, um die Antworten von ChatGPT zu ändern, was möglicherweise die Verbreitung von Fehlinformationen, Phishing, Betrug und den Diebstahl sensibler Daten begünstigt. Insbesondere könnte dieser manipulative Einfluss auch nach Ablauf des Sitzungstokens des Benutzers bestehen bleiben, was die Gefahr eines langfristigen, unbefugten Zugriffs und einer unbefugten Kontrolle unterstreicht.

Recent Mitigations and the Bypass

Aktuelle Abhilfemaßnahmen und die Umgehung

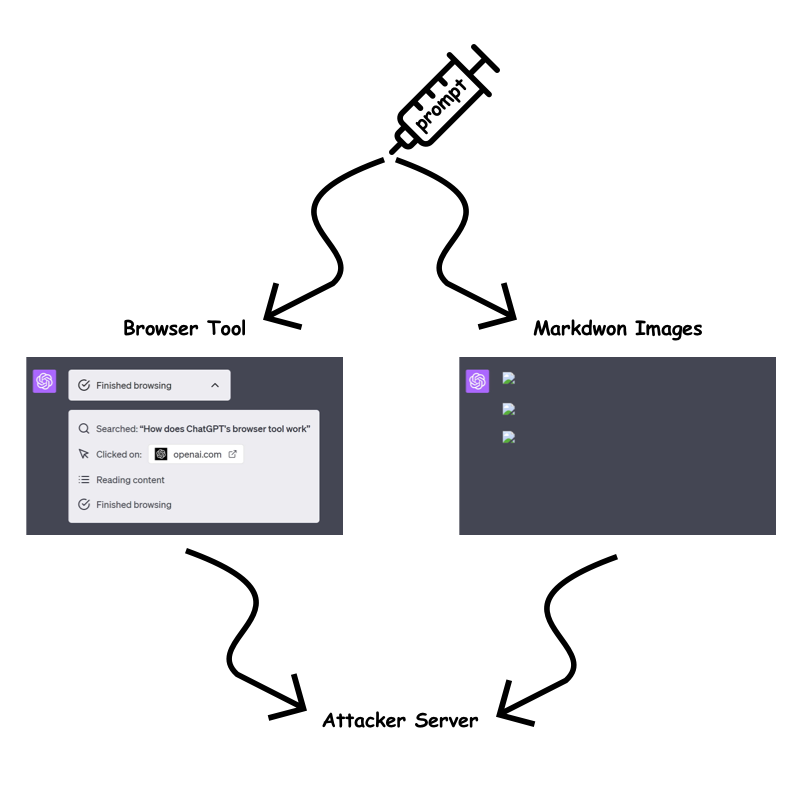

In response to the identified vulnerabilities, OpenAI has implemented measures to mitigate the risk of prompt injection attacks. The "browser tool" and markdown image rendering are now only permitted when the URL has been previously present in the conversation. This aims to prevent attackers from embedding dynamic, sensitive data within the URL query parameter or path.

Als Reaktion auf die identifizierten Schwachstellen hat OpenAI Maßnahmen implementiert, um das Risiko von Prompt-Injection-Angriffen zu mindern. Das „Browser-Tool“ und das Rendern von Markdown-Bildern sind jetzt nur noch zulässig, wenn die URL zuvor in der Konversation vorhanden war. Dadurch soll verhindert werden, dass Angreifer dynamische, sensible Daten in den URL-Abfrageparameter oder -Pfad einbetten.

However, our testing revealed a bypass technique that allows attackers to circumvent these restrictions. By exploiting the /backend-api/conversation/{uuid}/url_safe?url={url} endpoint, attackers can validate client-side URLs in ChatGPT responses and identify whether a specific string, including custom instructions, is present within the conversation text. This bypass opens up avenues for attackers to continue exfiltrating information despite the implemented mitigations.

Unsere Tests haben jedoch eine Umgehungstechnik ergeben, die es Angreifern ermöglicht, diese Einschränkungen zu umgehen. Durch die Ausnutzung des Endpunkts /backend-api/conversation/{uuid}/url_safe?url={url} können Angreifer clientseitige URLs in ChatGPT-Antworten validieren und feststellen, ob eine bestimmte Zeichenfolge, einschließlich benutzerdefinierter Anweisungen, im Konversationstext vorhanden ist . Diese Umgehung eröffnet Angreifern die Möglichkeit, trotz der implementierten Abhilfemaßnahmen weiterhin Informationen herauszufiltern.

Exfiltration Techniques Despite Mitigations

Exfiltrationstechniken trotz Abhilfemaßnahmen

Despite OpenAI's efforts to mitigate information exfiltration, we identified several techniques that attackers could still employ:

Trotz der Bemühungen von OpenAI, die Informationsexfiltration einzudämmen, haben wir mehrere Techniken identifiziert, die Angreifer immer noch einsetzen könnten:

Static URLs for Each Character:

Statische URLs für jedes Zeichen:

Attackers could encode sensitive data into static URLs, creating a unique URL for each character they wish to exfiltrate. By using ChatGPT to generate images for each character and observing the order in which the requests are received, attackers can piece together the data on their server.

Angreifer könnten sensible Daten in statische URLs verschlüsseln und so für jedes Zeichen, das sie exfiltrieren möchten, eine eindeutige URL erstellen. Durch die Verwendung von ChatGPT zur Generierung von Bildern für jeden Charakter und die Beobachtung der Reihenfolge, in der die Anfragen eingehen, können Angreifer die Daten auf ihrem Server zusammensetzen.

One Long Static URL:

Eine lange statische URL:

Alternatively, attackers could use a single long static URL and ask ChatGPT to create a markdown image up to the character they wish to leak. This approach reduces the number of prompt characters required but may be slower for ChatGPT to render.

Alternativ könnten Angreifer eine einzelne lange statische URL verwenden und ChatGPT bitten, ein Markdown-Bild bis zu dem Zeichen zu erstellen, das sie preisgeben möchten. Dieser Ansatz reduziert die Anzahl der erforderlichen Eingabeaufforderungszeichen, kann jedoch zu einer langsameren Darstellung durch ChatGPT führen.

Using Domain Patterns:

Verwenden von Domänenmustern:

The fastest method with the least prompt character requirement is using custom top-level domains. However, this method incurs a cost, as each domain would need to be purchased. Attackers could use a custom top-level domain for each character to create distinctive badges that link to the sensitive data.

Die schnellste Methode mit dem geringsten Bedarf an Eingabeaufforderungen ist die Verwendung benutzerdefinierter Top-Level-Domains. Allerdings ist diese Methode mit Kosten verbunden, da jede Domain erworben werden müsste. Angreifer könnten für jedes Zeichen eine benutzerdefinierte Top-Level-Domain verwenden, um eindeutige Abzeichen zu erstellen, die mit den sensiblen Daten verknüpft sind.

Other Attack Vectors

Andere Angriffsvektoren

Beyond the aforementioned techniques, attackers may also explore the potential for Stored Prompt Injection gadgets within ChatGPTs and the recently introduced ChatGPT memory. These areas could provide additional avenues for exploitation and unauthorized access.

Über die oben genannten Techniken hinaus können Angreifer auch das Potenzial für Stored Prompt Injection-Gadgets in ChatGPTs und dem kürzlich eingeführten ChatGPT-Speicher erkunden. Diese Bereiche könnten zusätzliche Möglichkeiten für Ausbeutung und unbefugten Zugriff bieten.

OpenAI's Response and Future Mitigation Strategies

Die Reaktions- und zukünftigen Schadensbegrenzungsstrategien von OpenAI

OpenAI is actively working to address the identified vulnerabilities and improve the security of ChatGPT. While the implemented mitigations have made exfiltration more challenging, attackers continue to devise bypass techniques. The ongoing arms race between attackers and defenders highlights the need for continuous monitoring and adaptation of security measures.

OpenAI arbeitet aktiv daran, die identifizierten Schwachstellen zu beheben und die Sicherheit von ChatGPT zu verbessern. Obwohl die implementierten Abhilfemaßnahmen die Exfiltration schwieriger gemacht haben, entwickeln Angreifer weiterhin Umgehungstechniken. Das anhaltende Wettrüsten zwischen Angreifern und Verteidigern verdeutlicht die Notwendigkeit einer kontinuierlichen Überwachung und Anpassung von Sicherheitsmaßnahmen.

Conclusion

Abschluss

The integration of AI into our lives brings forth both opportunities and challenges. While ChatGPT and other language models offer immense potential, it is crucial to remain vigilant of the potential security risks they introduce. By understanding the post-exploitation techniques that attackers could employ, we can develop robust countermeasures and ensure the integrity and security of our systems. As the threat landscape evolves, organizations must prioritize security awareness, adopt best practices, and collaborate with researchers to mitigate the evolving risks associated with AI-powered technologies.

Die Integration von KI in unser Leben bringt sowohl Chancen als auch Herausforderungen mit sich. Obwohl ChatGPT und andere Sprachmodelle ein enormes Potenzial bieten, ist es wichtig, wachsam gegenüber den potenziellen Sicherheitsrisiken zu bleiben, die sie mit sich bringen. Indem wir die Post-Exploitation-Techniken verstehen, die Angreifer einsetzen könnten, können wir robuste Gegenmaßnahmen entwickeln und die Integrität und Sicherheit unserer Systeme gewährleisten. Während sich die Bedrohungslandschaft weiterentwickelt, müssen Unternehmen dem Sicherheitsbewusstsein Priorität einräumen, Best Practices übernehmen und mit Forschern zusammenarbeiten, um die sich entwickelnden Risiken im Zusammenhang mit KI-gestützten Technologien zu mindern.

Haftungsausschluss:info@kdj.com

Die bereitgestellten Informationen stellen keine Handelsberatung dar. kdj.com übernimmt keine Verantwortung für Investitionen, die auf der Grundlage der in diesem Artikel bereitgestellten Informationen getätigt werden. Kryptowährungen sind sehr volatil und es wird dringend empfohlen, nach gründlicher Recherche mit Vorsicht zu investieren!

Wenn Sie glauben, dass der auf dieser Website verwendete Inhalt Ihr Urheberrecht verletzt, kontaktieren Sie uns bitte umgehend (info@kdj.com) und wir werden ihn umgehend löschen.

-

-

-

-

-

- Der weltweit erste XRP -ETF namens XRPH11 begann mit dem Handel an der brasilianischen B3 -Börse

- Apr 26, 2025 at 05:30 pm

- Der weltweit erste XRP -ETF namens XRPH11 begann am 25. April 2025 mit dem Handel an der B3 -Börse B3 in Brazil. Der von Hashdex herausgegebene Hashdex XRP ETF konzentriert sich auf die Bereitstellung eines direkten und indirekten Engagements von XRP für institutionelle Anleger.

-

- PI Network (PI) Preis heute

- Apr 26, 2025 at 05:30 pm

- PI Network (PI) handelt mit 0,6513 USD.

-

- Bitgewid erweitert seine ETF -Ambitionen jenseits von Bitcoin und Ethereum - diesmal auf das in der Nähe des Protokolls abzielen

- Apr 26, 2025 at 05:25 pm

- Wenn die Krypto vermarktet und institutionelles Interesse wächst, positioniert sich Bitgewise an der Spitze einer potenziellen neuen Welle von Altcoin-Exchange-Fonds (ETFs).

-

-

![Der Handel folgt, [Review Video] zu folgen, dass Gold Bitcoin -Rohölaufträge profitieren! Der Handel folgt, [Review Video] zu folgen, dass Gold Bitcoin -Rohölaufträge profitieren!](/uploads/2025/04/26/cryptocurrencies-news/videos/trading-follow-review-video-gold-bitcoin-crude-oil-profits/image-1.webp)