|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

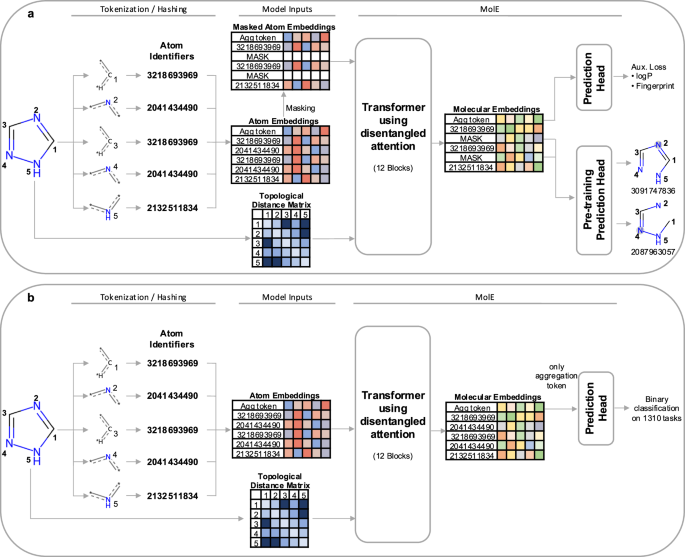

分子グラフ学習用のトランスフォーマーベースのモデルである MolE を紹介します。 MolE は、原子識別子とグラフ接続性の両方を入力トークンとして提供することにより、分子グラフを直接操作します。原子識別子は、さまざまな原子プロパティを 1 つの整数にハッシュすることによって計算され、グラフの接続性はトポロジカル距離行列として与えられます。 MolE は、その基本アーキテクチャとして Transformer を使用します。これは、以前にグラフにも適用されていました。変圧器の性能は、セルフアテンション機構の広範な使用に大きく起因すると考えられます。標準のトランスフォーマーでは、入力トークンはクエリ、キー、値 \(Q,K,V\in {R}^{N\times d}\) に埋め込まれ、次のように自己注意を計算するために使用されます。

MolE is a transformer model designed specifically for molecular graphs. It directly works with graphs by providing both atom identifiers and graph connectivity as input tokens and relative position information, respectively. Atom identifiers are calculated by hashing different atomic properties into a single integer. In particular, this hash contains the following information:

MolE は、分子グラフ用に特別に設計されたトランスフォーマー モデルです。原子識別子とグラフ接続性の両方をそれぞれ入力トークンと相対位置情報として提供することで、グラフを直接操作します。アトム識別子は、さまざまなアトミック プロパティを 1 つの整数にハッシュすることによって計算されます。特に、このハッシュには次の情報が含まれます。

- number of neighboring heavy atoms,

- 隣接する重原子の数、

- number of neighboring hydrogen atoms,

- 隣接する水素原子の数、

- valence minus the number of attached hydrogens,

- 原子価から結合した水素の数を引いたもの、

- atomic charge,

- 原子電荷、

- atomic mass,

- 原子量、

- attached bond types,

- 付属のボンドタイプ、

- and ring membership.

- そしてリングメンバーシップ。

Atom identifiers (also known as atom environments of radius 0) were computed using the Morgan algorithm as implemented in RDKit.

アトム識別子 (半径 0 のアトム環境とも呼ばれます) は、RDKit に実装されているモーガン アルゴリズムを使用して計算されました。

In addition to tokens, MolE also takes graph connectivity information as input which is an important inductive bias since it encodes the relative position of atoms in the molecular graph. In this case, the graph connectivity is given as a topological distance matrix d where dij corresponds to the length of the shortest path over bonds separating atom i from atom j.

トークンに加えて、MolE は、分子グラフ内の原子の相対位置をエンコードするため、重要な誘導バイアスであるグラフ接続情報も入力として受け取ります。この場合、グラフの接続性はトポロジカル距離行列 d として与えられます。ここで、dij は、原子 i と原子 j を隔てる結合上の最短経路の長さに対応します。

MolE uses a Transformer as its base architecture, which also has been applied to graphs previously. The performance of transformers can be attributed in large part to the extensive use of the self-attention mechanism. In standard transformers, the input tokens are embedded into queries, keys and values \(Q,K,V\in {R}^{N\times d}\), which are used to compute self-attention as:

MolE は、その基本アーキテクチャとして Transformer を使用します。これは、以前にグラフにも適用されていました。変圧器の性能は、セルフアテンション機構の広範な使用に大きく起因すると考えられます。標準のトランスフォーマーでは、入力トークンはクエリ、キー、値 \(Q,K,V\in {R}^{N\times d}\) に埋め込まれ、次のように自己注意を計算するために使用されます。

where \({H}_{0}\in {R}^{N\times d}\) are the output hidden vectors after self-attention, and \(d\) is the dimension of the hidden space.

ここで、 \({H}_{0}\in {R}^{N\times d}\) は自己注意後の出力隠れベクトル、\(d\) は隠れ空間の次元です。

In order to explicitly carry positional information through each layer of the transformer, MolE uses the disentangled self-attention from DeBERTa:

トランスフォーマーの各層を通じて位置情報を明示的に伝達するために、MolE は DeBERTa のもつれの解けたセルフアテンションを使用します。

where \({Q}^{c},{K}^{c},{V}^{c}\in {R}^{N\times d}\) are context queries, keys and values that contain token information (used in standard self-attention), and \({Q}_{i,j}^{p},{K}_{i,j}^{p}\in {R}^{N\times d}\) are the position queries and keys that encode the relative position of the \(i{{{\rm{th}}}}\) atom with respect to the \(j{{{\rm{th}}}}\) atom. The use of disentangled attention makes MolE invariant with respect to the order of the input atoms.

ここで、 \({Q}^{c},{K}^{c},{V}^{c}\in {R}^{N\times d}\) は、トークンを含むコンテキスト クエリ、キー、および値です。情報 (標準的なセルフアテンションで使用)、および \({Q}_{i,j}^{p},{K}_{i,j}^{p}\in {R}^{N\times d}\) は、\(j{{{\rm{th}} に対する \(i{{{\rm{th}}}}\) アトムの相対位置をエンコードする位置クエリとキーです。 }}\) アトム。解きほぐされたアテンションを使用すると、入力原子の順序に関して MolE が不変になります。

As mentioned earlier, self-supervised pretraining can effectively transfer information from large unlabeled datasets to smaller datasets with labels. Here we present a two-step pretraining strategy. The first step is a self-supervised approach to learn chemical structure representation. For this we use a BERT-like approach in which each atom is randomly masked with a probability of 15%, from which 80% of the selected tokens are replaced by a mask token, 10% replaced by a random token from the vocabulary, and 10% are not changed. Different from BERT, the prediction task is not to predict the identity of the masked token, but to predict the corresponding atom environment (or functional atom environment) of radius 2, meaning all atoms that are separated from the masked atom by two or less bonds. It is important to keep in mind that we used different tokenization strategies for inputs (radius 0) and labels (radius 2) and that input tokens do not contain overlapping data of neighboring atoms to avoid information leakage. This incentivizes the model to aggregate information from neighboring atoms while learning local molecular features. MolE learns via a classification task where each atom environment of radius 2 has a predefined label, contrary to the Context Prediction approach where the task is to match the embedding of atom environments of radius 4 to the embedding of context atoms (i.e., surrounding atoms beyond radius 4) via negative sampling. The second step uses a graph-level supervised pretraining with a large labeled dataset. As proposed by Hu et al., combining node- and graph-level pretraining helps to learn local and global features that improve the final prediction performance. More details regarding the pretraining steps can be found in the Methods section.

前述したように、自己教師あり事前トレーニングでは、ラベルのない大規模なデータセットからラベル付きの小さなデータセットに情報を効果的に転送できます。ここでは、2 段階の事前トレーニング戦略を紹介します。最初のステップは、化学構造の表現を学習するための自己教師付きアプローチです。このために、BERT のようなアプローチを使用します。このアプローチでは、各アトムが 15% の確率でランダムにマスクされ、選択されたトークンの 80% がマスク トークンに置き換えられ、10% が語彙のランダム トークンに置き換えられます。 10%は変わらない。 BERT とは異なり、予測タスクはマスクされたトークンの正体を予測することではなく、半径 2 の対応する原子環境 (または機能原子環境) を予測することです。これは、マスクされた原子から 2 つ以下の結合によって分離されているすべての原子を意味します。 。入力 (半径 0) とラベル (半径 2) に異なるトークン化戦略を使用したこと、および情報漏洩を避けるために入力トークンには隣接するアトムの重複データが含まれていないことに留意することが重要です。これにより、モデルは局所的な分子の特徴を学習しながら、隣接する原子からの情報を集約するようになります。 MolE は、半径 4 の原子環境の埋め込みをコンテキスト原子 (つまり、それを超えた周囲の原子) の埋め込みと一致させることをタスクとするコンテキスト予測アプローチとは対照的に、半径 2 の各原子環境が事前定義されたラベルを持つ分類タスクを介して学習します。半径 4) ネガティブサンプリング経由。 2 番目のステップでは、大規模なラベル付きデータセットを使用したグラフレベルの教師あり事前トレーニングを使用します。 Hu らによって提案されているように、ノードレベルとグラフレベルの事前トレーニングを組み合わせると、ローカルおよびグローバルな特徴を学習し、最終的な予測パフォーマンスを向上させることができます。事前トレーニング手順の詳細については、「方法」セクションを参照してください。

MolE was pretrained using an ultra-large database of ~842 million molecules from ZINC and ExCAPE-DB, employing a self-supervised scheme (with an auxiliary loss) followed by a supervised pretraining with ~456K molecules (see Methods section for more details). We assess the quality of the molecular embedding by finetuning MolE on a set of downstream tasks. In this case, we use a set of 22 ADMET tasks included in the Therapeutic Data Commons (TDC) benchmark This benchmark is composed of 9 regression and 13 binary classification tasks on datasets that range from hundreds (e.g, DILI with 475 compounds) to thousands of compounds (such as CYP inhibition tasks with ~13,000 compounds). An advantage of using this benchmark is

MolE は、ZINC および ExCAPE-DB の約 8 億 4,200 万分子の超大規模データベースを使用して事前トレーニングされ、自己教師ありスキーム (補助損失あり) に続いて約 456,000 分子を使用した教師付き事前トレーニングを採用しました (詳細については「方法」セクションを参照)。 。一連の下流タスクで MolE を微調整することにより、分子埋め込みの品質を評価します。この場合、Therapeutic Data Commons (TDC) ベンチマークに含まれる 22 の ADMET タスクのセットを使用します。このベンチマークは、数百 (例: 475 化合物を含む DILI) から数千までの範囲のデータセットに対する 9 つの回帰タスクと 13 の二値分類タスクで構成されます。化合物の数 (約 13,000 の化合物を使用した CYP 阻害タスクなど)。このベンチマークを使用する利点は次のとおりです。

免責事項:info@kdj.com

提供される情報は取引に関するアドバイスではありません。 kdj.com は、この記事で提供される情報に基づいて行われた投資に対して一切の責任を負いません。暗号通貨は変動性が高いため、十分な調査を行った上で慎重に投資することを強くお勧めします。

このウェブサイトで使用されているコンテンツが著作権を侵害していると思われる場合は、直ちに当社 (info@kdj.com) までご連絡ください。速やかに削除させていただきます。

-

-

-

-

- 故ソン・ジェリムさんの葬儀、厳粛な雰囲気の中で行われる

- 2024-11-14 22:15:02

- 俳優故ソン・ジェリムさんの告別式が11月14日正午、ソウル永登浦区汝矣島聖母病院で営まれた。

-

-

-

-

-