|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

ビジョン トランスフォーマー (ViT) は、セルフ アテンション メカニズムを使用して画像データを処理する革新的なアーキテクチャを提供することにより、コンピューター ビジョンに革命をもたらしました。特徴抽出を畳み込み層に依存する畳み込みニューラル ネットワーク (CNN) とは異なり、ViT は画像を小さなパッチに分割し、それらを個別のトークンとして扱います。このトークンベースのアプローチにより、大規模なデータセットのスケーラブルかつ効率的な処理が可能になり、ViT は画像分類やオブジェクト検出などの高次元タスクに特に効果的になります。トークン間での情報の流れとトークン内の特徴の抽出方法を切り離す機能により、コンピューター ビジョンのさまざまな課題に対処するための柔軟なフレームワークが提供されます。

Vision Transformers (ViTs) have emerged as a powerful architecture in computer vision, thanks to their self-attention mechanisms that can effectively process image data. Unlike Convolutional Neural Networks (CNNs), which extract features using convolutional layers, ViTs break down images into smaller patches and treat them as individual tokens. This token-based approach enables scalable and efficient processing of large datasets, making ViTs particularly well-suited for high-dimensional tasks like image classification and object detection. The decoupling of how information flows between tokens from how features are extracted within tokens provides a flexible framework for tackling diverse computer vision challenges.

ビジョン トランスフォーマー (ViT) は、画像データを効果的に処理できるセルフ アテンション メカニズムのおかげで、コンピューター ビジョンの強力なアーキテクチャとして登場しました。畳み込み層を使用して特徴を抽出する畳み込みニューラル ネットワーク (CNN) とは異なり、ViT は画像をより小さなパッチに分割し、それらを個別のトークンとして扱います。このトークンベースのアプローチにより、大規模なデータセットのスケーラブルで効率的な処理が可能になり、ViT は画像分類やオブジェクト検出などの高次元タスクに特に適しています。トークン間での情報の流れとトークン内の特徴の抽出方法を切り離すことで、コンピューター ビジョンのさまざまな課題に取り組むための柔軟なフレームワークが提供されます。

Despite their success, a key question that arises is whether pre-training is necessary for ViTs. It has been widely assumed that pre-training enhances downstream task performance by learning useful feature representations. However, recent research has begun to question whether these features are the sole contributors to performance improvements or whether other factors, such as attention patterns, might play a more significant role. This investigation challenges the traditional belief in the dominance of feature learning, suggesting that a deeper understanding of the mechanisms driving ViTs’ effectiveness could lead to more efficient training methodologies and improved performance.

成功にもかかわらず、生じる重要な疑問は、ViT に事前トレーニングが必要かどうかです。事前トレーニングにより、有用な特徴表現を学習することで下流タスクのパフォーマンスが向上すると広く考えられてきました。しかし、最近の研究では、これらの機能がパフォーマンス向上に唯一貢献しているのか、それとも注意パターンなどの他の要素がより重要な役割を果たしているのかという疑問が生じ始めています。この調査は、特徴学習が優勢であるという従来の考えに疑問を投げかけ、ViT の有効性を促進するメカニズムをより深く理解することで、より効率的なトレーニング方法論とパフォーマンスの向上につながる可能性があることを示唆しています。

Conventional approaches to utilizing pre-trained ViTs involve fine-tuning the entire model on specific downstream tasks. This process combines attention transfer and feature learning, making it difficult to isolate each contribution. While knowledge distillation frameworks have been employed to transfer logits or feature representations, they largely ignore the potential of attention patterns. The lack of focused analysis on attention mechanisms limits a comprehensive understanding of their role in improving downstream task outcomes. This gap highlights the need for methods to assess attention maps’ impact independently.

事前トレーニングされた ViT を利用する従来のアプローチには、特定の下流タスクに基づいてモデル全体を微調整することが含まれます。このプロセスでは、注意の伝達と特徴の学習が組み合わされるため、それぞれの寄与を分離することが困難になります。知識蒸留フレームワークは、ロジットや特徴表現を転送するために使用されてきましたが、注意パターンの可能性をほとんど無視しています。注意メカニズムに関する集中的な分析が欠如しているため、下流のタスクの結果を改善する際の注意メカニズムの役割の包括的な理解が制限されています。このギャップは、アテンション マップの影響を独立して評価する方法の必要性を浮き彫りにしています。

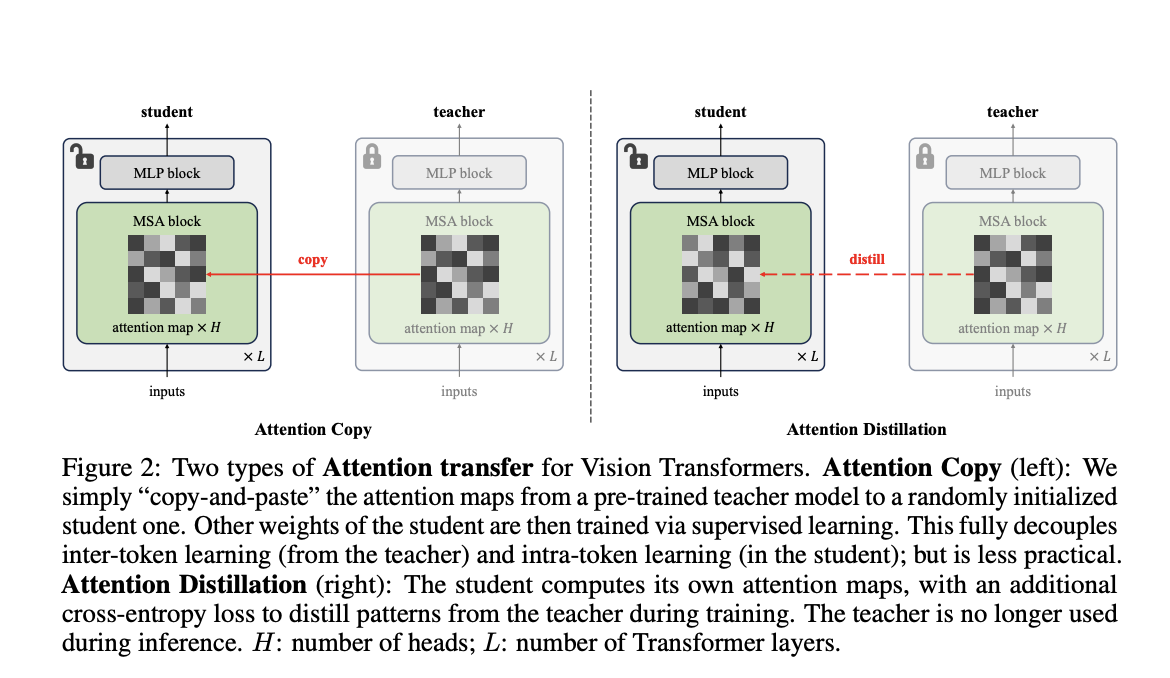

Researchers from Carnegie Mellon University and FAIR have introduced a novel method called “Attention Transfer,” designed to isolate and transfer only the attention patterns from pre-trained ViTs. The proposed framework consists of two methods: Attention Copy and Attention Distillation. In Attention Copy, the pre-trained teacher ViT generates attention maps directly applied to a student model while the student learns all other parameters from scratch. In contrast, Attention Distillation uses a distillation loss function to train the student model to align its attention maps with the teacher’s, requiring the teacher model only during training. These methods separate the intra-token computations from inter-token flow, offering a fresh perspective on pre-training dynamics in ViTs.

カーネギーメロン大学とFAIRの研究者は、事前に訓練されたViTから注意パターンのみを分離して転送するように設計された「注意転送」と呼ばれる新しい方法を導入しました。提案されたフレームワークは、アテンション コピーとアテンション蒸留という 2 つの方法で構成されます。アテンション コピーでは、事前トレーニングされた教師 ViT が学生モデルに直接適用されるアテンション マップを生成し、学生は他のすべてのパラメーターを最初から学習します。対照的に、注意蒸留では、蒸留損失関数を使用して生徒モデルをトレーニングし、その注意マップを教師のものと一致させるため、トレーニング中にのみ教師モデルが必要になります。これらの方法は、トークン内の計算をトークン間のフローから分離し、ViT の事前トレーニング ダイナミクスに関する新たな視点を提供します。

Attention Copy transfers pre-trained attention maps to a student model, effectively guiding how tokens interact without retaining learned features. This setup requires both the teacher and student models during inference, which may add computational complexity. Attention Distillation, on the other hand, refines the student model’s attention maps through a loss function that compares them to the teacher’s patterns. After training, the teacher model is no longer needed, making this approach more practical. Both methods leverage the unique architecture of ViTs, where self-attention maps dictate inter-token relationships, allowing the student to focus on learning its features from scratch.

アテンション コピーは、事前トレーニングされたアテンション マップを学生モデルに転送し、学習した特徴を保持することなくトークンがどのように相互作用するかを効果的にガイドします。この設定では推論中に教師モデルと生徒モデルの両方が必要となるため、計算が複雑になる可能性があります。一方、注意蒸留では、生徒モデルの注意マップを、教師のパターンと比較する損失関数を通じて洗練します。トレーニング後は教師モデルは必要なくなるため、このアプローチはより実用的になります。どちらの方法も、セルフ アテンション マップがトークン間の関係を指示する ViT の独自のアーキテクチャを活用しており、学生はその機能をゼロから学習することに集中できます。

The performance of these methods demonstrates the effectiveness of attention patterns in pre-trained ViTs. Attention Distillation achieved a top-1 accuracy of 85.7% on the ImageNet-1K dataset, equaling the performance of fully fine-tuned models. While slightly less effective, Attention Copy closed 77.8% of the gap between training from scratch and fine-tuning, reaching 85.1% accuracy. Furthermore, ensembling the student and teacher models enhanced accuracy to 86.3%, showcasing the complementary nature of their predictions. The study also revealed that transferring attention maps from task-specific fine-tuned teachers further improved accuracy, demonstrating the adaptability of attention mechanisms to specific downstream requirements. However, challenges arose under data distribution shifts, where attention transfer underperformed compared to weight tuning, highlighting limitations in generalization.

これらのメソッドのパフォーマンスは、事前トレーニングされた ViT における注意パターンの有効性を示しています。注意蒸留は、ImageNet-1K データセットで 85.7% というトップ 1 の精度を達成し、完全に微調整されたモデルのパフォーマンスと同等になりました。効果は若干劣るものの、アテンション コピーはゼロからのトレーニングと微調整の間のギャップを 77.8% 埋め、精度は 85.1% に達しました。さらに、学生モデルと教師モデルをアンサンブルすると精度が 86.3% に向上し、予測の相補的な性質が示されました。この研究では、タスク固有の微調整された教師からアテンション マップを転送することで精度がさらに向上したことも明らかになり、特定の下流要件に対するアテンション メカニズムの適応性が実証されました。しかし、データ分布の変化の下では、重みの調整に比べて注意の伝達が不十分であるという課題が生じ、一般化の限界が浮き彫りになりました。

This research illustrates that pre-trained attention patterns are sufficient for achieving high downstream task performance, questioning the necessity of traditional feature-centric pre-training paradigms. The proposed Attention Transfer method decouples attention mechanisms from feature learning, offering an alternative approach that reduces reliance on computationally intensive weight fine-tuning. While limitations such as distribution shift sensitivity and scalability across diverse tasks remain, this study opens new avenues for optimizing the use of ViTs in computer vision. Future work could address these challenges, refine attention transfer techniques, and explore their applicability to broader domains, paving the way for more efficient, effective machine learning models.

この研究は、事前トレーニングされた注意パターンが下流タスクの高いパフォーマンスを達成するのに十分であることを示しており、従来の機能中心の事前トレーニングパラダイムの必要性に疑問を呈しています。提案されたアテンション転送手法は、アテンション メカニズムを特徴学習から切り離し、計算負荷の高い重み微調整への依存を軽減する代替アプローチを提供します。分散シフトの感度や多様なタスクにわたるスケーラビリティなどの制限はまだ残っていますが、この研究はコンピュータ ビジョンにおける ViT の使用を最適化するための新しい道を開きます。今後の研究では、これらの課題に対処し、注意伝達技術を改良し、より広範な領域への適用可能性を探求し、より効率的で効果的な機械学習モデルへの道を開く可能性があります。

免責事項:info@kdj.com

提供される情報は取引に関するアドバイスではありません。 kdj.com は、この記事で提供される情報に基づいて行われた投資に対して一切の責任を負いません。暗号通貨は変動性が高いため、十分な調査を行った上で慎重に投資することを強くお勧めします。

このウェブサイトで使用されているコンテンツが著作権を侵害していると思われる場合は、直ちに当社 (info@kdj.com) までご連絡ください。速やかに削除させていただきます。