|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

Transfert d'attention : isoler le rôle des mécanismes d'attention dans les transformateurs de vision

Nov 21, 2024 at 06:00 pm

Les Vision Transformers (ViT) ont révolutionné la vision par ordinateur en proposant une architecture innovante qui utilise des mécanismes d'auto-attention pour traiter les données d'image. Contrairement aux réseaux de neurones convolutifs (CNN), qui s'appuient sur des couches convolutives pour l'extraction de fonctionnalités, les ViT divisent les images en patchs plus petits et les traitent comme des jetons individuels. Cette approche basée sur des jetons permet un traitement évolutif et efficace d'ensembles de données volumineux, ce qui rend les ViT particulièrement efficaces pour les tâches de grande dimension telles que la classification d'images et la détection d'objets. Leur capacité à dissocier la manière dont les informations circulent entre les jetons de la manière dont les fonctionnalités sont extraites au sein des jetons fournit un cadre flexible pour relever divers défis de vision par ordinateur.

Vision Transformers (ViTs) have emerged as a powerful architecture in computer vision, thanks to their self-attention mechanisms that can effectively process image data. Unlike Convolutional Neural Networks (CNNs), which extract features using convolutional layers, ViTs break down images into smaller patches and treat them as individual tokens. This token-based approach enables scalable and efficient processing of large datasets, making ViTs particularly well-suited for high-dimensional tasks like image classification and object detection. The decoupling of how information flows between tokens from how features are extracted within tokens provides a flexible framework for tackling diverse computer vision challenges.

Les transformateurs de vision (ViT) sont devenus une architecture puissante en vision par ordinateur, grâce à leurs mécanismes d'auto-attention capables de traiter efficacement les données d'image. Contrairement aux réseaux de neurones convolutifs (CNN), qui extraient des fonctionnalités à l'aide de couches convolutives, les ViT décomposent les images en patchs plus petits et les traitent comme des jetons individuels. Cette approche basée sur des jetons permet un traitement évolutif et efficace d'ensembles de données volumineux, ce qui rend les ViT particulièrement adaptés aux tâches de grande dimension telles que la classification d'images et la détection d'objets. Le découplage entre la manière dont les informations circulent entre les jetons et la manière dont les fonctionnalités sont extraites au sein des jetons fournit un cadre flexible pour relever divers défis de vision par ordinateur.

Despite their success, a key question that arises is whether pre-training is necessary for ViTs. It has been widely assumed that pre-training enhances downstream task performance by learning useful feature representations. However, recent research has begun to question whether these features are the sole contributors to performance improvements or whether other factors, such as attention patterns, might play a more significant role. This investigation challenges the traditional belief in the dominance of feature learning, suggesting that a deeper understanding of the mechanisms driving ViTs’ effectiveness could lead to more efficient training methodologies and improved performance.

Malgré leur succès, une question clé qui se pose est de savoir si une pré-formation est nécessaire pour les ViT. Il est largement admis que la pré-formation améliore les performances des tâches en aval en apprenant des représentations de fonctionnalités utiles. Cependant, des recherches récentes ont commencé à se demander si ces caractéristiques sont les seules à contribuer à l'amélioration des performances ou si d'autres facteurs, tels que les schémas d'attention, pourraient jouer un rôle plus important. Cette enquête remet en question la croyance traditionnelle selon laquelle l'apprentissage des fonctionnalités est dominant, suggérant qu'une compréhension plus approfondie des mécanismes à l'origine de l'efficacité des ViT pourrait conduire à des méthodologies de formation plus efficaces et à des performances améliorées.

Conventional approaches to utilizing pre-trained ViTs involve fine-tuning the entire model on specific downstream tasks. This process combines attention transfer and feature learning, making it difficult to isolate each contribution. While knowledge distillation frameworks have been employed to transfer logits or feature representations, they largely ignore the potential of attention patterns. The lack of focused analysis on attention mechanisms limits a comprehensive understanding of their role in improving downstream task outcomes. This gap highlights the need for methods to assess attention maps’ impact independently.

Les approches conventionnelles d'utilisation de ViT pré-entraînés impliquent d'affiner l'ensemble du modèle sur des tâches spécifiques en aval. Ce processus combine transfert d’attention et apprentissage de fonctionnalités, ce qui rend difficile l’isolement de chaque contribution. Bien que des cadres de distillation des connaissances aient été utilisés pour transférer des logits ou des représentations de caractéristiques, ils ignorent largement le potentiel des schémas d'attention. Le manque d’analyse ciblée sur les mécanismes d’attention limite une compréhension globale de leur rôle dans l’amélioration des résultats des tâches en aval. Cette lacune met en évidence la nécessité de disposer de méthodes permettant d'évaluer l'impact des cartes d'attention de manière indépendante.

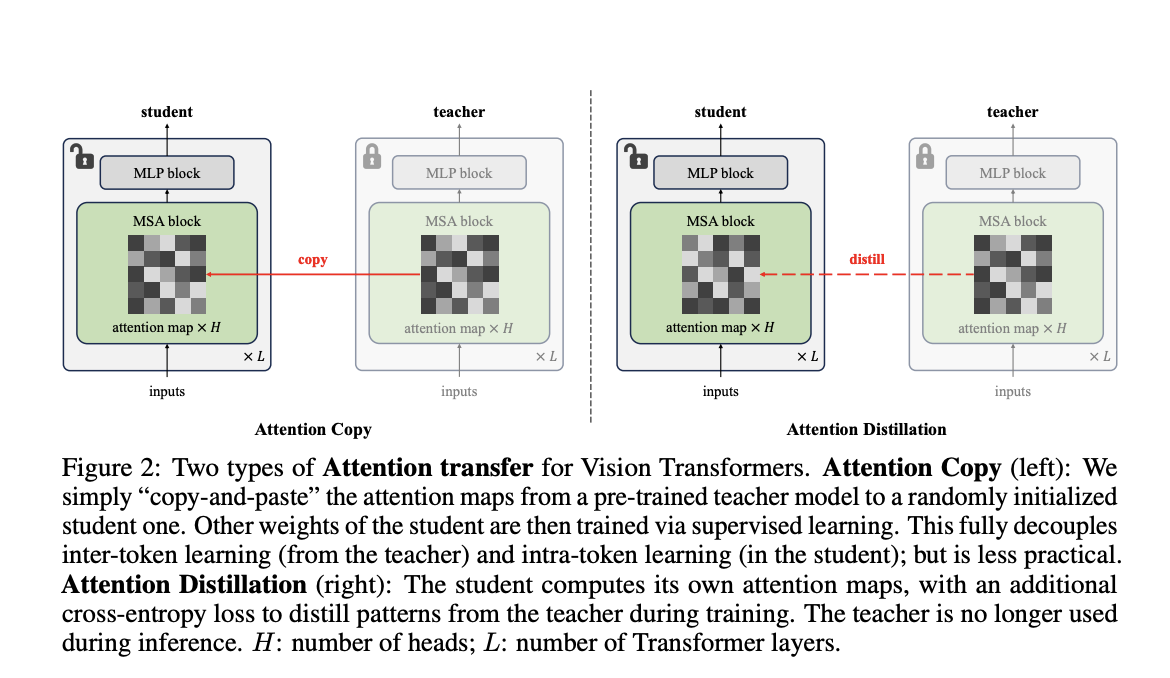

Researchers from Carnegie Mellon University and FAIR have introduced a novel method called “Attention Transfer,” designed to isolate and transfer only the attention patterns from pre-trained ViTs. The proposed framework consists of two methods: Attention Copy and Attention Distillation. In Attention Copy, the pre-trained teacher ViT generates attention maps directly applied to a student model while the student learns all other parameters from scratch. In contrast, Attention Distillation uses a distillation loss function to train the student model to align its attention maps with the teacher’s, requiring the teacher model only during training. These methods separate the intra-token computations from inter-token flow, offering a fresh perspective on pre-training dynamics in ViTs.

Des chercheurs de l’Université Carnegie Mellon et de FAIR ont introduit une nouvelle méthode appelée « Transfert d’attention », conçue pour isoler et transférer uniquement les modèles d’attention des ViT pré-entraînés. Le cadre proposé se compose de deux méthodes : Attention Copy et Attention Distillation. Dans Attention Copy, l'enseignant pré-formé ViT génère des cartes d'attention directement appliquées à un modèle d'élève tandis que l'élève apprend tous les autres paramètres à partir de zéro. En revanche, Attention Distillation utilise une fonction de perte de distillation pour entraîner le modèle de l'élève à aligner ses cartes d'attention avec celles de l'enseignant, nécessitant le modèle de l'enseignant uniquement pendant la formation. Ces méthodes séparent les calculs intra-jetons du flux inter-jetons, offrant une nouvelle perspective sur la dynamique de pré-formation dans les ViT.

Attention Copy transfers pre-trained attention maps to a student model, effectively guiding how tokens interact without retaining learned features. This setup requires both the teacher and student models during inference, which may add computational complexity. Attention Distillation, on the other hand, refines the student model’s attention maps through a loss function that compares them to the teacher’s patterns. After training, the teacher model is no longer needed, making this approach more practical. Both methods leverage the unique architecture of ViTs, where self-attention maps dictate inter-token relationships, allowing the student to focus on learning its features from scratch.

Attention Copy transfère les cartes d'attention pré-entraînées vers un modèle d'étudiant, guidant efficacement la manière dont les jetons interagissent sans conserver les fonctionnalités apprises. Cette configuration nécessite à la fois les modèles d'enseignant et d'étudiant lors de l'inférence, ce qui peut ajouter de la complexité informatique. La distillation de l'attention, quant à elle, affine les cartes d'attention du modèle de l'élève grâce à une fonction de perte qui les compare aux modèles de l'enseignant. Après la formation, le modèle de l’enseignant n’est plus nécessaire, ce qui rend cette approche plus pratique. Les deux méthodes exploitent l'architecture unique des ViT, où les cartes d'auto-attention dictent les relations entre les jetons, permettant à l'étudiant de se concentrer sur l'apprentissage de ses fonctionnalités à partir de zéro.

The performance of these methods demonstrates the effectiveness of attention patterns in pre-trained ViTs. Attention Distillation achieved a top-1 accuracy of 85.7% on the ImageNet-1K dataset, equaling the performance of fully fine-tuned models. While slightly less effective, Attention Copy closed 77.8% of the gap between training from scratch and fine-tuning, reaching 85.1% accuracy. Furthermore, ensembling the student and teacher models enhanced accuracy to 86.3%, showcasing the complementary nature of their predictions. The study also revealed that transferring attention maps from task-specific fine-tuned teachers further improved accuracy, demonstrating the adaptability of attention mechanisms to specific downstream requirements. However, challenges arose under data distribution shifts, where attention transfer underperformed compared to weight tuning, highlighting limitations in generalization.

La performance de ces méthodes démontre l’efficacité des modèles d’attention chez les ViT pré-entraînés. Attention Distillation a atteint une précision de premier ordre de 85,7 % sur l'ensemble de données ImageNet-1K, ce qui équivaut aux performances de modèles entièrement affinés. Bien que légèrement moins efficace, Attention Copy a comblé 77,8 % de l'écart entre l'entraînement à partir de zéro et le réglage fin, atteignant une précision de 85,1 %. De plus, l’assemblage des modèles d’élève et d’enseignant a amélioré la précision à 86,3 %, démontrant la nature complémentaire de leurs prédictions. L'étude a également révélé que le transfert de cartes d'attention à partir d'enseignants spécialisés dans des tâches spécifiques améliorait encore la précision, démontrant l'adaptabilité des mécanismes d'attention aux exigences spécifiques en aval. Cependant, des défis sont apparus lors des changements de distribution des données, où le transfert d'attention a été moins performant que le réglage du poids, mettant en évidence les limites de la généralisation.

This research illustrates that pre-trained attention patterns are sufficient for achieving high downstream task performance, questioning the necessity of traditional feature-centric pre-training paradigms. The proposed Attention Transfer method decouples attention mechanisms from feature learning, offering an alternative approach that reduces reliance on computationally intensive weight fine-tuning. While limitations such as distribution shift sensitivity and scalability across diverse tasks remain, this study opens new avenues for optimizing the use of ViTs in computer vision. Future work could address these challenges, refine attention transfer techniques, and explore their applicability to broader domains, paving the way for more efficient, effective machine learning models.

Cette recherche illustre que les modèles d'attention pré-entraînés sont suffisants pour atteindre des performances élevées dans les tâches en aval, remettant en question la nécessité des paradigmes de pré-entraînement traditionnels centrés sur les fonctionnalités. La méthode de transfert d'attention proposée dissocie les mécanismes d'attention de l'apprentissage des caractéristiques, offrant une approche alternative qui réduit le recours à un réglage précis du poids à forte intensité de calcul. Bien que des limites telles que la sensibilité au changement de distribution et l'évolutivité entre diverses tâches demeurent, cette étude ouvre de nouvelles voies pour optimiser l'utilisation des ViT en vision par ordinateur. Les travaux futurs pourraient relever ces défis, affiner les techniques de transfert d’attention et explorer leur applicabilité à des domaines plus larges, ouvrant ainsi la voie à des modèles d’apprentissage automatique plus efficients et plus efficaces.

Clause de non-responsabilité:info@kdj.com

Les informations fournies ne constituent pas des conseils commerciaux. kdj.com n’assume aucune responsabilité pour les investissements effectués sur la base des informations fournies dans cet article. Les crypto-monnaies sont très volatiles et il est fortement recommandé d’investir avec prudence après une recherche approfondie!

Si vous pensez que le contenu utilisé sur ce site Web porte atteinte à vos droits d’auteur, veuillez nous contacter immédiatement (info@kdj.com) et nous le supprimerons dans les plus brefs délais.

-

- Cardano (Ada) Price Eyes Un taureau massif au milieu de l'offre qui se profile

- Apr 26, 2025 at 12:05 pm

- Cardano Price est sur le point d'un rallye massif après plus de 20 millions de dollars de jetons ADA a récemment laissé les échanges. Les données de Coininglass indiquent qu'au cours des sept derniers jours,

-

-

-

-

-

- Le cercle nie fermement les rumeurs suggérant qu'elle prévoit de demander une licence bancaire américaine

- Apr 26, 2025 at 11:55 am

- «Nous exhortons le Congrès à adopter une législation sur le paiement bipartite des paiements bipartisan maintenant pour défendre l'innovation américaine, la stabilité et la sécurité des consommateurs.»

-

-

- Événement de lancement officiel de Meta Earth: la collecte de l'industrie Web3 incontournable

- Apr 26, 2025 at 11:50 am

- Du 30 avril au 1er mai 2025, Token2049 Dubaï accueillera les joueurs les plus influents de l'espace blockchain. Parmi eux, Meta Earth se distingue comme la licorne croissante du secteur modulaire de la blockchain, étant le seul projet de blockchain modulaire parmi les sponsors de titre et de Platinum.

-

![Le trading est de suivre [Revue vidéo] Les commandes de pétrole brut Bitcoin Gold font des bénéfices! Le trading est de suivre [Revue vidéo] Les commandes de pétrole brut Bitcoin Gold font des bénéfices!](/uploads/2025/04/26/cryptocurrencies-news/videos/trading-follow-review-video-gold-bitcoin-crude-oil-profits/image-1.webp)