|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

ViT(Vision Transformers)는 self-attention 메커니즘을 사용하여 이미지 데이터를 처리하는 혁신적인 아키텍처를 제공함으로써 컴퓨터 비전에 혁명을 일으켰습니다. 특징 추출을 위해 컨볼루셔널 레이어에 의존하는 CNN(컨볼루셔널 신경망)과 달리 ViT는 이미지를 더 작은 패치로 나누고 이를 개별 토큰으로 처리합니다. 이 토큰 기반 접근 방식을 사용하면 대규모 데이터 세트를 확장 가능하고 효율적으로 처리할 수 있으므로 ViT는 이미지 분류 및 개체 감지와 같은 고차원 작업에 특히 효과적입니다. 토큰 내에서 기능이 추출되는 방식과 토큰 간의 정보 흐름 방식을 분리하는 기능은 다양한 컴퓨터 비전 문제를 해결하기 위한 유연한 프레임워크를 제공합니다.

Vision Transformers (ViTs) have emerged as a powerful architecture in computer vision, thanks to their self-attention mechanisms that can effectively process image data. Unlike Convolutional Neural Networks (CNNs), which extract features using convolutional layers, ViTs break down images into smaller patches and treat them as individual tokens. This token-based approach enables scalable and efficient processing of large datasets, making ViTs particularly well-suited for high-dimensional tasks like image classification and object detection. The decoupling of how information flows between tokens from how features are extracted within tokens provides a flexible framework for tackling diverse computer vision challenges.

ViT(Vision Transformer)는 이미지 데이터를 효과적으로 처리할 수 있는 Self-Attention 메커니즘 덕분에 컴퓨터 비전의 강력한 아키텍처로 등장했습니다. 컨볼루셔널 레이어를 사용하여 특징을 추출하는 CNN(컨볼루셔널 신경망)과 달리 ViT는 이미지를 더 작은 패치로 나누고 이를 개별 토큰으로 처리합니다. 이 토큰 기반 접근 방식을 사용하면 대규모 데이터 세트를 확장 가능하고 효율적으로 처리할 수 있으므로 ViT는 이미지 분류 및 객체 감지와 같은 고차원 작업에 특히 적합합니다. 토큰 내에서 기능이 추출되는 방식과 토큰 간의 정보 흐름 방식을 분리하면 다양한 컴퓨터 비전 문제를 해결하기 위한 유연한 프레임워크가 제공됩니다.

Despite their success, a key question that arises is whether pre-training is necessary for ViTs. It has been widely assumed that pre-training enhances downstream task performance by learning useful feature representations. However, recent research has begun to question whether these features are the sole contributors to performance improvements or whether other factors, such as attention patterns, might play a more significant role. This investigation challenges the traditional belief in the dominance of feature learning, suggesting that a deeper understanding of the mechanisms driving ViTs’ effectiveness could lead to more efficient training methodologies and improved performance.

성공에도 불구하고 발생하는 주요 질문은 ViT에 사전 교육이 필요한지 여부입니다. 사전 훈련은 유용한 특징 표현을 학습함으로써 다운스트림 작업 성능을 향상시킨다고 널리 가정되어 왔습니다. 그러나 최근 연구에서는 이러한 기능이 성능 향상에 유일한 기여인지 아니면 주의 패턴과 같은 다른 요인이 더 중요한 역할을 할 수 있는지에 대해 의문을 제기하기 시작했습니다. 이 조사는 기능 학습의 지배력에 대한 전통적인 믿음에 도전하며, ViT의 효율성을 높이는 메커니즘에 대한 더 깊은 이해가 보다 효율적인 교육 방법론과 향상된 성능으로 이어질 수 있음을 시사합니다.

Conventional approaches to utilizing pre-trained ViTs involve fine-tuning the entire model on specific downstream tasks. This process combines attention transfer and feature learning, making it difficult to isolate each contribution. While knowledge distillation frameworks have been employed to transfer logits or feature representations, they largely ignore the potential of attention patterns. The lack of focused analysis on attention mechanisms limits a comprehensive understanding of their role in improving downstream task outcomes. This gap highlights the need for methods to assess attention maps’ impact independently.

사전 훈련된 ViT를 활용하는 기존 접근 방식에는 특정 다운스트림 작업에 대한 전체 모델을 미세 조정하는 작업이 포함됩니다. 이 프로세스는 주의 이전과 기능 학습을 결합하므로 각 기여를 분리하기가 어렵습니다. 지식 증류 프레임워크는 로지트 또는 특징 표현을 전송하는 데 사용되었지만 주의 패턴의 잠재력을 대부분 무시합니다. 주의 메커니즘에 대한 집중적인 분석이 부족하면 다운스트림 작업 결과를 개선하는 데 있어 메커니즘의 역할에 대한 포괄적인 이해가 제한됩니다. 이러한 격차는 주의 지도의 영향을 독립적으로 평가하는 방법의 필요성을 강조합니다.

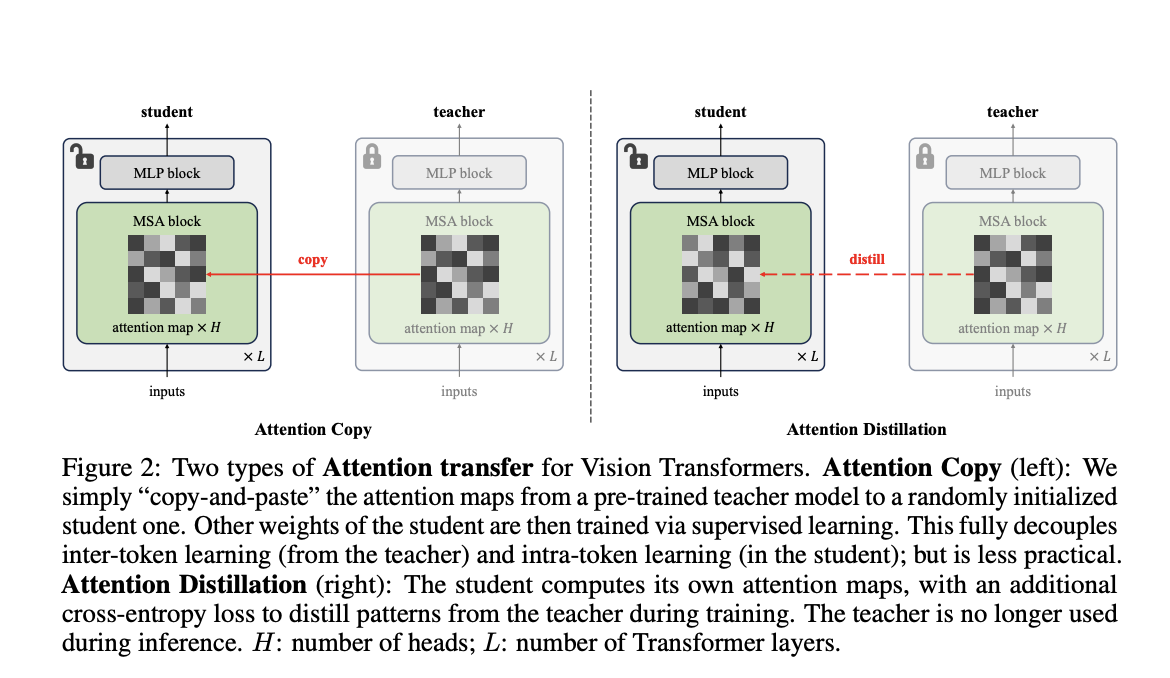

Researchers from Carnegie Mellon University and FAIR have introduced a novel method called “Attention Transfer,” designed to isolate and transfer only the attention patterns from pre-trained ViTs. The proposed framework consists of two methods: Attention Copy and Attention Distillation. In Attention Copy, the pre-trained teacher ViT generates attention maps directly applied to a student model while the student learns all other parameters from scratch. In contrast, Attention Distillation uses a distillation loss function to train the student model to align its attention maps with the teacher’s, requiring the teacher model only during training. These methods separate the intra-token computations from inter-token flow, offering a fresh perspective on pre-training dynamics in ViTs.

Carnegie Mellon University와 FAIR의 연구원들은 사전 훈련된 ViT의 주의 패턴만 분리하여 전달하도록 설계된 "Attention Transfer"라는 새로운 방법을 도입했습니다. 제안된 프레임워크는 Attention Copy와 Attention Distillation의 두 가지 방법으로 구성됩니다. Attention Copy에서는 사전 교육을 받은 교사 ViT가 학생 모델에 직접 적용되는 Attention Map을 생성하는 반면 학생은 다른 모든 매개변수를 처음부터 학습합니다. 이와 대조적으로 Attention Distillation은 증류 손실 기능을 사용하여 학생 모델을 교육하여 교사의 주의 지도와 일치하도록 교육하므로 교사 모델은 교육 중에만 필요합니다. 이러한 방법은 토큰 내 계산을 토큰 간 흐름에서 분리하여 ViT의 사전 훈련 역학에 대한 새로운 관점을 제공합니다.

Attention Copy transfers pre-trained attention maps to a student model, effectively guiding how tokens interact without retaining learned features. This setup requires both the teacher and student models during inference, which may add computational complexity. Attention Distillation, on the other hand, refines the student model’s attention maps through a loss function that compares them to the teacher’s patterns. After training, the teacher model is no longer needed, making this approach more practical. Both methods leverage the unique architecture of ViTs, where self-attention maps dictate inter-token relationships, allowing the student to focus on learning its features from scratch.

Attention Copy는 사전 훈련된 Attention Map을 학생 모델로 전송하여 학습된 기능을 유지하지 않고도 토큰이 상호 작용하는 방식을 효과적으로 안내합니다. 이 설정에는 추론 중에 교사와 학생 모델이 모두 필요하므로 계산 복잡성이 추가될 수 있습니다. 반면 Attention Distillation은 학생 모델의 Attention Map을 교사의 패턴과 비교하는 손실 함수를 통해 개선합니다. 훈련 후에는 교사 모델이 더 이상 필요하지 않으므로 이 접근 방식이 더욱 실용적입니다. 두 방법 모두 Self-Attention 맵이 토큰 간 관계를 지시하는 ViT의 고유한 아키텍처를 활용하므로 학생은 처음부터 해당 기능을 학습하는 데 집중할 수 있습니다.

The performance of these methods demonstrates the effectiveness of attention patterns in pre-trained ViTs. Attention Distillation achieved a top-1 accuracy of 85.7% on the ImageNet-1K dataset, equaling the performance of fully fine-tuned models. While slightly less effective, Attention Copy closed 77.8% of the gap between training from scratch and fine-tuning, reaching 85.1% accuracy. Furthermore, ensembling the student and teacher models enhanced accuracy to 86.3%, showcasing the complementary nature of their predictions. The study also revealed that transferring attention maps from task-specific fine-tuned teachers further improved accuracy, demonstrating the adaptability of attention mechanisms to specific downstream requirements. However, challenges arose under data distribution shifts, where attention transfer underperformed compared to weight tuning, highlighting limitations in generalization.

이러한 방법의 성능은 사전 훈련된 ViT의 주의 패턴의 효율성을 보여줍니다. Attention Distillation은 ImageNet-1K 데이터 세트에서 85.7%의 상위 1위 정확도를 달성했으며 이는 완전히 미세 조정된 모델의 성능과 동일합니다. 약간 덜 효과적이긴 하지만 Attention Copy는 처음부터 훈련과 미세 조정 사이의 격차를 77.8% 줄여 85.1%의 정확도에 도달했습니다. 또한 학생과 교사 모델을 앙상블하면 정확도가 86.3%로 향상되어 예측의 보완적 특성을 보여줍니다. 이 연구는 또한 작업별로 미세 조정된 교사로부터 주의 지도를 전송하면 정확도가 더욱 향상되어 특정 다운스트림 요구 사항에 대한 주의 메커니즘의 적응성이 입증되었음을 밝혔습니다. 그러나 데이터 분포 변화로 인해 가중치 조정에 비해 주의 전달 성능이 저하되어 일반화의 한계가 강조되는 문제가 발생했습니다.

This research illustrates that pre-trained attention patterns are sufficient for achieving high downstream task performance, questioning the necessity of traditional feature-centric pre-training paradigms. The proposed Attention Transfer method decouples attention mechanisms from feature learning, offering an alternative approach that reduces reliance on computationally intensive weight fine-tuning. While limitations such as distribution shift sensitivity and scalability across diverse tasks remain, this study opens new avenues for optimizing the use of ViTs in computer vision. Future work could address these challenges, refine attention transfer techniques, and explore their applicability to broader domains, paving the way for more efficient, effective machine learning models.

이 연구는 사전 훈련된 주의 패턴이 높은 다운스트림 작업 성능을 달성하는 데 충분하다는 것을 보여주며 전통적인 기능 중심 사전 훈련 패러다임의 필요성에 의문을 제기합니다. 제안된 Attention Transfer 방법은 주의 메커니즘을 특징 학습에서 분리하여 계산 집약적인 가중치 미세 조정에 대한 의존도를 줄이는 대체 접근 방식을 제공합니다. 다양한 작업에 걸쳐 분포 이동 민감도 및 확장성과 같은 제한 사항이 남아 있지만, 이 연구는 컴퓨터 비전에서 ViT 사용을 최적화하기 위한 새로운 길을 열어줍니다. 향후 작업에서는 이러한 문제를 해결하고 주의 전달 기술을 개선하며 더 넓은 영역에 대한 적용 가능성을 탐색하여 보다 효율적이고 효과적인 기계 학습 모델을 위한 길을 열 수 있습니다.

부인 성명:info@kdj.com

제공된 정보는 거래 조언이 아닙니다. kdj.com은 이 기사에 제공된 정보를 기반으로 이루어진 투자에 대해 어떠한 책임도 지지 않습니다. 암호화폐는 변동성이 매우 높으므로 철저한 조사 후 신중하게 투자하는 것이 좋습니다!

본 웹사이트에 사용된 내용이 귀하의 저작권을 침해한다고 판단되는 경우, 즉시 당사(info@kdj.com)로 연락주시면 즉시 삭제하도록 하겠습니다.

-

-

-

-

-

-

-

-

-

- 압력을받는 평양 : 미국 기소와 북한 배우를 보는 것

- 2025-07-04 08:30:12

- 북한에 대한 최신 미국의 기소를 해독하고 평양의 전략에 대해 공개 한 내용.