|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Nachrichtenartikel zu Kryptowährungen

Aufmerksamkeitsübertragung: Isolierung der Rolle von Aufmerksamkeitsmechanismen bei Vision Transformern

Nov 21, 2024 at 06:00 pm

Vision Transformers (ViTs) haben die Computer Vision revolutioniert, indem sie eine innovative Architektur anbieten, die Selbstaufmerksamkeitsmechanismen zur Verarbeitung von Bilddaten nutzt. Im Gegensatz zu Convolutional Neural Networks (CNNs), die zur Merkmalsextraktion auf Faltungsschichten angewiesen sind, unterteilen ViTs Bilder in kleinere Patches und behandeln sie als einzelne Token. Dieser tokenbasierte Ansatz ermöglicht eine skalierbare und effiziente Verarbeitung großer Datensätze, wodurch ViTs besonders effektiv für hochdimensionale Aufgaben wie Bildklassifizierung und Objekterkennung sind. Ihre Fähigkeit, den Informationsfluss zwischen Tokens von der Art und Weise zu entkoppeln, wie Funktionen innerhalb von Tokens extrahiert werden, bietet einen flexiblen Rahmen für die Bewältigung verschiedener Herausforderungen im Bereich Computer Vision.

Vision Transformers (ViTs) have emerged as a powerful architecture in computer vision, thanks to their self-attention mechanisms that can effectively process image data. Unlike Convolutional Neural Networks (CNNs), which extract features using convolutional layers, ViTs break down images into smaller patches and treat them as individual tokens. This token-based approach enables scalable and efficient processing of large datasets, making ViTs particularly well-suited for high-dimensional tasks like image classification and object detection. The decoupling of how information flows between tokens from how features are extracted within tokens provides a flexible framework for tackling diverse computer vision challenges.

Vision Transformers (ViTs) haben sich dank ihrer Selbstaufmerksamkeitsmechanismen, die Bilddaten effektiv verarbeiten können, zu einer leistungsstarken Architektur in der Computer Vision entwickelt. Im Gegensatz zu Convolutional Neural Networks (CNNs), die Merkmale mithilfe von Faltungsschichten extrahieren, zerlegen ViTs Bilder in kleinere Patches und behandeln sie als einzelne Token. Dieser tokenbasierte Ansatz ermöglicht eine skalierbare und effiziente Verarbeitung großer Datensätze, wodurch sich ViTs besonders gut für hochdimensionale Aufgaben wie Bildklassifizierung und Objekterkennung eignen. Die Entkopplung des Informationsflusses zwischen Tokens und der Extraktion von Merkmalen innerhalb von Tokens bietet einen flexiblen Rahmen für die Bewältigung verschiedener Herausforderungen im Bereich Computer Vision.

Despite their success, a key question that arises is whether pre-training is necessary for ViTs. It has been widely assumed that pre-training enhances downstream task performance by learning useful feature representations. However, recent research has begun to question whether these features are the sole contributors to performance improvements or whether other factors, such as attention patterns, might play a more significant role. This investigation challenges the traditional belief in the dominance of feature learning, suggesting that a deeper understanding of the mechanisms driving ViTs’ effectiveness could lead to more efficient training methodologies and improved performance.

Trotz ihres Erfolgs stellt sich die zentrale Frage, ob für ViTs eine Vorschulung notwendig ist. Es wird allgemein angenommen, dass das Vortraining die Leistung nachgelagerter Aufgaben durch das Erlernen nützlicher Funktionsdarstellungen verbessert. Neuere Forschungen stellen jedoch die Frage, ob diese Merkmale allein zu Leistungsverbesserungen beitragen oder ob andere Faktoren, wie beispielsweise Aufmerksamkeitsmuster, eine wichtigere Rolle spielen könnten. Diese Untersuchung stellt den traditionellen Glauben an die Dominanz des Feature-Learnings in Frage und legt nahe, dass ein tieferes Verständnis der Mechanismen, die die Wirksamkeit von ViTs steuern, zu effizienteren Trainingsmethoden und einer verbesserten Leistung führen könnte.

Conventional approaches to utilizing pre-trained ViTs involve fine-tuning the entire model on specific downstream tasks. This process combines attention transfer and feature learning, making it difficult to isolate each contribution. While knowledge distillation frameworks have been employed to transfer logits or feature representations, they largely ignore the potential of attention patterns. The lack of focused analysis on attention mechanisms limits a comprehensive understanding of their role in improving downstream task outcomes. This gap highlights the need for methods to assess attention maps’ impact independently.

Herkömmliche Ansätze zur Nutzung vorab trainierter ViTs beinhalten die Feinabstimmung des gesamten Modells auf bestimmte nachgelagerte Aufgaben. Dieser Prozess kombiniert Aufmerksamkeitsübertragung und Feature-Learning, was es schwierig macht, jeden Beitrag zu isolieren. Während Wissensdestillationsrahmen zur Übertragung von Logits oder Merkmalsdarstellungen eingesetzt werden, ignorieren sie weitgehend das Potenzial von Aufmerksamkeitsmustern. Der Mangel an gezielter Analyse der Aufmerksamkeitsmechanismen schränkt ein umfassendes Verständnis ihrer Rolle bei der Verbesserung der Ergebnisse nachgelagerter Aufgaben ein. Diese Lücke unterstreicht die Notwendigkeit von Methoden zur unabhängigen Bewertung der Wirkung von Aufmerksamkeitskarten.

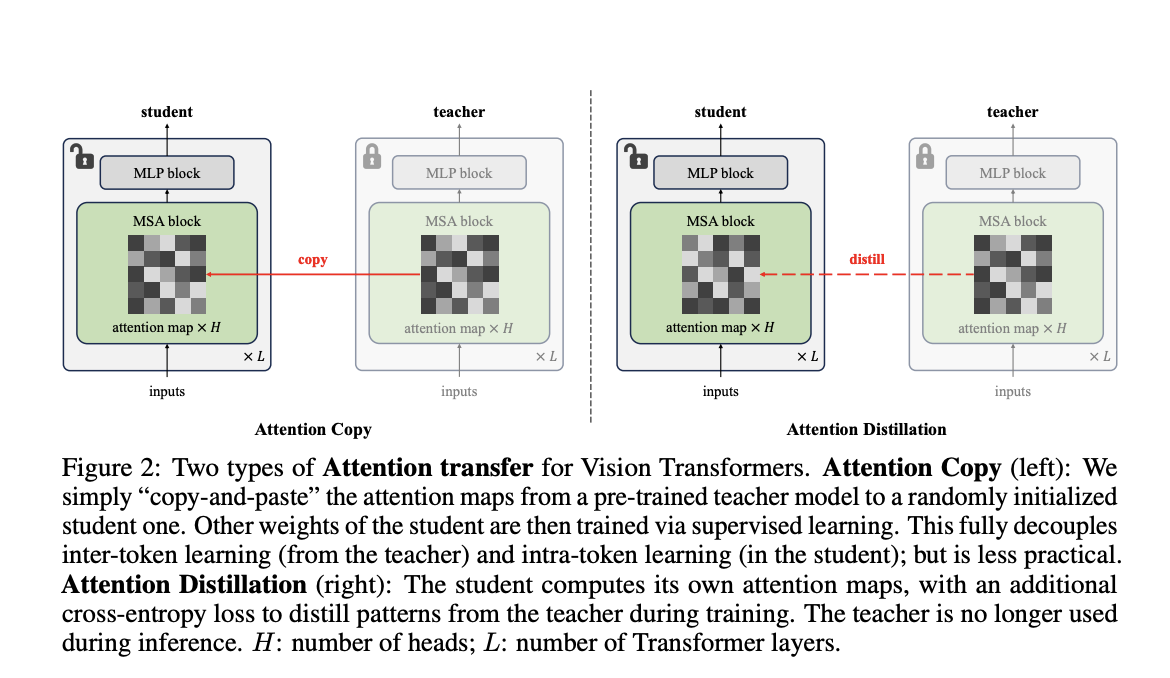

Researchers from Carnegie Mellon University and FAIR have introduced a novel method called “Attention Transfer,” designed to isolate and transfer only the attention patterns from pre-trained ViTs. The proposed framework consists of two methods: Attention Copy and Attention Distillation. In Attention Copy, the pre-trained teacher ViT generates attention maps directly applied to a student model while the student learns all other parameters from scratch. In contrast, Attention Distillation uses a distillation loss function to train the student model to align its attention maps with the teacher’s, requiring the teacher model only during training. These methods separate the intra-token computations from inter-token flow, offering a fresh perspective on pre-training dynamics in ViTs.

Forscher der Carnegie Mellon University und von FAIR haben eine neuartige Methode namens „Attention Transfer“ eingeführt, die darauf abzielt, nur die Aufmerksamkeitsmuster von vorab trainierten ViTs zu isolieren und zu übertragen. Das vorgeschlagene Framework besteht aus zwei Methoden: Attention Copy und Attention Distillation. In Attention Copy generiert der vorab geschulte Lehrer ViT Aufmerksamkeitskarten, die direkt auf ein Schülermodell angewendet werden, während der Schüler alle anderen Parameter von Grund auf lernt. Im Gegensatz dazu verwendet die Aufmerksamkeitsdestillation eine Destillationsverlustfunktion, um das Schülermodell so zu trainieren, dass es seine Aufmerksamkeitskarten an die des Lehrers anpasst, wobei das Lehrermodell nur während des Trainings erforderlich ist. Diese Methoden trennen die Intra-Token-Berechnungen vom Inter-Token-Fluss und bieten eine neue Perspektive auf die Dynamik vor dem Training in ViTs.

Attention Copy transfers pre-trained attention maps to a student model, effectively guiding how tokens interact without retaining learned features. This setup requires both the teacher and student models during inference, which may add computational complexity. Attention Distillation, on the other hand, refines the student model’s attention maps through a loss function that compares them to the teacher’s patterns. After training, the teacher model is no longer needed, making this approach more practical. Both methods leverage the unique architecture of ViTs, where self-attention maps dictate inter-token relationships, allowing the student to focus on learning its features from scratch.

Attention Copy überträgt vorab trainierte Aufmerksamkeitskarten auf ein Schülermodell und steuert so effektiv, wie Token interagieren, ohne erlernte Funktionen beizubehalten. Dieser Aufbau erfordert während der Inferenz sowohl das Lehrer- als auch das Schülermodell, was die Berechnungskomplexität erhöhen kann. Die Aufmerksamkeitsdestillation hingegen verfeinert die Aufmerksamkeitskarten des Schülermodells durch eine Verlustfunktion, die sie mit den Mustern des Lehrers vergleicht. Nach der Ausbildung wird das Lehrermodell nicht mehr benötigt, wodurch dieser Ansatz praktischer wird. Beide Methoden nutzen die einzigartige Architektur von ViTs, bei der Selbstaufmerksamkeitskarten die Beziehungen zwischen Token vorgeben und es dem Schüler ermöglichen, sich auf das Erlernen der Funktionen von Grund auf zu konzentrieren.

The performance of these methods demonstrates the effectiveness of attention patterns in pre-trained ViTs. Attention Distillation achieved a top-1 accuracy of 85.7% on the ImageNet-1K dataset, equaling the performance of fully fine-tuned models. While slightly less effective, Attention Copy closed 77.8% of the gap between training from scratch and fine-tuning, reaching 85.1% accuracy. Furthermore, ensembling the student and teacher models enhanced accuracy to 86.3%, showcasing the complementary nature of their predictions. The study also revealed that transferring attention maps from task-specific fine-tuned teachers further improved accuracy, demonstrating the adaptability of attention mechanisms to specific downstream requirements. However, challenges arose under data distribution shifts, where attention transfer underperformed compared to weight tuning, highlighting limitations in generalization.

Die Leistung dieser Methoden zeigt die Wirksamkeit von Aufmerksamkeitsmustern in vorab trainierten ViTs. Attention Distillation erreichte beim ImageNet-1K-Datensatz eine Top-1-Genauigkeit von 85,7 %, was der Leistung vollständig abgestimmter Modelle entspricht. Obwohl etwas weniger effektiv, schloss Attention Copy die Lücke zwischen dem Training von Grund auf und der Feinabstimmung zu 77,8 % und erreichte eine Genauigkeit von 85,1 %. Darüber hinaus steigerte die Kombination der Schüler- und Lehrermodelle die Genauigkeit auf 86,3 %, was den komplementären Charakter ihrer Vorhersagen verdeutlicht. Die Studie ergab auch, dass die Übertragung von Aufmerksamkeitskarten von aufgabenspezifisch fein abgestimmten Lehrern die Genauigkeit weiter verbesserte und die Anpassungsfähigkeit von Aufmerksamkeitsmechanismen an spezifische nachgelagerte Anforderungen demonstrierte. Allerdings ergaben sich bei Datenverteilungsverschiebungen Herausforderungen, bei denen die Aufmerksamkeitsübertragung im Vergleich zur Gewichtsanpassung schlechter ausfiel, was die Einschränkungen bei der Generalisierung verdeutlichte.

This research illustrates that pre-trained attention patterns are sufficient for achieving high downstream task performance, questioning the necessity of traditional feature-centric pre-training paradigms. The proposed Attention Transfer method decouples attention mechanisms from feature learning, offering an alternative approach that reduces reliance on computationally intensive weight fine-tuning. While limitations such as distribution shift sensitivity and scalability across diverse tasks remain, this study opens new avenues for optimizing the use of ViTs in computer vision. Future work could address these challenges, refine attention transfer techniques, and explore their applicability to broader domains, paving the way for more efficient, effective machine learning models.

Diese Forschung zeigt, dass vorab trainierte Aufmerksamkeitsmuster ausreichen, um eine hohe Leistung bei nachgelagerten Aufgaben zu erreichen, und stellt die Notwendigkeit traditioneller merkmalszentrierter Vortrainingsparadigmen in Frage. Die vorgeschlagene Aufmerksamkeitsübertragungsmethode entkoppelt Aufmerksamkeitsmechanismen vom Merkmalslernen und bietet einen alternativen Ansatz, der die Abhängigkeit von rechenintensiver Feinabstimmung der Gewichtung verringert. Während Einschränkungen wie Verteilungsverschiebungsempfindlichkeit und Skalierbarkeit über verschiedene Aufgaben hinweg bestehen bleiben, eröffnet diese Studie neue Wege zur Optimierung des Einsatzes von ViTs in der Computer Vision. Zukünftige Arbeiten könnten sich mit diesen Herausforderungen befassen, Aufmerksamkeitsübertragungstechniken verfeinern und ihre Anwendbarkeit auf breitere Bereiche untersuchen und so den Weg für effizientere und effektivere Modelle für maschinelles Lernen ebnen.

Haftungsausschluss:info@kdj.com

Die bereitgestellten Informationen stellen keine Handelsberatung dar. kdj.com übernimmt keine Verantwortung für Investitionen, die auf der Grundlage der in diesem Artikel bereitgestellten Informationen getätigt werden. Kryptowährungen sind sehr volatil und es wird dringend empfohlen, nach gründlicher Recherche mit Vorsicht zu investieren!

Wenn Sie glauben, dass der auf dieser Website verwendete Inhalt Ihr Urheberrecht verletzt, kontaktieren Sie uns bitte umgehend (info@kdj.com) und wir werden ihn umgehend löschen.

-

-

- Waymos AV-Tests am Flughafen Newark: Lohnt sich das KI-Wagnis von Alphabet?

- Oct 23, 2025 at 08:36 am

- Waymos selbstfahrende Autotests am Flughafen Newark signalisieren die KI-Dominanz von Alphabet und wirken sich sowohl auf die Aktien- als auch auf die Kryptomärkte aus. Ist das die Zukunft des Transports und der Investitionen?

-

-

- Solana, Crypto Advisory und Forward Industries: Eine New Yorker Minute zur Zukunft des Finanzwesens

- Oct 23, 2025 at 08:00 am

- Forward Industries greift mit einem neuen Krypto-Beratungsgremium tief in Solana ein und signalisiert damit einen großen Wandel in den Treasury-Strategien der Unternehmen. Ist das die Zukunft des Finanzwesens?

-

- MAGACOIN: Ethereum Whales tauchen in den heißesten Vorverkauf des Jahres 2025 ein

- Oct 23, 2025 at 07:59 am

- MAGACOIN FINANCE sorgt mit seinem explodierenden Vorverkauf für Aufsehen und lockt Ethereum-Wale an, die in einem volatilen Markt einen sicheren Hafen suchen. Ist das das Krypto-Juwel, auf das Sie gewartet haben?

-

-

- King Charles 5-Pence-Münzen kommen in Umlauf: Ein Royal Flush für Münzsammler!

- Oct 23, 2025 at 07:07 am

- King Charles 5-Pence-Münzen sind jetzt im Vereinigten Königreich im Umlauf! Entdecken Sie die Begeisterung, das Eichenblatt-Design und warum Sammler von dieser königlichen Veröffentlichung so begeistert sind.

-

- 5-Pence-Münzen von King Charles kommen in Umlauf: Ein Leitfaden für Sammler

- Oct 23, 2025 at 07:07 am

- Die 5-Pence-Münzen von König Karl III. sind jetzt im Umlauf! Entdecken Sie das neue Design, seine Bedeutung und warum Sammler begeistert sind. Machen Sie sich bereit für die Jagd nach diesen historischen Münzen!

-