|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

Démystifier les modèles de langage complexes avec LLM-TT : améliorer la transparence et la confiance dans l'intelligence artificielle

Apr 18, 2024 at 04:00 pm

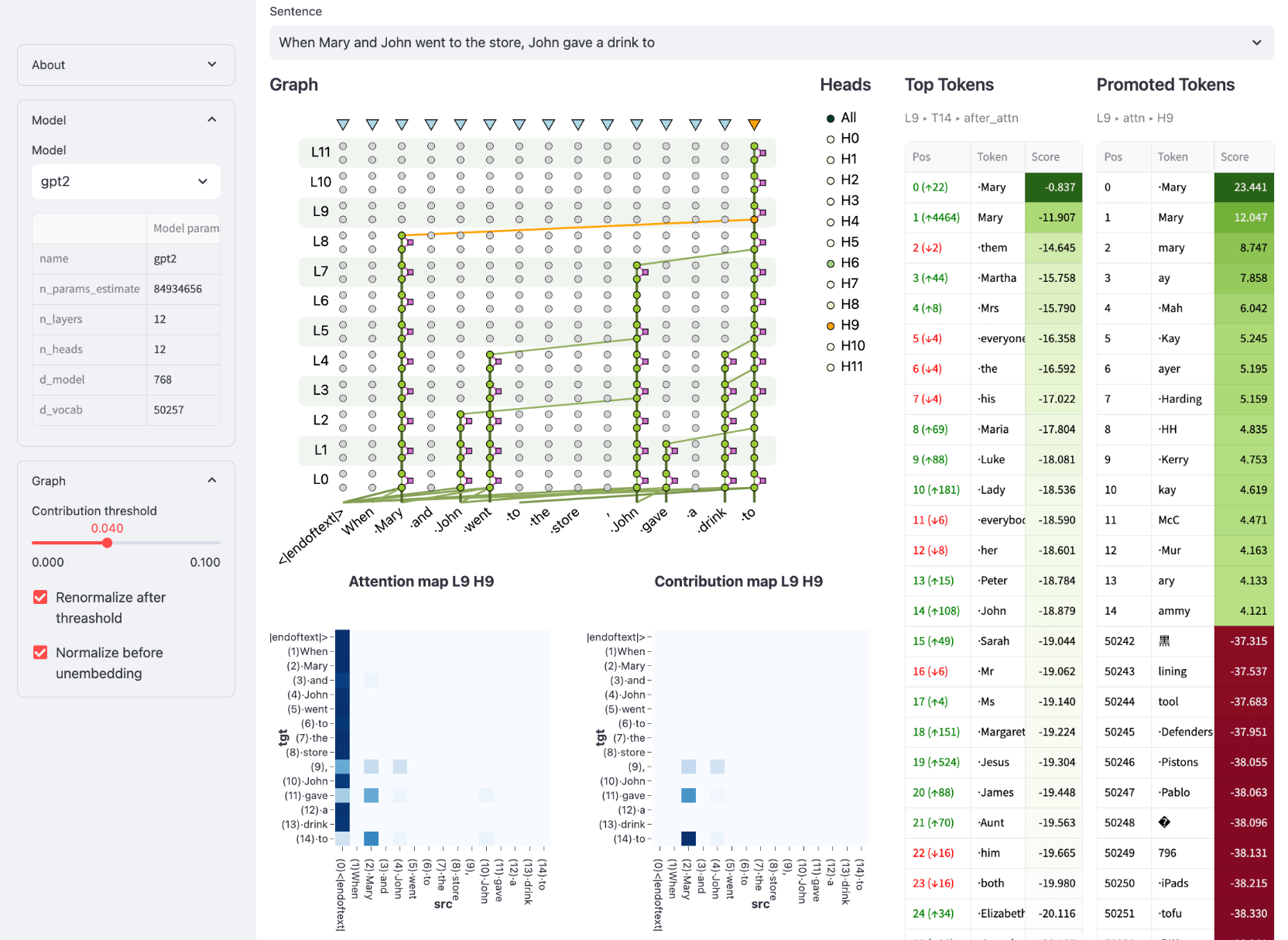

Le Large Language Model Transparency Tool (LLM-TT), développé par Meta Research, offre une visibilité sans précédent sur les processus de prise de décision des modèles de langage basés sur Transformer. Cette boîte à outils open source permet d'inspecter le flux d'informations, permettant aux utilisateurs d'explorer les contributions de la tête d'attention et les influences des neurones. L'outil permet le développement de déploiements d'IA plus éthiques et plus fiables en facilitant la vérification du comportement des modèles, la détection des biais et l'alignement sur les normes.

Demystifying Complex Language Models with the Pioneering LLM-TT Tool: Enhancing Transparency and Accountability in AI

Démystifier les modèles de langage complexes avec l'outil pionnier LLM-TT : améliorer la transparence et la responsabilité dans l'IA

In the burgeoning realm of artificial intelligence (AI), large language models (LLMs) have emerged as powerful tools, capable of tasks ranging from natural language processing to content generation. However, their intricate inner workings have remained largely opaque, hindering efforts to ensure their fairness, accountability, and alignment with ethical standards.

Dans le domaine en plein essor de l’intelligence artificielle (IA), les grands modèles de langage (LLM) sont apparus comme des outils puissants, capables d’effectuer des tâches allant du traitement du langage naturel à la génération de contenu. Cependant, leurs rouages internes complexes sont restés largement opaques, entravant les efforts visant à garantir leur équité, leur responsabilité et leur alignement sur les normes éthiques.

Enter the Large Language Model Transparency Tool (LLM-TT), a groundbreaking open-source toolkit developed by Meta Research. This innovative tool brings unprecedented transparency to LLMs, empowering users to dissect their decision-making processes and uncover hidden biases. By providing a comprehensive view into the flow of information within an LLM, LLM-TT empowers researchers, developers, and policymakers alike to foster more ethical and responsible AI practices.

Entrez dans le Large Language Model Transparency Tool (LLM-TT), une boîte à outils open source révolutionnaire développée par Meta Research. Cet outil innovant apporte une transparence sans précédent aux LLM, permettant aux utilisateurs d'analyser leurs processus décisionnels et de découvrir les préjugés cachés. En fournissant une vue complète du flux d'informations au sein d'un LLM, LLM-TT permet aux chercheurs, aux développeurs et aux décideurs politiques de favoriser des pratiques d'IA plus éthiques et responsables.

Bridging the Gap of Understanding and Oversight

Combler le fossé entre compréhension et surveillance

The development of LLM-TT stems from the growing recognition that the complexity of LLMs poses significant challenges for understanding and monitoring their behavior. As these models are increasingly deployed in high-stakes applications, such as decision-making processes and content moderation, the need for methods to ensure their fairness, accuracy, and adherence to ethical principles becomes paramount.

Le développement du LLM-TT découle de la reconnaissance croissante du fait que la complexité des LLM pose des défis importants pour la compréhension et le suivi de leur comportement. Alors que ces modèles sont de plus en plus déployés dans des applications à enjeux élevés, telles que les processus de prise de décision et la modération de contenu, le besoin de méthodes garantissant leur équité, leur exactitude et leur respect des principes éthiques devient primordial.

LLM-TT addresses this need by providing a visual representation of the information flow within a model, allowing users to trace the impact of individual components on model outputs. This capability is particularly crucial for identifying and mitigating potential biases that may arise from the training data or model architecture. With LLM-TT, researchers can systematically examine the model's reasoning process, uncover hidden assumptions, and ensure its alignment with desired objectives.

LLM-TT répond à ce besoin en fournissant une représentation visuelle du flux d'informations au sein d'un modèle, permettant aux utilisateurs de retracer l'impact des composants individuels sur les sorties du modèle. Cette capacité est particulièrement cruciale pour identifier et atténuer les biais potentiels pouvant découler des données de formation ou de l’architecture du modèle. Avec LLM-TT, les chercheurs peuvent examiner systématiquement le processus de raisonnement du modèle, découvrir des hypothèses cachées et garantir son alignement sur les objectifs souhaités.

Interactive Inspection of Model Components

Inspection interactive des composants du modèle

LLM-TT offers an interactive user experience, enabling detailed inspection of the model's architecture and its processing of information. By selecting a model and input, users can generate a contribution graph that visualizes the flow of information from input to output. The tool provides interactive controls to adjust the contribution threshold, allowing users to focus on the most influential components of the model's computation.

LLM-TT offre une expérience utilisateur interactive, permettant une inspection détaillée de l'architecture du modèle et de son traitement des informations. En sélectionnant un modèle et une entrée, les utilisateurs peuvent générer un graphique de contribution qui visualise le flux d'informations de l'entrée à la sortie. L'outil fournit des contrôles interactifs pour ajuster le seuil de contribution, permettant aux utilisateurs de se concentrer sur les composants les plus influents du calcul du modèle.

Moreover, LLM-TT allows users to select any token within the model's output and explore its representation after each layer in the model. This feature provides insights into how the model processes individual words or phrases, enabling users to understand the relationship between input and output and identify potential sources of bias or error.

De plus, LLM-TT permet aux utilisateurs de sélectionner n'importe quel jeton dans la sortie du modèle et d'explorer sa représentation après chaque couche du modèle. Cette fonctionnalité fournit des informations sur la manière dont le modèle traite des mots ou des expressions individuelles, permettant aux utilisateurs de comprendre la relation entre l'entrée et la sortie et d'identifier les sources potentielles de biais ou d'erreur.

Dissecting Attention Mechanisms and Feedforward Networks

Disséquer les mécanismes d'attention et les réseaux de rétroaction

LLM-TT goes beyond static visualizations by incorporating interactive elements that allow users to delve deeper into the model's inner workings. By clicking on edges within the contribution graph, users can reveal details about the contributing attention head, providing insights into the specific relationships between input and output tokens.

LLM-TT va au-delà des visualisations statiques en incorporant des éléments interactifs qui permettent aux utilisateurs d'approfondir le fonctionnement interne du modèle. En cliquant sur les bords du graphique de contribution, les utilisateurs peuvent révéler des détails sur la tête d'attention qui contribue, fournissant ainsi un aperçu des relations spécifiques entre les jetons d'entrée et de sortie.

Furthermore, LLM-TT provides the ability to inspect feedforward network (FFN) blocks and their constituent neurons. This fine-grained analysis enables users to pinpoint the exact locations within the model where important computations occur, shedding light on the intricate mechanisms that underpin the model's predictions.

De plus, LLM-TT offre la possibilité d’inspecter les blocs de réseau à action directe (FFN) et leurs neurones constitutifs. Cette analyse fine permet aux utilisateurs d'identifier les emplacements exacts au sein du modèle où des calculs importants ont lieu, mettant ainsi en lumière les mécanismes complexes qui sous-tendent les prédictions du modèle.

Enhancing Trust and Reliability in AI Deployments

Améliorer la confiance et la fiabilité dans les déploiements d'IA

The LLM-TT tool is an invaluable asset for building trust and reliability in AI deployments. By providing a deeper understanding of how LLMs make decisions, the tool empowers users to identify and mitigate potential risks, such as biases or errors. This transparency fosters accountability and allows organizations to make informed decisions about the use of LLMs in critical applications.

L'outil LLM-TT est un atout inestimable pour renforcer la confiance et la fiabilité dans les déploiements d'IA. En fournissant une compréhension plus approfondie de la manière dont les LLM prennent des décisions, l'outil permet aux utilisateurs d'identifier et d'atténuer les risques potentiels, tels que les biais ou les erreurs. Cette transparence favorise la responsabilité et permet aux organisations de prendre des décisions éclairées sur l'utilisation des LLM dans les applications critiques.

Conclusion: Empowering Ethical and Responsible AI

Conclusion : favoriser une IA éthique et responsable

The Large Language Model Transparency Tool (LLM-TT) is a groundbreaking innovation that empowers researchers, developers, and policymakers to enhance the transparency, accountability, and ethical use of large language models. By providing an interactive and comprehensive view into the inner workings of LLMs, LLM-TT supports the development and deployment of more fair, reliable, and responsible AI technologies.

Le Large Language Model Transparency Tool (LLM-TT) est une innovation révolutionnaire qui permet aux chercheurs, aux développeurs et aux décideurs politiques d'améliorer la transparence, la responsabilité et l'utilisation éthique des grands modèles linguistiques. En fournissant une vue interactive et complète du fonctionnement interne des LLM, LLM-TT soutient le développement et le déploiement de technologies d'IA plus équitables, fiables et responsables.

As the field of AI continues to advance, the need for robust tools to monitor and understand complex models will only grow stronger. LLM-TT stands as a testament to the importance of transparency and accountability in AI, paving the way for a future where AI systems are used ethically and responsibly to benefit society.

À mesure que le domaine de l’IA continue de progresser, le besoin d’outils robustes pour surveiller et comprendre des modèles complexes ne fera que croître. LLM-TT témoigne de l’importance de la transparence et de la responsabilité dans l’IA, ouvrant la voie à un avenir où les systèmes d’IA seront utilisés de manière éthique et responsable au profit de la société.

Clause de non-responsabilité:info@kdj.com

Les informations fournies ne constituent pas des conseils commerciaux. kdj.com n’assume aucune responsabilité pour les investissements effectués sur la base des informations fournies dans cet article. Les crypto-monnaies sont très volatiles et il est fortement recommandé d’investir avec prudence après une recherche approfondie!

Si vous pensez que le contenu utilisé sur ce site Web porte atteinte à vos droits d’auteur, veuillez nous contacter immédiatement (info@kdj.com) et nous le supprimerons dans les plus brefs délais.

-

- Bitcoin (BTC) ETF ARKB et FBTC Register net d'entrée de 220,7 millions de dollars malgré les nouveaux tarifs de Trump

- Apr 03, 2025 at 05:25 pm

- Mercredi 2 avril, Trump a annoncé un tarif de référence de 10% sur les importations et les tarifs réciproques sur la plupart des partenaires commerciaux des États-Unis.

-

- Solana (Sol) a du mal à maintenir des niveaux de soutien cruciaux alors que Mutuum Finance (MUTM) capture l'intérêt des investisseurs

- Apr 03, 2025 at 05:25 pm

- Le marché des crypto-monnaies assiste à une période turbulente alors que Solana (Sol) a du mal à maintenir des niveaux de soutien cruciaux tandis qu'un nouvel acteur, Mutuum Finance (MUTM), capture l'intérêt des investisseurs avec ses chiffres de prévente prometteurs.

-

- Les prix du Bitcoin (BTC), Ethereum (ETH) et XRP diminuent à mesure que les ventes de baleines, les sorties ETF et les craintes de récession pèsent sur le marché de la cryptographie.

- Apr 03, 2025 at 05:20 pm

- Le prix du Bitcoin (BTC) a mené le marché altcoin plus large, dirigé par Ethereum (ETH) et XRP, dans une perspective baissière au cours des dernières 24 heures. La pièce phare a baissé plus de 1%

-

-

-

- Standard Chartered Bank prédit Avax Token surperformra Bitcoin et Ethereum d'ici 2029

- Apr 03, 2025 at 05:15 pm

- Geoff Kendrick, qui dirige la division de recherche sur les actifs numériques, a déclaré que le jeton pourrait atteindre 55 $ d'ici 2025, 100 $ pour 2026, 150 $ pour 2027, 200 $ pour 2028 et 250 $ à la fin de 2029.

-

-

-

- Bitcoin (BTC) fait face à des conditions similaires à celles du marché des ours 2022, car les activités américaines voit «un risque très élevé» à venir.

- Apr 03, 2025 at 05:05 pm

- Dans sa dernière analyse, Charles Edwards, le fondateur du Bitcoin quantitatif et du Fonds d'actifs numériques Capriole Investments, a interrogé lorsque les États-Unis commenceraient à imprimer de l'argent.