|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Meta Research에서 개발한 LLM-TT(Large Language Model Transparency Tool)는 Transformer 기반 언어 모델의 의사 결정 프로세스에 대한 전례 없는 가시성을 제공합니다. 이 오픈 소스 툴킷을 사용하면 정보 흐름을 검사하여 사용자가 주의 머리 기여도와 뉴런 영향을 탐색할 수 있습니다. 이 도구는 모델 동작 검증, 편향 감지 및 표준 일치를 촉진하여 보다 윤리적이고 신뢰할 수 있는 AI 배포 개발을 지원합니다.

Demystifying Complex Language Models with the Pioneering LLM-TT Tool: Enhancing Transparency and Accountability in AI

선구적인 LLM-TT 도구를 사용하여 복잡한 언어 모델 이해하기: AI의 투명성과 책임성 강화

In the burgeoning realm of artificial intelligence (AI), large language models (LLMs) have emerged as powerful tools, capable of tasks ranging from natural language processing to content generation. However, their intricate inner workings have remained largely opaque, hindering efforts to ensure their fairness, accountability, and alignment with ethical standards.

급성장하는 인공지능(AI) 영역에서 대규모 언어 모델(LLM)은 자연어 처리부터 콘텐츠 생성까지 다양한 작업을 수행할 수 있는 강력한 도구로 등장했습니다. 그러나 그들의 복잡한 내부 작업은 대체로 불투명하여 공정성, 책임성 및 윤리 기준 준수를 보장하려는 노력을 방해하고 있습니다.

Enter the Large Language Model Transparency Tool (LLM-TT), a groundbreaking open-source toolkit developed by Meta Research. This innovative tool brings unprecedented transparency to LLMs, empowering users to dissect their decision-making processes and uncover hidden biases. By providing a comprehensive view into the flow of information within an LLM, LLM-TT empowers researchers, developers, and policymakers alike to foster more ethical and responsible AI practices.

Meta Research에서 개발한 획기적인 오픈 소스 툴킷인 LLM-TT(대형 언어 모델 투명성 도구)를 사용해 보세요. 이 혁신적인 도구는 LLM에 전례 없는 투명성을 제공하여 사용자가 의사 결정 프로세스를 분석하고 숨겨진 편견을 찾아낼 수 있도록 지원합니다. LLM 내의 정보 흐름에 대한 포괄적인 보기를 제공함으로써 LLM-TT는 연구원, 개발자 및 정책 입안자 모두가 보다 윤리적이고 책임감 있는 AI 관행을 육성할 수 있도록 지원합니다.

Bridging the Gap of Understanding and Oversight

이해와 감독의 격차 해소

The development of LLM-TT stems from the growing recognition that the complexity of LLMs poses significant challenges for understanding and monitoring their behavior. As these models are increasingly deployed in high-stakes applications, such as decision-making processes and content moderation, the need for methods to ensure their fairness, accuracy, and adherence to ethical principles becomes paramount.

LLM-TT의 개발은 LLM의 복잡성으로 인해 LLM의 행동을 이해하고 모니터링하는 데 상당한 어려움이 있다는 인식이 높아지는 데서 비롯됩니다. 이러한 모델이 의사 결정 프로세스 및 콘텐츠 조정과 같은 고위험 애플리케이션에 점점 더 많이 배포됨에 따라 공정성, 정확성 및 윤리 원칙 준수를 보장하는 방법의 필요성이 중요해졌습니다.

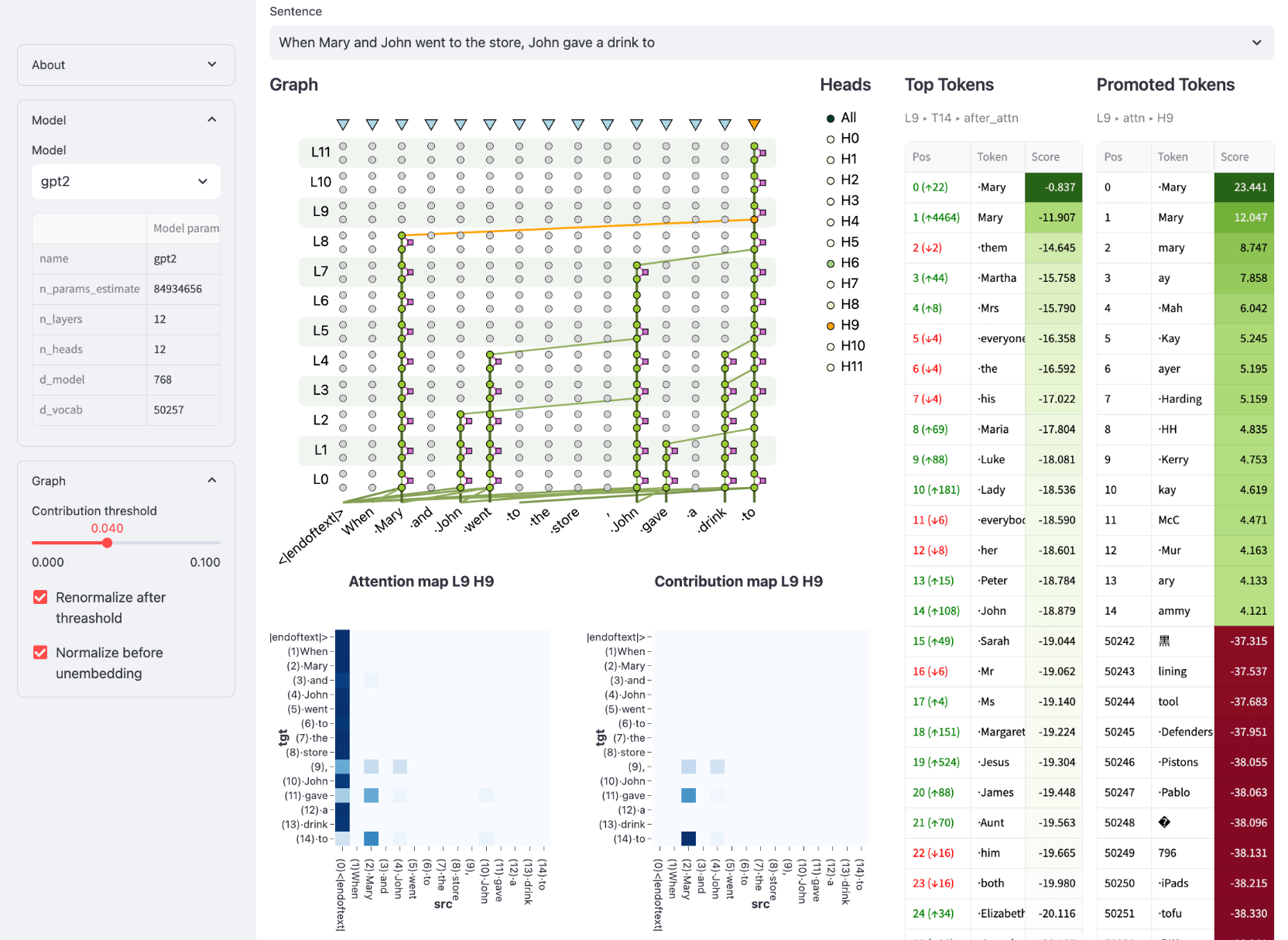

LLM-TT addresses this need by providing a visual representation of the information flow within a model, allowing users to trace the impact of individual components on model outputs. This capability is particularly crucial for identifying and mitigating potential biases that may arise from the training data or model architecture. With LLM-TT, researchers can systematically examine the model's reasoning process, uncover hidden assumptions, and ensure its alignment with desired objectives.

LLM-TT는 모델 내의 정보 흐름을 시각적으로 표현하여 사용자가 모델 출력에 대한 개별 구성 요소의 영향을 추적할 수 있도록 함으로써 이러한 요구 사항을 해결합니다. 이 기능은 훈련 데이터나 모델 아키텍처에서 발생할 수 있는 잠재적 편향을 식별하고 완화하는 데 특히 중요합니다. LLM-TT를 사용하면 연구자는 모델의 추론 프로세스를 체계적으로 검사하고, 숨겨진 가정을 찾아내고, 원하는 목표와 일치하는지 확인할 수 있습니다.

Interactive Inspection of Model Components

모델 구성요소의 대화형 검사

LLM-TT offers an interactive user experience, enabling detailed inspection of the model's architecture and its processing of information. By selecting a model and input, users can generate a contribution graph that visualizes the flow of information from input to output. The tool provides interactive controls to adjust the contribution threshold, allowing users to focus on the most influential components of the model's computation.

LLM-TT는 모델 아키텍처와 정보 처리를 자세히 검사할 수 있는 대화형 사용자 경험을 제공합니다. 모델과 입력을 선택하면 사용자는 입력에서 출력까지의 정보 흐름을 시각화하는 기여도 그래프를 생성할 수 있습니다. 이 도구는 기여도 임계값을 조정하는 대화형 제어 기능을 제공하므로 사용자는 모델 계산에서 가장 영향력 있는 구성 요소에 집중할 수 있습니다.

Moreover, LLM-TT allows users to select any token within the model's output and explore its representation after each layer in the model. This feature provides insights into how the model processes individual words or phrases, enabling users to understand the relationship between input and output and identify potential sources of bias or error.

또한 LLM-TT를 사용하면 사용자는 모델 출력 내에서 토큰을 선택하고 모델의 각 레이어 이후에 해당 토큰의 표현을 탐색할 수 있습니다. 이 기능은 모델이 개별 단어나 구문을 처리하는 방법에 대한 통찰력을 제공하여 사용자가 입력과 출력 간의 관계를 이해하고 편향 또는 오류의 잠재적 소스를 식별할 수 있도록 합니다.

Dissecting Attention Mechanisms and Feedforward Networks

주의 메커니즘 및 피드포워드 네트워크 분석

LLM-TT goes beyond static visualizations by incorporating interactive elements that allow users to delve deeper into the model's inner workings. By clicking on edges within the contribution graph, users can reveal details about the contributing attention head, providing insights into the specific relationships between input and output tokens.

LLM-TT는 사용자가 모델의 내부 작동을 더 깊이 파고들 수 있도록 하는 대화형 요소를 통합하여 정적 시각화를 뛰어넘습니다. 기여도 그래프 내의 가장자리를 클릭하면 사용자는 기여하는 관심 헤드에 대한 세부 정보를 공개하여 입력 토큰과 출력 토큰 간의 특정 관계에 대한 통찰력을 제공할 수 있습니다.

Furthermore, LLM-TT provides the ability to inspect feedforward network (FFN) blocks and their constituent neurons. This fine-grained analysis enables users to pinpoint the exact locations within the model where important computations occur, shedding light on the intricate mechanisms that underpin the model's predictions.

또한 LLM-TT는 FFN(피드포워드 네트워크) 블록과 해당 구성 뉴런을 검사하는 기능을 제공합니다. 이 세밀한 분석을 통해 사용자는 모델 내에서 중요한 계산이 이루어지는 정확한 위치를 찾아내고 모델 예측을 뒷받침하는 복잡한 메커니즘을 밝힐 수 있습니다.

Enhancing Trust and Reliability in AI Deployments

AI 배포의 신뢰도 및 신뢰성 향상

The LLM-TT tool is an invaluable asset for building trust and reliability in AI deployments. By providing a deeper understanding of how LLMs make decisions, the tool empowers users to identify and mitigate potential risks, such as biases or errors. This transparency fosters accountability and allows organizations to make informed decisions about the use of LLMs in critical applications.

LLM-TT 도구는 AI 배포에서 신뢰와 신뢰성을 구축하는 데 있어 귀중한 자산입니다. 이 도구는 LLM이 의사 결정을 내리는 방법에 대한 더 깊은 이해를 제공함으로써 사용자가 편견이나 오류와 같은 잠재적인 위험을 식별하고 완화할 수 있도록 지원합니다. 이러한 투명성은 책임성을 강화하고 조직이 중요한 응용 프로그램에서 LLM 사용에 대해 정보에 입각한 결정을 내릴 수 있도록 해줍니다.

Conclusion: Empowering Ethical and Responsible AI

결론: 윤리적이고 책임감 있는 AI 강화

The Large Language Model Transparency Tool (LLM-TT) is a groundbreaking innovation that empowers researchers, developers, and policymakers to enhance the transparency, accountability, and ethical use of large language models. By providing an interactive and comprehensive view into the inner workings of LLMs, LLM-TT supports the development and deployment of more fair, reliable, and responsible AI technologies.

LLM-TT(대형 언어 모델 투명성 도구)는 연구원, 개발자 및 정책 입안자가 대규모 언어 모델의 투명성, 책임성 및 윤리적 사용을 향상할 수 있도록 지원하는 획기적인 혁신입니다. LLM-TT는 LLM의 내부 작동에 대한 대화형의 포괄적인 보기를 제공함으로써 보다 공정하고 안정적이며 책임감 있는 AI 기술의 개발 및 배포를 지원합니다.

As the field of AI continues to advance, the need for robust tools to monitor and understand complex models will only grow stronger. LLM-TT stands as a testament to the importance of transparency and accountability in AI, paving the way for a future where AI systems are used ethically and responsibly to benefit society.

AI 분야가 계속 발전함에 따라 복잡한 모델을 모니터링하고 이해하기 위한 강력한 도구에 대한 필요성은 점점 더 커질 것입니다. LLM-TT는 AI의 투명성과 책임의 중요성에 대한 증거로서 AI 시스템이 사회에 이익이 되도록 윤리적이고 책임감 있게 사용되는 미래를 위한 길을 열어줍니다.

부인 성명:info@kdj.com

제공된 정보는 거래 조언이 아닙니다. kdj.com은 이 기사에 제공된 정보를 기반으로 이루어진 투자에 대해 어떠한 책임도 지지 않습니다. 암호화폐는 변동성이 매우 높으므로 철저한 조사 후 신중하게 투자하는 것이 좋습니다!

본 웹사이트에 사용된 내용이 귀하의 저작권을 침해한다고 판단되는 경우, 즉시 당사(info@kdj.com)로 연락주시면 즉시 삭제하도록 하겠습니다.