|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Nachrichtenartikel zu Kryptowährungen

Entmystifizierung komplexer Sprachmodelle mit LLM-TT: Verbesserung der Transparenz und des Vertrauens in künstliche Intelligenz

Apr 18, 2024 at 04:00 pm

Das von Meta Research entwickelte Large Language Model Transparency Tool (LLM-TT) bietet beispiellose Einblicke in die Entscheidungsprozesse transformatorbasierter Sprachmodelle. Dieses Open-Source-Toolkit ermöglicht die Inspektion des Informationsflusses und ermöglicht es Benutzern, Aufmerksamkeitskopfbeiträge und Neuroneneinflüsse zu untersuchen. Das Tool ermöglicht die Entwicklung ethischerer und vertrauenswürdigerer KI-Einsätze, indem es die Überprüfung des Modellverhaltens, die Erkennung von Verzerrungen und die Ausrichtung auf Standards erleichtert.

Demystifying Complex Language Models with the Pioneering LLM-TT Tool: Enhancing Transparency and Accountability in AI

Entmystifizierung komplexer Sprachmodelle mit dem bahnbrechenden LLM-TT-Tool: Verbesserung der Transparenz und Verantwortlichkeit in der KI

In the burgeoning realm of artificial intelligence (AI), large language models (LLMs) have emerged as powerful tools, capable of tasks ranging from natural language processing to content generation. However, their intricate inner workings have remained largely opaque, hindering efforts to ensure their fairness, accountability, and alignment with ethical standards.

Im aufstrebenden Bereich der künstlichen Intelligenz (KI) haben sich große Sprachmodelle (LLMs) als leistungsstarke Werkzeuge herausgestellt, die Aufgaben von der Verarbeitung natürlicher Sprache bis zur Inhaltsgenerierung erfüllen können. Ihr komplexes Innenleben ist jedoch weitgehend undurchsichtig geblieben, was die Bemühungen behindert, ihre Fairness, Rechenschaftspflicht und Übereinstimmung mit ethischen Standards sicherzustellen.

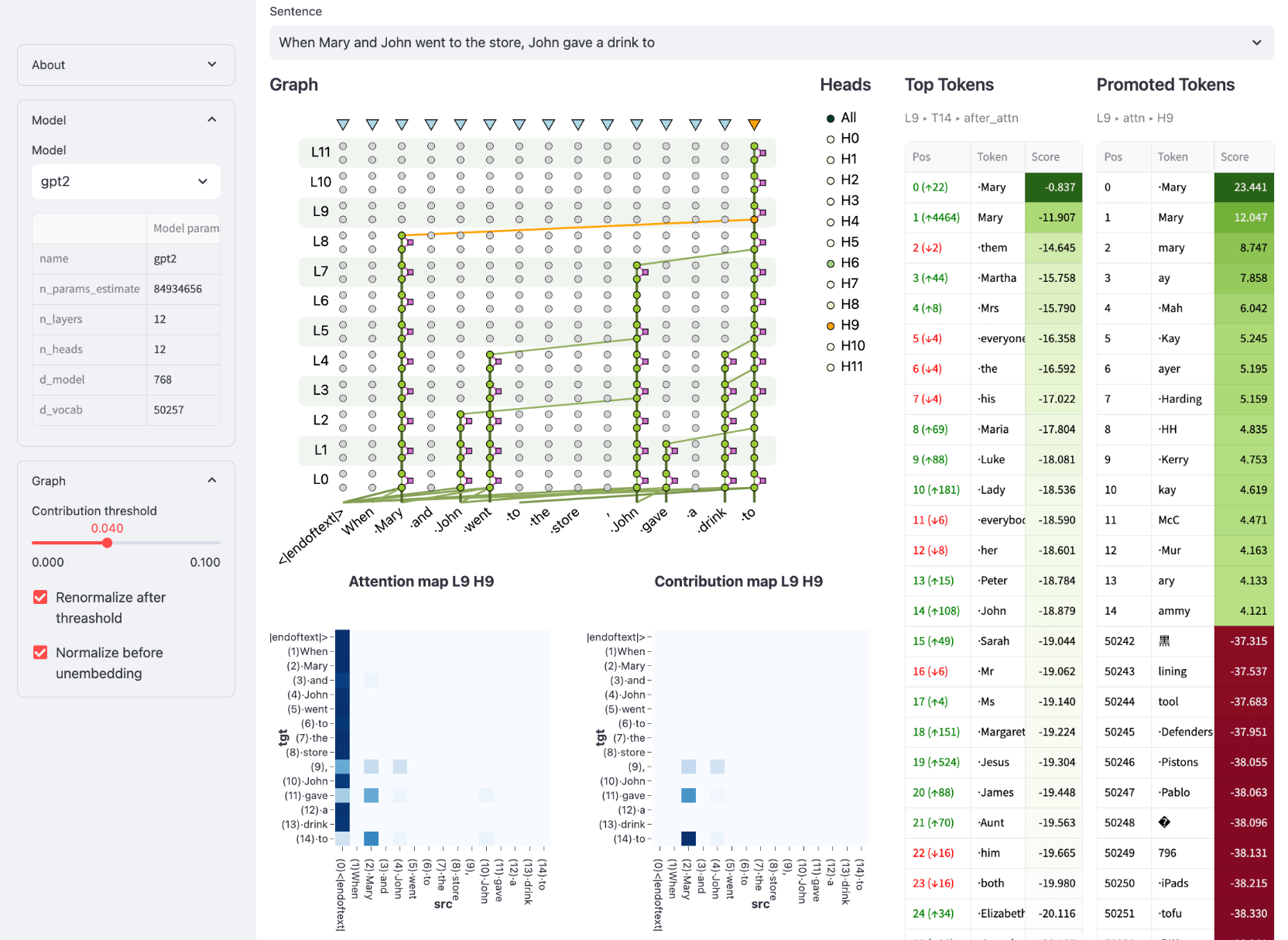

Enter the Large Language Model Transparency Tool (LLM-TT), a groundbreaking open-source toolkit developed by Meta Research. This innovative tool brings unprecedented transparency to LLMs, empowering users to dissect their decision-making processes and uncover hidden biases. By providing a comprehensive view into the flow of information within an LLM, LLM-TT empowers researchers, developers, and policymakers alike to foster more ethical and responsible AI practices.

Betreten Sie das Large Language Model Transparency Tool (LLM-TT), ein bahnbrechendes Open-Source-Toolkit, das von Meta Research entwickelt wurde. Dieses innovative Tool bringt beispiellose Transparenz in LLMs und ermöglicht es Benutzern, ihre Entscheidungsprozesse zu analysieren und versteckte Vorurteile aufzudecken. Durch die Bereitstellung eines umfassenden Einblicks in den Informationsfluss innerhalb eines LLM ermöglicht LLM-TT Forschern, Entwicklern und politischen Entscheidungsträgern gleichermaßen, ethischere und verantwortungsvollere KI-Praktiken zu fördern.

Bridging the Gap of Understanding and Oversight

Überbrückung der Kluft zwischen Verständnis und Kontrolle

The development of LLM-TT stems from the growing recognition that the complexity of LLMs poses significant challenges for understanding and monitoring their behavior. As these models are increasingly deployed in high-stakes applications, such as decision-making processes and content moderation, the need for methods to ensure their fairness, accuracy, and adherence to ethical principles becomes paramount.

Die Entwicklung von LLM-TT basiert auf der wachsenden Erkenntnis, dass die Komplexität von LLMs erhebliche Herausforderungen für das Verständnis und die Überwachung ihres Verhaltens mit sich bringt. Da diese Modelle zunehmend in anspruchsvollen Anwendungen wie Entscheidungsprozessen und der Moderation von Inhalten eingesetzt werden, wird der Bedarf an Methoden zur Gewährleistung ihrer Fairness, Genauigkeit und Einhaltung ethischer Grundsätze immer wichtiger.

LLM-TT addresses this need by providing a visual representation of the information flow within a model, allowing users to trace the impact of individual components on model outputs. This capability is particularly crucial for identifying and mitigating potential biases that may arise from the training data or model architecture. With LLM-TT, researchers can systematically examine the model's reasoning process, uncover hidden assumptions, and ensure its alignment with desired objectives.

LLM-TT geht auf diesen Bedarf ein, indem es eine visuelle Darstellung des Informationsflusses innerhalb eines Modells bereitstellt und es Benutzern ermöglicht, die Auswirkungen einzelner Komponenten auf die Modellausgaben zu verfolgen. Diese Fähigkeit ist besonders wichtig für die Identifizierung und Minderung potenzieller Verzerrungen, die sich aus den Trainingsdaten oder der Modellarchitektur ergeben können. Mit LLM-TT können Forscher den Argumentationsprozess des Modells systematisch untersuchen, versteckte Annahmen aufdecken und seine Übereinstimmung mit den gewünschten Zielen sicherstellen.

Interactive Inspection of Model Components

Interaktive Inspektion von Modellkomponenten

LLM-TT offers an interactive user experience, enabling detailed inspection of the model's architecture and its processing of information. By selecting a model and input, users can generate a contribution graph that visualizes the flow of information from input to output. The tool provides interactive controls to adjust the contribution threshold, allowing users to focus on the most influential components of the model's computation.

LLM-TT bietet ein interaktives Benutzererlebnis und ermöglicht eine detaillierte Betrachtung der Architektur des Modells und seiner Informationsverarbeitung. Durch Auswahl eines Modells und einer Eingabe können Benutzer ein Beitragsdiagramm erstellen, das den Informationsfluss von der Eingabe zur Ausgabe visualisiert. Das Tool bietet interaktive Steuerelemente zum Anpassen des Beitragsschwellenwerts, sodass sich Benutzer auf die einflussreichsten Komponenten der Modellberechnung konzentrieren können.

Moreover, LLM-TT allows users to select any token within the model's output and explore its representation after each layer in the model. This feature provides insights into how the model processes individual words or phrases, enabling users to understand the relationship between input and output and identify potential sources of bias or error.

Darüber hinaus ermöglicht LLM-TT Benutzern die Auswahl eines beliebigen Tokens in der Modellausgabe und die Untersuchung seiner Darstellung nach jeder Ebene im Modell. Diese Funktion bietet Einblicke in die Art und Weise, wie das Modell einzelne Wörter oder Phrasen verarbeitet, und ermöglicht es Benutzern, die Beziehung zwischen Eingabe und Ausgabe zu verstehen und potenzielle Quellen für Verzerrungen oder Fehler zu identifizieren.

Dissecting Attention Mechanisms and Feedforward Networks

Analyse von Aufmerksamkeitsmechanismen und Feedforward-Netzwerken

LLM-TT goes beyond static visualizations by incorporating interactive elements that allow users to delve deeper into the model's inner workings. By clicking on edges within the contribution graph, users can reveal details about the contributing attention head, providing insights into the specific relationships between input and output tokens.

LLM-TT geht über statische Visualisierungen hinaus, indem es interaktive Elemente integriert, die es Benutzern ermöglichen, tiefer in das Innenleben des Modells einzutauchen. Durch Klicken auf Kanten im Beitragsdiagramm können Benutzer Details zum beitragenden Aufmerksamkeitskopf anzeigen und so Einblicke in die spezifischen Beziehungen zwischen Eingabe- und Ausgabe-Tokens erhalten.

Furthermore, LLM-TT provides the ability to inspect feedforward network (FFN) blocks and their constituent neurons. This fine-grained analysis enables users to pinpoint the exact locations within the model where important computations occur, shedding light on the intricate mechanisms that underpin the model's predictions.

Darüber hinaus bietet LLM-TT die Möglichkeit, Feedforward-Netzwerkblöcke (FFN) und ihre konstituierenden Neuronen zu untersuchen. Diese feinkörnige Analyse ermöglicht es Benutzern, die genauen Stellen innerhalb des Modells zu bestimmen, an denen wichtige Berechnungen stattfinden, und gibt Aufschluss über die komplizierten Mechanismen, die den Vorhersagen des Modells zugrunde liegen.

Enhancing Trust and Reliability in AI Deployments

Verbesserung des Vertrauens und der Zuverlässigkeit bei KI-Bereitstellungen

The LLM-TT tool is an invaluable asset for building trust and reliability in AI deployments. By providing a deeper understanding of how LLMs make decisions, the tool empowers users to identify and mitigate potential risks, such as biases or errors. This transparency fosters accountability and allows organizations to make informed decisions about the use of LLMs in critical applications.

Das LLM-TT-Tool ist ein unschätzbarer Vorteil für den Aufbau von Vertrauen und Zuverlässigkeit bei KI-Einsätzen. Durch die Bereitstellung eines tieferen Verständnisses darüber, wie LLMs Entscheidungen treffen, ermöglicht das Tool den Benutzern, potenzielle Risiken wie Voreingenommenheiten oder Fehler zu erkennen und zu mindern. Diese Transparenz fördert die Verantwortlichkeit und ermöglicht es Organisationen, fundierte Entscheidungen über den Einsatz von LLMs in kritischen Anwendungen zu treffen.

Conclusion: Empowering Ethical and Responsible AI

Fazit: Ethische und verantwortungsvolle KI stärken

The Large Language Model Transparency Tool (LLM-TT) is a groundbreaking innovation that empowers researchers, developers, and policymakers to enhance the transparency, accountability, and ethical use of large language models. By providing an interactive and comprehensive view into the inner workings of LLMs, LLM-TT supports the development and deployment of more fair, reliable, and responsible AI technologies.

Das Large Language Model Transparency Tool (LLM-TT) ist eine bahnbrechende Innovation, die es Forschern, Entwicklern und politischen Entscheidungsträgern ermöglicht, die Transparenz, Verantwortlichkeit und ethische Nutzung großer Sprachmodelle zu verbessern. Durch die Bereitstellung eines interaktiven und umfassenden Einblicks in das Innenleben von LLMs unterstützt LLM-TT die Entwicklung und den Einsatz fairerer, zuverlässigerer und verantwortungsvollerer KI-Technologien.

As the field of AI continues to advance, the need for robust tools to monitor and understand complex models will only grow stronger. LLM-TT stands as a testament to the importance of transparency and accountability in AI, paving the way for a future where AI systems are used ethically and responsibly to benefit society.

Da der Bereich der KI immer weiter voranschreitet, wird der Bedarf an robusten Werkzeugen zur Überwachung und zum Verständnis komplexer Modelle immer größer. LLM-TT ist ein Beweis für die Bedeutung von Transparenz und Rechenschaftspflicht in der KI und ebnet den Weg für eine Zukunft, in der KI-Systeme ethisch und verantwortungsvoll zum Nutzen der Gesellschaft eingesetzt werden.

Haftungsausschluss:info@kdj.com

Die bereitgestellten Informationen stellen keine Handelsberatung dar. kdj.com übernimmt keine Verantwortung für Investitionen, die auf der Grundlage der in diesem Artikel bereitgestellten Informationen getätigt werden. Kryptowährungen sind sehr volatil und es wird dringend empfohlen, nach gründlicher Recherche mit Vorsicht zu investieren!

Wenn Sie glauben, dass der auf dieser Website verwendete Inhalt Ihr Urheberrecht verletzt, kontaktieren Sie uns bitte umgehend (info@kdj.com) und wir werden ihn umgehend löschen.

![Der Handel folgt, [Review Video] zu folgen, dass Gold Bitcoin -Rohölaufträge profitieren! Der Handel folgt, [Review Video] zu folgen, dass Gold Bitcoin -Rohölaufträge profitieren!](/uploads/2025/04/26/cryptocurrencies-news/videos/trading-follow-review-video-gold-bitcoin-crude-oil-profits/image-1.webp)