|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Meta Research によって開発された Large Language Model Transparency Tool (LLM-TT) は、Transformer ベースの言語モデルの意思決定プロセスに対する前例のない可視性を提供します。このオープンソース ツールキットを使用すると、情報フローの検査が可能になり、ユーザーはアテンション ヘッドの寄与とニューロンの影響を調査できます。このツールは、モデルの動作の検証、バイアスの検出、標準との整合性を容易にすることで、より倫理的で信頼できる AI 導入の開発を支援します。

Demystifying Complex Language Models with the Pioneering LLM-TT Tool: Enhancing Transparency and Accountability in AI

先駆的な LLM-TT ツールで複雑な言語モデルを解明する: AI の透明性と説明責任を強化する

In the burgeoning realm of artificial intelligence (AI), large language models (LLMs) have emerged as powerful tools, capable of tasks ranging from natural language processing to content generation. However, their intricate inner workings have remained largely opaque, hindering efforts to ensure their fairness, accountability, and alignment with ethical standards.

人工知能 (AI) の急成長分野では、自然言語処理からコンテンツ生成まで幅広いタスクを実行できる強力なツールとして大規模言語モデル (LLM) が登場しました。しかし、彼らの複雑な内部構造はほとんど不透明なままであり、彼らの公平性、説明責任、倫理基準との整合性を確保する取り組みを妨げています。

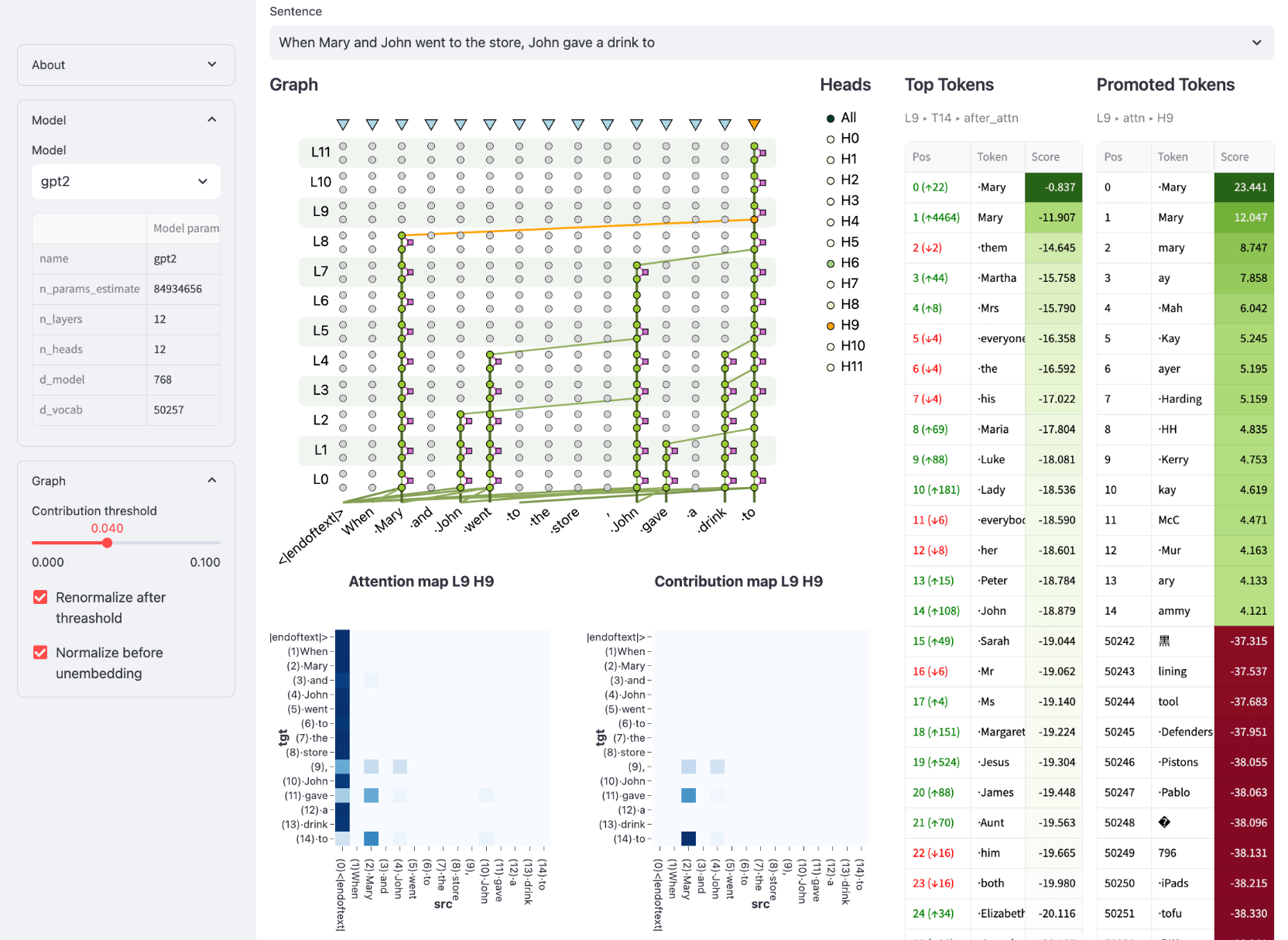

Enter the Large Language Model Transparency Tool (LLM-TT), a groundbreaking open-source toolkit developed by Meta Research. This innovative tool brings unprecedented transparency to LLMs, empowering users to dissect their decision-making processes and uncover hidden biases. By providing a comprehensive view into the flow of information within an LLM, LLM-TT empowers researchers, developers, and policymakers alike to foster more ethical and responsible AI practices.

Meta Research が開発した画期的なオープンソース ツールキットである Large Language Model Transparency Tool (LLM-TT) を導入してください。この革新的なツールは、LLM に前例のない透明性をもたらし、ユーザーが意思決定プロセスを分析し、隠れたバイアスを明らかにできるようにします。 LLM-TT は、LLM 内の情報の流れの包括的なビューを提供することで、研究者、開発者、政策立案者が同様に、より倫理的で責任ある AI 実践を推進できるようにします。

Bridging the Gap of Understanding and Oversight

理解と監視のギャップを埋める

The development of LLM-TT stems from the growing recognition that the complexity of LLMs poses significant challenges for understanding and monitoring their behavior. As these models are increasingly deployed in high-stakes applications, such as decision-making processes and content moderation, the need for methods to ensure their fairness, accuracy, and adherence to ethical principles becomes paramount.

LLM-TT の開発は、LLM の複雑さがその動作を理解および監視する上で重大な課題を引き起こすという認識の高まりから生まれました。これらのモデルは、意思決定プロセスやコンテンツのモデレーションなど、一か八かのアプリケーションに導入されることが増えており、モデルの公平性、正確性、倫理原則の順守を保証する方法の必要性が最も重要になっています。

LLM-TT addresses this need by providing a visual representation of the information flow within a model, allowing users to trace the impact of individual components on model outputs. This capability is particularly crucial for identifying and mitigating potential biases that may arise from the training data or model architecture. With LLM-TT, researchers can systematically examine the model's reasoning process, uncover hidden assumptions, and ensure its alignment with desired objectives.

LLM-TT は、モデル内の情報フローを視覚的に表現することでこのニーズに対応し、ユーザーがモデル出力に対する個々のコンポーネントの影響を追跡できるようにします。この機能は、トレーニング データやモデル アーキテクチャから生じる可能性のある潜在的なバイアスを特定し、軽減するために特に重要です。 LLM-TT を使用すると、研究者はモデルの推論プロセスを体系的に検査し、隠れた仮定を明らかにし、目的との整合性を確保できます。

Interactive Inspection of Model Components

モデルコンポーネントの対話型検査

LLM-TT offers an interactive user experience, enabling detailed inspection of the model's architecture and its processing of information. By selecting a model and input, users can generate a contribution graph that visualizes the flow of information from input to output. The tool provides interactive controls to adjust the contribution threshold, allowing users to focus on the most influential components of the model's computation.

LLM-TT は対話型のユーザー エクスペリエンスを提供し、モデルのアーキテクチャとその情報処理の詳細な検査を可能にします。ユーザーはモデルと入力を選択することで、入力から出力までの情報の流れを視覚化する寄与グラフを生成できます。このツールは、寄与のしきい値を調整するための対話型コントロールを提供するため、ユーザーはモデルの計算の最も影響力のあるコンポーネントに集中できます。

Moreover, LLM-TT allows users to select any token within the model's output and explore its representation after each layer in the model. This feature provides insights into how the model processes individual words or phrases, enabling users to understand the relationship between input and output and identify potential sources of bias or error.

さらに、LLM-TT を使用すると、ユーザーはモデルの出力内で任意のトークンを選択し、モデル内の各層の後でその表現を探索できます。この機能は、モデルが個々の単語やフレーズをどのように処理するかについての洞察を提供し、ユーザーが入力と出力の関係を理解し、潜在的なバイアスやエラーの原因を特定できるようにします。

Dissecting Attention Mechanisms and Feedforward Networks

注意メカニズムとフィードフォワード ネットワークを解剖する

LLM-TT goes beyond static visualizations by incorporating interactive elements that allow users to delve deeper into the model's inner workings. By clicking on edges within the contribution graph, users can reveal details about the contributing attention head, providing insights into the specific relationships between input and output tokens.

LLM-TT は、ユーザーがモデルの内部動作をさらに深く掘り下げることができるインタラクティブな要素を組み込むことで、静的な視覚化を超えています。寄与グラフ内のエッジをクリックすると、ユーザーは寄与しているアテンション ヘッドの詳細を明らかにし、入力トークンと出力トークンの間の特定の関係についての洞察を得ることができます。

Furthermore, LLM-TT provides the ability to inspect feedforward network (FFN) blocks and their constituent neurons. This fine-grained analysis enables users to pinpoint the exact locations within the model where important computations occur, shedding light on the intricate mechanisms that underpin the model's predictions.

さらに、LLM-TT は、フィードフォワード ネットワーク (FFN) ブロックとその構成ニューロンを検査する機能を提供します。このきめ細かい分析により、ユーザーは重要な計算が行われるモデル内の正確な位置を正確に特定することができ、モデルの予測を支える複雑なメカニズムを明らかにすることができます。

Enhancing Trust and Reliability in AI Deployments

AI 導入における信頼性と信頼性の強化

The LLM-TT tool is an invaluable asset for building trust and reliability in AI deployments. By providing a deeper understanding of how LLMs make decisions, the tool empowers users to identify and mitigate potential risks, such as biases or errors. This transparency fosters accountability and allows organizations to make informed decisions about the use of LLMs in critical applications.

LLM-TT ツールは、AI 導入における信頼性と信頼性を構築するための貴重な資産です。このツールは、LLM がどのように意思決定を行うかをより深く理解できるようにすることで、ユーザーがバイアスやエラーなどの潜在的なリスクを特定し、軽減できるようにします。この透明性により説明責任が促進され、組織は重要なアプリケーションでの LLM の使用について情報に基づいた意思決定を行うことができます。

Conclusion: Empowering Ethical and Responsible AI

結論: 倫理的で責任ある AI を強化する

The Large Language Model Transparency Tool (LLM-TT) is a groundbreaking innovation that empowers researchers, developers, and policymakers to enhance the transparency, accountability, and ethical use of large language models. By providing an interactive and comprehensive view into the inner workings of LLMs, LLM-TT supports the development and deployment of more fair, reliable, and responsible AI technologies.

Large Language Model Transparency Tool (LLM-TT) は、研究者、開発者、政策立案者が大規模言語モデルの透明性、説明責任、倫理的使用を強化できるようにする画期的なイノベーションです。 LLM-TT は、LLM の内部動作に対するインタラクティブかつ包括的なビューを提供することで、より公正で信頼性が高く責任ある AI テクノロジーの開発と展開をサポートします。

As the field of AI continues to advance, the need for robust tools to monitor and understand complex models will only grow stronger. LLM-TT stands as a testament to the importance of transparency and accountability in AI, paving the way for a future where AI systems are used ethically and responsibly to benefit society.

AI の分野が進歩し続けるにつれて、複雑なモデルを監視し理解するための堅牢なツールの必要性はますます高まるでしょう。 LLM-TT は、AI における透明性と説明責任の重要性の証しであり、社会に利益をもたらすために AI システムが倫理的かつ責任を持って使用される未来への道を切り開きます。

免責事項:info@kdj.com

提供される情報は取引に関するアドバイスではありません。 kdj.com は、この記事で提供される情報に基づいて行われた投資に対して一切の責任を負いません。暗号通貨は変動性が高いため、十分な調査を行った上で慎重に投資することを強くお勧めします。

このウェブサイトで使用されているコンテンツが著作権を侵害していると思われる場合は、直ちに当社 (info@kdj.com) までご連絡ください。速やかに削除させていただきます。

![取引は、[ビデオのレビュー]ゴールドビットコイン原油注文に従うことです。 取引は、[ビデオのレビュー]ゴールドビットコイン原油注文に従うことです。](/uploads/2025/04/26/cryptocurrencies-news/videos/trading-follow-review-video-gold-bitcoin-crude-oil-profits/image-1.webp)