|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Nachrichtenartikel zu Kryptowährungen

Content-Adaptive Tokenization (CAT): Ein bahnbrechendes Framework für die inhaltsbewusste Bild-Tokenisierung

Jan 11, 2025 at 09:03 am

Forscher der Carnegie Mellon University und von Meta schlagen Content-Adaptive Tokenization (CAT) vor, ein bahnbrechendes Framework für die inhaltsbewusste Bild-Tokenisierung

In the realm of AI-driven image modeling, one of the critical challenges that have yet to be fully addressed is the inability to effectively account for the diversity present in image content complexity. Existing tokenization methods largely employ static compression ratios, treating all images equally without considering their varying complexities. As a result of this approach, complex images often undergo excessive compression, leading to the loss of crucial information, while simpler images remain under-compressed, wasting valuable computational resources. These inefficiencies directly impact the performance of subsequent operations, such as the reconstruction and generation of images, where accurate and efficient representation plays a pivotal role.

Im Bereich der KI-gesteuerten Bildmodellierung besteht eine der entscheidenden Herausforderungen, die noch nicht vollständig angegangen werden muss, darin, dass die Vielfalt der Komplexität von Bildinhalten nicht effektiv berücksichtigt werden kann. Bestehende Tokenisierungsmethoden verwenden größtenteils statische Komprimierungsverhältnisse und behandeln alle Bilder gleich, ohne ihre unterschiedliche Komplexität zu berücksichtigen. Aufgrund dieses Ansatzes werden komplexe Bilder häufig übermäßig komprimiert, was zum Verlust wichtiger Informationen führt, während einfachere Bilder unzureichend komprimiert bleiben und wertvolle Rechenressourcen verschwenden. Diese Ineffizienzen wirken sich direkt auf die Leistung nachfolgender Vorgänge aus, etwa der Rekonstruktion und Generierung von Bildern, bei denen eine genaue und effiziente Darstellung eine entscheidende Rolle spielt.

Current techniques for tokenizing images fall short in appropriately addressing the variation in complexity. Fixed ratio tokenization approaches, such as resizing images to standard sizes, fail to account for the varying content complexities. While Vision Transformers do adapt patch size dynamically, they rely on image input and lack the flexibility required for text-to-image applications. Other compression techniques, such as JPEG, are specifically designed for traditional media and lack optimization for deep learning-based tokenization. Recent work, such as ElasticTok, has explored random token length strategies but lacked consideration of the intrinsic content complexity during training time, leading to inefficiencies in quality and computational cost.

Aktuelle Techniken zur Tokenisierung von Bildern können die Unterschiede in der Komplexität nicht angemessen berücksichtigen. Tokenisierungsansätze mit festem Verhältnis, wie z. B. die Größenänderung von Bildern auf Standardgrößen, berücksichtigen die unterschiedlichen Inhaltskomplexitäten nicht. Während Vision Transformer die Patchgröße dynamisch anpassen, sind sie auf die Bildeingabe angewiesen und verfügen nicht über die Flexibilität, die für Text-zu-Bild-Anwendungen erforderlich ist. Andere Komprimierungstechniken wie JPEG sind speziell für herkömmliche Medien konzipiert und nicht für die Deep-Learning-basierte Tokenisierung optimiert. In neueren Arbeiten wie ElasticTok wurden Strategien mit zufälliger Tokenlänge untersucht, es fehlte jedoch die Berücksichtigung der intrinsischen Inhaltskomplexität während der Trainingszeit, was zu Ineffizienzen bei der Qualität und den Rechenkosten führte.

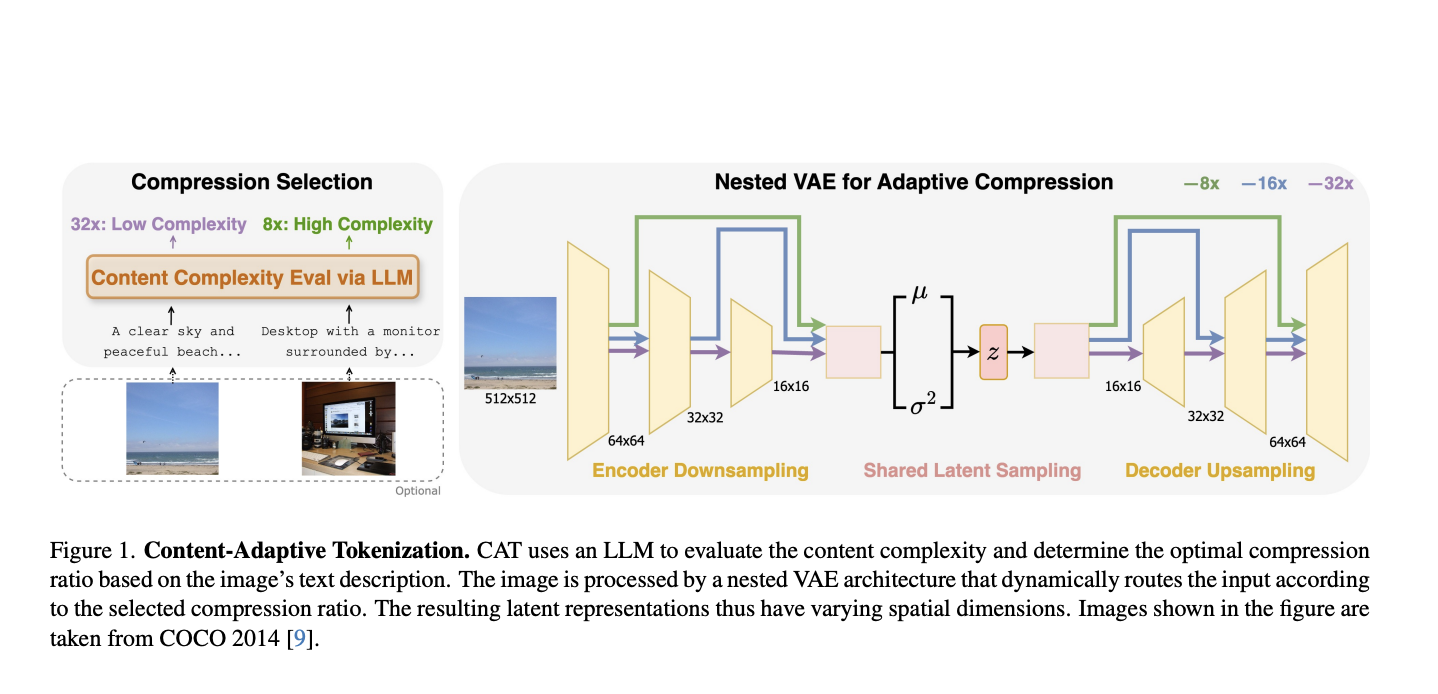

To address these limitations, researchers from Carnegie Mellon University and Meta have proposed Content-Adaptive Tokenization (CAT), a pioneering framework for content-aware image tokenization that introduces a dynamic approach to allocating representation capacity based on content complexity. This innovation enables large language models to assess the complexity of images from captions and perception-based queries while classifying images into three compression levels: 8x, 16x, and 32x. Furthermore, it utilizes a nested VAE architecture that generates variable-length latent features by dynamically routing intermediate outputs based on the complexity of the images. The adaptive design reduces training overhead and optimizes image representation quality to overcome the inefficiencies of fixed-ratio methods. Notably, CAT enables adaptive and efficient tokenization using text-based complexity analysis without requiring image inputs at inference.

Um diese Einschränkungen zu beseitigen, haben Forscher der Carnegie Mellon University und von Meta die Content-Adaptive Tokenization (CAT) vorgeschlagen, ein bahnbrechendes Framework für die inhaltsbewusste Bild-Tokenisierung, das einen dynamischen Ansatz zur Zuweisung von Darstellungskapazität basierend auf der Komplexität des Inhalts einführt. Diese Innovation ermöglicht es großen Sprachmodellen, die Komplexität von Bildern anhand von Bildunterschriften und wahrnehmungsbasierten Abfragen zu beurteilen und gleichzeitig Bilder in drei Komprimierungsstufen zu klassifizieren: 8x, 16x und 32x. Darüber hinaus nutzt es eine verschachtelte VAE-Architektur, die latente Merkmale variabler Länge generiert, indem Zwischenausgaben basierend auf der Komplexität der Bilder dynamisch weitergeleitet werden. Das adaptive Design reduziert den Trainingsaufwand und optimiert die Bilddarstellungsqualität, um die Ineffizienzen von Methoden mit festem Verhältnis zu überwinden. Insbesondere ermöglicht CAT eine adaptive und effiziente Tokenisierung mithilfe einer textbasierten Komplexitätsanalyse, ohne dass bei der Inferenz Bildeingaben erforderlich sind.

CAT evaluates complexity with captions produced from LLMs that consider both semantic, visual, and perceptual features while determining compression ratios. Such a caption-based system is observed to be superior to traditional methods, including JPEG size and MSE in mimicking human perceived importance. The adaptive nested VAE design achieves this with channel-matched skip connections that dynamically alter latent space across varying compression levels. Shared parameterization guarantees consistency across scales, while training is performed by a combination of reconstruction error, perceptual loss (e.g., LPIPS), and adversarial loss to reach optimal performance. CAT was trained on a dataset of 380 million images and tested on the benchmarks of COCO, ImageNet, CelebA, and ChartQA, demonstrating its applicability to different image types.

CAT bewertet die Komplexität mit aus LLMs erstellten Untertiteln, die sowohl semantische als auch visuelle und wahrnehmungsbezogene Merkmale berücksichtigen und gleichzeitig die Komprimierungsverhältnisse bestimmen. Es wird beobachtet, dass ein solches auf Untertiteln basierendes System herkömmlichen Methoden, einschließlich JPEG-Größe und MSE, bei der Nachahmung der vom Menschen wahrgenommenen Bedeutung überlegen ist. Das adaptive verschachtelte VAE-Design erreicht dies mit kanalangepassten Sprungverbindungen, die den latenten Raum über verschiedene Komprimierungsstufen hinweg dynamisch ändern. Die gemeinsame Parametrisierung garantiert Konsistenz über Skalen hinweg, während das Training durch eine Kombination aus Rekonstruktionsfehlern, Wahrnehmungsverlusten (z. B. LPIPS) und gegnerischen Verlusten durchgeführt wird, um eine optimale Leistung zu erreichen. CAT wurde anhand eines Datensatzes von 380 Millionen Bildern trainiert und anhand der Benchmarks von COCO, ImageNet, CelebA und ChartQA getestet, wodurch seine Anwendbarkeit auf verschiedene Bildtypen demonstriert wurde.

This approach achieves highly significant performance improvements in both image reconstruction and generation by adapting compression to content complexity. For reconstruction tasks, it significantly improves the rFID, LPIPS, and PSNR metrics. It delivers a 12% quality improvement for the reconstruction of CelebA and a 39% enhancement for ChartQA, all while keeping the quality comparable to those of datasets such as COCO and ImageNet with fewer tokens and efficiency. For class-conditional ImageNet generation, CAT outperforms the fixed-ratio baselines with an FID of 4.56 and improves inference throughput by 18.5%. This adaptive tokenization framework serves as the new benchmark for further improvement.

Mit diesem Ansatz werden erhebliche Leistungsverbesserungen sowohl bei der Bildrekonstruktion als auch bei der Generierung erzielt, indem die Komprimierung an die Komplexität des Inhalts angepasst wird. Für Rekonstruktionsaufgaben werden die rFID-, LPIPS- und PSNR-Metriken erheblich verbessert. Es bietet eine Qualitätsverbesserung von 12 % für die Rekonstruktion von CelebA und eine Verbesserung von 39 % für ChartQA, während die Qualität mit der von Datensätzen wie COCO und ImageNet vergleichbar bleibt, mit weniger Token und Effizienz. Bei der klassenbedingten ImageNet-Generierung übertrifft CAT die Basislinien mit festem Verhältnis mit einem FID von 4,56 und verbessert den Inferenzdurchsatz um 18,5 %. Dieses adaptive Tokenisierungs-Framework dient als neuer Maßstab für weitere Verbesserungen.

CAT presents a novel approach to image tokenization by dynamically modulating compression levels based on the complexity of the content. It integrates LLM-based assessments with an adaptive nested VAE, eliminating persistent inefficiencies associated with fixed-ratio tokenization, thereby significantly improving performance in reconstruction and generation tasks. The adaptability and effectiveness of CAT make it a revolutionary asset in AI-oriented image modeling, with potential applications extending to video and multi-modal domains.

CAT präsentiert einen neuartigen Ansatz zur Bild-Tokenisierung durch dynamisches Modulieren der Komprimierungsstufen basierend auf der Komplexität des Inhalts. Es integriert LLM-basierte Bewertungen mit einer adaptiven verschachtelten VAE, wodurch anhaltende Ineffizienzen im Zusammenhang mit der Tokenisierung mit festem Verhältnis beseitigt werden und dadurch die Leistung bei Rekonstruktions- und Generierungsaufgaben erheblich verbessert wird. Die Anpassungsfähigkeit und Effektivität von CAT machen es zu einem revolutionären Vorteil in der KI-orientierten Bildmodellierung, mit potenziellen Anwendungen, die sich auf Video- und multimodale Bereiche erstrecken.

Haftungsausschluss:info@kdj.com

Die bereitgestellten Informationen stellen keine Handelsberatung dar. kdj.com übernimmt keine Verantwortung für Investitionen, die auf der Grundlage der in diesem Artikel bereitgestellten Informationen getätigt werden. Kryptowährungen sind sehr volatil und es wird dringend empfohlen, nach gründlicher Recherche mit Vorsicht zu investieren!

Wenn Sie glauben, dass der auf dieser Website verwendete Inhalt Ihr Urheberrecht verletzt, kontaktieren Sie uns bitte umgehend (info@kdj.com) und wir werden ihn umgehend löschen.

-

-

-

-

- Trump Treffen mit Bukele: Stärkung der Beziehungen zu Sicherheit und Bitcoin

- Apr 05, 2025 at 12:30 am

- Der US -Präsident Donald Trump wird voraussichtlich am 14. April 2020 beim Präsidenten des Weißen Hauses, Nayib Bukele von El Salvador, willkommen geheißen. Der Besuch entspricht den kürzlich unterzeichneten bilateralen Vereinbarungen zwischen den beiden Ländern bezüglich Einwanderungs- und Sicherheitskooperation.

-

-

- Der Coinbase -Aktienkurs -Crash verstärkte sich nach der Ankündigung von Donald Trump

- Apr 05, 2025 at 12:25 am

- Input: Coinbase, einer der größten Krypto -Austausch der Welt, ist empfindlich gegenüber Marktbedingungen. Der Coinbase -Aktienkurs -Crash verstärkte sich nach der Ankündigung von Donald Trump

-

-

- Der Stablecoin -Marktcrash wurde als FDUSD vertieft, der von First Digital ausgestellt wurde, seinen 1 -Dollar -Stift verloren

- Apr 05, 2025 at 12:20 am

- Der Stablecoin -Marktcrash wurde als FDUSD, der von First Digital ausgestellt wurde, nach Insolvenzvorwürfen von Tron -Gründer Justin Sun seinen 1 -Dollar -Stift verlor.

-

- Justin Sun tritt ein, um TrueUsd (TUSD) aus einer Liquiditätskrise in Höhe von 456 Mio. USD zu retten

- Apr 05, 2025 at 12:15 am

- Crypto News summt darüber, dass Justin Sun einspringt, um Trueusd (TUSD) zu retten. Das Stablecoin stand nach Missmanagement durch ihren Treuhänder einer Liquiditätskrise in Höhe von 456 Millionen US -Dollar