|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

カーネギー メロン大学とメタの研究者は、コンテンツを意識した画像トークン化の先駆的なフレームワークであるコンテンツ アダプティブ トークン化 (CAT) を提案しています。

In the realm of AI-driven image modeling, one of the critical challenges that have yet to be fully addressed is the inability to effectively account for the diversity present in image content complexity. Existing tokenization methods largely employ static compression ratios, treating all images equally without considering their varying complexities. As a result of this approach, complex images often undergo excessive compression, leading to the loss of crucial information, while simpler images remain under-compressed, wasting valuable computational resources. These inefficiencies directly impact the performance of subsequent operations, such as the reconstruction and generation of images, where accurate and efficient representation plays a pivotal role.

AI 主導の画像モデリングの領域では、まだ十分に対処されていない重大な課題の 1 つは、画像コンテンツの複雑さに存在する多様性を効果的に説明できないことです。既存のトークン化方法は主に静的な圧縮率を採用しており、さまざまな複雑さを考慮せずにすべての画像を同等に扱います。このアプローチの結果、複雑な画像は過剰な圧縮を受けることが多く、重要な情報が失われる一方、単純な画像は圧縮が不十分なままとなり、貴重な計算リソースが無駄になります。これらの非効率性は、画像の再構成や生成など、正確で効率的な表現が極めて重要な役割を果たす後続の操作のパフォーマンスに直接影響します。

Current techniques for tokenizing images fall short in appropriately addressing the variation in complexity. Fixed ratio tokenization approaches, such as resizing images to standard sizes, fail to account for the varying content complexities. While Vision Transformers do adapt patch size dynamically, they rely on image input and lack the flexibility required for text-to-image applications. Other compression techniques, such as JPEG, are specifically designed for traditional media and lack optimization for deep learning-based tokenization. Recent work, such as ElasticTok, has explored random token length strategies but lacked consideration of the intrinsic content complexity during training time, leading to inefficiencies in quality and computational cost.

画像をトークン化する現在の技術は、複雑さの変化に適切に対処するには不十分です。画像のサイズを標準サイズに変更するなど、固定比率のトークン化アプローチでは、さまざまなコンテンツの複雑さを考慮できません。 Vision Transformer はパッチ サイズを動的に調整しますが、画像入力に依存しており、テキストから画像へのアプリケーションに必要な柔軟性がありません。 JPEG などの他の圧縮技術は、従来のメディア向けに特別に設計されており、深層学習ベースのトークン化のための最適化が欠けています。 ElasticTok などの最近の研究では、ランダムなトークン長戦略が検討されていますが、トレーニング時の本質的なコンテンツの複雑さが考慮されておらず、品質と計算コストの非効率につながっています。

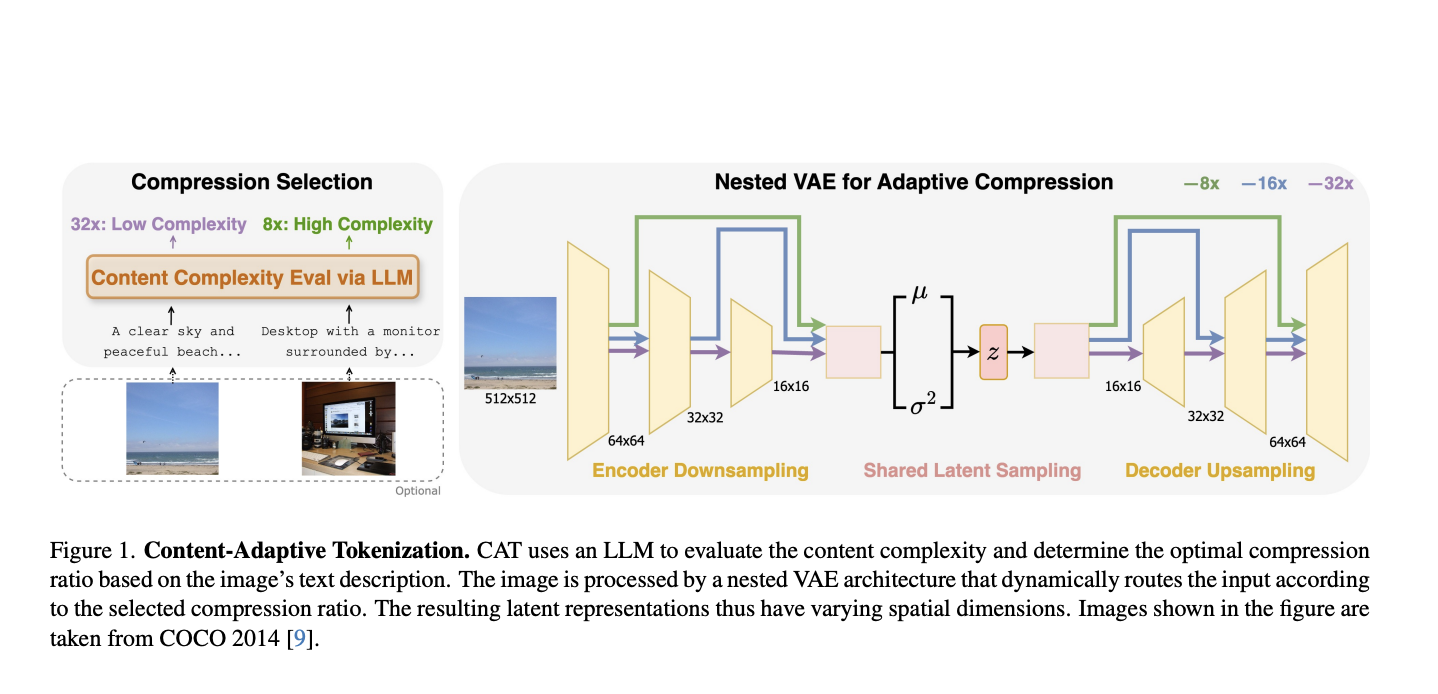

To address these limitations, researchers from Carnegie Mellon University and Meta have proposed Content-Adaptive Tokenization (CAT), a pioneering framework for content-aware image tokenization that introduces a dynamic approach to allocating representation capacity based on content complexity. This innovation enables large language models to assess the complexity of images from captions and perception-based queries while classifying images into three compression levels: 8x, 16x, and 32x. Furthermore, it utilizes a nested VAE architecture that generates variable-length latent features by dynamically routing intermediate outputs based on the complexity of the images. The adaptive design reduces training overhead and optimizes image representation quality to overcome the inefficiencies of fixed-ratio methods. Notably, CAT enables adaptive and efficient tokenization using text-based complexity analysis without requiring image inputs at inference.

これらの制限に対処するために、カーネギー メロン大学とメタの研究者は、コンテンツ アダプティブ トークン化 (CAT) を提案しました。これは、コンテンツの複雑さに基づいて表現容量を割り当てる動的なアプローチを導入した、コンテンツを認識した画像トークン化の先駆的なフレームワークです。このイノベーションにより、大規模な言語モデルで、画像を 8x、16x、32x の 3 つの圧縮レベルに分類しながら、キャプションや知覚ベースのクエリから画像の複雑さを評価できるようになります。さらに、ネストされた VAE アーキテクチャを利用し、画像の複雑さに基づいて中間出力を動的にルーティングすることで可変長の潜在特徴を生成します。適応型設計により、トレーニングのオーバーヘッドが削減され、画像表現の品質が最適化され、固定比率手法の非効率性が克服されます。特に、CAT は、推論時に画像入力を必要とせずに、テキストベースの複雑さ分析を使用して適応的かつ効率的なトークン化を可能にします。

CAT evaluates complexity with captions produced from LLMs that consider both semantic, visual, and perceptual features while determining compression ratios. Such a caption-based system is observed to be superior to traditional methods, including JPEG size and MSE in mimicking human perceived importance. The adaptive nested VAE design achieves this with channel-matched skip connections that dynamically alter latent space across varying compression levels. Shared parameterization guarantees consistency across scales, while training is performed by a combination of reconstruction error, perceptual loss (e.g., LPIPS), and adversarial loss to reach optimal performance. CAT was trained on a dataset of 380 million images and tested on the benchmarks of COCO, ImageNet, CelebA, and ChartQA, demonstrating its applicability to different image types.

CAT は、圧縮率を決定する際に、意味論的、視覚的、知覚的特徴の両方を考慮する LLM から生成されたキャプションの複雑さを評価します。このようなキャプションベースのシステムは、人間が認識する重要性を模倣する点で、JPEG サイズや MSE などの従来の方法よりも優れていることが観察されています。適応型ネスト型 VAE 設計は、さまざまな圧縮レベルにわたって潜在スペースを動的に変更するチャネル一致スキップ接続によってこれを実現します。共有パラメータ化によりスケール間の一貫性が保証され、トレーニングは最適なパフォーマンスに達するために再構成エラー、知覚損失 (LPIPS など)、および敵対的損失の組み合わせによって実行されます。 CAT は 3 億 8,000 万枚の画像のデータセットでトレーニングされ、COCO、ImageNet、CelebA、ChartQA のベンチマークでテストされ、さまざまな画像タイプへの適用性を実証しました。

This approach achieves highly significant performance improvements in both image reconstruction and generation by adapting compression to content complexity. For reconstruction tasks, it significantly improves the rFID, LPIPS, and PSNR metrics. It delivers a 12% quality improvement for the reconstruction of CelebA and a 39% enhancement for ChartQA, all while keeping the quality comparable to those of datasets such as COCO and ImageNet with fewer tokens and efficiency. For class-conditional ImageNet generation, CAT outperforms the fixed-ratio baselines with an FID of 4.56 and improves inference throughput by 18.5%. This adaptive tokenization framework serves as the new benchmark for further improvement.

このアプローチでは、コンテンツの複雑さに合わせて圧縮を調整することで、画像の再構成と生成の両方で非常に大幅なパフォーマンスの向上を実現します。再構成タスクの場合、rFID、LPIPS、PSNR メトリクスが大幅に改善されます。これにより、より少ないトークンと効率で COCO や ImageNet などのデータセットと同等の品質を維持しながら、CelebA の再構築では 12% の品質向上、ChartQA では 39% の品質向上が実現します。クラス条件付き ImageNet 生成の場合、CAT は FID 4.56 の固定比率ベースラインを上回り、推論スループットが 18.5% 向上します。この適応型トークン化フレームワークは、さらなる改善のための新しいベンチマークとして機能します。

CAT presents a novel approach to image tokenization by dynamically modulating compression levels based on the complexity of the content. It integrates LLM-based assessments with an adaptive nested VAE, eliminating persistent inefficiencies associated with fixed-ratio tokenization, thereby significantly improving performance in reconstruction and generation tasks. The adaptability and effectiveness of CAT make it a revolutionary asset in AI-oriented image modeling, with potential applications extending to video and multi-modal domains.

CAT は、コンテンツの複雑さに基づいて圧縮レベルを動的に調整することで、画像のトークン化に対する新しいアプローチを提供します。 LLM ベースの評価を適応型ネストされた VAE と統合し、固定比率のトークン化に伴う永続的な非効率性を排除し、それにより再構築および生成タスクのパフォーマンスを大幅に向上させます。 CAT の適応性と有効性により、CAT は AI 指向の画像モデリングにおける革新的な資産となり、潜在的なアプリケーションはビデオおよびマルチモーダル ドメインに拡張されます。

免責事項:info@kdj.com

提供される情報は取引に関するアドバイスではありません。 kdj.com は、この記事で提供される情報に基づいて行われた投資に対して一切の責任を負いません。暗号通貨は変動性が高いため、十分な調査を行った上で慎重に投資することを強くお勧めします。

このウェブサイトで使用されているコンテンツが著作権を侵害していると思われる場合は、直ちに当社 (info@kdj.com) までご連絡ください。速やかに削除させていただきます。