|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Carnegie Mellon University와 Meta의 연구원들은 콘텐츠 인식 이미지 토큰화를 위한 선구적인 프레임워크인 CAT(Content-Adaptive Tokenization)를 제안합니다.

In the realm of AI-driven image modeling, one of the critical challenges that have yet to be fully addressed is the inability to effectively account for the diversity present in image content complexity. Existing tokenization methods largely employ static compression ratios, treating all images equally without considering their varying complexities. As a result of this approach, complex images often undergo excessive compression, leading to the loss of crucial information, while simpler images remain under-compressed, wasting valuable computational resources. These inefficiencies directly impact the performance of subsequent operations, such as the reconstruction and generation of images, where accurate and efficient representation plays a pivotal role.

AI 기반 이미지 모델링 영역에서 아직 완전히 해결되지 않은 중요한 과제 중 하나는 이미지 콘텐츠 복잡성에 존재하는 다양성을 효과적으로 설명할 수 없다는 것입니다. 기존 토큰화 방법은 주로 정적 압축 비율을 사용하여 다양한 복잡성을 고려하지 않고 모든 이미지를 동일하게 처리합니다. 이러한 접근 방식의 결과로 복잡한 이미지는 종종 과도하게 압축되어 중요한 정보가 손실되는 반면, 단순한 이미지는 압축되지 않은 상태로 남아 귀중한 계산 리소스를 낭비합니다. 이러한 비효율성은 정확하고 효율적인 표현이 중추적인 역할을 하는 이미지 재구성 및 생성과 같은 후속 작업의 성능에 직접적인 영향을 미칩니다.

Current techniques for tokenizing images fall short in appropriately addressing the variation in complexity. Fixed ratio tokenization approaches, such as resizing images to standard sizes, fail to account for the varying content complexities. While Vision Transformers do adapt patch size dynamically, they rely on image input and lack the flexibility required for text-to-image applications. Other compression techniques, such as JPEG, are specifically designed for traditional media and lack optimization for deep learning-based tokenization. Recent work, such as ElasticTok, has explored random token length strategies but lacked consideration of the intrinsic content complexity during training time, leading to inefficiencies in quality and computational cost.

이미지를 토큰화하는 현재 기술은 복잡성의 변화를 적절하게 해결하는 데 부족합니다. 이미지 크기를 표준 크기로 조정하는 것과 같은 고정 비율 토큰화 접근 방식은 다양한 콘텐츠 복잡성을 설명하지 못합니다. Vision Transformers는 패치 크기를 동적으로 조정하지만 이미지 입력에 의존하고 텍스트-이미지 애플리케이션에 필요한 유연성이 부족합니다. JPEG와 같은 다른 압축 기술은 기존 미디어용으로 특별히 설계되었으며 딥러닝 기반 토큰화에 대한 최적화가 부족합니다. ElasticTok과 같은 최근 연구에서는 무작위 토큰 길이 전략을 탐색했지만 훈련 시간 동안 본질적인 콘텐츠 복잡성을 고려하지 않아 품질과 계산 비용이 비효율적으로 발생했습니다.

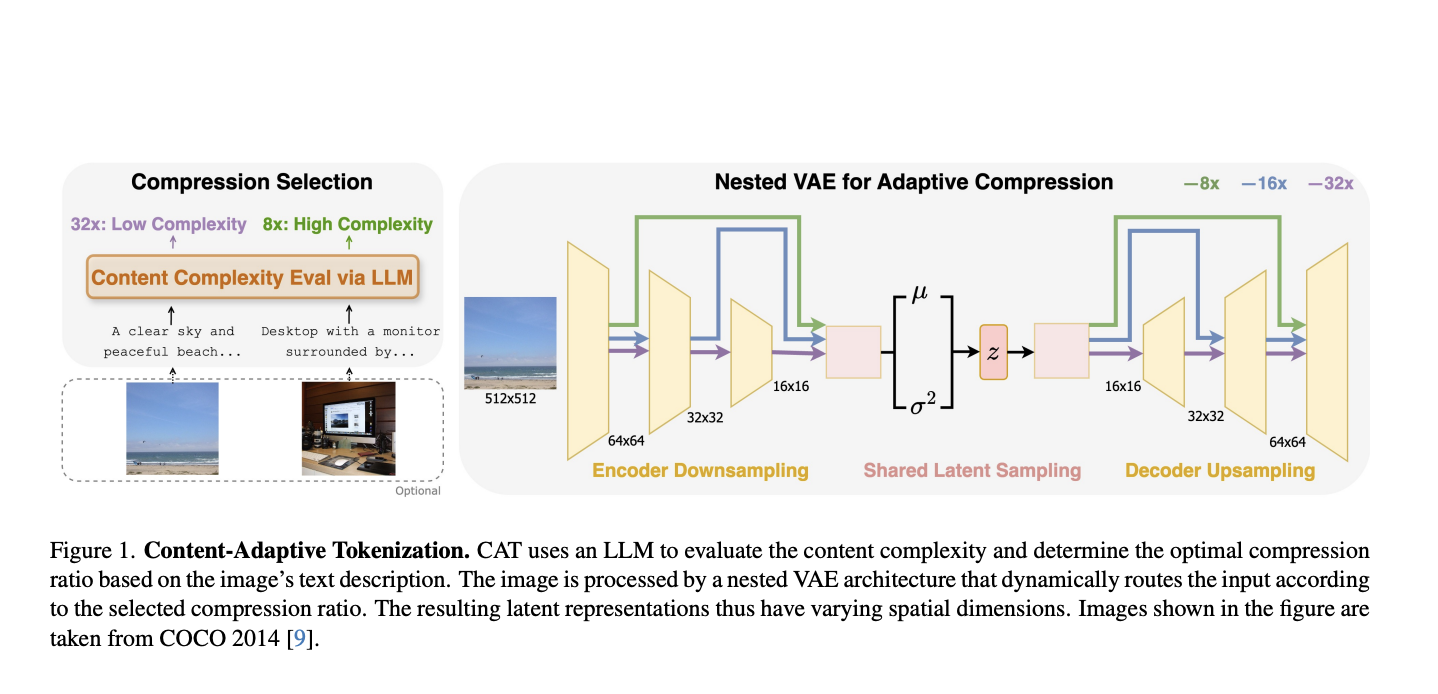

To address these limitations, researchers from Carnegie Mellon University and Meta have proposed Content-Adaptive Tokenization (CAT), a pioneering framework for content-aware image tokenization that introduces a dynamic approach to allocating representation capacity based on content complexity. This innovation enables large language models to assess the complexity of images from captions and perception-based queries while classifying images into three compression levels: 8x, 16x, and 32x. Furthermore, it utilizes a nested VAE architecture that generates variable-length latent features by dynamically routing intermediate outputs based on the complexity of the images. The adaptive design reduces training overhead and optimizes image representation quality to overcome the inefficiencies of fixed-ratio methods. Notably, CAT enables adaptive and efficient tokenization using text-based complexity analysis without requiring image inputs at inference.

이러한 한계를 해결하기 위해 Carnegie Mellon University와 Meta의 연구원들은 콘텐츠 복잡성을 기반으로 표현 용량을 할당하는 동적 접근 방식을 도입하는 콘텐츠 인식 이미지 토큰화를 위한 선구적인 프레임워크인 CAT(Content-Adaptive Tokenization)를 제안했습니다. 이러한 혁신을 통해 대규모 언어 모델은 캡션 및 인식 기반 쿼리에서 이미지의 복잡성을 평가하는 동시에 이미지를 8x, 16x 및 32x의 세 가지 압축 수준으로 분류할 수 있습니다. 또한 이미지의 복잡성을 기반으로 중간 출력을 동적으로 라우팅하여 가변 길이의 잠재 기능을 생성하는 중첩된 VAE 아키텍처를 활용합니다. 적응형 디자인은 교육 오버헤드를 줄이고 이미지 표현 품질을 최적화하여 고정 비율 방법의 비효율성을 극복합니다. 특히 CAT는 추론 시 이미지 입력을 요구하지 않고 텍스트 기반 복잡성 분석을 사용하여 적응적이고 효율적인 토큰화를 가능하게 합니다.

CAT evaluates complexity with captions produced from LLMs that consider both semantic, visual, and perceptual features while determining compression ratios. Such a caption-based system is observed to be superior to traditional methods, including JPEG size and MSE in mimicking human perceived importance. The adaptive nested VAE design achieves this with channel-matched skip connections that dynamically alter latent space across varying compression levels. Shared parameterization guarantees consistency across scales, while training is performed by a combination of reconstruction error, perceptual loss (e.g., LPIPS), and adversarial loss to reach optimal performance. CAT was trained on a dataset of 380 million images and tested on the benchmarks of COCO, ImageNet, CelebA, and ChartQA, demonstrating its applicability to different image types.

CAT는 압축 비율을 결정하는 동시에 의미론적, 시각적, 지각적 특징을 모두 고려하는 LLM에서 생성된 캡션의 복잡성을 평가합니다. 이러한 캡션 기반 시스템은 인간이 인지하는 중요성을 모방하는 데 있어 JPEG 크기 및 MSE를 포함한 기존 방법보다 우수한 것으로 관찰되었습니다. 적응형 중첩 VAE 설계는 다양한 압축 수준에 걸쳐 잠재 공간을 동적으로 변경하는 채널 일치 건너뛰기 연결을 통해 이를 달성합니다. 공유 매개변수화는 규모 전반에 걸쳐 일관성을 보장하는 동시에 재구성 오류, 지각 손실(예: LPIPS) 및 적대적 손실을 조합하여 훈련을 수행하여 최적의 성능에 도달합니다. CAT는 3억 8천만 개의 이미지 데이터 세트에 대해 교육을 받았고 COCO, ImageNet, CelebA 및 ChartQA의 벤치마크에서 테스트되어 다양한 이미지 유형에 대한 적용 가능성을 입증했습니다.

This approach achieves highly significant performance improvements in both image reconstruction and generation by adapting compression to content complexity. For reconstruction tasks, it significantly improves the rFID, LPIPS, and PSNR metrics. It delivers a 12% quality improvement for the reconstruction of CelebA and a 39% enhancement for ChartQA, all while keeping the quality comparable to those of datasets such as COCO and ImageNet with fewer tokens and efficiency. For class-conditional ImageNet generation, CAT outperforms the fixed-ratio baselines with an FID of 4.56 and improves inference throughput by 18.5%. This adaptive tokenization framework serves as the new benchmark for further improvement.

이 접근 방식은 압축을 콘텐츠 복잡성에 맞게 조정하여 이미지 재구성과 생성 모두에서 매우 중요한 성능 향상을 달성합니다. 재구성 작업의 경우 rFID, LPIPS 및 PSNR 지표가 크게 향상됩니다. CelebA 재구성의 경우 12% 품질 향상, ChartQA의 경우 39% 향상을 제공하는 동시에 더 적은 토큰과 효율성으로 COCO 및 ImageNet과 같은 데이터 세트의 품질과 비슷한 품질을 유지합니다. 클래스 조건부 ImageNet 생성의 경우 CAT는 FID 4.56으로 고정 비율 기준보다 성능이 뛰어나며 추론 처리량을 18.5% 향상합니다. 이 적응형 토큰화 프레임워크는 추가 개선을 위한 새로운 벤치마크 역할을 합니다.

CAT presents a novel approach to image tokenization by dynamically modulating compression levels based on the complexity of the content. It integrates LLM-based assessments with an adaptive nested VAE, eliminating persistent inefficiencies associated with fixed-ratio tokenization, thereby significantly improving performance in reconstruction and generation tasks. The adaptability and effectiveness of CAT make it a revolutionary asset in AI-oriented image modeling, with potential applications extending to video and multi-modal domains.

CAT는 콘텐츠의 복잡성에 따라 압축 수준을 동적으로 조정하여 이미지 토큰화에 대한 새로운 접근 방식을 제시합니다. LLM 기반 평가를 적응형 중첩 VAE와 통합하여 고정 비율 토큰화와 관련된 지속적인 비효율성을 제거함으로써 재구성 및 생성 작업의 성능을 크게 향상시킵니다. CAT의 적응성과 효율성은 AI 중심 이미지 모델링의 혁신적인 자산이 되며 잠재적인 애플리케이션이 비디오 및 다중 모드 도메인으로 확장됩니다.

부인 성명:info@kdj.com

제공된 정보는 거래 조언이 아닙니다. kdj.com은 이 기사에 제공된 정보를 기반으로 이루어진 투자에 대해 어떠한 책임도 지지 않습니다. 암호화폐는 변동성이 매우 높으므로 철저한 조사 후 신중하게 투자하는 것이 좋습니다!

본 웹사이트에 사용된 내용이 귀하의 저작권을 침해한다고 판단되는 경우, 즉시 당사(info@kdj.com)로 연락주시면 즉시 삭제하도록 하겠습니다.