|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

Tokenisation adaptative au contenu (CAT) : un cadre pionnier pour la tokenisation d'images sensible au contenu

Jan 11, 2025 at 09:03 am

Des chercheurs de l'Université Carnegie Mellon et Meta proposent la tokenisation adaptative au contenu (CAT), un cadre pionnier pour la tokenisation d'images sensible au contenu.

In the realm of AI-driven image modeling, one of the critical challenges that have yet to be fully addressed is the inability to effectively account for the diversity present in image content complexity. Existing tokenization methods largely employ static compression ratios, treating all images equally without considering their varying complexities. As a result of this approach, complex images often undergo excessive compression, leading to the loss of crucial information, while simpler images remain under-compressed, wasting valuable computational resources. These inefficiencies directly impact the performance of subsequent operations, such as the reconstruction and generation of images, where accurate and efficient representation plays a pivotal role.

Dans le domaine de la modélisation d’images basée sur l’IA, l’un des défis majeurs qui n’a pas encore été pleinement résolu est l’incapacité de prendre en compte efficacement la diversité présente dans la complexité du contenu des images. Les méthodes de tokenisation existantes utilisent en grande partie des taux de compression statiques, traitant toutes les images de la même manière sans tenir compte de leurs différentes complexités. En raison de cette approche, les images complexes subissent souvent une compression excessive, entraînant la perte d’informations cruciales, tandis que les images plus simples restent sous-compressées, gaspillant ainsi de précieuses ressources informatiques. Ces inefficacités ont un impact direct sur les performances des opérations ultérieures, telles que la reconstruction et la génération d'images, où une représentation précise et efficace joue un rôle central.

Current techniques for tokenizing images fall short in appropriately addressing the variation in complexity. Fixed ratio tokenization approaches, such as resizing images to standard sizes, fail to account for the varying content complexities. While Vision Transformers do adapt patch size dynamically, they rely on image input and lack the flexibility required for text-to-image applications. Other compression techniques, such as JPEG, are specifically designed for traditional media and lack optimization for deep learning-based tokenization. Recent work, such as ElasticTok, has explored random token length strategies but lacked consideration of the intrinsic content complexity during training time, leading to inefficiencies in quality and computational cost.

Les techniques actuelles de tokenisation des images ne parviennent pas à répondre de manière appropriée à la variation de complexité. Les approches de tokenisation à rapport fixe, telles que le redimensionnement des images à des tailles standard, ne tiennent pas compte des différentes complexités du contenu. Bien que les Vision Transformers adaptent la taille des patchs de manière dynamique, ils s'appuient sur la saisie d'images et n'ont pas la flexibilité requise pour les applications texte-image. D'autres techniques de compression, telles que JPEG, sont spécifiquement conçues pour les médias traditionnels et manquent d'optimisation pour la tokenisation basée sur l'apprentissage profond. Des travaux récents, tels qu'ElasticTok, ont exploré des stratégies de longueur de jeton aléatoire, mais n'ont pas pris en compte la complexité intrinsèque du contenu pendant la période de formation, ce qui a entraîné des inefficacités en termes de qualité et de coût de calcul.

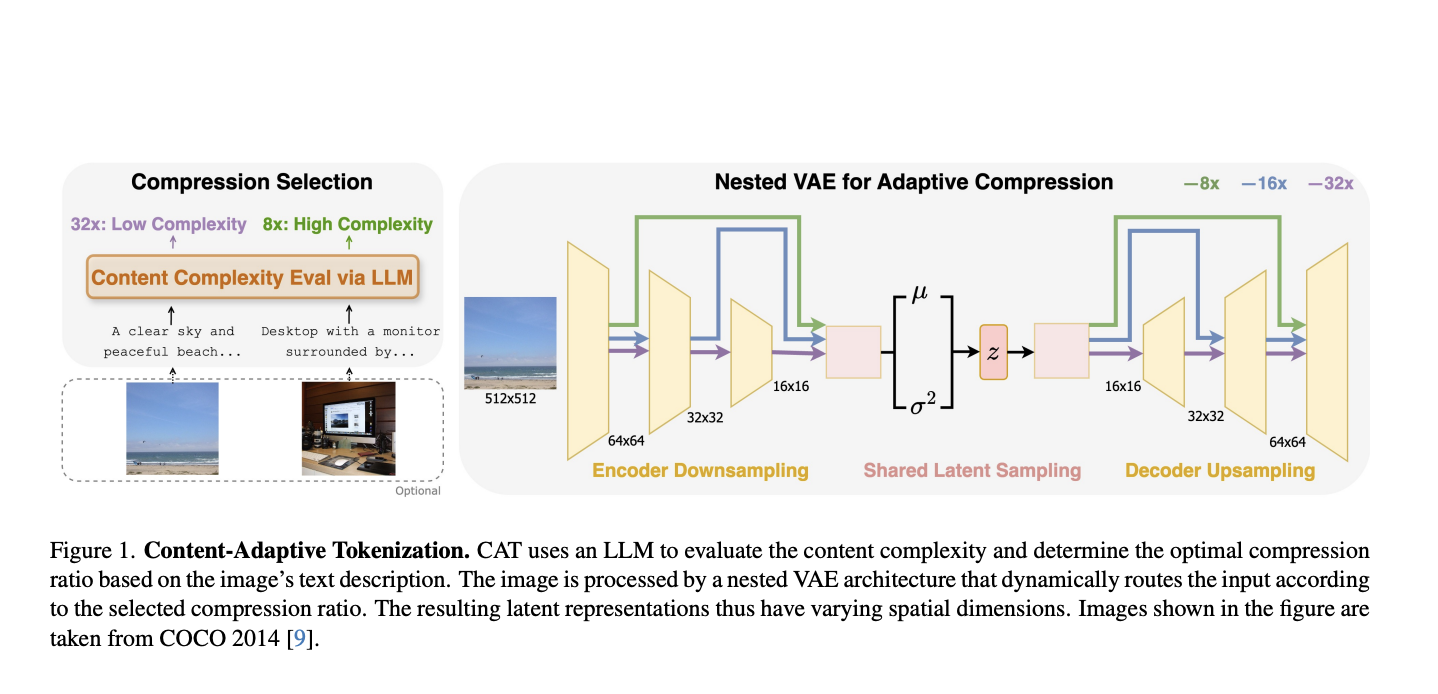

To address these limitations, researchers from Carnegie Mellon University and Meta have proposed Content-Adaptive Tokenization (CAT), a pioneering framework for content-aware image tokenization that introduces a dynamic approach to allocating representation capacity based on content complexity. This innovation enables large language models to assess the complexity of images from captions and perception-based queries while classifying images into three compression levels: 8x, 16x, and 32x. Furthermore, it utilizes a nested VAE architecture that generates variable-length latent features by dynamically routing intermediate outputs based on the complexity of the images. The adaptive design reduces training overhead and optimizes image representation quality to overcome the inefficiencies of fixed-ratio methods. Notably, CAT enables adaptive and efficient tokenization using text-based complexity analysis without requiring image inputs at inference.

Pour remédier à ces limitations, des chercheurs de l'Université Carnegie Mellon et Meta ont proposé la tokenisation adaptative au contenu (CAT), un cadre pionnier pour la tokenisation d'images sensible au contenu qui introduit une approche dynamique pour allouer la capacité de représentation en fonction de la complexité du contenu. Cette innovation permet à de grands modèles de langage d'évaluer la complexité des images à partir de légendes et de requêtes basées sur la perception tout en classant les images en trois niveaux de compression : 8x, 16x et 32x. De plus, il utilise une architecture VAE imbriquée qui génère des caractéristiques latentes de longueur variable en acheminant dynamiquement les sorties intermédiaires en fonction de la complexité des images. La conception adaptative réduit les frais de formation et optimise la qualité de la représentation des images pour surmonter les inefficacités des méthodes à rapport fixe. Notamment, CAT permet une tokenisation adaptative et efficace à l’aide d’une analyse de complexité basée sur du texte sans nécessiter d’entrées d’image lors de l’inférence.

CAT evaluates complexity with captions produced from LLMs that consider both semantic, visual, and perceptual features while determining compression ratios. Such a caption-based system is observed to be superior to traditional methods, including JPEG size and MSE in mimicking human perceived importance. The adaptive nested VAE design achieves this with channel-matched skip connections that dynamically alter latent space across varying compression levels. Shared parameterization guarantees consistency across scales, while training is performed by a combination of reconstruction error, perceptual loss (e.g., LPIPS), and adversarial loss to reach optimal performance. CAT was trained on a dataset of 380 million images and tested on the benchmarks of COCO, ImageNet, CelebA, and ChartQA, demonstrating its applicability to different image types.

CAT évalue la complexité avec des sous-titres produits à partir de LLM qui prennent en compte à la fois les caractéristiques sémantiques, visuelles et perceptuelles tout en déterminant les taux de compression. Un tel système basé sur les légendes s'avère supérieur aux méthodes traditionnelles, notamment la taille JPEG et le MSE, pour imiter l'importance perçue par l'homme. La conception VAE imbriquée adaptative y parvient grâce à des connexions de saut adaptées aux canaux qui modifient dynamiquement l'espace latent à travers différents niveaux de compression. Le paramétrage partagé garantit la cohérence entre les échelles, tandis que la formation est effectuée par une combinaison d'erreur de reconstruction, de perte de perception (par exemple, LPIPS) et de perte contradictoire pour atteindre des performances optimales. CAT a été formé sur un ensemble de données de 380 millions d'images et testé sur les benchmarks de COCO, ImageNet, CelebA et ChartQA, démontrant son applicabilité à différents types d'images.

This approach achieves highly significant performance improvements in both image reconstruction and generation by adapting compression to content complexity. For reconstruction tasks, it significantly improves the rFID, LPIPS, and PSNR metrics. It delivers a 12% quality improvement for the reconstruction of CelebA and a 39% enhancement for ChartQA, all while keeping the quality comparable to those of datasets such as COCO and ImageNet with fewer tokens and efficiency. For class-conditional ImageNet generation, CAT outperforms the fixed-ratio baselines with an FID of 4.56 and improves inference throughput by 18.5%. This adaptive tokenization framework serves as the new benchmark for further improvement.

Cette approche permet d'obtenir des améliorations de performances très significatives dans la reconstruction et la génération d'images en adaptant la compression à la complexité du contenu. Pour les tâches de reconstruction, il améliore considérablement les métriques rFID, LPIPS et PSNR. Il offre une amélioration de la qualité de 12 % pour la reconstruction de CelebA et de 39 % pour ChartQA, tout en conservant une qualité comparable à celle d'ensembles de données tels que COCO et ImageNet avec moins de jetons et d'efficacité. Pour la génération ImageNet conditionnelle à la classe, CAT surpasse les lignes de base à rapport fixe avec un FID de 4,56 et améliore le débit d'inférence de 18,5 %. Ce cadre de tokenisation adaptative sert de nouvelle référence pour de nouvelles améliorations.

CAT presents a novel approach to image tokenization by dynamically modulating compression levels based on the complexity of the content. It integrates LLM-based assessments with an adaptive nested VAE, eliminating persistent inefficiencies associated with fixed-ratio tokenization, thereby significantly improving performance in reconstruction and generation tasks. The adaptability and effectiveness of CAT make it a revolutionary asset in AI-oriented image modeling, with potential applications extending to video and multi-modal domains.

CAT présente une nouvelle approche de la tokenisation d'images en modulant dynamiquement les niveaux de compression en fonction de la complexité du contenu. Il intègre des évaluations basées sur LLM avec un VAE imbriqué adaptatif, éliminant les inefficacités persistantes associées à la tokenisation à rapport fixe, améliorant ainsi considérablement les performances des tâches de reconstruction et de génération. L'adaptabilité et l'efficacité de la TAO en font un atout révolutionnaire dans la modélisation d'images orientée IA, avec des applications potentielles s'étendant aux domaines vidéo et multimodaux.

Clause de non-responsabilité:info@kdj.com

Les informations fournies ne constituent pas des conseils commerciaux. kdj.com n’assume aucune responsabilité pour les investissements effectués sur la base des informations fournies dans cet article. Les crypto-monnaies sont très volatiles et il est fortement recommandé d’investir avec prudence après une recherche approfondie!

Si vous pensez que le contenu utilisé sur ce site Web porte atteinte à vos droits d’auteur, veuillez nous contacter immédiatement (info@kdj.com) et nous le supprimerons dans les plus brefs délais.

-

-

-

-

-

- Le premier ETF XRP au monde, nommé XRPH11, a commencé à négocier à la Bourse B3 du Brésil

- Apr 26, 2025 at 05:30 pm

- Le premier ETF XRP au monde, nommé XRPH11, a commencé à négocier à la Bourse B3 du Brésil le 25 avril 2025. Émis par Hashdex, le Hashdex XRP ETF se concentre sur la fourniture d'une exposition directe et indirecte à XRP pour les investisseurs institutionnels.

-

- Prix du réseau PI (PI) aujourd'hui

- Apr 26, 2025 at 05:30 pm

- PI Network (PI) se négocie à 0,6513 $.

-

- Élargit le bit de ses ambitions ETF au-delà

- Apr 26, 2025 at 05:25 pm

- Au fur et à mesure que les marchés cryptographiques se réchauffent et que l'intérêt institutionnel augmente, le positionnement se positionne à l'avant-garde d'une nouvelle vague potentielle de fonds négociés en échange d'Altcoin (ETF).

-

-

![Le trading est de suivre [Revue vidéo] Les commandes de pétrole brut Bitcoin Gold font des bénéfices! Le trading est de suivre [Revue vidéo] Les commandes de pétrole brut Bitcoin Gold font des bénéfices!](/uploads/2025/04/26/cryptocurrencies-news/videos/trading-follow-review-video-gold-bitcoin-crude-oil-profits/image-1.webp)