|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

고급 추론 기능에도 불구하고 최신 LLM은 관계를 해독할 때 목표를 놓치는 경우가 많습니다. 이 기사에서는 이해력 및 생성과 같은 작업 전반에 걸쳐 LLM에 영향을 미치는 함정인 반전 저주를 탐구합니다.

Large Language Models (LLMs) are renowned for their advanced reasoning capabilities, enabling them to perform a wide range of tasks, from natural language processing to code generation. However, despite their strengths, LLMs often exhibit a weakness in deciphering relationships, particularly when dealing with inverses. This phenomenon, termed the “reversal curse,” affects LLMs across various tasks, including comprehension and generation.

LLM(대형 언어 모델)은 자연어 처리부터 코드 생성까지 광범위한 작업을 수행할 수 있는 고급 추론 기능으로 유명합니다. 그러나 이러한 장점에도 불구하고 LLM은 특히 역관계를 다룰 때 관계를 해독하는 데 약점을 보이는 경우가 많습니다. "역전 저주"라고 불리는 이 현상은 이해력과 생성을 포함한 다양한 작업 전반에 걸쳐 LLM에 영향을 미칩니다.

To understand the underlying issue, let’s consider a scenario with two entities, denoted as a and b, connected by their relation R and its inverse. LLMs excel at handling sequences such as “aRb,” where a is related to b by relation R. For instance, an LLM can quickly answer the question, “Who is the mother of Tom Cruise?” when asked. However, LLMs struggle with the inverse relation, denoted as R inverse. In our example, if we ask an LLM, “Who is Mary Lee Pfeiffer’s son?” it is more likely to hallucinate and falter, despite already knowing the relationship between Tom Cruise and Mary Lee Pfeiffer.

근본적인 문제를 이해하기 위해 a와 b로 표시된 두 엔터티가 관계 R과 역관계로 연결된 시나리오를 고려해 보겠습니다. LLM은 a가 관계 R로 b와 관련되어 있는 "aRb"와 같은 시퀀스를 처리하는 데 탁월합니다. 예를 들어 LLM은 "Tom Cruise의 어머니는 누구입니까?"라는 질문에 신속하게 답할 수 있습니다. 물었을 때. 그러나 LLM은 R 역(R inverse)으로 표시되는 역 관계로 인해 어려움을 겪습니다. 이 예에서 LLM에게 "Mary Lee Pfeiffer의 아들은 누구입니까?"라고 묻는다면, Tom Cruise와 Mary Lee Pfeiffer의 관계를 이미 알고 있음에도 불구하고 환각에 빠지고 흔들릴 가능성이 더 높습니다.

This reversal curse is a pitfall that affects LLMs in a variety of tasks. In a recent study, researchers from the Renmin University of China brought this phenomenon to the attention of the research community, shedding light on its probable causes and suggesting potential mitigation strategies. They identify the Training Objective Function as one of the key factors influencing the extent of the reversal curse.

이 반전 저주는 다양한 작업에서 LLM에 영향을 미치는 함정입니다. 최근 연구에서 중국 인민대학교 연구자들은 이 현상을 연구계의 주목을 받아 가능한 원인을 밝히고 잠재적인 완화 전략을 제안했습니다. 그들은 훈련 목표 기능을 역전 저주의 정도에 영향을 미치는 핵심 요소 중 하나로 식별합니다.

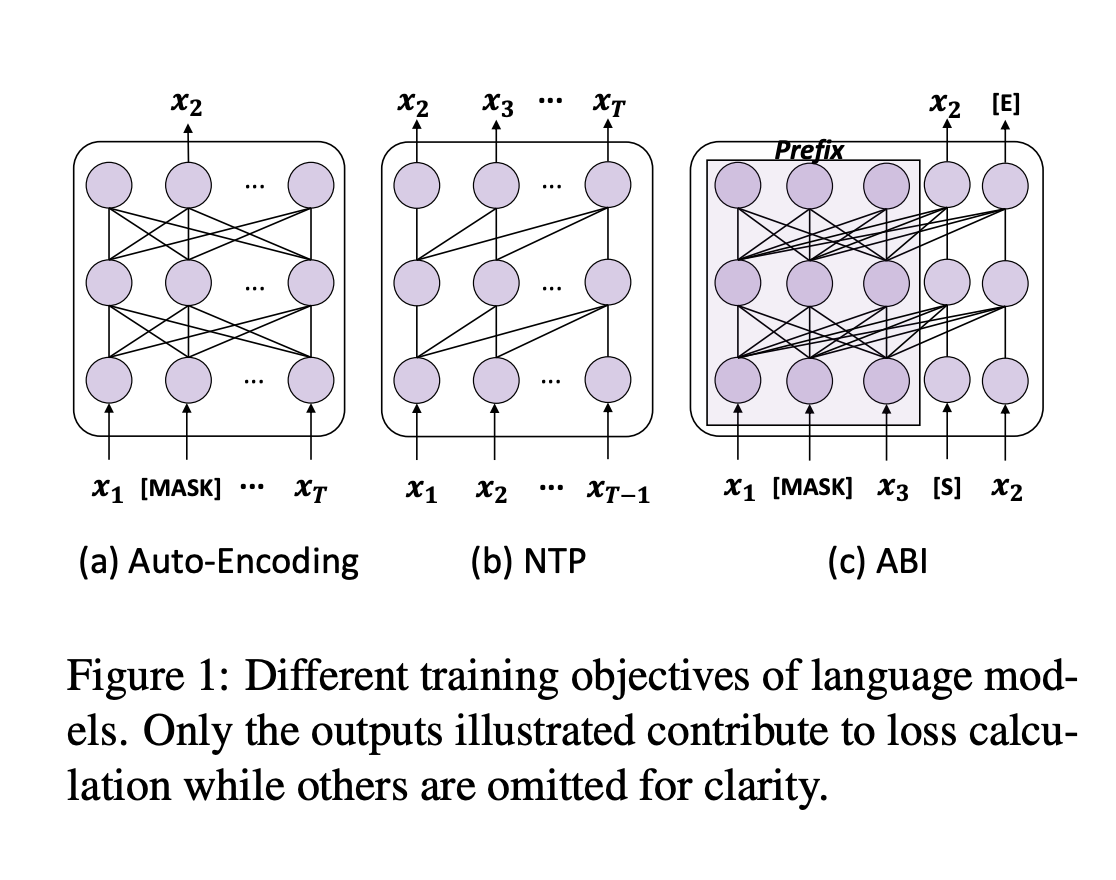

To fully grasp the reversal curse, we must first understand the training process of LLMs. Next-token prediction (NTP) is the dominant pre-training objective for current large language models, such as GPT and Llama. In models like GPT and Llama, the attention masks during training depend on the preceding tokens, meaning each token focuses solely on its prior context. This makes it impossible to account for subsequent tokens. As a result, if a occurs before b in the training corpus, the model maximizes the probability of b given a over the likelihood of a given b. Therefore, there is no guarantee that LLMs can provide a high probability for a when presented with b. In contrast, GLM models are pre-trained with autoregressive blank in-filling objectives, where the masked token controls both preceding and succeeding tokens, making them more robust to the reversal curse.

역전의 저주를 완전히 이해하려면 먼저 LLM의 교육 과정을 이해해야 합니다. NTP(다음 토큰 예측)는 GPT 및 Llama와 같은 현재 대규모 언어 모델의 주요 사전 학습 목표입니다. GPT 및 Llama와 같은 모델에서 훈련 중 주의 마스크는 이전 토큰에 따라 달라집니다. 즉, 각 토큰은 이전 컨텍스트에만 집중합니다. 이로 인해 후속 토큰을 설명하는 것이 불가능해집니다. 결과적으로 훈련 코퍼스에서 a가 b보다 먼저 발생하면 모델은 주어진 b의 가능성보다 주어진 a의 확률을 최대화합니다. 따라서 LLM이 b와 함께 제시될 때 a에 대해 높은 확률을 제공할 수 있다는 보장은 없습니다. 대조적으로, GLM 모델은 마스크된 토큰이 이전 및 후속 토큰을 모두 제어하여 역전 저주에 더욱 강력하게 만드는 자동 회귀 공백 채우기 목표로 사전 훈련되었습니다.

The authors put this hypothesis to the test by fine-tuning GLMs on “Name to Description” data, using fictitious names and feeding descriptions to retrieve information about the entities. The GLMs achieved approximately 80% accuracy on this task, while Llama’s accuracy was 0%.

저자는 가상의 이름을 사용하고 설명을 제공하여 개체에 대한 정보를 검색하는 "이름에서 설명" 데이터에 대한 GLM을 미세 조정하여 이 가설을 테스트했습니다. GLM은 이 작업에서 약 80%의 정확도를 달성한 반면 Llama의 정확도는 0%였습니다.

To address this issue, the authors propose a method that adapts the training objective of LLMs to something similar to ABI. They fine-tuned models using Bidirectional Causal Language Model Optimization (BICO) to reverse-engineer mathematical tasks and translation problems. BICO adopts an autoregressive blank infilling objective, similar to GLM, but with tailored modifications designed explicitly for causal language models. The authors introduced rotary (relative) position embeddings and modified the attention function to make it bidirectional. This fine-tuning method improved the model’s accuracy in reverse translation and mathematical problem-solving tasks.

이 문제를 해결하기 위해 저자는 LLM의 교육 목표를 ABI와 유사한 것에 적용하는 방법을 제안합니다. BICO(양방향 인과 언어 모델 최적화)를 사용하여 모델을 미세 조정하여 수학적 작업과 번역 문제를 리버스 엔지니어링했습니다. BICO는 GLM과 유사하지만 인과 언어 모델을 위해 명시적으로 설계된 맞춤형 수정이 포함된 자동 회귀 공백 채우기 목표를 채택합니다. 저자는 회전(상대) 위치 임베딩을 도입하고 주의 기능을 수정하여 양방향으로 만들었습니다. 이 미세 조정 방법은 역변환 및 수학적 문제 해결 작업에서 모델의 정확도를 향상시켰습니다.

In conclusion, the authors analyze the reversal curse and propose a fine-tuning strategy to mitigate this pitfall. By adopting a causal language model with an ABI-like objective, this study sheds light on the reversal underperformance of LLMs. This work could be further expanded to examine the impact of advanced techniques, such as RLHF, on the reversal curse.

결론적으로 저자는 반전 저주를 분석하고 이러한 함정을 완화하기 위한 미세 조정 전략을 제안합니다. ABI와 유사한 목표를 가진 인과 언어 모델을 채택함으로써 이 연구는 LLM의 역전 성과가 저조한 점을 밝힙니다. 이 작업은 RLHF와 같은 고급 기술이 반전 저주에 미치는 영향을 조사하기 위해 더욱 확장될 수 있습니다.

Don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. If you like our work, you will love our newsletter. Don’t Forget to join our 55k+ ML SubReddit.

Twitter에서 우리를 팔로우하고 Telegram 채널과 LinkedIn 그룹에 가입하는 것을 잊지 마세요. 저희 작업이 마음에 드신다면 저희 뉴스레터도 마음에 드실 것입니다. 55,000개 이상의 ML SubReddit에 가입하는 것을 잊지 마세요.

부인 성명:info@kdj.com

제공된 정보는 거래 조언이 아닙니다. kdj.com은 이 기사에 제공된 정보를 기반으로 이루어진 투자에 대해 어떠한 책임도 지지 않습니다. 암호화폐는 변동성이 매우 높으므로 철저한 조사 후 신중하게 투자하는 것이 좋습니다!

본 웹사이트에 사용된 내용이 귀하의 저작권을 침해한다고 판단되는 경우, 즉시 당사(info@kdj.com)로 연락주시면 즉시 삭제하도록 하겠습니다.

![[4K 60fps] Prisma by novichokk (1 코인) [4K 60fps] Prisma by novichokk (1 코인)](/uploads/2025/10/14/cryptocurrencies-news/videos/k-fps-prisma-novichokk-coin/68ee49804ba00_image_500_375.webp)