|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

最新の LLM は高度な推論機能にもかかわらず、関係を解読する際に的を外してしまうことがよくあります。この記事では、理解や生成などのタスク全体で LLM に影響を与える落とし穴である、逆転の呪いについて考察します。

Large Language Models (LLMs) are renowned for their advanced reasoning capabilities, enabling them to perform a wide range of tasks, from natural language processing to code generation. However, despite their strengths, LLMs often exhibit a weakness in deciphering relationships, particularly when dealing with inverses. This phenomenon, termed the “reversal curse,” affects LLMs across various tasks, including comprehension and generation.

大規模言語モデル (LLM) は高度な推論機能で知られており、自然言語処理からコード生成まで幅広いタスクを実行できます。ただし、LLM はその長所にもかかわらず、関係の解読において、特に逆を扱う場合に弱点を示すことがよくあります。 「逆転の呪い」と呼ばれるこの現象は、理解や生成などのさまざまなタスクにわたって LLM に影響を与えます。

To understand the underlying issue, let’s consider a scenario with two entities, denoted as a and b, connected by their relation R and its inverse. LLMs excel at handling sequences such as “aRb,” where a is related to b by relation R. For instance, an LLM can quickly answer the question, “Who is the mother of Tom Cruise?” when asked. However, LLMs struggle with the inverse relation, denoted as R inverse. In our example, if we ask an LLM, “Who is Mary Lee Pfeiffer’s son?” it is more likely to hallucinate and falter, despite already knowing the relationship between Tom Cruise and Mary Lee Pfeiffer.

根本的な問題を理解するために、a と b で示される 2 つのエンティティが、それらの関係 R とその逆によって接続されているシナリオを考えてみましょう。 LLM は、a が関係 R によって b に関連付けられる「aRb」などのシーケンスの処理に優れています。たとえば、LLM は、「トム クルーズの母親は誰ですか?」という質問にすぐに答えることができます。と聞かれると。ただし、LLM は、R 逆数と呼ばれる逆関係に苦労します。この例では、LLM に「メアリー・リー・ファイファーの息子は誰ですか?」と尋ねるとします。トム・クルーズとメアリー・リー・ファイファーの関係をすでに知っているにもかかわらず、幻覚を起こしたり、怯えたりする可能性が高くなります。

This reversal curse is a pitfall that affects LLMs in a variety of tasks. In a recent study, researchers from the Renmin University of China brought this phenomenon to the attention of the research community, shedding light on its probable causes and suggesting potential mitigation strategies. They identify the Training Objective Function as one of the key factors influencing the extent of the reversal curse.

この逆転の呪いは、さまざまなタスクにおいて LLM に影響を与える落とし穴です。最近の研究で、中国人民大学の研究者らはこの現象を研究コミュニティの注目を集め、考えられる原因を明らかにし、潜在的な緩和戦略を提案しました。彼らは、トレーニングの目的関数が、逆転の呪いの範囲に影響を与える重要な要素の 1 つであると特定しています。

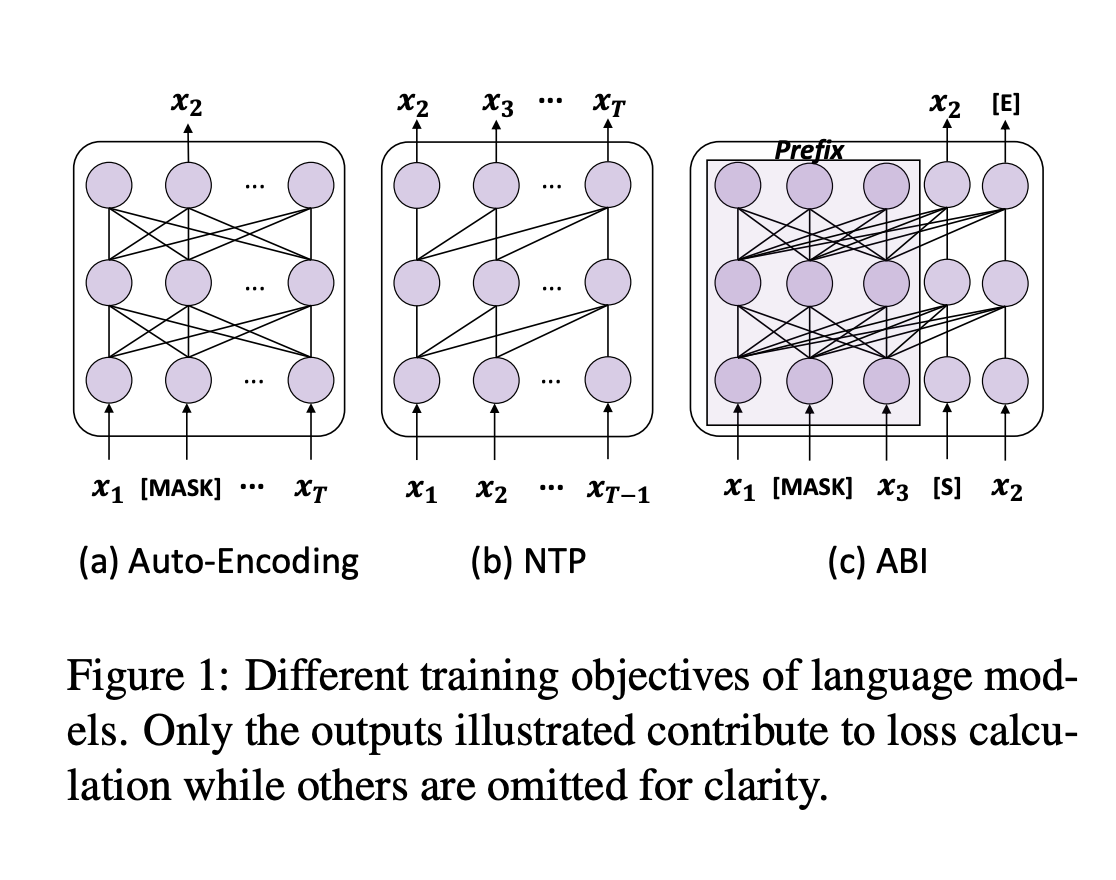

To fully grasp the reversal curse, we must first understand the training process of LLMs. Next-token prediction (NTP) is the dominant pre-training objective for current large language models, such as GPT and Llama. In models like GPT and Llama, the attention masks during training depend on the preceding tokens, meaning each token focuses solely on its prior context. This makes it impossible to account for subsequent tokens. As a result, if a occurs before b in the training corpus, the model maximizes the probability of b given a over the likelihood of a given b. Therefore, there is no guarantee that LLMs can provide a high probability for a when presented with b. In contrast, GLM models are pre-trained with autoregressive blank in-filling objectives, where the masked token controls both preceding and succeeding tokens, making them more robust to the reversal curse.

逆転の呪いを完全に理解するには、まず LLM のトレーニング プロセスを理解する必要があります。ネクスト トークン予測 (NTP) は、GPT や Llama などの現在の大規模言語モデルの主要な事前トレーニング目標です。 GPT や Llama などのモデルでは、トレーニング中のアテンション マスクは先行するトークンに依存します。つまり、各トークンはその前のコンテキストのみに焦点を当てます。これにより、後続のトークンを説明することができなくなります。結果として、トレーニング コーパス内で a が b より前に出現する場合、モデルは、a が与えられた場合の b の確率を、指定された b の尤度よりも最大化します。したがって、LLM が b を提示されたときに a に対して高い確率を提供できるという保証はありません。対照的に、GLM モデルは自己回帰の空白埋め目標を使用して事前トレーニングされており、マスクされたトークンが先行トークンと後続トークンの両方を制御するため、逆転の呪いに対してより堅牢になります。

The authors put this hypothesis to the test by fine-tuning GLMs on “Name to Description” data, using fictitious names and feeding descriptions to retrieve information about the entities. The GLMs achieved approximately 80% accuracy on this task, while Llama’s accuracy was 0%.

著者らは、架空の名前と説明を入力してエンティティに関する情報を取得し、「名前から説明」データに基づいて GLM を微調整することで、この仮説をテストしました。 GLM はこのタスクで約 80% の精度を達成しましたが、Llama の精度は 0% でした。

To address this issue, the authors propose a method that adapts the training objective of LLMs to something similar to ABI. They fine-tuned models using Bidirectional Causal Language Model Optimization (BICO) to reverse-engineer mathematical tasks and translation problems. BICO adopts an autoregressive blank infilling objective, similar to GLM, but with tailored modifications designed explicitly for causal language models. The authors introduced rotary (relative) position embeddings and modified the attention function to make it bidirectional. This fine-tuning method improved the model’s accuracy in reverse translation and mathematical problem-solving tasks.

この問題に対処するために、著者らは、LLM のトレーニング目標を ABI に似たものに適合させる方法を提案しています。彼らは、双方向因果言語モデル最適化 (BICO) を使用してモデルを微調整し、数学的タスクと翻訳の問題をリバース エンジニアリングしました。 BICO は、GLM と同様の自己回帰的空白埋め目標を採用していますが、因果言語モデル用に明示的に設計された調整された修正が加えられています。著者らは回転(相対)位置埋め込みを導入し、アテンション関数を修正して双方向にするようにしました。この微調整方法により、逆変換および数学的問題解決タスクにおけるモデルの精度が向上しました。

In conclusion, the authors analyze the reversal curse and propose a fine-tuning strategy to mitigate this pitfall. By adopting a causal language model with an ABI-like objective, this study sheds light on the reversal underperformance of LLMs. This work could be further expanded to examine the impact of advanced techniques, such as RLHF, on the reversal curse.

結論として、著者らは逆転の呪いを分析し、この落とし穴を軽減するための微調整戦略を提案します。この研究では、ABI のような目的を持った因果言語モデルを採用することで、LLM の反転パフォーマンスの低下に光を当てています。この研究は、RLHF などの高度なテクニックが逆転の呪いに及ぼす影響を調べるためにさらに拡張される可能性があります。

Don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. If you like our work, you will love our newsletter. Don’t Forget to join our 55k+ ML SubReddit.

Twitter で私たちをフォローし、Telegram チャンネルと LinkedIn グループに参加することを忘れないでください。私たちの仕事が気に入ったら、ニュースレターも気に入っていただけるでしょう。 55,000 以上の ML SubReddit に忘れずに参加してください。

免責事項:info@kdj.com

提供される情報は取引に関するアドバイスではありません。 kdj.com は、この記事で提供される情報に基づいて行われた投資に対して一切の責任を負いません。暗号通貨は変動性が高いため、十分な調査を行った上で慎重に投資することを強くお勧めします。

このウェブサイトで使用されているコンテンツが著作権を侵害していると思われる場合は、直ちに当社 (info@kdj.com) までご連絡ください。速やかに削除させていただきます。

![取引は、[ビデオのレビュー]ゴールドビットコイン原油注文に従うことです。 取引は、[ビデオのレビュー]ゴールドビットコイン原油注文に従うことです。](/uploads/2025/04/26/cryptocurrencies-news/videos/trading-follow-review-video-gold-bitcoin-crude-oil-profits/image-1.webp)