|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Nachrichtenartikel zu Kryptowährungen

Der Umkehrfluch von LLMs: Wenn fortgeschrittene Argumentationsmodelle in Beziehungen das Ziel verfehlen

Nov 16, 2024 at 12:48 pm

Trotz ihrer fortgeschrittenen Denkfähigkeiten verfehlen die neuesten LLMs bei der Entschlüsselung von Zusammenhängen oft ihr Ziel. In diesem Artikel untersuchen wir den Umkehrfluch, eine Falle, die sich auf LLMs bei Aufgaben wie Verstehen und Generieren auswirkt.

Large Language Models (LLMs) are renowned for their advanced reasoning capabilities, enabling them to perform a wide range of tasks, from natural language processing to code generation. However, despite their strengths, LLMs often exhibit a weakness in deciphering relationships, particularly when dealing with inverses. This phenomenon, termed the “reversal curse,” affects LLMs across various tasks, including comprehension and generation.

Large Language Models (LLMs) sind bekannt für ihre fortschrittlichen Argumentationsfähigkeiten, die es ihnen ermöglichen, ein breites Spektrum an Aufgaben auszuführen, von der Verarbeitung natürlicher Sprache bis zur Codegenerierung. Trotz ihrer Stärken weisen LLMs jedoch häufig eine Schwäche bei der Entschlüsselung von Beziehungen auf, insbesondere beim Umgang mit Inversen. Dieses als „Umkehrfluch“ bezeichnete Phänomen betrifft LLMs bei verschiedenen Aufgaben, einschließlich Verständnis und Generierung.

To understand the underlying issue, let’s consider a scenario with two entities, denoted as a and b, connected by their relation R and its inverse. LLMs excel at handling sequences such as “aRb,” where a is related to b by relation R. For instance, an LLM can quickly answer the question, “Who is the mother of Tom Cruise?” when asked. However, LLMs struggle with the inverse relation, denoted as R inverse. In our example, if we ask an LLM, “Who is Mary Lee Pfeiffer’s son?” it is more likely to hallucinate and falter, despite already knowing the relationship between Tom Cruise and Mary Lee Pfeiffer.

Um das zugrunde liegende Problem zu verstehen, betrachten wir ein Szenario mit zwei Entitäten, die als a und b bezeichnet werden und durch ihre Beziehung R und deren Umkehrung verbunden sind. LLMs zeichnen sich durch den Umgang mit Sequenzen wie „aRb“ aus, bei denen a über die Beziehung R mit b in Beziehung steht. Beispielsweise kann ein LLM schnell die Frage beantworten: „Wer ist die Mutter von Tom Cruise?“ wenn man gefragt wird. Allerdings haben LLMs mit der inversen Beziehung zu kämpfen, die als R-invers bezeichnet wird. Wenn wir in unserem Beispiel einen LLM fragen: „Wer ist Mary Lee Pfeiffers Sohn?“ Es ist wahrscheinlicher, dass es halluziniert und ins Stocken gerät, obwohl es die Beziehung zwischen Tom Cruise und Mary Lee Pfeiffer bereits kennt.

This reversal curse is a pitfall that affects LLMs in a variety of tasks. In a recent study, researchers from the Renmin University of China brought this phenomenon to the attention of the research community, shedding light on its probable causes and suggesting potential mitigation strategies. They identify the Training Objective Function as one of the key factors influencing the extent of the reversal curse.

Dieser Umkehrfluch ist eine Falle, die LLMs bei einer Vielzahl von Aufgaben betrifft. In einer aktuellen Studie machten Forscher der Renmin-Universität China die Forschungsgemeinschaft auf dieses Phänomen aufmerksam, beleuchteten seine wahrscheinlichen Ursachen und schlugen mögliche Strategien zur Eindämmung vor. Sie identifizieren die Trainingszielfunktion als einen der Schlüsselfaktoren, der das Ausmaß des Umkehrfluchs beeinflusst.

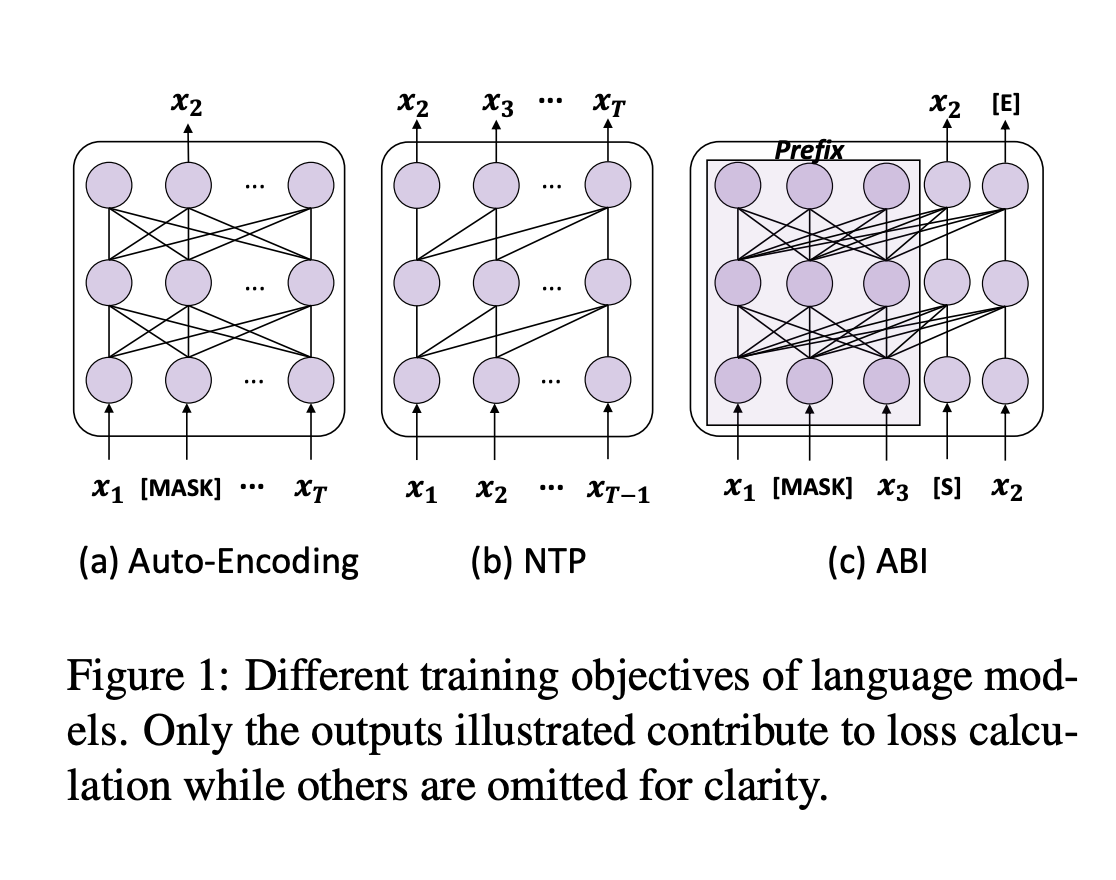

To fully grasp the reversal curse, we must first understand the training process of LLMs. Next-token prediction (NTP) is the dominant pre-training objective for current large language models, such as GPT and Llama. In models like GPT and Llama, the attention masks during training depend on the preceding tokens, meaning each token focuses solely on its prior context. This makes it impossible to account for subsequent tokens. As a result, if a occurs before b in the training corpus, the model maximizes the probability of b given a over the likelihood of a given b. Therefore, there is no guarantee that LLMs can provide a high probability for a when presented with b. In contrast, GLM models are pre-trained with autoregressive blank in-filling objectives, where the masked token controls both preceding and succeeding tokens, making them more robust to the reversal curse.

Um den Umkehrfluch vollständig zu verstehen, müssen wir zunächst den Trainingsprozess von LLMs verstehen. Die Next-Token-Vorhersage (NTP) ist das vorherrschende Ziel vor dem Training für aktuelle große Sprachmodelle wie GPT und Llama. In Modellen wie GPT und Llama hängen die Aufmerksamkeitsmasken während des Trainings von den vorhergehenden Token ab, was bedeutet, dass sich jeder Token ausschließlich auf seinen vorherigen Kontext konzentriert. Dies macht es unmöglich, nachfolgende Token zu berücksichtigen. Wenn also a vor b im Trainingskorpus auftritt, maximiert das Modell die Wahrscheinlichkeit von b bei gegebenem a gegenüber der Wahrscheinlichkeit bei gegebenem b. Daher gibt es keine Garantie dafür, dass LLMs eine hohe Wahrscheinlichkeit für a bieten können, wenn sie mit b präsentiert werden. Im Gegensatz dazu werden GLM-Modelle mit autoregressiven Lückenfüllzielen vorab trainiert, wobei der maskierte Token sowohl vorhergehende als auch nachfolgende Token kontrolliert und sie so robuster gegenüber dem Umkehrfluch macht.

The authors put this hypothesis to the test by fine-tuning GLMs on “Name to Description” data, using fictitious names and feeding descriptions to retrieve information about the entities. The GLMs achieved approximately 80% accuracy on this task, while Llama’s accuracy was 0%.

Die Autoren stellten diese Hypothese auf die Probe, indem sie GLMs auf „Name to Description“-Daten verfeinerten, indem sie fiktive Namen und Feed-Beschreibungen verwendeten, um Informationen über die Entitäten abzurufen. Die GLMs erreichten bei dieser Aufgabe eine Genauigkeit von etwa 80 %, während die Genauigkeit von Llama 0 % betrug.

To address this issue, the authors propose a method that adapts the training objective of LLMs to something similar to ABI. They fine-tuned models using Bidirectional Causal Language Model Optimization (BICO) to reverse-engineer mathematical tasks and translation problems. BICO adopts an autoregressive blank infilling objective, similar to GLM, but with tailored modifications designed explicitly for causal language models. The authors introduced rotary (relative) position embeddings and modified the attention function to make it bidirectional. This fine-tuning method improved the model’s accuracy in reverse translation and mathematical problem-solving tasks.

Um dieses Problem anzugehen, schlagen die Autoren eine Methode vor, die das Trainingsziel von LLMs an etwas anpasst, das dem von ABI ähnelt. Mithilfe der Bidirektionalen Kausalen Sprachmodelloptimierung (BICO) optimierten sie Modelle, um mathematische Aufgaben und Übersetzungsprobleme zurückzuentwickeln. BICO verwendet ein autoregressives Blank-Filling-Ziel, ähnlich wie GLM, jedoch mit maßgeschneiderten Modifikationen, die explizit für kausale Sprachmodelle entwickelt wurden. Die Autoren führten rotierende (relative) Positionseinbettungen ein und modifizierten die Aufmerksamkeitsfunktion, um sie bidirektional zu machen. Diese Feinabstimmungsmethode verbesserte die Genauigkeit des Modells bei Rückübersetzungen und mathematischen Problemlösungsaufgaben.

In conclusion, the authors analyze the reversal curse and propose a fine-tuning strategy to mitigate this pitfall. By adopting a causal language model with an ABI-like objective, this study sheds light on the reversal underperformance of LLMs. This work could be further expanded to examine the impact of advanced techniques, such as RLHF, on the reversal curse.

Abschließend analysieren die Autoren den Umkehrfluch und schlagen eine Feinabstimmungsstrategie vor, um diese Falle zu entschärfen. Durch die Verwendung eines kausalen Sprachmodells mit einem ABI-ähnlichen Ziel wirft diese Studie Licht auf die Umkehrleistung von LLMs. Diese Arbeit könnte weiter ausgeweitet werden, um die Auswirkungen fortgeschrittener Techniken wie RLHF auf den Umkehrfluch zu untersuchen.

Don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. If you like our work, you will love our newsletter. Don’t Forget to join our 55k+ ML SubReddit.

Vergessen Sie nicht, uns auf Twitter zu folgen und unserem Telegram-Kanal und unserer LinkedIn-Gruppe beizutreten. Wenn Ihnen unsere Arbeit gefällt, werden Sie unseren Newsletter lieben. Vergessen Sie nicht, unserem 55k+ ML SubReddit beizutreten.

Haftungsausschluss:info@kdj.com

Die bereitgestellten Informationen stellen keine Handelsberatung dar. kdj.com übernimmt keine Verantwortung für Investitionen, die auf der Grundlage der in diesem Artikel bereitgestellten Informationen getätigt werden. Kryptowährungen sind sehr volatil und es wird dringend empfohlen, nach gründlicher Recherche mit Vorsicht zu investieren!

Wenn Sie glauben, dass der auf dieser Website verwendete Inhalt Ihr Urheberrecht verletzt, kontaktieren Sie uns bitte umgehend (info@kdj.com) und wir werden ihn umgehend löschen.

-

- Fartcoin (Fart) bricht einen Widerstand von 1 USD durch und steigt um 460% gegenüber den jährlichen Tiefstständen

- Apr 25, 2025 at 12:05 am

- Dieser Fart-Preisschub markiert eine beeindruckende Rallye von 460% gegenüber seinen jährlichen Tiefstständen und bringt das Token in markanter Entfernung seines Allzeithochs.

-

-

- Die Xploradex -Token -Verteilung ist in vollem Gange. Nur 5 Tage bleiben dem $ XRP -Vorverkauf beizutreten

- Apr 25, 2025 at 12:00 am

- Mit der $ XPL -Token -Distribution in vollem Gange sind die Anleger nun tief in den endgültigen Countdown. Nur 5 Tage bleiben für die Öffentlichkeit $ XRP -Vorverkauf beitreten

-

-

- Coinbase erweitert den PyUSD -Zugriff, indem er mit PayPal zusammenarbeitet, um die Verwendung des Stablecoin von PayPal zu unterstützen

- Apr 24, 2025 at 11:55 pm

- Die in den USA ansässige Crypto Exchange Coinbase hat eine Partnerschaft mit PayPal geschlossen, um die Verwendung des Stablecoin Pyusd von PayPal zu unterstützen. Von Samuel Reed.

-

- Bitcoin (BTC) -Preisweg kann vor seiner kommenden „Omega Candle“ -Rallye unterdrückt werden

- Apr 24, 2025 at 11:55 pm

- Laut Prince Filip Karađorđević, dem erblichen Prinzen von Serbien und Jugoslawien, kann Bitcoin's Price -Trajektorie vor seiner kommenden Kundgebung „Omega Candle“ unterdrückt werden.

-

-

-