|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

La malédiction inversée des LLM : quand les modèles de raisonnement avancés ratent la cible des relations

Nov 16, 2024 at 12:48 pm

Malgré leurs capacités de raisonnement avancées, les derniers LLM manquent souvent la cible lorsqu’il s’agit de déchiffrer les relations. Dans cet article, nous explorons la malédiction du renversement, un piège qui affecte les LLM dans des tâches telles que la compréhension et la génération.

Large Language Models (LLMs) are renowned for their advanced reasoning capabilities, enabling them to perform a wide range of tasks, from natural language processing to code generation. However, despite their strengths, LLMs often exhibit a weakness in deciphering relationships, particularly when dealing with inverses. This phenomenon, termed the “reversal curse,” affects LLMs across various tasks, including comprehension and generation.

Les grands modèles linguistiques (LLM) sont réputés pour leurs capacités de raisonnement avancées, leur permettant d'effectuer un large éventail de tâches, du traitement du langage naturel à la génération de code. Cependant, malgré leurs points forts, les LLM présentent souvent une faiblesse dans le déchiffrement des relations, en particulier lorsqu'il s'agit d'inverses. Ce phénomène, appelé « malédiction d’inversion », affecte les LLM dans diverses tâches, notamment la compréhension et la génération.

To understand the underlying issue, let’s consider a scenario with two entities, denoted as a and b, connected by their relation R and its inverse. LLMs excel at handling sequences such as “aRb,” where a is related to b by relation R. For instance, an LLM can quickly answer the question, “Who is the mother of Tom Cruise?” when asked. However, LLMs struggle with the inverse relation, denoted as R inverse. In our example, if we ask an LLM, “Who is Mary Lee Pfeiffer’s son?” it is more likely to hallucinate and falter, despite already knowing the relationship between Tom Cruise and Mary Lee Pfeiffer.

Pour comprendre le problème sous-jacent, considérons un scénario avec deux entités, notées a et b, reliées par leur relation R et son inverse. Les LLM excellent dans le traitement de séquences telles que « aRb », où a est lié à b par la relation R. Par exemple, un LLM peut répondre rapidement à la question « Qui est la mère de Tom Cruise ? lorsqu'on lui a demandé. Cependant, les LLM ont du mal avec la relation inverse, notée R inverse. Dans notre exemple, si nous demandons à un LLM : « Qui est le fils de Mary Lee Pfeiffer ? il est plus susceptible d'halluciner et de faiblir, même s'il connaît déjà la relation entre Tom Cruise et Mary Lee Pfeiffer.

This reversal curse is a pitfall that affects LLMs in a variety of tasks. In a recent study, researchers from the Renmin University of China brought this phenomenon to the attention of the research community, shedding light on its probable causes and suggesting potential mitigation strategies. They identify the Training Objective Function as one of the key factors influencing the extent of the reversal curse.

Cette malédiction du renversement est un piège qui affecte les LLM dans diverses tâches. Dans une étude récente, des chercheurs de l'Université Renmin de Chine ont porté ce phénomène à l'attention de la communauté des chercheurs, mettant en lumière ses causes probables et suggérant des stratégies d'atténuation potentielles. Ils identifient la fonction objectif de formation comme l’un des facteurs clés influençant l’étendue de la malédiction d’inversion.

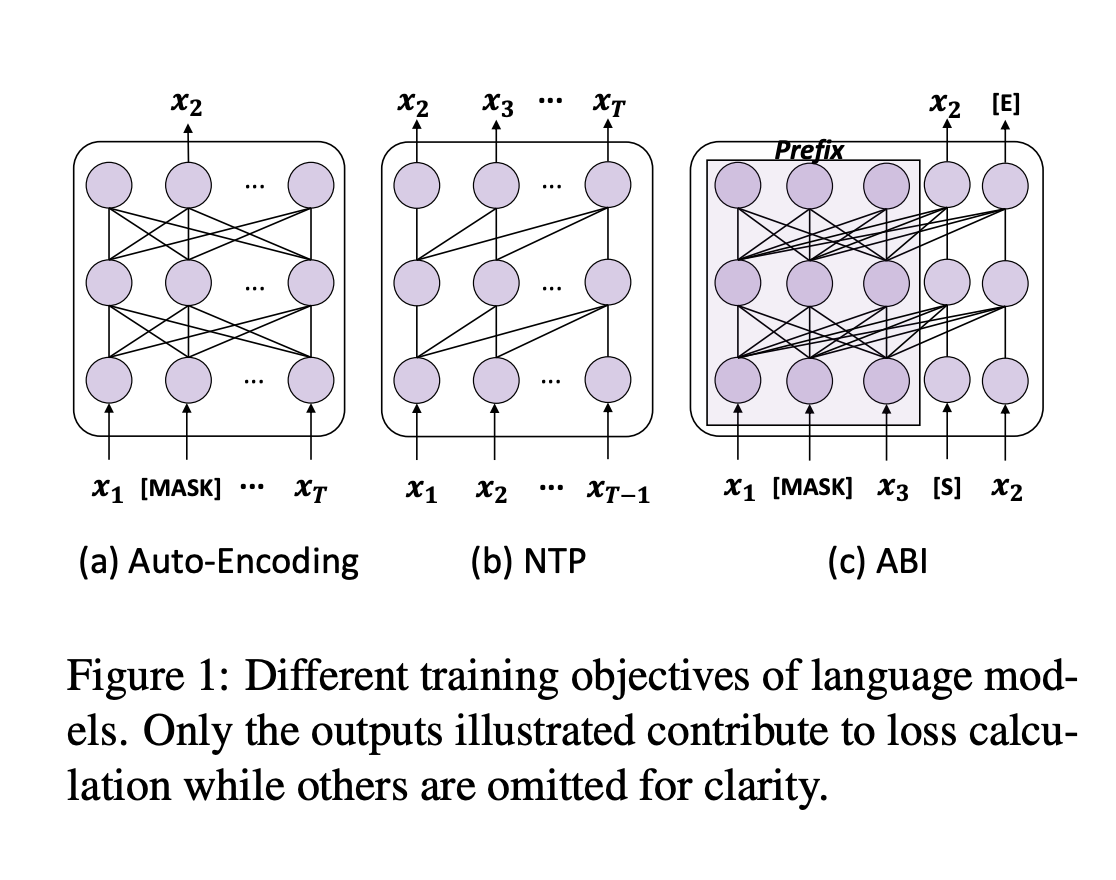

To fully grasp the reversal curse, we must first understand the training process of LLMs. Next-token prediction (NTP) is the dominant pre-training objective for current large language models, such as GPT and Llama. In models like GPT and Llama, the attention masks during training depend on the preceding tokens, meaning each token focuses solely on its prior context. This makes it impossible to account for subsequent tokens. As a result, if a occurs before b in the training corpus, the model maximizes the probability of b given a over the likelihood of a given b. Therefore, there is no guarantee that LLMs can provide a high probability for a when presented with b. In contrast, GLM models are pre-trained with autoregressive blank in-filling objectives, where the masked token controls both preceding and succeeding tokens, making them more robust to the reversal curse.

Pour bien saisir la malédiction du renversement, nous devons d’abord comprendre le processus de formation des LLM. La prédiction du prochain jeton (NTP) est l'objectif de pré-formation dominant pour les grands modèles de langage actuels, tels que GPT et Llama. Dans des modèles comme GPT et Llama, les masques d'attention pendant l'entraînement dépendent des jetons précédents, ce qui signifie que chaque jeton se concentre uniquement sur son contexte antérieur. Cela rend impossible la prise en compte des jetons ultérieurs. En conséquence, si a apparaît avant b dans le corpus de formation, le modèle maximise la probabilité de b étant donné a sur la probabilité d'un b donné. Par conséquent, rien ne garantit que les LLM puissent fournir une forte probabilité pour a lorsqu’ils sont présentés avec b. En revanche, les modèles GLM sont pré-entraînés avec des objectifs de remplissage autorégressifs, où le jeton masqué contrôle à la fois les jetons précédents et suivants, ce qui les rend plus robustes à la malédiction d'inversion.

The authors put this hypothesis to the test by fine-tuning GLMs on “Name to Description” data, using fictitious names and feeding descriptions to retrieve information about the entities. The GLMs achieved approximately 80% accuracy on this task, while Llama’s accuracy was 0%.

Les auteurs ont mis cette hypothèse à l’épreuve en affinant les GLM sur les données « Name to Description », en utilisant des noms fictifs et en alimentant des descriptions pour récupérer des informations sur les entités. Les GLM ont atteint une précision d'environ 80 % sur cette tâche, tandis que la précision de Llama était de 0 %.

To address this issue, the authors propose a method that adapts the training objective of LLMs to something similar to ABI. They fine-tuned models using Bidirectional Causal Language Model Optimization (BICO) to reverse-engineer mathematical tasks and translation problems. BICO adopts an autoregressive blank infilling objective, similar to GLM, but with tailored modifications designed explicitly for causal language models. The authors introduced rotary (relative) position embeddings and modified the attention function to make it bidirectional. This fine-tuning method improved the model’s accuracy in reverse translation and mathematical problem-solving tasks.

Pour résoudre ce problème, les auteurs proposent une méthode qui adapte l'objectif de formation des LLM à quelque chose de similaire à l'ABI. Ils ont affiné les modèles à l’aide de l’optimisation du modèle de langage causal bidirectionnel (BICO) pour effectuer une rétro-ingénierie des tâches mathématiques et des problèmes de traduction. BICO adopte un objectif de remplissage autorégressif, similaire à GLM, mais avec des modifications sur mesure conçues explicitement pour les modèles de langage causal. Les auteurs ont introduit des intégrations de positions rotatives (relatives) et ont modifié la fonction d'attention pour la rendre bidirectionnelle. Cette méthode de réglage fin a amélioré la précision du modèle dans les tâches de traduction inverse et de résolution de problèmes mathématiques.

In conclusion, the authors analyze the reversal curse and propose a fine-tuning strategy to mitigate this pitfall. By adopting a causal language model with an ABI-like objective, this study sheds light on the reversal underperformance of LLMs. This work could be further expanded to examine the impact of advanced techniques, such as RLHF, on the reversal curse.

En conclusion, les auteurs analysent la malédiction du renversement et proposent une stratégie de réglage fin pour atténuer cet écueil. En adoptant un modèle de langage causal avec un objectif de type ABI, cette étude met en lumière la sous-performance des LLM par inversion. Ce travail pourrait être élargi pour examiner l’impact de techniques avancées, telles que la RLHF, sur la malédiction d’inversion.

Don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. If you like our work, you will love our newsletter. Don’t Forget to join our 55k+ ML SubReddit.

N'oubliez pas de nous suivre sur Twitter et de rejoindre notre chaîne Telegram et notre groupe LinkedIn. Si vous aimez notre travail, vous allez adorer notre newsletter. N'oubliez pas de rejoindre notre SubReddit de plus de 55 000 ML.

Clause de non-responsabilité:info@kdj.com

Les informations fournies ne constituent pas des conseils commerciaux. kdj.com n’assume aucune responsabilité pour les investissements effectués sur la base des informations fournies dans cet article. Les crypto-monnaies sont très volatiles et il est fortement recommandé d’investir avec prudence après une recherche approfondie!

Si vous pensez que le contenu utilisé sur ce site Web porte atteinte à vos droits d’auteur, veuillez nous contacter immédiatement (info@kdj.com) et nous le supprimerons dans les plus brefs délais.

-

-

- Événement de lancement officiel de Meta Earth: la collecte de l'industrie Web3 incontournable

- Apr 26, 2025 at 11:50 am

- Du 30 avril au 1er mai 2025, Token2049 Dubaï accueillera les joueurs les plus influents de l'espace blockchain. Parmi eux, Meta Earth se distingue comme la licorne croissante du secteur modulaire de la blockchain, étant le seul projet de blockchain modulaire parmi les sponsors de titre et de Platinum.

-

-

-

- Microsoft a dévoilé une nouvelle stratégie de vente ciblant les petites et moyennes entreprises (PME) en enrôlant des entreprises tierces pour promouvoir ses offres de logiciels d'IA.

- Apr 26, 2025 at 11:40 am

- Microsoft a dévoilé une nouvelle stratégie de vente ciblant les petites et moyennes entreprises (PME) en enrôlant des entreprises tierces pour promouvoir ses offres de logiciels d'IA.

-

-

-

- La société minière de Dogecoin (DOGE) Z Squared Fusion avec une entreprise biopharmaceutique Coeptis (COEP)

- Apr 26, 2025 at 11:35 am

- Cette fusion permettra à Z carré de maintenir l'extraction de Dogecoin et de céder les activités pharmaceutiques de Coeptis. La nouvelle entreprise sera essentiellement une opération d'exploitation de crypto-monnaie avec Dogecoin et Litecoin (LTC) comme principaux atouts.

-

- 5 pièces de monnaie de fabrication ce mois: Qubetics (tics), Polkadot (dot), Hedera (HBAR), Kaspa (KAS), Arbitrum (ARB)

- Apr 26, 2025 at 11:30 am

- La crypto ne dort pas. Chaque semaine, quelque chose brise Internet - qu'il s'agisse d'un nouveau sommet de tous les temps, d'une pompe aléatoire ou d'une prévente sauvage qui prenait le feu.

![Le trading est de suivre [Revue vidéo] Les commandes de pétrole brut Bitcoin Gold font des bénéfices! Le trading est de suivre [Revue vidéo] Les commandes de pétrole brut Bitcoin Gold font des bénéfices!](/uploads/2025/04/26/cryptocurrencies-news/videos/trading-follow-review-video-gold-bitcoin-crude-oil-profits/image-1.webp)