|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

자동회귀(AR) 모델은 이미지 생성 분야를 변화시켜 고품질 영상 제작에 새로운 기준을 설정했습니다. 이러한 모델은 이미지 생성 프로세스를 순차적인 단계로 분류하며, 각 토큰은 이전 토큰을 기반으로 생성되어 탁월한 사실성과 일관성을 갖춘 출력을 생성합니다.

Autoregressive (AR) models have revolutionized the field of image generation, pushing the boundaries of visual realism and coherence. These models operate sequentially, generating each token based on the preceding ones, resulting in outputs of exceptional quality. Researchers have widely employed AR techniques in computer vision, gaming, and digital content creation applications. However, the potential of AR models is often limited by inherent inefficiencies, particularly their slow generation speed, which poses a significant challenge in real-time scenarios.

자동회귀(AR) 모델은 이미지 생성 분야에 혁명을 일으켜 시각적 사실성과 일관성의 한계를 뛰어 넘었습니다. 이러한 모델은 순차적으로 작동하여 이전 토큰을 기반으로 각 토큰을 생성하여 탁월한 품질의 출력을 생성합니다. 연구자들은 컴퓨터 비전, 게임, 디지털 콘텐츠 제작 애플리케이션에 AR 기술을 널리 사용해 왔습니다. 그러나 AR 모델의 잠재력은 본질적인 비효율성, 특히 느린 생성 속도로 인해 제한되는 경우가 많으며 이는 실시간 시나리오에서 심각한 문제를 야기합니다.

Among various concerns, a critical aspect that hinders the practical deployment of AR models is their speed. The sequential nature of token-by-token generation inherently limits scalability and introduces high latency during image generation tasks. For instance, generating a 256×256 image using traditional AR models like LlamaGen requires 256 steps, which translates to approximately five seconds on modern GPUs. Such delays hinder their application in scenarios demanding instantaneous results. Moreover, while AR models excel in maintaining the fidelity of their outputs, they face difficulties in meeting the growing demand for both speed and quality in large-scale implementations.

다양한 우려 사항 중에서 AR 모델의 실제 배포를 방해하는 중요한 측면은 속도입니다. 토큰별 생성의 순차적 특성으로 인해 본질적으로 확장성이 제한되고 이미지 생성 작업 중에 대기 시간이 길어집니다. 예를 들어 LlamaGen과 같은 기존 AR 모델을 사용하여 256×256 이미지를 생성하려면 256단계가 필요하며, 이는 최신 GPU에서 약 5초가 소요됩니다. 이러한 지연은 즉각적인 결과를 요구하는 시나리오에서 적용을 방해합니다. 또한 AR 모델은 출력의 충실도를 유지하는 데는 탁월하지만 대규모 구현에서 속도와 품질 모두에 대한 증가하는 요구를 충족하는 데 어려움을 겪고 있습니다.

Efforts to accelerate AR models have led to various methods, such as predicting multiple tokens simultaneously or adopting masking strategies during generation. These approaches aim to reduce the required steps but often compromise the quality of the generated images. For example, in multi-token generation techniques, the assumption of conditional independence among tokens introduces artifacts, ultimately undermining the cohesiveness of the output. Similarly, masking-based methods allow for faster generation by training models to predict specific tokens based on others, but their effectiveness diminishes when generation steps are drastically reduced. These limitations highlight the need for a novel approach to enhance AR model efficiency.

AR 모델을 가속화하려는 노력은 여러 토큰을 동시에 예측하거나 생성 중 마스킹 전략을 채택하는 등 다양한 방법으로 이어졌습니다. 이러한 접근 방식은 필요한 단계를 줄이는 것을 목표로 하지만 생성된 이미지의 품질이 저하되는 경우가 많습니다. 예를 들어, 다중 토큰 생성 기술에서 토큰 간의 조건부 독립성을 가정하면 아티팩트가 발생하여 결과적으로 출력의 응집력이 약화됩니다. 마찬가지로 마스킹 기반 방법은 모델을 훈련하여 다른 토큰을 기반으로 특정 토큰을 예측함으로써 더 빠른 생성을 허용하지만 생성 단계가 급격히 줄어들면 효율성이 떨어집니다. 이러한 제한 사항은 AR 모델 효율성을 향상시키기 위한 새로운 접근 방식의 필요성을 강조합니다.

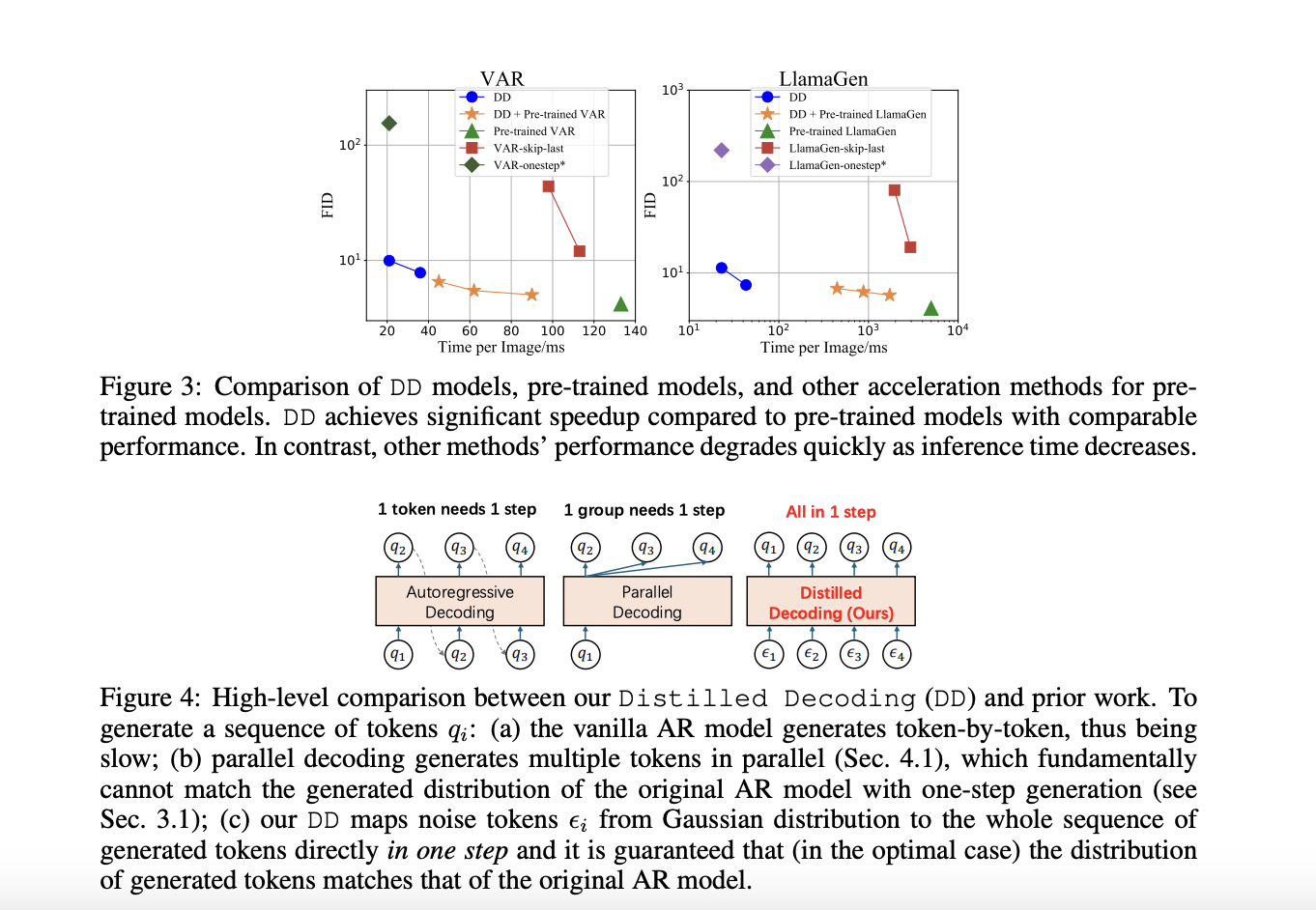

A recent research collaboration between Tsinghua University and Microsoft Research has devised a solution to these challenges: Distilled Decoding (DD). This method builds on flow matching, a deterministic mapping that connects Gaussian noise to the output distribution of pre-trained AR models. Unlike conventional methods, DD does not require access to the original training data of the AR models, making it more practical for deployment. The research demonstrated that DD can transform the generation process from hundreds of steps to as few as one or two while preserving the quality of the output. For example, on ImageNet-256, DD achieved a speed-up of 6.3x for VAR models and an impressive 217.8x for LlamaGen, reducing generation steps from 256 to just one.

최근 Tsinghua University와 Microsoft Research의 연구 협력에서는 이러한 과제에 대한 솔루션인 DD(Distilled Decoding)를 고안했습니다. 이 방법은 사전 훈련된 AR 모델의 출력 분포에 가우스 노이즈를 연결하는 결정론적 매핑인 흐름 일치를 기반으로 합니다. 기존 방법과 달리 DD는 AR 모델의 원본 교육 데이터에 액세스할 필요가 없으므로 배포에 더 실용적입니다. 연구에 따르면 DD는 출력 품질을 유지하면서 생성 프로세스를 수백 단계에서 1~2단계로 변환할 수 있음이 입증되었습니다. 예를 들어, ImageNet-256에서 DD는 VAR 모델의 경우 6.3배, LlamaGen의 경우 217.8x의 놀라운 속도 향상을 달성하여 생성 단계를 256에서 단 1로 줄였습니다.

The technical foundation of DD is based on its ability to create a deterministic trajectory for token generation. Using flow matching, DD maps noisy inputs to tokens to align their distribution with the pre-trained AR model. During training, the mapping is distilled into a lightweight network that can directly predict the final data sequence from a noise input. This process ensures faster generation and provides flexibility in balancing speed and quality by allowing intermediate steps when needed. Unlike existing methods, DD eliminates the trade-off between speed and fidelity, enabling scalable implementations across diverse tasks.

DD의 기술적 기반은 토큰 생성을 위한 결정론적 궤적을 생성하는 능력을 기반으로 합니다. DD는 흐름 일치를 사용하여 잡음이 있는 입력을 토큰에 매핑하여 해당 분포를 사전 훈련된 AR 모델과 일치시킵니다. 훈련 중에 매핑은 노이즈 입력에서 최종 데이터 시퀀스를 직접 예측할 수 있는 경량 네트워크로 정제됩니다. 이 프로세스는 더 빠른 생성을 보장하고 필요할 때 중간 단계를 허용함으로써 속도와 품질의 균형을 맞추는 유연성을 제공합니다. 기존 방법과 달리 DD는 속도와 충실도 사이의 균형을 제거하여 다양한 작업에 걸쳐 확장 가능한 구현을 가능하게 합니다.

In experiments, DD highlights its superiority over traditional methods. For instance, using VAR-d16 models, DD achieved one-step generation with an FID score increase from 4.19 to 9.96, showcasing minimal quality degradation despite a 6.3x speed-up. For LlamaGen models, the reduction in steps from 256 to one resulted in an FID score of 11.35, compared to 4.11 in the original model, with a remarkable 217.8x speed improvement. DD demonstrated similar efficiency in text-to-image tasks, reducing generation steps from 256 to two while maintaining a comparable FID score of 28.95 against 25.70. The results underline DD’s ability to drastically enhance speed without significant loss in image quality, a feat unmatched by baseline methods.

실험에서 DD는 기존 방법보다 우월함을 강조합니다. 예를 들어 VAR-d16 모델을 사용하여 DD는 FID 점수가 4.19에서 9.96으로 증가하여 6.3배의 속도 향상에도 불구하고 품질 저하가 최소화된 한 단계 생성을 달성했습니다. LlamaGen 모델의 경우 256단계에서 1단계로 감소한 결과 FID 점수는 원래 모델의 4.11에 비해 11.35가 되었으며 속도는 217.8배나 향상되었습니다. DD는 텍스트-이미지 작업에서도 유사한 효율성을 보여주었으며, 생성 단계를 256에서 2로 줄이면서 비슷한 FID 점수인 25.70 대비 28.95를 유지했습니다. 결과는 이미지 품질의 큰 손실 없이 속도를 획기적으로 향상시키는 DD의 능력을 강조하며, 이는 기본 방법으로는 비교할 수 없는 성과입니다.

Several key takeaways from the research on DD include:

DD 연구에서 얻은 몇 가지 주요 내용은 다음과 같습니다.

In conclusion, with the introduction of Distilled Decoding, researchers have successfully addressed the longstanding speed-quality trade-off that has plagued AR generation processes by leveraging flow matching and deterministic mappings. The method accelerates image synthesis by reducing steps drastically and preserves the outputs’ fidelity and scalability. With its robust performance, adaptability, and practical deployment advantages, Distilled Decoding opens new frontiers in real-time applications of AR models. It sets the stage for further innovation in generative modeling.

결론적으로, Distilled Decoding의 도입으로 연구자들은 흐름 일치 및 결정론적 매핑을 활용하여 AR 생성 프로세스를 괴롭혀온 오랜 속도-품질 균형 문제를 성공적으로 해결했습니다. 이 방법은 단계를 대폭 줄여 이미지 합성을 가속화하고 출력의 충실도와 확장성을 유지합니다. 강력한 성능, 적응성 및 실용적인 배포 이점을 갖춘 Distilled Decoding은 AR 모델의 실시간 애플리케이션에 새로운 지평을 열었습니다. 이는 생성 모델링의 추가 혁신을 위한 발판을 마련합니다.

Check out the Paper and GitHub Page. All credit for this research goes to the researchers of this project. Also, don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. Don’t Forget to join our 60k+ ML SubReddit.

Paper 및 GitHub 페이지를 확인하세요. 이 연구에 대한 모든 공로는 이 프로젝트의 연구자에게 돌아갑니다. 또한 Twitter에서 우리를 팔로우하고 Telegram 채널과 LinkedIn 그룹에 가입하는 것을 잊지 마세요. 60,000개가 넘는 ML SubReddit에 가입하는 것을 잊지 마세요.

Trending: LG AI Research Releases EXAONE 3.5: Three Open-Source Bilingual Frontier AI-level Models Delivering Unmatched Instruction Following and Long Context Understanding for Global Leadership in Generative AI Excellence

동향: LG AI 리서치, EXAONE 3.5 출시: 생성 AI 우수성 분야의 글로벌 리더십을 위해 탁월한 지시 따르기 및 장기적인 상황 이해를 제공하는 세 가지 오픈 소스 이중 언어 프론티어 AI 수준 모델

부인 성명:info@kdj.com

제공된 정보는 거래 조언이 아닙니다. kdj.com은 이 기사에 제공된 정보를 기반으로 이루어진 투자에 대해 어떠한 책임도 지지 않습니다. 암호화폐는 변동성이 매우 높으므로 철저한 조사 후 신중하게 투자하는 것이 좋습니다!

본 웹사이트에 사용된 내용이 귀하의 저작권을 침해한다고 판단되는 경우, 즉시 당사(info@kdj.com)로 연락주시면 즉시 삭제하도록 하겠습니다.

-

-

-

-

-

- $ 12.50

- 2025-04-08 23:40:12

- XRP는 트럼프 대통령이 취임하기 전에 $ 12.50로 상승 할 수 있습니다.

-

- 모그 코인 가격 예측 2024

- 2025-04-08 23:40:12

- 이 상승은 최근 가장 큰 암호화 교환 인 Binance에 대한 새로운 메모 코인 목록에 따라 부활했습니다.

-

-

-