|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Nachrichtenartikel zu Kryptowährungen

Destillierte Dekodierung (DD): Ein neuartiger Ansatz zur Beschleunigung autoregressiver (AR) Bilderzeugungsmodelle

Dec 27, 2024 at 12:19 am

Autoregressive (AR) Modelle haben den Bereich der Bilderzeugung verändert und neue Maßstäbe bei der Erstellung hochwertiger Bilder gesetzt. Diese Modelle unterteilen den Bilderstellungsprozess in aufeinanderfolgende Schritte, wobei jeder Token auf der Grundlage vorheriger Token generiert wird, wodurch Ergebnisse mit außergewöhnlichem Realismus und Kohärenz entstehen.

Autoregressive (AR) models have revolutionized the field of image generation, pushing the boundaries of visual realism and coherence. These models operate sequentially, generating each token based on the preceding ones, resulting in outputs of exceptional quality. Researchers have widely employed AR techniques in computer vision, gaming, and digital content creation applications. However, the potential of AR models is often limited by inherent inefficiencies, particularly their slow generation speed, which poses a significant challenge in real-time scenarios.

Autoregressive (AR) Modelle haben den Bereich der Bilderzeugung revolutioniert und die Grenzen des visuellen Realismus und der Kohärenz verschoben. Diese Modelle arbeiten sequentiell und generieren jeden Token auf der Grundlage der vorherigen, was zu Ergebnissen von außergewöhnlicher Qualität führt. Forscher haben AR-Techniken in großem Umfang in Anwendungen für Computer Vision, Spiele und die Erstellung digitaler Inhalte eingesetzt. Das Potenzial von AR-Modellen wird jedoch häufig durch inhärente Ineffizienzen begrenzt, insbesondere durch ihre langsame Generierungsgeschwindigkeit, die in Echtzeitszenarien eine erhebliche Herausforderung darstellt.

Among various concerns, a critical aspect that hinders the practical deployment of AR models is their speed. The sequential nature of token-by-token generation inherently limits scalability and introduces high latency during image generation tasks. For instance, generating a 256×256 image using traditional AR models like LlamaGen requires 256 steps, which translates to approximately five seconds on modern GPUs. Such delays hinder their application in scenarios demanding instantaneous results. Moreover, while AR models excel in maintaining the fidelity of their outputs, they face difficulties in meeting the growing demand for both speed and quality in large-scale implementations.

Ein kritischer Aspekt, der den praktischen Einsatz von AR-Modellen behindert, ist unter anderem ihre Geschwindigkeit. Die sequentielle Natur der Token-für-Token-Generierung schränkt die Skalierbarkeit inhärent ein und führt zu einer hohen Latenz bei Bildgenerierungsaufgaben. Beispielsweise erfordert die Generierung eines 256×256-Bildes mit herkömmlichen AR-Modellen wie LlamaGen 256 Schritte, was auf modernen GPUs etwa fünf Sekunden entspricht. Solche Verzögerungen behindern ihre Anwendung in Szenarien, die sofortige Ergebnisse erfordern. Darüber hinaus zeichnen sich AR-Modelle zwar durch die Beibehaltung der Wiedergabetreue aus, es fällt ihnen jedoch schwer, die wachsende Nachfrage nach Geschwindigkeit und Qualität bei groß angelegten Implementierungen zu erfüllen.

Efforts to accelerate AR models have led to various methods, such as predicting multiple tokens simultaneously or adopting masking strategies during generation. These approaches aim to reduce the required steps but often compromise the quality of the generated images. For example, in multi-token generation techniques, the assumption of conditional independence among tokens introduces artifacts, ultimately undermining the cohesiveness of the output. Similarly, masking-based methods allow for faster generation by training models to predict specific tokens based on others, but their effectiveness diminishes when generation steps are drastically reduced. These limitations highlight the need for a novel approach to enhance AR model efficiency.

Bemühungen zur Beschleunigung von AR-Modellen haben zu verschiedenen Methoden geführt, beispielsweise zur gleichzeitigen Vorhersage mehrerer Token oder zur Anwendung von Maskierungsstrategien während der Generierung. Diese Ansätze zielen darauf ab, die erforderlichen Schritte zu reduzieren, beeinträchtigen jedoch häufig die Qualität der erzeugten Bilder. Beispielsweise führt die Annahme einer bedingten Unabhängigkeit zwischen Token bei Techniken zur Generierung mehrerer Token zu Artefakten, die letztendlich die Kohärenz der Ausgabe untergraben. In ähnlicher Weise ermöglichen maskierungsbasierte Methoden eine schnellere Generierung, indem sie Modelle trainieren, um bestimmte Token auf der Grundlage anderer vorherzusagen. Ihre Wirksamkeit nimmt jedoch ab, wenn die Generierungsschritte drastisch reduziert werden. Diese Einschränkungen unterstreichen die Notwendigkeit eines neuartigen Ansatzes zur Verbesserung der Effizienz von AR-Modellen.

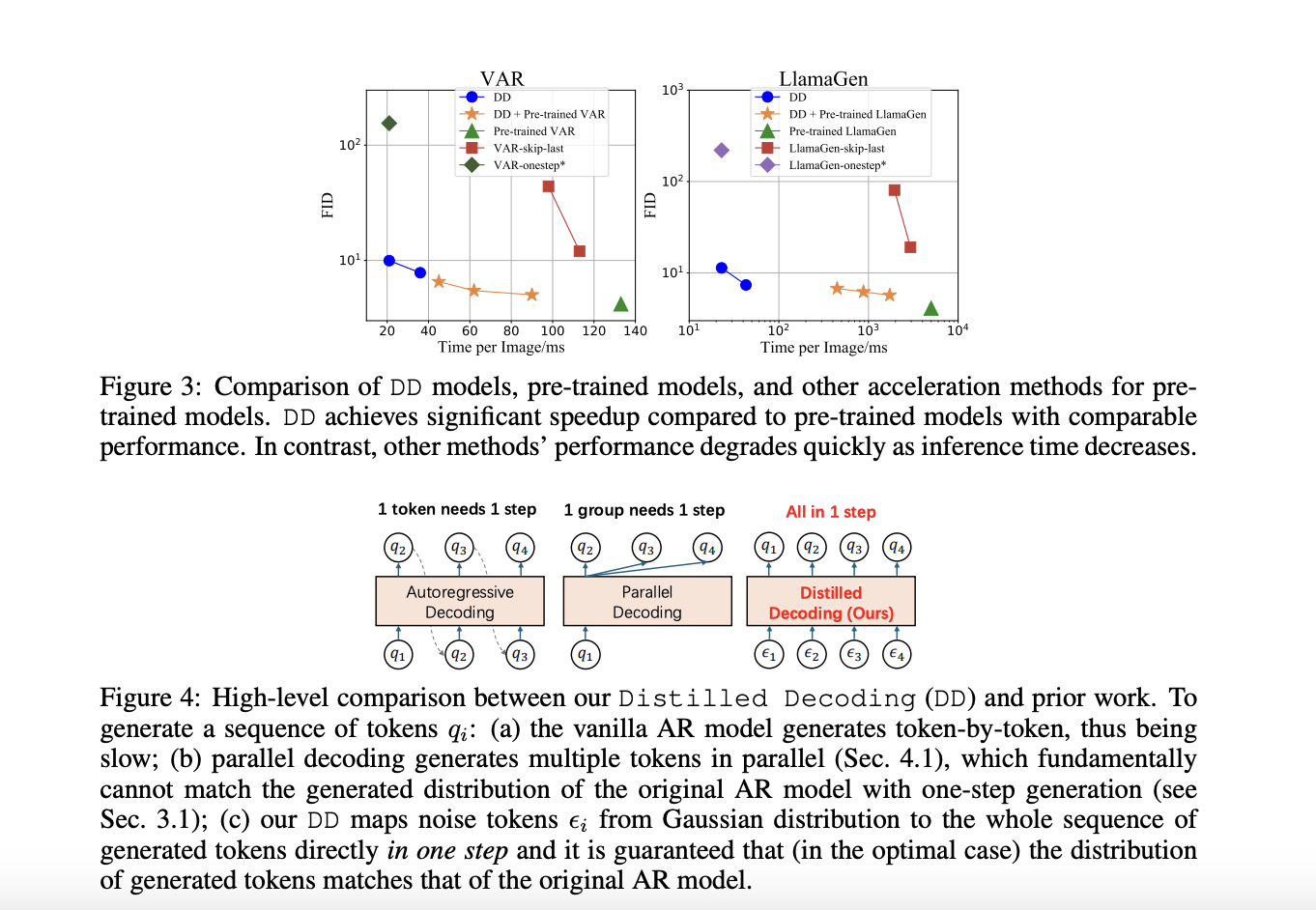

A recent research collaboration between Tsinghua University and Microsoft Research has devised a solution to these challenges: Distilled Decoding (DD). This method builds on flow matching, a deterministic mapping that connects Gaussian noise to the output distribution of pre-trained AR models. Unlike conventional methods, DD does not require access to the original training data of the AR models, making it more practical for deployment. The research demonstrated that DD can transform the generation process from hundreds of steps to as few as one or two while preserving the quality of the output. For example, on ImageNet-256, DD achieved a speed-up of 6.3x for VAR models and an impressive 217.8x for LlamaGen, reducing generation steps from 256 to just one.

Eine aktuelle Forschungskooperation zwischen der Tsinghua-Universität und Microsoft Research hat eine Lösung für diese Herausforderungen entwickelt: Distilled Decoding (DD). Diese Methode basiert auf Flow Matching, einer deterministischen Abbildung, die Gaußsches Rauschen mit der Ausgabeverteilung vorab trainierter AR-Modelle verbindet. Im Gegensatz zu herkömmlichen Methoden erfordert DD keinen Zugriff auf die ursprünglichen Trainingsdaten der AR-Modelle, was die Bereitstellung praktischer macht. Die Forschung hat gezeigt, dass DD den Generierungsprozess von Hunderten Schritten auf nur einen oder zwei umwandeln kann, während die Qualität der Ausgabe erhalten bleibt. Auf ImageNet-256 erreichte DD beispielsweise eine Geschwindigkeitssteigerung von 6,3x für VAR-Modelle und beeindruckende 217,8x für LlamaGen, wodurch die Generierungsschritte von 256 auf nur einen reduziert wurden.

The technical foundation of DD is based on its ability to create a deterministic trajectory for token generation. Using flow matching, DD maps noisy inputs to tokens to align their distribution with the pre-trained AR model. During training, the mapping is distilled into a lightweight network that can directly predict the final data sequence from a noise input. This process ensures faster generation and provides flexibility in balancing speed and quality by allowing intermediate steps when needed. Unlike existing methods, DD eliminates the trade-off between speed and fidelity, enabling scalable implementations across diverse tasks.

Die technische Grundlage von DD basiert auf seiner Fähigkeit, einen deterministischen Verlauf für die Token-Generierung zu erstellen. Mithilfe von Flow Matching ordnet DD verrauschte Eingaben Token zu, um deren Verteilung an das vorab trainierte AR-Modell anzupassen. Während des Trainings wird die Zuordnung in ein leichtgewichtiges Netzwerk destilliert, das die endgültige Datensequenz anhand einer Rauscheingabe direkt vorhersagen kann. Dieser Prozess sorgt für eine schnellere Generierung und bietet Flexibilität beim Ausgleich von Geschwindigkeit und Qualität, indem er bei Bedarf Zwischenschritte zulässt. Im Gegensatz zu bestehenden Methoden eliminiert DD den Kompromiss zwischen Geschwindigkeit und Genauigkeit und ermöglicht skalierbare Implementierungen für verschiedene Aufgaben.

In experiments, DD highlights its superiority over traditional methods. For instance, using VAR-d16 models, DD achieved one-step generation with an FID score increase from 4.19 to 9.96, showcasing minimal quality degradation despite a 6.3x speed-up. For LlamaGen models, the reduction in steps from 256 to one resulted in an FID score of 11.35, compared to 4.11 in the original model, with a remarkable 217.8x speed improvement. DD demonstrated similar efficiency in text-to-image tasks, reducing generation steps from 256 to two while maintaining a comparable FID score of 28.95 against 25.70. The results underline DD’s ability to drastically enhance speed without significant loss in image quality, a feat unmatched by baseline methods.

In Experimenten unterstreicht DD seine Überlegenheit gegenüber herkömmlichen Methoden. Mithilfe von VAR-d16-Modellen erreichte DD beispielsweise eine einstufige Generierung mit einem Anstieg des FID-Scores von 4,19 auf 9,96, was trotz einer 6,3-fachen Beschleunigung eine minimale Qualitätsverschlechterung aufwies. Bei den LlamaGen-Modellen führte die Reduzierung der Schritte von 256 auf einen zu einem FID-Wert von 11,35 im Vergleich zu 4,11 im Originalmodell, mit einer bemerkenswerten Geschwindigkeitsverbesserung um das 217,8-fache. DD zeigte eine ähnliche Effizienz bei Text-zu-Bild-Aufgaben und reduzierte die Generierungsschritte von 256 auf zwei, während gleichzeitig ein vergleichbarer FID-Wert von 28,95 gegenüber 25,70 beibehalten wurde. Die Ergebnisse unterstreichen die Fähigkeit von DD, die Geschwindigkeit ohne wesentliche Einbußen bei der Bildqualität drastisch zu steigern, eine Leistung, die mit Basismethoden unerreicht ist.

Several key takeaways from the research on DD include:

Zu den wichtigsten Erkenntnissen aus der Forschung zu DD gehören:

In conclusion, with the introduction of Distilled Decoding, researchers have successfully addressed the longstanding speed-quality trade-off that has plagued AR generation processes by leveraging flow matching and deterministic mappings. The method accelerates image synthesis by reducing steps drastically and preserves the outputs’ fidelity and scalability. With its robust performance, adaptability, and practical deployment advantages, Distilled Decoding opens new frontiers in real-time applications of AR models. It sets the stage for further innovation in generative modeling.

Zusammenfassend lässt sich sagen, dass Forscher mit der Einführung von Distilled Decoding den seit langem bestehenden Kompromiss zwischen Geschwindigkeit und Qualität, der AR-Generierungsprozessen zu schaffen macht, erfolgreich angegangen sind, indem sie Flussanpassung und deterministische Zuordnungen genutzt haben. Die Methode beschleunigt die Bildsynthese durch eine drastische Reduzierung der Schritte und bewahrt die Wiedergabetreue und Skalierbarkeit. Mit seiner robusten Leistung, Anpassungsfähigkeit und praktischen Bereitstellungsvorteilen eröffnet Distilled Decoding neue Grenzen bei Echtzeitanwendungen von AR-Modellen. Es schafft die Voraussetzungen für weitere Innovationen in der generativen Modellierung.

Check out the Paper and GitHub Page. All credit for this research goes to the researchers of this project. Also, don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. Don’t Forget to join our 60k+ ML SubReddit.

Schauen Sie sich die Paper- und GitHub-Seite an. Alle Anerkennung für diese Forschung gebührt den Forschern dieses Projekts. Vergessen Sie auch nicht, uns auf Twitter zu folgen und unserem Telegram-Kanal und unserer LinkedIn-Gruppe beizutreten. Vergessen Sie nicht, unserem über 60.000 ML großen SubReddit beizutreten.

Trending: LG AI Research Releases EXAONE 3.5: Three Open-Source Bilingual Frontier AI-level Models Delivering Unmatched Instruction Following and Long Context Understanding for Global Leadership in Generative AI Excellence

Im Trend: LG AI Research veröffentlicht EXAONE 3.5: Drei Open-Source-Modelle auf zweisprachiger Frontier-KI-Ebene, die eine unübertroffene Anleitungsfolge und ein langes Kontextverständnis für eine weltweite Führung bei generativer KI-Exzellenz bieten

Haftungsausschluss:info@kdj.com

Die bereitgestellten Informationen stellen keine Handelsberatung dar. kdj.com übernimmt keine Verantwortung für Investitionen, die auf der Grundlage der in diesem Artikel bereitgestellten Informationen getätigt werden. Kryptowährungen sind sehr volatil und es wird dringend empfohlen, nach gründlicher Recherche mit Vorsicht zu investieren!

Wenn Sie glauben, dass der auf dieser Website verwendete Inhalt Ihr Urheberrecht verletzt, kontaktieren Sie uns bitte umgehend (info@kdj.com) und wir werden ihn umgehend löschen.

-

-

- Waymos AV-Tests am Flughafen Newark: Lohnt sich das KI-Wagnis von Alphabet?

- Oct 23, 2025 at 08:36 am

- Waymos selbstfahrende Autotests am Flughafen Newark signalisieren die KI-Dominanz von Alphabet und wirken sich sowohl auf die Aktien- als auch auf die Kryptomärkte aus. Ist das die Zukunft des Transports und der Investitionen?

-

-

- Solana, Crypto Advisory und Forward Industries: Eine New Yorker Minute zur Zukunft des Finanzwesens

- Oct 23, 2025 at 08:00 am

- Forward Industries greift mit einem neuen Krypto-Beratungsgremium tief in Solana ein und signalisiert damit einen großen Wandel in den Treasury-Strategien der Unternehmen. Ist das die Zukunft des Finanzwesens?

-

- MAGACOIN: Ethereum Whales tauchen in den heißesten Vorverkauf des Jahres 2025 ein

- Oct 23, 2025 at 07:59 am

- MAGACOIN FINANCE sorgt mit seinem explodierenden Vorverkauf für Aufsehen und lockt Ethereum-Wale an, die in einem volatilen Markt einen sicheren Hafen suchen. Ist das das Krypto-Juwel, auf das Sie gewartet haben?

-

-

- King Charles 5-Pence-Münzen kommen in Umlauf: Ein Royal Flush für Münzsammler!

- Oct 23, 2025 at 07:07 am

- King Charles 5-Pence-Münzen sind jetzt im Vereinigten Königreich im Umlauf! Entdecken Sie die Begeisterung, das Eichenblatt-Design und warum Sammler von dieser königlichen Veröffentlichung so begeistert sind.

-

- 5-Pence-Münzen von King Charles kommen in Umlauf: Ein Leitfaden für Sammler

- Oct 23, 2025 at 07:07 am

- Die 5-Pence-Münzen von König Karl III. sind jetzt im Umlauf! Entdecken Sie das neue Design, seine Bedeutung und warum Sammler begeistert sind. Machen Sie sich bereit für die Jagd nach diesen historischen Münzen!

-