|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

Décodage distillé (DD) : une nouvelle approche pour accélérer les modèles de génération d'images autorégressives (AR)

Dec 27, 2024 at 12:19 am

Les modèles autorégressifs (AR) ont changé le domaine de la génération d'images, établissant de nouvelles références en matière de production de visuels de haute qualité. Ces modèles décomposent le processus de création d'image en étapes séquentielles, chaque jeton étant généré sur la base de jetons précédents, créant ainsi des sorties d'un réalisme et d'une cohérence exceptionnels.

Autoregressive (AR) models have revolutionized the field of image generation, pushing the boundaries of visual realism and coherence. These models operate sequentially, generating each token based on the preceding ones, resulting in outputs of exceptional quality. Researchers have widely employed AR techniques in computer vision, gaming, and digital content creation applications. However, the potential of AR models is often limited by inherent inefficiencies, particularly their slow generation speed, which poses a significant challenge in real-time scenarios.

Les modèles autorégressifs (AR) ont révolutionné le domaine de la génération d'images, repoussant les limites du réalisme visuel et de la cohérence. Ces modèles fonctionnent de manière séquentielle, générant chaque jeton en fonction des précédents, ce qui donne des résultats d'une qualité exceptionnelle. Les chercheurs ont largement utilisé les techniques de réalité augmentée dans les applications de vision par ordinateur, de jeux et de création de contenu numérique. Cependant, le potentiel des modèles AR est souvent limité par des inefficacités inhérentes, en particulier leur vitesse de génération lente, ce qui pose un défi important dans les scénarios en temps réel.

Among various concerns, a critical aspect that hinders the practical deployment of AR models is their speed. The sequential nature of token-by-token generation inherently limits scalability and introduces high latency during image generation tasks. For instance, generating a 256×256 image using traditional AR models like LlamaGen requires 256 steps, which translates to approximately five seconds on modern GPUs. Such delays hinder their application in scenarios demanding instantaneous results. Moreover, while AR models excel in maintaining the fidelity of their outputs, they face difficulties in meeting the growing demand for both speed and quality in large-scale implementations.

Parmi diverses préoccupations, un aspect critique qui entrave le déploiement pratique des modèles AR est leur rapidité. La nature séquentielle de la génération jeton par jeton limite intrinsèquement l’évolutivité et introduit une latence élevée lors des tâches de génération d’images. Par exemple, générer une image 256×256 à l’aide de modèles AR traditionnels comme LlamaGen nécessite 256 étapes, ce qui correspond à environ cinq secondes sur les GPU modernes. De tels retards entravent leur application dans des scénarios exigeant des résultats instantanés. De plus, même si les modèles AR excellent dans le maintien de la fidélité de leurs résultats, ils ont du mal à répondre à la demande croissante de rapidité et de qualité dans les implémentations à grande échelle.

Efforts to accelerate AR models have led to various methods, such as predicting multiple tokens simultaneously or adopting masking strategies during generation. These approaches aim to reduce the required steps but often compromise the quality of the generated images. For example, in multi-token generation techniques, the assumption of conditional independence among tokens introduces artifacts, ultimately undermining the cohesiveness of the output. Similarly, masking-based methods allow for faster generation by training models to predict specific tokens based on others, but their effectiveness diminishes when generation steps are drastically reduced. These limitations highlight the need for a novel approach to enhance AR model efficiency.

Les efforts visant à accélérer les modèles AR ont conduit à diverses méthodes, telles que la prédiction simultanée de plusieurs jetons ou l'adoption de stratégies de masquage lors de la génération. Ces approches visent à réduire les étapes requises mais compromettent souvent la qualité des images générées. Par exemple, dans les techniques de génération multi-jetons, l’hypothèse d’indépendance conditionnelle entre les jetons introduit des artefacts, compromettant finalement la cohésion du résultat. De même, les méthodes basées sur le masquage permettent une génération plus rapide en entraînant des modèles pour prédire des jetons spécifiques en fonction d'autres, mais leur efficacité diminue lorsque les étapes de génération sont considérablement réduites. Ces limites mettent en évidence la nécessité d’une nouvelle approche pour améliorer l’efficacité du modèle AR.

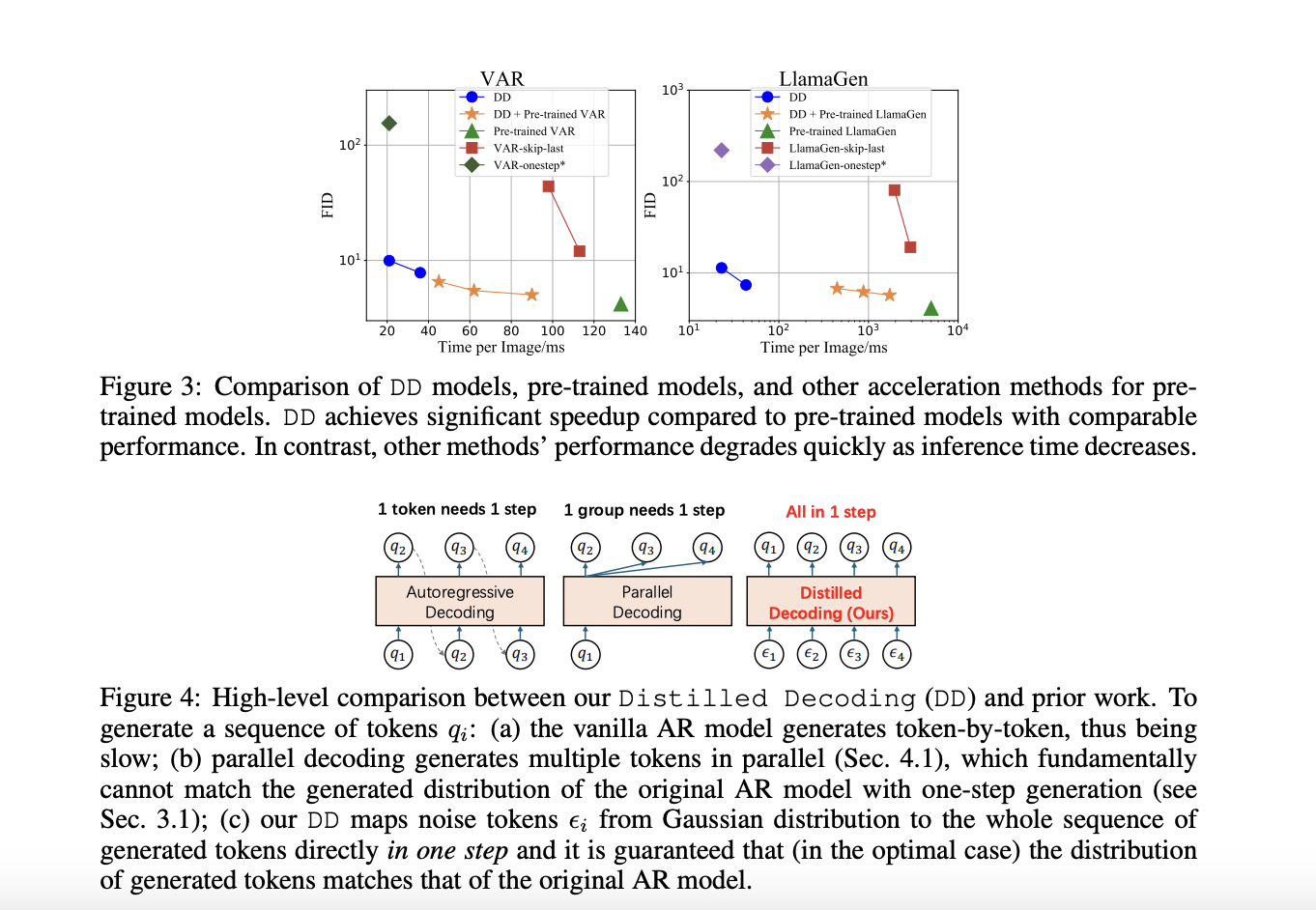

A recent research collaboration between Tsinghua University and Microsoft Research has devised a solution to these challenges: Distilled Decoding (DD). This method builds on flow matching, a deterministic mapping that connects Gaussian noise to the output distribution of pre-trained AR models. Unlike conventional methods, DD does not require access to the original training data of the AR models, making it more practical for deployment. The research demonstrated that DD can transform the generation process from hundreds of steps to as few as one or two while preserving the quality of the output. For example, on ImageNet-256, DD achieved a speed-up of 6.3x for VAR models and an impressive 217.8x for LlamaGen, reducing generation steps from 256 to just one.

Une récente collaboration de recherche entre l'Université Tsinghua et Microsoft Research a mis au point une solution à ces défis : le décodage distillé (DD). Cette méthode s'appuie sur la correspondance de flux, une cartographie déterministe qui relie le bruit gaussien à la distribution de sortie de modèles AR pré-entraînés. Contrairement aux méthodes conventionnelles, DD ne nécessite pas d'accès aux données de formation originales des modèles AR, ce qui le rend plus pratique pour le déploiement. La recherche a démontré que la DD peut transformer le processus de génération de centaines d'étapes à seulement une ou deux tout en préservant la qualité du résultat. Par exemple, sur ImageNet-256, DD a atteint une accélération de 6,3x pour les modèles VAR et une accélération impressionnante de 217,8x pour LlamaGen, réduisant ainsi les étapes de génération de 256 à une seule.

The technical foundation of DD is based on its ability to create a deterministic trajectory for token generation. Using flow matching, DD maps noisy inputs to tokens to align their distribution with the pre-trained AR model. During training, the mapping is distilled into a lightweight network that can directly predict the final data sequence from a noise input. This process ensures faster generation and provides flexibility in balancing speed and quality by allowing intermediate steps when needed. Unlike existing methods, DD eliminates the trade-off between speed and fidelity, enabling scalable implementations across diverse tasks.

Le fondement technique de DD repose sur sa capacité à créer une trajectoire déterministe pour la génération de jetons. À l'aide de la correspondance de flux, DD mappe les entrées bruyantes aux jetons pour aligner leur distribution sur le modèle AR pré-entraîné. Pendant la formation, la cartographie est distillée dans un réseau léger qui peut prédire directement la séquence de données finale à partir d'une entrée de bruit. Ce processus garantit une génération plus rapide et offre une flexibilité pour équilibrer la vitesse et la qualité en autorisant des étapes intermédiaires si nécessaire. Contrairement aux méthodes existantes, DD élimine le compromis entre vitesse et fidélité, permettant des implémentations évolutives sur diverses tâches.

In experiments, DD highlights its superiority over traditional methods. For instance, using VAR-d16 models, DD achieved one-step generation with an FID score increase from 4.19 to 9.96, showcasing minimal quality degradation despite a 6.3x speed-up. For LlamaGen models, the reduction in steps from 256 to one resulted in an FID score of 11.35, compared to 4.11 in the original model, with a remarkable 217.8x speed improvement. DD demonstrated similar efficiency in text-to-image tasks, reducing generation steps from 256 to two while maintaining a comparable FID score of 28.95 against 25.70. The results underline DD’s ability to drastically enhance speed without significant loss in image quality, a feat unmatched by baseline methods.

Dans les expériences, DD met en évidence sa supériorité sur les méthodes traditionnelles. Par exemple, en utilisant les modèles VAR-d16, DD a réalisé une génération en une étape avec une augmentation du score FID de 4,19 à 9,96, montrant une dégradation minimale de la qualité malgré une accélération de 6,3x. Pour les modèles LlamaGen, la réduction des pas de 256 à un a abouti à un score FID de 11,35, contre 4,11 dans le modèle d'origine, avec une amélioration remarquable de la vitesse de 217,8 fois. DD a démontré une efficacité similaire dans les tâches de conversion texte-image, réduisant les étapes de génération de 256 à deux tout en conservant un score FID comparable de 28,95 contre 25,70. Les résultats soulignent la capacité de DD à améliorer considérablement la vitesse sans perte significative de la qualité de l'image, un exploit inégalé par les méthodes de base.

Several key takeaways from the research on DD include:

Plusieurs points clés à retenir de la recherche sur le DD comprennent :

In conclusion, with the introduction of Distilled Decoding, researchers have successfully addressed the longstanding speed-quality trade-off that has plagued AR generation processes by leveraging flow matching and deterministic mappings. The method accelerates image synthesis by reducing steps drastically and preserves the outputs’ fidelity and scalability. With its robust performance, adaptability, and practical deployment advantages, Distilled Decoding opens new frontiers in real-time applications of AR models. It sets the stage for further innovation in generative modeling.

En conclusion, avec l’introduction du Distilled Decoding, les chercheurs ont réussi à résoudre le compromis de longue date entre vitesse et qualité qui tourmentait les processus de génération de RA en tirant parti de l’appariement de flux et des cartographies déterministes. La méthode accélère la synthèse d’images en réduisant considérablement les étapes et préserve la fidélité et l’évolutivité des sorties. Grâce à ses performances robustes, son adaptabilité et ses avantages pratiques en matière de déploiement, Distilled Decoding ouvre de nouvelles frontières dans les applications en temps réel des modèles AR. Il ouvre la voie à de nouvelles innovations en matière de modélisation générative.

Check out the Paper and GitHub Page. All credit for this research goes to the researchers of this project. Also, don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. Don’t Forget to join our 60k+ ML SubReddit.

Consultez la page Paper et GitHub. Tout le mérite de cette recherche revient aux chercheurs de ce projet. N'oubliez pas non plus de nous suivre sur Twitter et de rejoindre notre chaîne Telegram et notre groupe LinkedIn. N'oubliez pas de rejoindre notre SubReddit de plus de 60 000 ML.

Trending: LG AI Research Releases EXAONE 3.5: Three Open-Source Bilingual Frontier AI-level Models Delivering Unmatched Instruction Following and Long Context Understanding for Global Leadership in Generative AI Excellence

Tendance : LG AI Research publie EXAONE 3.5 : trois modèles d'IA Frontier bilingues open source offrant un suivi d'instructions inégalé et une longue compréhension du contexte pour un leadership mondial en matière d'excellence en IA générative

Clause de non-responsabilité:info@kdj.com

Les informations fournies ne constituent pas des conseils commerciaux. kdj.com n’assume aucune responsabilité pour les investissements effectués sur la base des informations fournies dans cet article. Les crypto-monnaies sont très volatiles et il est fortement recommandé d’investir avec prudence après une recherche approfondie!

Si vous pensez que le contenu utilisé sur ce site Web porte atteinte à vos droits d’auteur, veuillez nous contacter immédiatement (info@kdj.com) et nous le supprimerons dans les plus brefs délais.

-

- Cardano (Ada) Price Eyes Un taureau massif au milieu de l'offre qui se profile

- Apr 26, 2025 at 12:05 pm

- Cardano Price est sur le point d'un rallye massif après plus de 20 millions de dollars de jetons ADA a récemment laissé les échanges. Les données de Coininglass indiquent qu'au cours des sept derniers jours,

-

-

-

-

-

- Le cercle nie fermement les rumeurs suggérant qu'elle prévoit de demander une licence bancaire américaine

- Apr 26, 2025 at 11:55 am

- «Nous exhortons le Congrès à adopter une législation sur le paiement bipartite des paiements bipartisan maintenant pour défendre l'innovation américaine, la stabilité et la sécurité des consommateurs.»

-

-

- Événement de lancement officiel de Meta Earth: la collecte de l'industrie Web3 incontournable

- Apr 26, 2025 at 11:50 am

- Du 30 avril au 1er mai 2025, Token2049 Dubaï accueillera les joueurs les plus influents de l'espace blockchain. Parmi eux, Meta Earth se distingue comme la licorne croissante du secteur modulaire de la blockchain, étant le seul projet de blockchain modulaire parmi les sponsors de titre et de Platinum.

-

![Le trading est de suivre [Revue vidéo] Les commandes de pétrole brut Bitcoin Gold font des bénéfices! Le trading est de suivre [Revue vidéo] Les commandes de pétrole brut Bitcoin Gold font des bénéfices!](/uploads/2025/04/26/cryptocurrencies-news/videos/trading-follow-review-video-gold-bitcoin-crude-oil-profits/image-1.webp)