|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

自己回帰 (AR) モデルは画像生成の分野を変え、高品質のビジュアルを生成する際の新たなベンチマークを設定しました。これらのモデルは、イメージ作成プロセスを一連のステップに分割し、各トークンが前のトークンに基づいて生成され、優れたリアリズムと一貫性を備えた出力を作成します。

Autoregressive (AR) models have revolutionized the field of image generation, pushing the boundaries of visual realism and coherence. These models operate sequentially, generating each token based on the preceding ones, resulting in outputs of exceptional quality. Researchers have widely employed AR techniques in computer vision, gaming, and digital content creation applications. However, the potential of AR models is often limited by inherent inefficiencies, particularly their slow generation speed, which poses a significant challenge in real-time scenarios.

自己回帰 (AR) モデルは画像生成の分野に革命をもたらし、視覚的なリアリズムと一貫性の限界を押し広げました。これらのモデルは順番に動作し、前のトークンに基づいて各トークンを生成し、その結果、優れた品質の出力が得られます。研究者は、コンピュータ ビジョン、ゲーム、デジタル コンテンツ作成アプリケーションで AR 技術を広く採用してきました。ただし、AR モデルの可能性は、固有の非効率性、特に生成速度の遅さによって制限されることが多く、リアルタイム シナリオでは大きな課題となります。

Among various concerns, a critical aspect that hinders the practical deployment of AR models is their speed. The sequential nature of token-by-token generation inherently limits scalability and introduces high latency during image generation tasks. For instance, generating a 256×256 image using traditional AR models like LlamaGen requires 256 steps, which translates to approximately five seconds on modern GPUs. Such delays hinder their application in scenarios demanding instantaneous results. Moreover, while AR models excel in maintaining the fidelity of their outputs, they face difficulties in meeting the growing demand for both speed and quality in large-scale implementations.

さまざまな懸念事項の中でも、AR モデルの実用的な展開を妨げる重要な側面はその速度です。トークンごとの生成の逐次的な性質により、本質的にスケーラビリティが制限され、イメージ生成タスク中に高い待ち時間が発生します。たとえば、LlamaGen などの従来の AR モデルを使用して 256×256 の画像を生成するには 256 ステップが必要で、最新の GPU では約 5 秒に相当します。このような遅延は、即時の結果が要求されるシナリオでの適用を妨げます。さらに、AR モデルは出力の忠実度を維持する点では優れていますが、大規模な実装では速度と品質の両方に対する需要の高まりに応えることが困難に直面しています。

Efforts to accelerate AR models have led to various methods, such as predicting multiple tokens simultaneously or adopting masking strategies during generation. These approaches aim to reduce the required steps but often compromise the quality of the generated images. For example, in multi-token generation techniques, the assumption of conditional independence among tokens introduces artifacts, ultimately undermining the cohesiveness of the output. Similarly, masking-based methods allow for faster generation by training models to predict specific tokens based on others, but their effectiveness diminishes when generation steps are drastically reduced. These limitations highlight the need for a novel approach to enhance AR model efficiency.

AR モデルを高速化する取り組みにより、複数のトークンを同時に予測したり、生成中にマスキング戦略を採用したりするなど、さまざまな方法が開発されました。これらのアプローチは、必要な手順を減らすことを目的としていますが、多くの場合、生成される画像の品質が損なわれます。たとえば、マルチトークン生成手法では、トークン間で条件付き独立性を仮定するとアーティファクトが生じ、最終的には出力の一貫性が損なわれます。同様に、マスキングベースの方法では、他のトークンに基づいて特定のトークンを予測するモデルをトレーニングすることで、より高速な生成が可能になりますが、生成ステップが大幅に削減されると、その有効性は低下します。これらの制限は、AR モデルの効率を高めるための新しいアプローチの必要性を浮き彫りにしています。

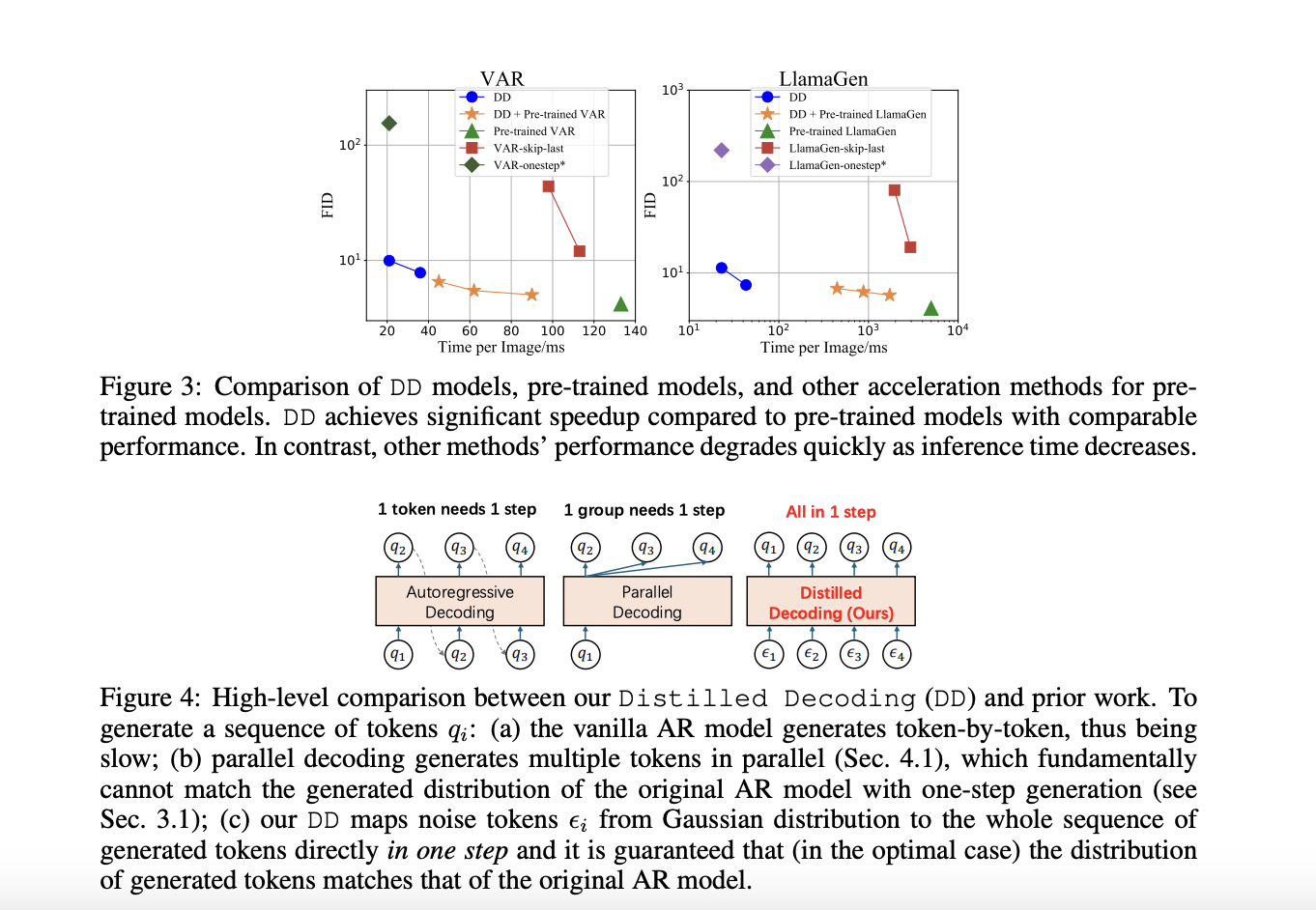

A recent research collaboration between Tsinghua University and Microsoft Research has devised a solution to these challenges: Distilled Decoding (DD). This method builds on flow matching, a deterministic mapping that connects Gaussian noise to the output distribution of pre-trained AR models. Unlike conventional methods, DD does not require access to the original training data of the AR models, making it more practical for deployment. The research demonstrated that DD can transform the generation process from hundreds of steps to as few as one or two while preserving the quality of the output. For example, on ImageNet-256, DD achieved a speed-up of 6.3x for VAR models and an impressive 217.8x for LlamaGen, reducing generation steps from 256 to just one.

清華大学と Microsoft Research との最近の共同研究では、これらの課題に対する解決策、蒸留復号化 (DD) を考案しました。この方法は、ガウス ノイズを事前トレーニングされた AR モデルの出力分布に結び付ける決定論的マッピングであるフロー マッチングに基づいています。従来の方法とは異なり、DD は AR モデルの元のトレーニング データにアクセスする必要がないため、導入がより現実的になります。この研究では、DD により、出力の品質を維持しながら、生成プロセスを数百のステップからわずか 1 つまたは 2 つのステップに変換できることが実証されました。たとえば、ImageNet-256 では、DD は VAR モデルで 6.3 倍、LlamaGen で 217.8 倍という驚異的な高速化を達成し、生成ステップを 256 から 1 つに削減しました。

The technical foundation of DD is based on its ability to create a deterministic trajectory for token generation. Using flow matching, DD maps noisy inputs to tokens to align their distribution with the pre-trained AR model. During training, the mapping is distilled into a lightweight network that can directly predict the final data sequence from a noise input. This process ensures faster generation and provides flexibility in balancing speed and quality by allowing intermediate steps when needed. Unlike existing methods, DD eliminates the trade-off between speed and fidelity, enabling scalable implementations across diverse tasks.

DD の技術的基盤は、トークン生成の決定的な軌道を作成する機能に基づいています。 DD はフロー マッチングを使用して、ノイズの多い入力をトークンにマッピングし、その分布を事前トレーニングされた AR モデルと一致させます。トレーニング中に、マッピングはノイズ入力から最終的なデータ シーケンスを直接予測できる軽量ネットワークに蒸留されます。このプロセスにより、より高速な生成が保証され、必要に応じて中間ステップが許可されるため、速度と品質のバランスをとる柔軟性が得られます。既存の方法とは異なり、DD は速度と忠実度の間のトレードオフを排除し、さまざまなタスクにわたってスケーラブルな実装を可能にします。

In experiments, DD highlights its superiority over traditional methods. For instance, using VAR-d16 models, DD achieved one-step generation with an FID score increase from 4.19 to 9.96, showcasing minimal quality degradation despite a 6.3x speed-up. For LlamaGen models, the reduction in steps from 256 to one resulted in an FID score of 11.35, compared to 4.11 in the original model, with a remarkable 217.8x speed improvement. DD demonstrated similar efficiency in text-to-image tasks, reducing generation steps from 256 to two while maintaining a comparable FID score of 28.95 against 25.70. The results underline DD’s ability to drastically enhance speed without significant loss in image quality, a feat unmatched by baseline methods.

実験では、DD が従来の方法よりも優れていることが強調されています。たとえば、VAR-d16 モデルを使用すると、DD は FID スコアが 4.19 から 9.96 に増加してワンステップ生成を達成し、6.3 倍の高速化にも関わらず品質の低下が最小限であることを示しました。 LlamaGen モデルの場合、ステップ数が 256 から 1 に減少した結果、FID スコアは 11.35 となり、元のモデルの 4.11 と比較して、217.8 倍の顕著な速度向上が見られました。 DD は、テキストから画像へのタスクでも同様の効率を示し、生成ステップを 256 から 2 に減らし、同等の FID スコア 25.70 に対して 28.95 を維持しました。この結果は、画質を大幅に損なうことなく速度を大幅に向上させる DD の能力を強調しており、これはベースラインの方法では比類のない偉業です。

Several key takeaways from the research on DD include:

DD に関する研究から得られる重要なポイントは次のとおりです。

In conclusion, with the introduction of Distilled Decoding, researchers have successfully addressed the longstanding speed-quality trade-off that has plagued AR generation processes by leveraging flow matching and deterministic mappings. The method accelerates image synthesis by reducing steps drastically and preserves the outputs’ fidelity and scalability. With its robust performance, adaptability, and practical deployment advantages, Distilled Decoding opens new frontiers in real-time applications of AR models. It sets the stage for further innovation in generative modeling.

結論として、研究者らは、蒸留デコーディングの導入により、フロー マッチングと決定論的マッピングを活用することで、AR 生成プロセスを悩ませてきた長年の速度と品質のトレードオフに対処することに成功しました。この方法は、ステップを大幅に削減することで画像合成を加速し、出力の忠実性とスケーラビリティを維持します。 Distilled Decoding は、その堅牢なパフォーマンス、適応性、実用的な展開の利点により、AR モデルのリアルタイム アプリケーションに新たな境地を開きます。これは、生成モデリングにおけるさらなる革新のための舞台を設定します。

Check out the Paper and GitHub Page. All credit for this research goes to the researchers of this project. Also, don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. Don’t Forget to join our 60k+ ML SubReddit.

Paper と GitHub ページをチェックしてください。この研究の功績はすべて、このプロジェクトの研究者に与えられます。また、Twitter で私たちをフォローし、Telegram チャンネルと LinkedIn グループに参加することも忘れないでください。 60,000 以上の ML SubReddit に忘れずに参加してください。

Trending: LG AI Research Releases EXAONE 3.5: Three Open-Source Bilingual Frontier AI-level Models Delivering Unmatched Instruction Following and Long Context Understanding for Global Leadership in Generative AI Excellence

トレンド: LG AI Research が EXAONE 3.5 をリリース: ジェネレーティブ AI エクセレンスにおける世界的リーダーシップに向けて、比類のない命令追従と長いコンテキスト理解を実現する 3 つのオープンソース バイリンガル フロンティア AI レベル モデル

免責事項:info@kdj.com

提供される情報は取引に関するアドバイスではありません。 kdj.com は、この記事で提供される情報に基づいて行われた投資に対して一切の責任を負いません。暗号通貨は変動性が高いため、十分な調査を行った上で慎重に投資することを強くお勧めします。

このウェブサイトで使用されているコンテンツが著作権を侵害していると思われる場合は、直ちに当社 (info@kdj.com) までご連絡ください。速やかに削除させていただきます。

-

-

-

-

-

-

-

-

-

- 12.50ドル

- 2025-04-08 23:40:12

- XRPは、トランプ大統領が就任する前に12.50ドルに上昇する可能性があります