|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

현재 AI 시대정신에서 시퀀스 모델은 데이터를 분석하고 다음에 수행할 작업을 예측하는 능력으로 인해 인기가 급상승했습니다.

Sequence models have become increasingly popular in the AI domain for their ability to analyze data and predict下一步做什么. For instance, you've likely used next-token prediction models like ChatGPT, which anticipate each word (token) in a sequence to form answers to users' queries. There are also full-sequence diffusion models like Sora, which convert words into dazzling, realistic visuals by successively "denoising" an entire video sequence.

시퀀스 모델은 데이터 분석 및 예측 기능으로 인해 AI 영역에서 점점 인기를 얻고 있습니다. 예를 들어 ChatGPT와 같은 다음 토큰 예측 모델을 사용했을 가능성이 높습니다. 이 모델은 시퀀스의 각 단어(토큰)를 예상하여 사용자 쿼리에 대한 답변을 형성합니다. 전체 비디오 시퀀스를 연속적으로 "노이즈 제거"하여 단어를 눈부시게 사실적인 시각적으로 변환하는 Sora와 같은 전체 시퀀스 확산 모델도 있습니다.

Researchers from MIT's Computer Science and Artificial Intelligence Laboratory (CSAIL) have proposed a simple change to the diffusion training scheme that makes this sequence denoising considerably more flexible.

MIT 컴퓨터 과학 및 인공 지능 연구소(CSAIL)의 연구원들은 이 시퀀스 노이즈 제거를 훨씬 더 유연하게 만드는 확산 훈련 방식에 대한 간단한 변경을 제안했습니다.

When applied to fields like computer vision and robotics, the next-token and full-sequence diffusion models have capability trade-offs. Next-token models can spit out sequences that vary in length.

컴퓨터 비전 및 로봇 공학과 같은 분야에 적용할 때 차세대 토큰 및 전체 시퀀스 확산 모델은 기능 상충관계를 갖습니다. 다음 토큰 모델은 길이가 다양한 시퀀스를 생성할 수 있습니다.

However, they make these generations while being unaware of desirable states in the far future—such as steering its sequence generation toward a certain goal 10 tokens away—and thus require additional mechanisms for long-horizon (long-term) planning. Diffusion models can perform such future-conditioned sampling, but lack the ability of next-token models to generate variable-length sequences.

그러나 먼 미래의 바람직한 상태(예: 시퀀스 생성을 10개 토큰 떨어진 특정 목표를 향해 조정하는 등)를 인식하지 못한 채 이러한 세대를 생성하므로 장기 계획을 위한 추가 메커니즘이 필요합니다. 확산 모델은 이러한 미래 조건 샘플링을 수행할 수 있지만 가변 길이 시퀀스를 생성하는 다음 토큰 모델의 기능이 부족합니다.

Researchers from CSAIL want to combine the strengths of both models, so they created a sequence model training technique called "Diffusion Forcing." The name comes from "Teacher Forcing," the conventional training scheme that breaks down full sequence generation into the smaller, easier steps of next-token generation (much like a good teacher simplifying a complex concept).

CSAIL의 연구원들은 두 모델의 장점을 결합하기 위해 "확산 강제"라는 시퀀스 모델 훈련 기술을 만들었습니다. 이름은 전체 시퀀스 생성을 다음 토큰 생성의 더 작고 쉬운 단계로 나누는 기존 교육 방식인 "Teacher Forcing"에서 유래되었습니다(복잡한 개념을 단순화하는 훌륭한 교사와 유사).

Diffusion Forcing found common ground between diffusion models and teacher forcing: They both use training schemes that involve predicting masked (noisy) tokens from unmasked ones. In the case of diffusion models, they gradually add noise to data, which can be viewed as fractional masking.

확산 강제는 확산 모델과 교사 강제 사이의 공통점을 찾았습니다. 둘 다 마스크되지 않은 토큰에서 마스크된(노이즈) 토큰을 예측하는 훈련 방식을 사용합니다. 확산 모델의 경우 점차적으로 데이터에 노이즈를 추가하는데, 이는 부분 마스킹으로 볼 수 있습니다.

The MIT researchers' Diffusion Forcing method trains neural networks to cleanse a collection of tokens, removing different amounts of noise within each one while simultaneously predicting the next few tokens. The result: a flexible, reliable sequence model that resulted in higher-quality artificial videos and more precise decision-making for robots and AI agents.

MIT 연구원의 확산 강제 방법은 신경망을 훈련하여 토큰 모음을 정화하고 각 토큰 내에서 서로 다른 양의 노이즈를 제거하는 동시에 다음 몇 개의 토큰을 예측합니다. 그 결과, 로봇과 AI 에이전트를 위한 고품질 인공 비디오와 보다 정확한 의사 결정을 가능하게 하는 유연하고 안정적인 시퀀스 모델이 탄생했습니다.

By sorting through noisy data and reliably predicting the next steps in a task, Diffusion Forcing can aid a robot in ignoring visual distractions to complete manipulation tasks. It can also generate stable and consistent video sequences and even guide an AI agent through digital mazes.

시끄러운 데이터를 분류하고 작업의 다음 단계를 안정적으로 예측함으로써 확산 강제는 로봇이 시각적 방해 요소를 무시하고 조작 작업을 완료하는 데 도움을 줄 수 있습니다. 또한 안정적이고 일관된 비디오 시퀀스를 생성하고 디지털 미로를 통해 AI 에이전트를 안내할 수도 있습니다.

This method could potentially enable household and factory robots to generalize to new tasks and improve AI-generated entertainment.

이 방법을 사용하면 가정 및 공장 로봇이 새로운 작업을 일반화하고 AI 기반 엔터테인먼트를 향상할 수 있습니다.

"Sequence models aim to condition on the known past and predict the unknown future, a type of binary masking. However, masking doesn't need to be binary," says lead author, MIT electrical engineering and computer science (EECS) Ph.D. student, and CSAIL member Boyuan Chen.

"시퀀스 모델은 알려진 과거를 조건으로 하고 알려지지 않은 미래를 예측하는 것을 목표로 합니다. 일종의 이진 마스킹입니다. 그러나 마스킹은 이진일 필요는 없습니다"라고 수석 저자인 MIT 전기 공학 및 컴퓨터 과학(EECS) 박사는 말합니다. . 학생, CSAIL 회원 Boyan Chen.

"With Diffusion Forcing, we add different levels of noise to each token, effectively serving as a type of fractional masking. At test time, our system can 'unmask' a collection of tokens and diffuse a sequence in the near future at a lower noise level. It knows what to trust within its data to overcome out-of-distribution inputs."

"Diffusion Forcing을 사용하면 각 토큰에 서로 다른 수준의 노이즈를 추가하여 효과적으로 분수 마스킹 유형의 역할을 합니다. 테스트 시 우리 시스템은 토큰 모음을 '마스크 해제'하고 가까운 시일 내에 더 낮은 노이즈로 시퀀스를 확산시킬 수 있습니다. 수준입니다. 배포되지 않은 입력을 극복하기 위해 데이터 내에서 무엇을 신뢰해야 하는지 알고 있습니다."

In several experiments, Diffusion Forcing thrived at ignoring misleading data to execute tasks while anticipating future actions.

여러 실험에서 Diffusion Forcing은 잘못된 데이터를 무시하고 향후 작업을 예상하면서 작업을 실행하는 데 성공했습니다.

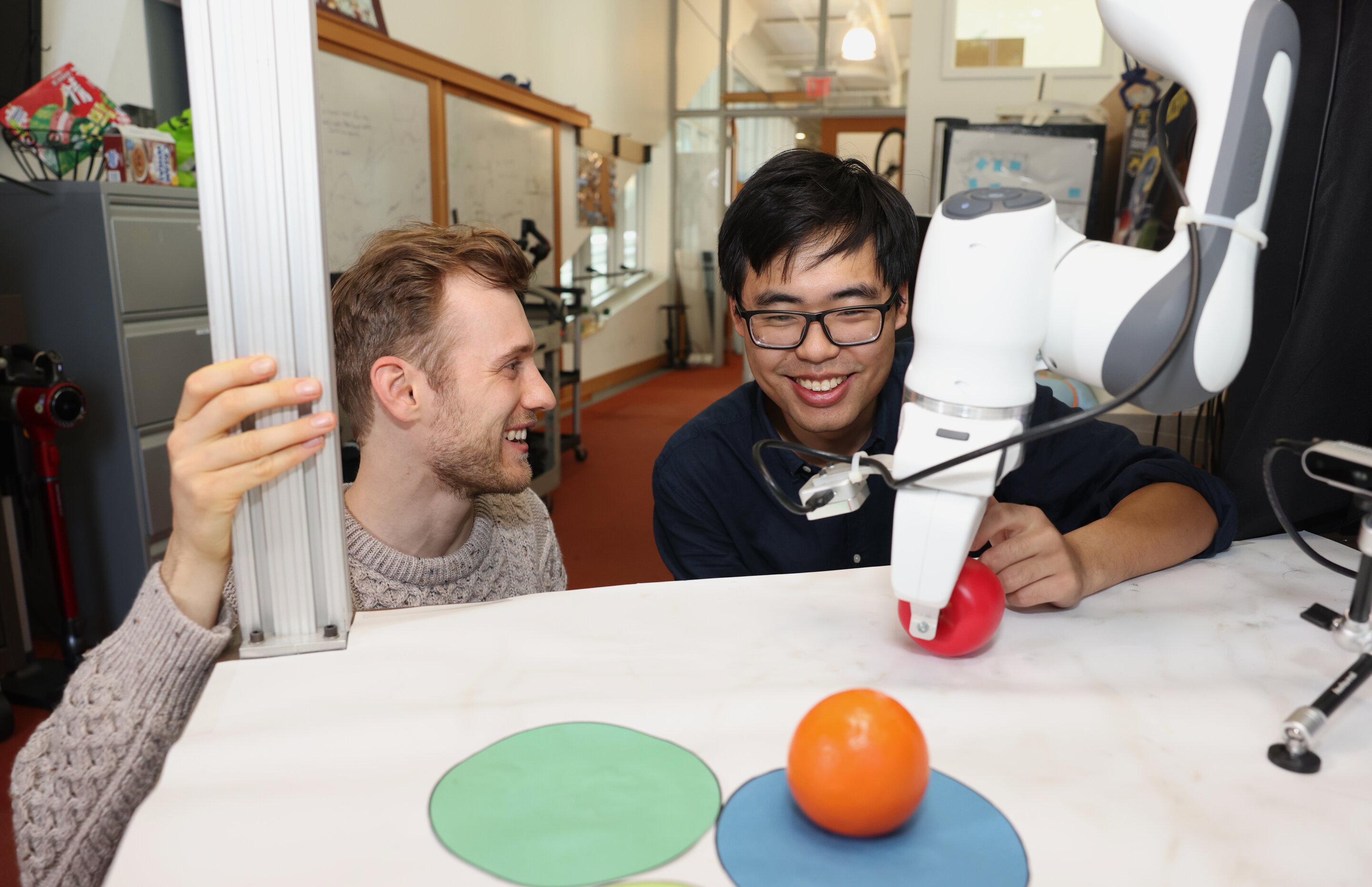

When implemented into a robotic arm, for example, it helped swap two toy fruits across three circular mats, a minimal example of a family of long-horizon tasks that require memories. The researchers trained the robot by controlling it from a distance (or teleoperating it) in virtual reality.

예를 들어, 로봇 팔에 구현되면 3개의 원형 매트에 걸쳐 2개의 장난감 과일을 교환하는 데 도움이 되었는데, 이는 기억이 필요한 장거리 작업 계열의 최소 예입니다. 연구원들은 가상 현실에서 로봇을 멀리서 제어(또는 원격 조작)하여 훈련시켰습니다.

The robot is trained to mimic the user's movements from its camera. Despite starting from random positions and seeing distractions like a shopping bag blocking the markers, it placed the objects into its target spots.

로봇은 카메라를 통해 사용자의 움직임을 모방하도록 훈련되었습니다. 임의의 위치에서 시작하고 마커를 막고 있는 쇼핑백과 같은 방해 요소가 있음에도 불구하고 개체를 목표 지점에 배치했습니다.

To generate videos, they trained Diffusion Forcing on "Minecraft" game play and colorful digital environments created within Google's DeepMind Lab Simulator. When given a single frame of footage, the method produced more stable, higher-resolution videos than comparable baselines like a Sora-like full-sequence diffusion model and ChatGPT-like next-token models.

비디오를 생성하기 위해 그들은 Google의 DeepMind Lab Simulator에서 생성된 "Minecraft" 게임 플레이와 다채로운 디지털 환경에 대한 확산 강제를 훈련했습니다. 단일 영상 프레임이 주어지면 이 방법은 Sora와 같은 전체 시퀀스 확산 모델 및 ChatGPT와 같은 다음 토큰 모델과 같은 유사한 기준보다 더 안정적이고 고해상도의 비디오를 생성했습니다.

These approaches created videos that appeared inconsistent, with the latter sometimes failing to generate working video past just 72 frames.

이러한 접근 방식은 일관되지 않은 것처럼 보이는 비디오를 생성했으며, 후자는 때때로 72프레임만 지나면 작동하는 비디오를 생성하지 못했습니다.

Diffusion Forcing not only generates fancy videos, but can also serve as a motion planner that steers toward desired outcomes or rewards. Thanks to its flexibility, Diffusion Forcing can uniquely generate plans with varying horizon, perform tree search, and incorporate the intuition that the distant future is more uncertain than the near future.

확산 강제는 멋진 비디오를 생성할 뿐만 아니라 원하는 결과나 보상을 향해 나아가는 모션 플래너 역할도 할 수 있습니다. 유연성 덕분에 Diffusion Forcing은 다양한 범위의 계획을 고유하게 생성하고 트리 검색을 수행하며 먼 미래가 가까운 미래보다 더 불확실하다는 직관을 통합할 수 있습니다.

In the task of solving a 2D maze, Diffusion Forcing outperformed six baselines by generating faster plans leading to the goal location, indicating that it could be an effective planner for robots in the future.

2D 미로를 해결하는 작업에서 Diffusion Forcing은 목표 위치로 이어지는 더 빠른 계획을 생성하여 6가지 기준을 능가했으며 이는 향후 로봇을 위한 효과적인 계획자가 될 수 있음을 나타냅니다.

Across each demo, Diffusion Forcing acted as a full sequence model, a next-token prediction model, or both. According to Chen, this versatile approach could potentially serve as a powerful backbone for a "world model," an AI system that can simulate the dynamics of the world by training on billions of internet videos.

각 데모에서 확산 강제는 전체 시퀀스 모델, 다음 토큰 예측 모델 또는 두 가지 모두로 작동했습니다. Chen에 따르면 이러한 다재다능한 접근 방식은 수십억 개의 인터넷 비디오를 훈련하여 세계의 역학을 시뮬레이션할 수 있는 AI 시스템인 "세계 모델"의 강력한 백본 역할을 할 수 있습니다.

This would allow robots

이를 통해 로봇은

부인 성명:info@kdj.com

제공된 정보는 거래 조언이 아닙니다. kdj.com은 이 기사에 제공된 정보를 기반으로 이루어진 투자에 대해 어떠한 책임도 지지 않습니다. 암호화폐는 변동성이 매우 높으므로 철저한 조사 후 신중하게 투자하는 것이 좋습니다!

본 웹사이트에 사용된 내용이 귀하의 저작권을 침해한다고 판단되는 경우, 즉시 당사(info@kdj.com)로 연락주시면 즉시 삭제하도록 하겠습니다.