|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

現在の AI の時代精神では、データを分析し、次に何を行うかを予測する機能により、シーケンス モデルの人気が急上昇しています。

Sequence models have become increasingly popular in the AI domain for their ability to analyze data and predict下一步做什么. For instance, you've likely used next-token prediction models like ChatGPT, which anticipate each word (token) in a sequence to form answers to users' queries. There are also full-sequence diffusion models like Sora, which convert words into dazzling, realistic visuals by successively "denoising" an entire video sequence.

シーケンス モデルは、データを分析して次のことを予測できるため、AI 分野でますます人気が高まっています。たとえば、ユーザーのクエリに対する回答を形成するためにシーケンス内の各単語 (トークン) を予測する、ChatGPT のようなネクスト トークン予測モデルを使用したことがあるでしょう。 Sora のようなフルシーケンス拡散モデルもあります。これは、ビデオ シーケンス全体を連続的に「ノイズ除去」することで、言葉をまばゆいばかりのリアルなビジュアルに変換します。

Researchers from MIT's Computer Science and Artificial Intelligence Laboratory (CSAIL) have proposed a simple change to the diffusion training scheme that makes this sequence denoising considerably more flexible.

MIT のコンピュータ サイエンスおよび人工知能研究所 (CSAIL) の研究者は、このシーケンスのノイズ除去を大幅に柔軟にする拡散トレーニング スキームへの簡単な変更を提案しました。

When applied to fields like computer vision and robotics, the next-token and full-sequence diffusion models have capability trade-offs. Next-token models can spit out sequences that vary in length.

コンピューター ビジョンやロボット工学などの分野に適用する場合、ネクスト トークン拡散モデルとフルシーケンス拡散モデルには機能のトレードオフがあります。 Next-token モデルは、長さが異なるシーケンスを吐き出すことができます。

However, they make these generations while being unaware of desirable states in the far future—such as steering its sequence generation toward a certain goal 10 tokens away—and thus require additional mechanisms for long-horizon (long-term) planning. Diffusion models can perform such future-conditioned sampling, but lack the ability of next-token models to generate variable-length sequences.

ただし、遠い将来の望ましい状態を意識せずにこれらの世代を作成するため (シーケンスの生成を 10 トークン先の特定の目標に向けて誘導するなど)、長期的な計画のための追加メカニズムが必要になります。拡散モデルは、このような将来条件付きサンプリングを実行できますが、可変長シーケンスを生成するネクストトークン モデルの機能がありません。

Researchers from CSAIL want to combine the strengths of both models, so they created a sequence model training technique called "Diffusion Forcing." The name comes from "Teacher Forcing," the conventional training scheme that breaks down full sequence generation into the smaller, easier steps of next-token generation (much like a good teacher simplifying a complex concept).

CSAIL の研究者は、両方のモデルの長所を組み合わせたいと考え、「拡散強制」と呼ばれるシーケンス モデル トレーニング手法を作成しました。この名前は、完全なシーケンス生成を次のトークン生成のより小さく簡単なステップに分割する従来のトレーニング スキームである「Teacher Forcing」に由来しています (優れた教師が複雑な概念を単純化するのとよく似ています)。

Diffusion Forcing found common ground between diffusion models and teacher forcing: They both use training schemes that involve predicting masked (noisy) tokens from unmasked ones. In the case of diffusion models, they gradually add noise to data, which can be viewed as fractional masking.

拡散強制は、拡散モデルと教師強制の間に共通点を発見しました。どちらも、マスクされた (ノイズのある) トークンをマスクされていないトークンから予測することを含むトレーニング スキームを使用します。拡散モデルの場合、データに徐々にノイズが追加されます。これは部分マスキングとみなすことができます。

The MIT researchers' Diffusion Forcing method trains neural networks to cleanse a collection of tokens, removing different amounts of noise within each one while simultaneously predicting the next few tokens. The result: a flexible, reliable sequence model that resulted in higher-quality artificial videos and more precise decision-making for robots and AI agents.

MIT の研究者による拡散強制手法は、ニューラル ネットワークをトレーニングしてトークンのコレクションをクレンジングし、各トークン内のさまざまな量のノイズを除去しながら、同時に次のいくつかのトークンを予測します。その結果、柔軟で信頼性の高いシーケンス モデルが誕生し、より高品質の人工ビデオと、ロボットや AI エージェントのより正確な意思決定が実現しました。

By sorting through noisy data and reliably predicting the next steps in a task, Diffusion Forcing can aid a robot in ignoring visual distractions to complete manipulation tasks. It can also generate stable and consistent video sequences and even guide an AI agent through digital mazes.

拡散強制は、ノイズの多いデータを分類し、タスクの次のステップを確実に予測することで、ロボットが視覚的な邪魔を無視して操作タスクを完了できるように支援します。また、安定した一貫したビデオ シーケンスを生成し、AI エージェントをデジタル迷路内でガイドすることもできます。

This method could potentially enable household and factory robots to generalize to new tasks and improve AI-generated entertainment.

この方法により、家庭用ロボットや工場用ロボットが新しいタスクに汎用化し、AI が生成するエンターテイメントを改善できる可能性があります。

"Sequence models aim to condition on the known past and predict the unknown future, a type of binary masking. However, masking doesn't need to be binary," says lead author, MIT electrical engineering and computer science (EECS) Ph.D. student, and CSAIL member Boyuan Chen.

「シーケンス モデルは、既知の過去を条件付けし、未知の未来を予測することを目的としています。これはバイナリ マスキングの一種です。ただし、マスキングはバイナリである必要はありません」と筆頭著者である MIT 電気工学およびコンピュータ サイエンス (EECS) 博士は述べています。 。学生でCSAILメンバーのBoyuan Chen氏。

"With Diffusion Forcing, we add different levels of noise to each token, effectively serving as a type of fractional masking. At test time, our system can 'unmask' a collection of tokens and diffuse a sequence in the near future at a lower noise level. It knows what to trust within its data to overcome out-of-distribution inputs."

「拡散強制を使用すると、各トークンに異なるレベルのノイズを追加し、一種のフラクショナル マスキングとして効果的に機能します。テスト時に、私たちのシステムはトークンのコレクションを「マスク解除」し、近い将来、より低いノイズでシーケンスを拡散できます。配布範囲外の入力を克服するためにデータ内で何を信頼すべきかを知っています。」

In several experiments, Diffusion Forcing thrived at ignoring misleading data to execute tasks while anticipating future actions.

いくつかの実験では、拡散強制は、将来のアクションを予測しながら、誤解を招くデータを無視してタスクを実行することで成功しました。

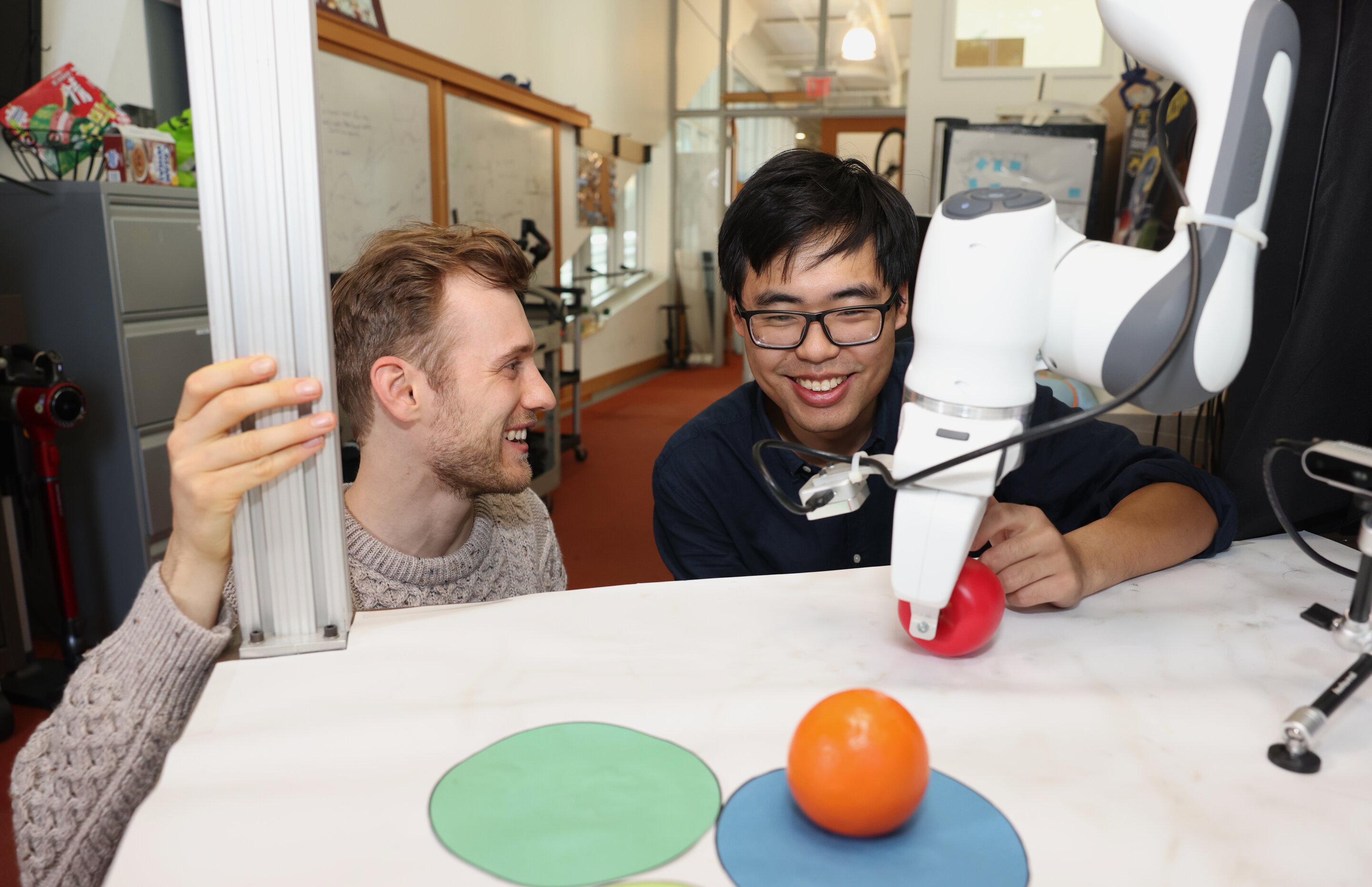

When implemented into a robotic arm, for example, it helped swap two toy fruits across three circular mats, a minimal example of a family of long-horizon tasks that require memories. The researchers trained the robot by controlling it from a distance (or teleoperating it) in virtual reality.

たとえば、ロボット アームに実装すると、3 つの円形マット上で 2 つのおもちゃの果物を交換するのに役立ちました。これは、記憶を必要とする長期的なタスクの最小例です。研究者らは、仮想現実内で遠隔からロボットを制御(または遠隔操作)することでロボットを訓練した。

The robot is trained to mimic the user's movements from its camera. Despite starting from random positions and seeing distractions like a shopping bag blocking the markers, it placed the objects into its target spots.

ロボットは、カメラからのユーザーの動きを模倣するように訓練されています。ランダムな位置から開始し、マーカーを遮るショッピングバッグなどの邪魔物があったにもかかわらず、オブジェクトを目標の場所に配置しました。

To generate videos, they trained Diffusion Forcing on "Minecraft" game play and colorful digital environments created within Google's DeepMind Lab Simulator. When given a single frame of footage, the method produced more stable, higher-resolution videos than comparable baselines like a Sora-like full-sequence diffusion model and ChatGPT-like next-token models.

ビデオを生成するために、彼らは「Minecraft」のゲームプレイと、Google の DeepMind Lab Simulator 内に作成されたカラフルなデジタル環境で拡散強制をトレーニングしました。単一フレームの映像が与えられると、この方法は、Sora のようなフルシーケンス拡散モデルや ChatGPT のようなネクスト トークン モデルなどの同等のベースラインよりも、より安定した高解像度のビデオを生成しました。

These approaches created videos that appeared inconsistent, with the latter sometimes failing to generate working video past just 72 frames.

これらのアプローチでは一貫性のないように見えるビデオが作成され、後者はわずか 72 フレームを超えて正常に動作するビデオを生成できない場合がありました。

Diffusion Forcing not only generates fancy videos, but can also serve as a motion planner that steers toward desired outcomes or rewards. Thanks to its flexibility, Diffusion Forcing can uniquely generate plans with varying horizon, perform tree search, and incorporate the intuition that the distant future is more uncertain than the near future.

拡散強制は、派手なビデオを生成するだけでなく、望ましい結果や報酬に向けて方向転換するモーション プランナーとしても機能します。拡散強制は、その柔軟性のおかげで、さまざまな地平線を持つ計画を独自に生成し、ツリー検索を実行し、遠い将来は近い将来よりも不確実であるという直観を組み込むことができます。

In the task of solving a 2D maze, Diffusion Forcing outperformed six baselines by generating faster plans leading to the goal location, indicating that it could be an effective planner for robots in the future.

2D 迷路を解くタスクでは、拡散強制は、ゴール位置につながるより高速な計画を生成することで 6 つのベースラインを上回り、将来的にはロボットの効果的な計画ツールとなる可能性があることを示しています。

Across each demo, Diffusion Forcing acted as a full sequence model, a next-token prediction model, or both. According to Chen, this versatile approach could potentially serve as a powerful backbone for a "world model," an AI system that can simulate the dynamics of the world by training on billions of internet videos.

各デモにわたって、拡散強制は完全なシーケンス モデル、ネクスト トークン予測モデル、またはその両方として機能しました。チェン氏によると、この汎用性の高いアプローチは、数十億のインターネット ビデオをトレーニングすることで世界のダイナミクスをシミュレートできる AI システムである「ワールド モデル」の強力なバックボーンとして機能する可能性があります。

This would allow robots

これでロボットも使えるようになる

免責事項:info@kdj.com

提供される情報は取引に関するアドバイスではありません。 kdj.com は、この記事で提供される情報に基づいて行われた投資に対して一切の責任を負いません。暗号通貨は変動性が高いため、十分な調査を行った上で慎重に投資することを強くお勧めします。

このウェブサイトで使用されているコンテンツが著作権を侵害していると思われる場合は、直ちに当社 (info@kdj.com) までご連絡ください。速やかに削除させていただきます。

-

-

-

-

- XRPとリップルが規制の流れを乗り切る:今後の展望

- 2026-02-10 11:00:41

- XRPとリップルは、進化する規制状況と市場力学に直面しており、将来の価格行動と採用に影響を与えます。

-

-

-

-

-