|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

자연어 처리(NLP) 분야는 대규모 언어 모델(LLM)의 개발로 큰 발전을 이루었습니다. 그러나 이러한 진전에는 나름의 과제도 있었습니다. 훈련 및 추론에는 상당한 컴퓨팅 리소스가 필요하고, 다양한 고품질 데이터 세트의 가용성이 중요하며, 전문가 혼합(MoE) 아키텍처에서 균형 잡힌 활용을 달성하는 것은 여전히 복잡합니다. 이러한 요인은 비효율성과 비용 증가에 기여하여 오픈 소스 모델을 독점 모델과 일치하도록 확장하는 데 장애물이 됩니다. 더욱이, 훈련 중 견고성과 안정성을 보장하는 것은 지속적인 문제입니다. 사소한 불안정성이라도 성과를 방해하고 비용이 많이 드는 개입이 필요할 수 있기 때문입니다.

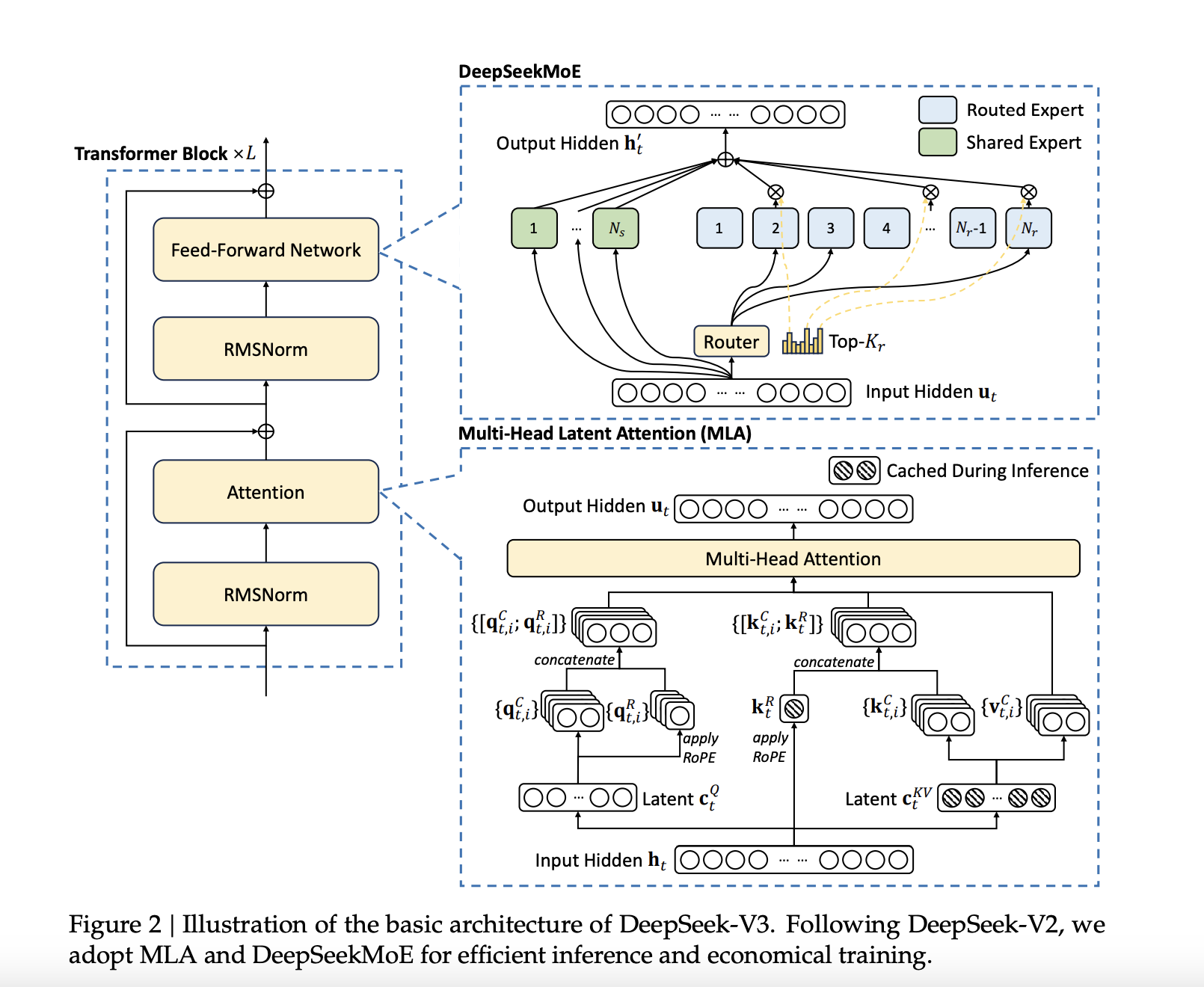

DeepSeek-AI has announced the release of DeepSeek-V3, a 671B Mixture-of-Experts (MoE) language model with 37B parameters activated per token. This latest model builds upon DeepSeek-AI's previous work on Multi-Head Latent Attention (MLA) and DeepSeekMoE architectures, which were refined in DeepSeek-V2 and DeepSeek-V2.5. DeepSeek-V3 is trained on a massive dataset of 14.8 trillion high-quality tokens, ensuring a broad and diverse knowledge base. Notably, DeepSeek-V3 is fully open-source, with accessible models, papers, and training frameworks for the research community to explore.

DeepSeek-AI는 토큰당 37B 매개변수가 활성화된 671B MoE(Mixture-of-Experts) 언어 모델인 DeepSeek-V3의 출시를 발표했습니다. 이 최신 모델은 DeepSeek-V2 및 DeepSeek-V2.5에서 개선된 MLA(Multi-Head Latent Attention) 및 DeepSeekMoE 아키텍처에 대한 DeepSeek-AI의 이전 작업을 기반으로 구축되었습니다. DeepSeek-V3는 14.8조 개의 고품질 토큰으로 구성된 대규모 데이터 세트에서 훈련되어 광범위하고 다양한 지식 기반을 보장합니다. 특히 DeepSeek-V3는 연구 커뮤니티가 탐색할 수 있는 접근 가능한 모델, 논문 및 교육 프레임워크를 갖춘 완전한 오픈 소스입니다.

Technical Details and BenefitsSeveral innovations are incorporated into DeepSeek-V3 to address long-standing challenges in the field. An auxiliary-loss-free load balancing strategy efficiently distributes computational loads across experts while maintaining model performance. Moreover, a multi-token prediction training objective enhances data efficiency and enables faster inference through speculative decoding.

기술 세부 정보 및 이점 DeepSeek-V3에는 현장에서 오랫동안 지속된 과제를 해결하기 위해 여러 가지 혁신 기술이 통합되어 있습니다. 보조 손실 없는 로드 밸런싱 전략은 모델 성능을 유지하면서 전문가들에게 계산 로드를 효율적으로 분산시킵니다. 또한, 멀티 토큰 예측 훈련 목표는 데이터 효율성을 높이고 추측적 디코딩을 통해 더 빠른 추론을 가능하게 합니다.

Additionally, FP8 mixed precision training improves computational efficiency by reducing GPU memory usage without sacrificing accuracy. The DualPipe algorithm further minimizes pipeline bubbles by overlapping computation and communication phases, reducing all-to-all communication overhead. These advancements allow DeepSeek-V3 to process 60 tokens per second during inference—a significant improvement over DeepSeek-V2.5.

또한 FP8 혼합 정밀도 교육은 정확도를 저하시키지 않고 GPU 메모리 사용량을 줄여 계산 효율성을 향상시킵니다. DualPipe 알고리즘은 계산 및 통신 단계를 겹쳐서 파이프라인 버블을 더욱 최소화하고 전체 통신 오버헤드를 줄입니다. 이러한 발전을 통해 DeepSeek-V3는 추론 중에 초당 60개의 토큰을 처리할 수 있습니다. 이는 DeepSeek-V2.5에 비해 크게 향상된 것입니다.

Performance Insights and ResultsDeepSeek-V3 is evaluated across multiple benchmarks, showcasing strong performance. On educational datasets like MMLU and MMLU-Pro, DeepSeek-V3 achieves scores of 88.5 and 75.9, respectively, outperforming other open-source models. In mathematical reasoning tasks, DeepSeek-V3 sets new standards with a score of 90.2 on MATH-500. The model also performs exceptionally in coding benchmarks such as LiveCodeBench.

성능 개선 도우미 및 결과DeepSeek-V3는 여러 벤치마크에서 평가되어 강력한 성능을 보여줍니다. MMLU 및 MMLU-Pro와 같은 교육용 데이터 세트에서 DeepSeek-V3는 각각 88.5점과 75.9점을 달성하여 다른 오픈 소스 모델보다 성능이 뛰어납니다. 수학적 추론 작업에서 DeepSeek-V3는 MATH-500에서 90.2점으로 새로운 표준을 설정했습니다. 이 모델은 LiveCodeBench와 같은 코딩 벤치마크에서도 탁월한 성능을 발휘합니다.

Despite these achievements, the training cost is kept relatively low at $5.576 million, requiring only 2.788 million H800 GPU hours. These results highlight DeepSeek-V3’s efficiency and its potential to make high-performance LLMs more accessible.

이러한 성과에도 불구하고 훈련 비용은 557만 6천 달러로 상대적으로 낮게 유지되며, H800 GPU 시간은 278만 8천 시간만 필요합니다. 이러한 결과는 DeepSeek-V3의 효율성과 고성능 LLM에 대한 접근성을 더욱 높일 수 있는 잠재력을 강조합니다.

ConclusionDeepSeek-V3 marks a significant advancement in open-source NLP research. By tackling the computational and architectural challenges associated with large-scale language models, DeepSeek-AI establishes a new benchmark for efficiency and performance. DeepSeek-V3 sets a new standard for open-source LLMs, achieving a balance of performance and efficiency that makes it a competitive alternative to proprietary models. DeepSeek-AI's commitment to open-source development ensures that the broader research community can benefit from its advancements.

결론DeepSeek-V3는 오픈 소스 NLP 연구에서 상당한 발전을 이루었습니다. DeepSeek-AI는 대규모 언어 모델과 관련된 계산 및 아키텍처 문제를 해결함으로써 효율성과 성능에 대한 새로운 벤치마크를 설정합니다. DeepSeek-V3는 오픈 소스 LLM에 대한 새로운 표준을 설정하여 독점 모델에 대한 경쟁력 있는 대안이 되는 성능과 효율성의 균형을 달성합니다. 오픈 소스 개발에 대한 DeepSeek-AI의 노력은 더 광범위한 연구 커뮤니티가 그 발전의 혜택을 누릴 수 있도록 보장합니다.

Check out the Paper, GitHub Page, and Model on Hugging Face. All credit for this research goes to the researchers of this project. Also, don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. Don’t Forget to join our 60k+ ML SubReddit.

Paper, GitHub 페이지, Hugging Face 모델을 확인해 보세요. 이 연구에 대한 모든 공로는 이 프로젝트의 연구자에게 돌아갑니다. 또한 Twitter에서 우리를 팔로우하고 Telegram 채널과 LinkedIn 그룹에 가입하는 것을 잊지 마세요. 60,000개가 넘는 ML SubReddit에 가입하는 것을 잊지 마세요.

Trending: LG AI Research Releases EXAONE 3.5: Three Open-Source Bilingual Frontier AI-level Models

동향: LG AI 리서치, EXAONE 3.5 출시: 세 가지 오픈 소스 이중 언어 프론티어 AI 수준 모델

부인 성명:info@kdj.com

제공된 정보는 거래 조언이 아닙니다. kdj.com은 이 기사에 제공된 정보를 기반으로 이루어진 투자에 대해 어떠한 책임도 지지 않습니다. 암호화폐는 변동성이 매우 높으므로 철저한 조사 후 신중하게 투자하는 것이 좋습니다!

본 웹사이트에 사용된 내용이 귀하의 저작권을 침해한다고 판단되는 경우, 즉시 당사(info@kdj.com)로 연락주시면 즉시 삭제하도록 하겠습니다.