|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

自然言語処理 (NLP) の分野は、大規模言語モデル (LLM) の開発により大きな進歩を遂げました。ただし、この進歩には独自の課題も伴いました。トレーニングと推論には大量の計算リソースが必要であり、多様で高品質なデータセットの可用性が重要であり、専門家混合 (MoE) アーキテクチャでバランスの取れた利用を達成することは依然として複雑です。これらの要因は非効率性とコストの増加に寄与し、オープンソース モデルをプロプライエタリなモデルに合わせて拡張する際の障害となります。さらに、わずかな不安定性でもパフォーマンスに支障をきたし、コストのかかる介入が必要になる可能性があるため、トレーニング中の堅牢性と安定性を確保することは継続的な問題です。

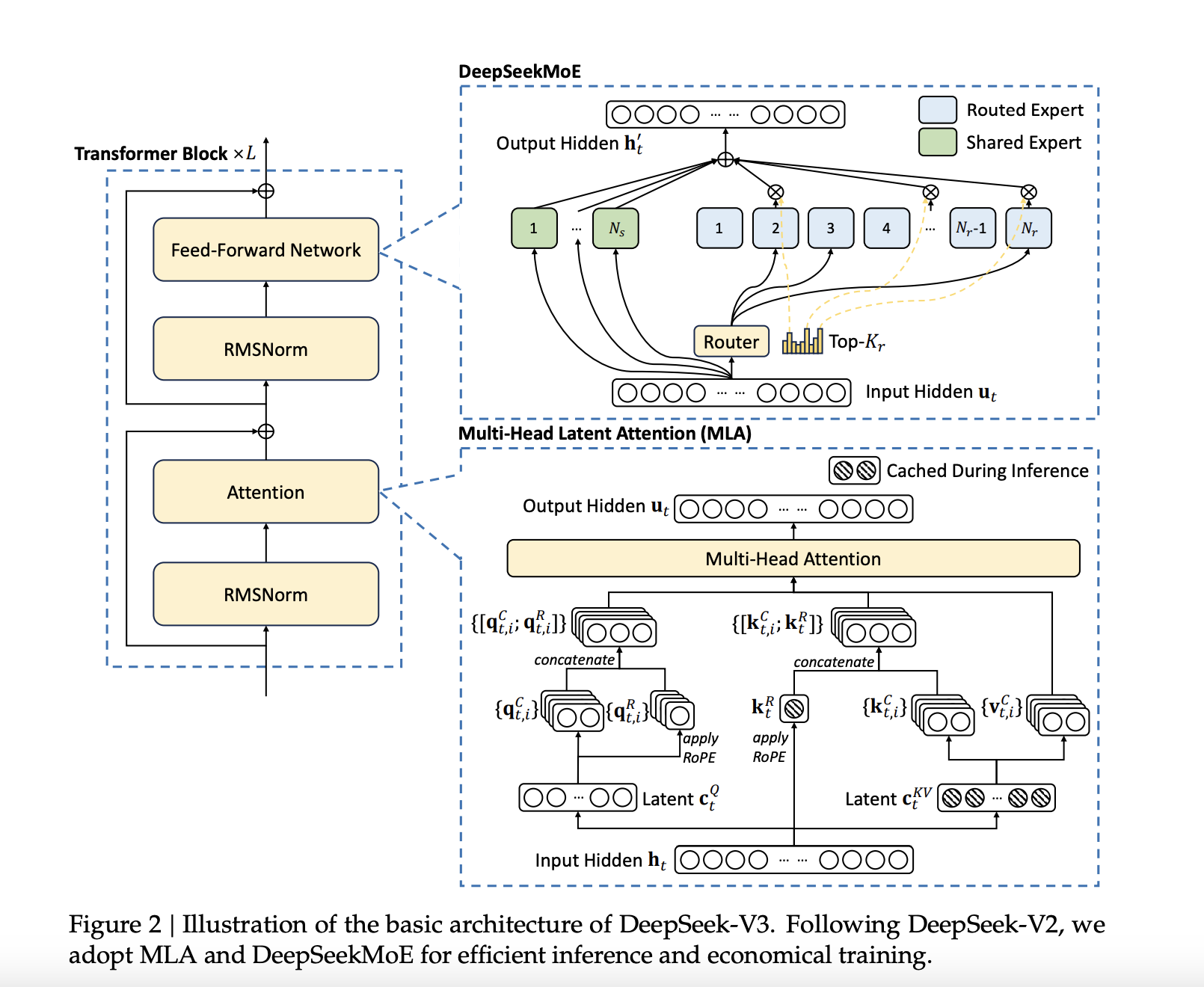

DeepSeek-AI has announced the release of DeepSeek-V3, a 671B Mixture-of-Experts (MoE) language model with 37B parameters activated per token. This latest model builds upon DeepSeek-AI's previous work on Multi-Head Latent Attention (MLA) and DeepSeekMoE architectures, which were refined in DeepSeek-V2 and DeepSeek-V2.5. DeepSeek-V3 is trained on a massive dataset of 14.8 trillion high-quality tokens, ensuring a broad and diverse knowledge base. Notably, DeepSeek-V3 is fully open-source, with accessible models, papers, and training frameworks for the research community to explore.

DeepSeek-AI は、トークンごとに有効化される 37B パラメーターを備えた 671B Mixture-of-Experts (MoE) 言語モデルである DeepSeek-V3 のリリースを発表しました。この最新モデルは、DeepSeek-V2 および DeepSeek-V2.5 で洗練された、マルチヘッド潜在注意 (MLA) および DeepSeekMoE アーキテクチャに関する DeepSeek-AI の以前の研究に基づいて構築されています。 DeepSeek-V3 は、14.8 兆の高品質トークンからなる大規模なデータセットでトレーニングされており、広範で多様な知識ベースを保証します。特に、DeepSeek-V3 は完全にオープンソースであり、研究コミュニティが探索できるアクセス可能なモデル、論文、トレーニング フレームワークを備えています。

Technical Details and BenefitsSeveral innovations are incorporated into DeepSeek-V3 to address long-standing challenges in the field. An auxiliary-loss-free load balancing strategy efficiently distributes computational loads across experts while maintaining model performance. Moreover, a multi-token prediction training objective enhances data efficiency and enables faster inference through speculative decoding.

技術的な詳細と利点DeepSeek-V3 には、現場での長年の課題に対処するためのいくつかのイノベーションが組み込まれています。補助損失のない負荷分散戦略により、モデルのパフォーマンスを維持しながら、計算負荷をエキスパート全体に効率的に分散します。さらに、マルチトークン予測トレーニング目標によりデータ効率が向上し、投機的デコードによるより高速な推論が可能になります。

Additionally, FP8 mixed precision training improves computational efficiency by reducing GPU memory usage without sacrificing accuracy. The DualPipe algorithm further minimizes pipeline bubbles by overlapping computation and communication phases, reducing all-to-all communication overhead. These advancements allow DeepSeek-V3 to process 60 tokens per second during inference—a significant improvement over DeepSeek-V2.5.

さらに、FP8 混合精度トレーニングは、精度を犠牲にすることなく GPU メモリの使用量を削減することで、計算効率を向上させます。 DualPipe アルゴリズムは、計算フェーズと通信フェーズをオーバーラップさせることでパイプライン バブルをさらに最小限に抑え、全体対全体の通信オーバーヘッドを削減します。これらの進歩により、DeepSeek-V3 は推論中に 1 秒あたり 60 トークンを処理できるようになり、DeepSeek-V2.5 に比べて大幅に改善されました。

Performance Insights and ResultsDeepSeek-V3 is evaluated across multiple benchmarks, showcasing strong performance. On educational datasets like MMLU and MMLU-Pro, DeepSeek-V3 achieves scores of 88.5 and 75.9, respectively, outperforming other open-source models. In mathematical reasoning tasks, DeepSeek-V3 sets new standards with a score of 90.2 on MATH-500. The model also performs exceptionally in coding benchmarks such as LiveCodeBench.

パフォーマンスの洞察と結果DeepSeek-V3 は複数のベンチマークにわたって評価され、強力なパフォーマンスを示しています。 MMLU や MMLU-Pro などの教育データセットでは、DeepSeek-V3 はそれぞれ 88.5 と 75.9 のスコアを達成し、他のオープンソース モデルを上回りました。数学的推論タスクでは、DeepSeek-V3 は MATH-500 のスコア 90.2 という新しい基準を設定しました。このモデルは、LiveCodeBench などのコーディング ベンチマークでも優れたパフォーマンスを発揮します。

Despite these achievements, the training cost is kept relatively low at $5.576 million, requiring only 2.788 million H800 GPU hours. These results highlight DeepSeek-V3’s efficiency and its potential to make high-performance LLMs more accessible.

これらの成果にもかかわらず、トレーニング コストは 557 万 6000 ドルと比較的低く抑えられ、必要な H800 GPU 時間は 278 万 8000 時間のみです。これらの結果は、DeepSeek-V3 の効率性と、高性能 LLM をより利用しやすくする可能性を強調しています。

ConclusionDeepSeek-V3 marks a significant advancement in open-source NLP research. By tackling the computational and architectural challenges associated with large-scale language models, DeepSeek-AI establishes a new benchmark for efficiency and performance. DeepSeek-V3 sets a new standard for open-source LLMs, achieving a balance of performance and efficiency that makes it a competitive alternative to proprietary models. DeepSeek-AI's commitment to open-source development ensures that the broader research community can benefit from its advancements.

結論DeepSeek-V3 は、オープンソース NLP 研究における大きな進歩を示します。大規模な言語モデルに関連する計算上およびアーキテクチャ上の課題に取り組むことで、DeepSeek-AI は効率とパフォーマンスの新しいベンチマークを確立します。 DeepSeek-V3 は、オープンソース LLM の新しい標準を設定し、独自のモデルに代わる競争力のあるパフォーマンスと効率のバランスを実現します。 DeepSeek-AI のオープンソース開発への取り組みにより、より広範な研究コミュニティがその進歩から恩恵を受けることができます。

Check out the Paper, GitHub Page, and Model on Hugging Face. All credit for this research goes to the researchers of this project. Also, don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. Don’t Forget to join our 60k+ ML SubReddit.

ハグフェイスに関する論文、GitHub ページ、およびモデルをチェックしてください。この研究の功績はすべて、このプロジェクトの研究者に与えられます。また、Twitter で私たちをフォローし、Telegram チャンネルと LinkedIn グループに参加することも忘れないでください。 60,000 以上の ML SubReddit に忘れずに参加してください。

Trending: LG AI Research Releases EXAONE 3.5: Three Open-Source Bilingual Frontier AI-level Models

トレンド: LG AI Research が EXAONE 3.5 をリリース: 3 つのオープンソース バイリンガル フロンティア AI レベル モデル

免責事項:info@kdj.com

提供される情報は取引に関するアドバイスではありません。 kdj.com は、この記事で提供される情報に基づいて行われた投資に対して一切の責任を負いません。暗号通貨は変動性が高いため、十分な調査を行った上で慎重に投資することを強くお勧めします。

このウェブサイトで使用されているコンテンツが著作権を侵害していると思われる場合は、直ちに当社 (info@kdj.com) までご連絡ください。速やかに削除させていただきます。