|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

DeepSeek-V3 : un modèle de langage mixte d'experts 671B de DeepSeek-AI

Dec 27, 2024 at 12:32 pm

Le domaine du traitement du langage naturel (NLP) a fait des progrès significatifs avec le développement de modèles de langage à grande échelle (LLM). Cependant, ces progrès ont apporté leur lot de défis. La formation et l'inférence nécessitent des ressources informatiques substantielles, la disponibilité d'ensembles de données diversifiés et de haute qualité est essentielle et parvenir à une utilisation équilibrée dans les architectures mixtes d'experts (MoE) reste complexe. Ces facteurs contribuent à l'inefficacité et à l'augmentation des coûts, posant des obstacles à la mise à l'échelle des modèles open source pour correspondre à leurs homologues propriétaires. De plus, garantir la robustesse et la stabilité pendant l’entraînement est un problème permanent, car même des instabilités mineures peuvent perturber les performances et nécessiter des interventions coûteuses.

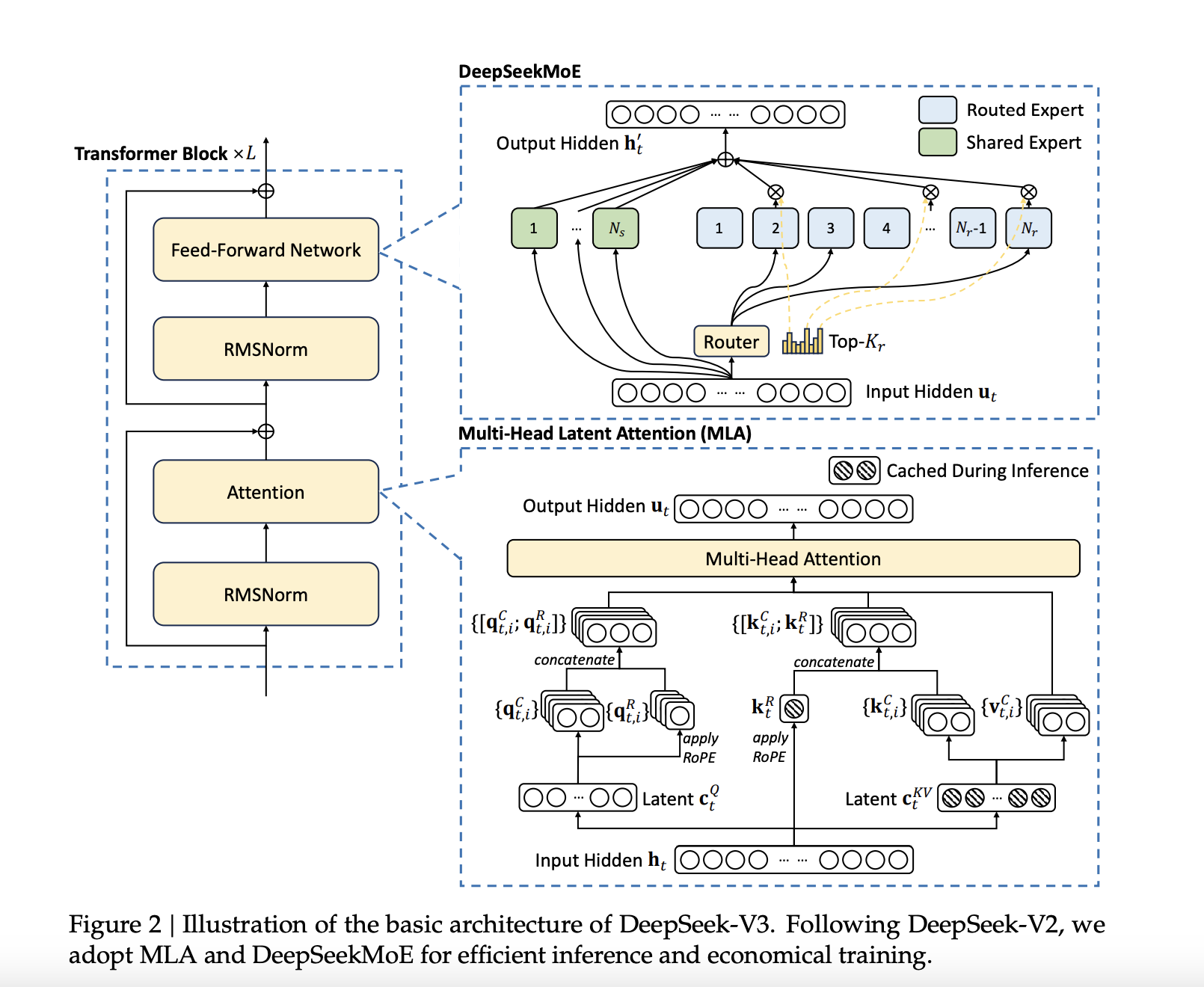

DeepSeek-AI has announced the release of DeepSeek-V3, a 671B Mixture-of-Experts (MoE) language model with 37B parameters activated per token. This latest model builds upon DeepSeek-AI's previous work on Multi-Head Latent Attention (MLA) and DeepSeekMoE architectures, which were refined in DeepSeek-V2 and DeepSeek-V2.5. DeepSeek-V3 is trained on a massive dataset of 14.8 trillion high-quality tokens, ensuring a broad and diverse knowledge base. Notably, DeepSeek-V3 is fully open-source, with accessible models, papers, and training frameworks for the research community to explore.

DeepSeek-AI a annoncé la sortie de DeepSeek-V3, un modèle de langage Mixture-of-Experts (MoE) 671B avec 37B de paramètres activés par jeton. Ce dernier modèle s'appuie sur les travaux antérieurs de DeepSeek-AI sur les architectures Multi-Head Latent Attention (MLA) et DeepSeekMoE, qui ont été affinés dans DeepSeek-V2 et DeepSeek-V2.5. DeepSeek-V3 est formé sur un ensemble de données massif de 14 800 milliards de jetons de haute qualité, garantissant une base de connaissances large et diversifiée. Notamment, DeepSeek-V3 est entièrement open source, avec des modèles, des articles et des cadres de formation accessibles que la communauté des chercheurs peut explorer.

Technical Details and BenefitsSeveral innovations are incorporated into DeepSeek-V3 to address long-standing challenges in the field. An auxiliary-loss-free load balancing strategy efficiently distributes computational loads across experts while maintaining model performance. Moreover, a multi-token prediction training objective enhances data efficiency and enables faster inference through speculative decoding.

Détails techniques et avantages Plusieurs innovations sont intégrées dans DeepSeek-V3 pour relever les défis de longue date dans le domaine. Une stratégie d'équilibrage de charge auxiliaire sans perte répartit efficacement les charges de calcul entre les experts tout en maintenant les performances du modèle. De plus, un objectif de formation à la prédiction multi-jetons améliore l’efficacité des données et permet une inférence plus rapide grâce au décodage spéculatif.

Additionally, FP8 mixed precision training improves computational efficiency by reducing GPU memory usage without sacrificing accuracy. The DualPipe algorithm further minimizes pipeline bubbles by overlapping computation and communication phases, reducing all-to-all communication overhead. These advancements allow DeepSeek-V3 to process 60 tokens per second during inference—a significant improvement over DeepSeek-V2.5.

De plus, l'entraînement de précision mixte FP8 améliore l'efficacité des calculs en réduisant l'utilisation de la mémoire GPU sans sacrifier la précision. L'algorithme DualPipe minimise davantage les bulles de pipeline en chevauchant les phases de calcul et de communication, réduisant ainsi la surcharge de communication globale. Ces avancées permettent à DeepSeek-V3 de traiter 60 jetons par seconde pendant l'inférence, soit une amélioration significative par rapport à DeepSeek-V2.5.

Performance Insights and ResultsDeepSeek-V3 is evaluated across multiple benchmarks, showcasing strong performance. On educational datasets like MMLU and MMLU-Pro, DeepSeek-V3 achieves scores of 88.5 and 75.9, respectively, outperforming other open-source models. In mathematical reasoning tasks, DeepSeek-V3 sets new standards with a score of 90.2 on MATH-500. The model also performs exceptionally in coding benchmarks such as LiveCodeBench.

Performance Insights et ResultsDeepSeek-V3 est évalué sur plusieurs critères, démontrant de solides performances. Sur des ensembles de données éducatives comme MMLU et MMLU-Pro, DeepSeek-V3 obtient des scores de 88,5 et 75,9, respectivement, surpassant les autres modèles open source. Dans les tâches de raisonnement mathématique, DeepSeek-V3 établit de nouvelles normes avec un score de 90,2 sur MATH-500. Le modèle fonctionne également exceptionnellement dans les tests de codage tels que LiveCodeBench.

Despite these achievements, the training cost is kept relatively low at $5.576 million, requiring only 2.788 million H800 GPU hours. These results highlight DeepSeek-V3’s efficiency and its potential to make high-performance LLMs more accessible.

Malgré ces réalisations, le coût de la formation reste relativement faible à 5,576 millions de dollars, ne nécessitant que 2,788 millions d'heures de GPU H800. Ces résultats mettent en évidence l'efficacité de DeepSeek-V3 et son potentiel à rendre les LLM hautes performances plus accessibles.

ConclusionDeepSeek-V3 marks a significant advancement in open-source NLP research. By tackling the computational and architectural challenges associated with large-scale language models, DeepSeek-AI establishes a new benchmark for efficiency and performance. DeepSeek-V3 sets a new standard for open-source LLMs, achieving a balance of performance and efficiency that makes it a competitive alternative to proprietary models. DeepSeek-AI's commitment to open-source development ensures that the broader research community can benefit from its advancements.

ConclusionDeepSeek-V3 marque une avancée significative dans la recherche open source en PNL. En relevant les défis informatiques et architecturaux associés aux modèles de langage à grande échelle, DeepSeek-AI établit une nouvelle référence en matière d'efficacité et de performances. DeepSeek-V3 établit une nouvelle norme pour les LLM open source, atteignant un équilibre entre performances et efficacité qui en fait une alternative compétitive aux modèles propriétaires. L'engagement de DeepSeek-AI en faveur du développement open source garantit que la communauté de recherche au sens large peut bénéficier de ses avancées.

Check out the Paper, GitHub Page, and Model on Hugging Face. All credit for this research goes to the researchers of this project. Also, don’t forget to follow us on Twitter and join our Telegram Channel and LinkedIn Group. Don’t Forget to join our 60k+ ML SubReddit.

Consultez le document, la page GitHub et le modèle sur Hugging Face. Tout le mérite de cette recherche revient aux chercheurs de ce projet. N'oubliez pas non plus de nous suivre sur Twitter et de rejoindre notre chaîne Telegram et notre groupe LinkedIn. N'oubliez pas de rejoindre notre SubReddit de plus de 60 000 ML.

Trending: LG AI Research Releases EXAONE 3.5: Three Open-Source Bilingual Frontier AI-level Models

Tendance : LG AI Research publie EXAONE 3.5 : trois modèles Open Source bilingues de niveau IA Frontier

Clause de non-responsabilité:info@kdj.com

Les informations fournies ne constituent pas des conseils commerciaux. kdj.com n’assume aucune responsabilité pour les investissements effectués sur la base des informations fournies dans cet article. Les crypto-monnaies sont très volatiles et il est fortement recommandé d’investir avec prudence après une recherche approfondie!

Si vous pensez que le contenu utilisé sur ce site Web porte atteinte à vos droits d’auteur, veuillez nous contacter immédiatement (info@kdj.com) et nous le supprimerons dans les plus brefs délais.

-

- Le prix Avalanche (AVAX) sort de la chute du modèle de coin, ciblant 25 $ à 26 $ de résistance

- Apr 05, 2025 at 12:40 pm

- Avax Price connaît un renversement haussier alors qu'il sort d'un modèle de coin en baisse. Le jeton a fait un mouvement à la hausse significatif après avoir atteint une zone de prix critique.

-

- XRP a eu du mal à dépasser 2,5 $ malgré le fort élan du marché. Pendant ce temps, Ozak AI ($ OZ) attire l'attention en tant que jeton d'évasion potentiel.

- Apr 05, 2025 at 12:40 pm

- XRP est resté un acteur dominant dans les paiements transfrontaliers. Le jeton a connu une croissance régulière, mais elle continue de faire face à une résistance à 2,5 $ et des stands inférieurs à 3 $.

-

- La surtension des prix XRP pourrait accroître la confiance des investisseurs dans les altcoins et ainsi augmenter la demande de Doge

- Apr 05, 2025 at 12:35 pm

- XRP se négocie actuellement à 2,07 $ et a besoin d'une augmentation de 142% pour atteindre 5 $. Si Dogecoin suit une trajectoire similaire, son taux passera de 0,1688 $ à 0,4218 $.

-

-

- Bitcoin (BTC) se négocie actuellement au-dessus du support critique

- Apr 05, 2025 at 12:30 pm

- Bitcoin se négocie actuellement au-dessus du soutien critique, mais les taureaux ont du mal à récupérer le niveau de 90000 $ - un seuil qui pourrait signaler le début d'un rassemblement de récupération significatif.

-

- Bitcoin (BTC) montre la résilience à mesure que le marché boursier diminue en raison des tarifs américains

- Apr 05, 2025 at 12:30 pm

- Alors que le marché boursier diminue en raison des tarifs américains sur la plupart de ses partenaires commerciaux, Bitcoin a montré une certaine résilience. Un expert de Unchained explique pourquoi.

-

- Avalanche (AVAX) gagne en confiance institutionnelle, certains prédisant une augmentation significative de sa valeur

- Apr 05, 2025 at 12:25 pm

- Cette projection ambitieuse survient à un moment où Ethereum (ETH) semble perdre son avantage, et la trajectoire de croissance d'Avalanche continue de s'accélérer.

-

- Comme avril apporte une nouvelle volatilité et une opportunité au marché de la cryptographie, les investisseurs réévaluent leurs portefeuilles

- Apr 05, 2025 at 12:25 pm

- Ce n'est pas seulement une autre opportunité d'investissement - c'est votre chance de faire partie de l'avenir de la finance. LightChain Ai redéfinit la façon dont la richesse est construite

-