|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

COT (Chain of-Thought) 프롬프트를 통해 달성 된 획기적인 발전에도 불구하고, LLMS (Lange Language Models)는 복잡한 추론 과제에서 중대한 도전에 직면 해 있습니다.

Large Language Models (LLMs) have made substantial progress in handling Chain-of-Thought (CoT) reasoning tasks, but they face challenges in terms of computational overhead, especially for longer CoT sequences. This directly affects inference latency and memory requirements.

대형 언어 모델 (LLM)은 COT (Chain of-Thought) 추론 작업을 처리하는 데 상당한 진전을 이루었지만, 특히 더 긴 COT 서열의 경우 계산 오버 헤드 측면에서 어려움에 직면 해 있습니다. 이는 추론 대기 시간 및 메모리 요구 사항에 직접적인 영향을 미칩니다.

Since LLM decoding is autoregressive in nature, as CoT sequences grow longer, there is a proportional increase in processing time and memory usage in attention layers where computational costs scale quadratically. Striking a balance between maintaining reasoning accuracy and computational efficiency has become a critical challenge, as attempts to reduce reasoning steps often compromise the model’s problem-solving capabilities.

LLM 디코딩은 본질적으로자가 회귀이기 때문에 COT 서열이 더 길어질수록 계산 비용이 차별적으로 규모가 높은주의 계층에서 처리 시간과 메모리 사용이 비례 적으로 증가합니다. 추론 단계를 줄이려는 시도는 종종 모델의 문제 해결 능력을 손상시키기 때문에 추론 정확도와 계산 효율성을 유지하는 것 사이의 균형을 유지하는 것은 중요한 과제가되었습니다.

To address the computational challenges of Chain-of-Thought (CoT) reasoning, various methodologies have been developed. Some approaches focus on streamlining the reasoning process by simplifying or skipping certain thinking steps, while others attempt to generate steps in parallel. A different strategy involves compressing reasoning steps into continuous latent representations, enabling LLMs to reason without generating explicit word tokens.

COT (Chain of-Thought) 추론의 계산 문제를 해결하기 위해 다양한 방법론이 개발되었습니다. 일부 접근법은 특정 사고 단계를 단순화하거나 건너 뛰어 추론 과정을 간소화하는 데 중점을 두는 반면, 다른 접근법은 단계를 동시에 생성하려고 시도합니다. 다른 전략은 추론 단계를 지속적인 잠재적 표현으로 압축하여 명시 적 단어 토큰을 생성하지 않고 LLM을 추론 할 수있게합니다.

Moreover, prompt compression techniques to handle complex instructions and long-context inputs more efficiently range from using lightweight language models to generate concise prompts, employing implicit continuous tokens for task representation, and implementing direct compression by filtering for high-informative tokens.

또한, 복잡한 지침 및 장기 텍스트 입력을 처리하기위한 신속한 압축 기술은 가벼운 언어 모델 사용에서 간결한 프롬프트 생성, 작업 표현을 위해 암시 적 연속 토큰을 사용하고, 고유성 토큰을 필터링하여 직접 압축을 구현하는 것까지보다 효율적으로 다양합니다.

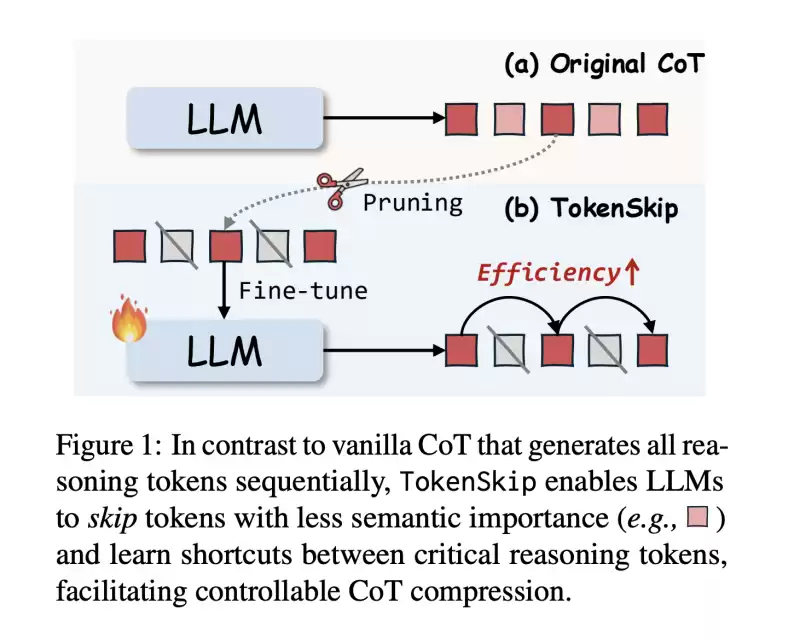

In this work, researchers from The Hong Kong Polytechnic University and the University of Science and Technology of China propose TokenSkip, an approach to optimize CoT processing in LLMs. It enables models to skip less important tokens within CoT sequences while maintaining connections between critical reasoning tokens, with adjustable compression ratios.

이 작업에서 홍콩 폴리 테크닉 대학교 (Hong Kong Polytechnic University)와 중국 과학 기술 대학 (University of China of China of China)의 연구원들은 LLM의 COT 처리를 최적화하는 접근법 인 Tokenskip을 제안합니다. 이를 통해 모델은 COT 서열 내에서 덜 중요한 토큰을 건너 뛸 수 있으며 조정 가능한 압축 비율로 중요한 추론 토큰 간의 연결을 유지할 수 있습니다.

The system works by first constructing compressed CoT training data through token pruning, followed by a supervised fine-tuning process. Initial testing across multiple models, including LLaMA-3.1-8B-Instruct and Qwen2.5-Instruct series shows promising results, particularly in maintaining reasoning capabilities while significantly reducing computational overhead.

이 시스템은 먼저 토큰 가지 치기를 통해 압축 된 COT 훈련 데이터를 구성하고 감독 된 미세 조정 공정을 구성하여 작동합니다. LLAMA-3.1-8B-비 구역 및 QWEN2.5- 비 구역 시리즈를 포함한 여러 모델에서 초기 테스트는 유망한 결과를 보여줍니다. 특히 추론 기능을 유지하면서 계산 오버 헤드를 크게 줄입니다.

The architecture of TokenSkip is built on the fundamental principle that different reasoning tokens contribute varying levels of importance to reaching the final answer. It consists of two main phases: training data preparation and inference.

Tokenskip의 아키텍처는 다른 추론 토큰이 최종 답변에 도달하는 데 다양한 수준의 중요성에 기여한다는 기본 원칙을 기반으로합니다. 교육 데이터 준비 및 추론의 두 가지 주요 단계로 구성됩니다.

During the training phase, the system generates CoT trajectories using the target LLM, and each remaining trajectory is pruned with a randomly selected compression ratio. The token pruning process is guided by an “importance scoring” mechanism, which assigns higher scores to tokens that are more critical for the final answer.

훈련 단계 동안, 시스템은 Target LLM을 사용하여 COT 궤적을 생성하고, 각각의 나머지 궤적은 무작위로 선택된 압축 비율로 정리됩니다. 토큰 가지 치기 프로세스는 "중요도 점수"메커니즘에 의해 안내되며,이 메커니즘은 최종 답변에 더 중요한 토큰에 더 높은 점수를 할당합니다.

At inference time, TokenSkip maintains the autoregressive decoding approach but enhances efficiency by enabling LLMs to skip less important tokens. The structure of the input format is such that the question and compression ratio get separated by end-of-sequence tokens.

추론 시간에 Tokenskip은 자동 회귀 디코딩 접근법을 유지하지만 LLM이 덜 중요한 토큰을 건너 뛸 수 있도록하여 효율성을 향상시킵니다. 입력 형식의 구조는 질문 및 압축 비율이 순회 종료 토큰으로 분리되는 것입니다.

The results show that larger language models are more capable of maintaining performance while achieving higher compression rates. The Qwen2.5-14B-Instruct model achieves remarkable results with only a 0.4% performance drop while reducing token usage by 40%.

결과는 더 큰 언어 모델이 더 높은 압축 속도를 달성하면서 성능을 유지할 수 있음을 보여줍니다. QWEN2.5-14B 강조 모델은 0.4% 성능 감소로 놀라운 결과를 달성하면서 토큰 사용량을 40% 줄입니다.

When compared with alternative approaches like prompt-based reduction and truncation, TokenSkip shows superior performance. While prompt-based reduction fails to achieve target compression ratios and truncation leads to significant performance degradation, TokenSkip maintains the specified compression ratio while preserving reasoning capabilities. On the MATH-500 dataset, it achieves a 30% reduction in token usage with less than a 4% performance drop.

프롬프트 기반 감소 및 잘림과 같은 대체 접근 방식과 비교할 때 Tokenskip은 우수한 성능을 보여줍니다. 프롬프트 기반 감소는 목표 압축 비율을 달성하지 못하고 잘린 성능 저하로 이어지지 만, Tokenskip은 추론 기능을 유지하면서 지정된 압축 비율을 유지합니다. MATH-500 데이터 세트에서는 성능이 4% 미만인 토큰 사용량이 30% 감소합니다.

In this paper, researchers introduce TokenSkip, a method that represents a significant advancement in optimizing CoT processing for LLMs by introducing a controllable compression mechanism based on token importance. The success of the method lies in maintaining reasoning accuracy while significantly reducing computational overhead by selectively preserving critical tokens and skipping less important ones. The approach has proven effective with LLMs, showing minimal performance degradation even at substantial compression ratios.

이 논문에서 연구원들은 토큰의 중요성에 기초한 제어 가능한 압축 메커니즘을 도입하여 LLM에 대한 COT 처리를 최적화하는 데 중요한 발전을 나타내는 Tokenskip을 소개합니다. 이 방법의 성공은 추론 정확도를 유지하는 동시에 중요한 토큰을 선택적으로 보존하고 덜 중요한 토큰을 건너 뛰면 계산 오버 헤드를 크게 줄이는 데 있습니다. 이 접근법은 LLMS에서 효과적인 것으로 입증되었으며, 상당한 압축 비율로도 성능 저하가 최소화됩니다.

This research opens new possibilities for advancing efficient reasoning in LLMs, establishing a foundation for future developments in computational efficiency while maintaining robust reasoning capabilities.

이 연구는 LLM의 효율적인 추론을 발전시킬 수있는 새로운 가능성을 열어주고 강력한 추론 능력을 유지하면서 계산 효율성의 미래 발전을위한 토대를 구축합니다.

Check out the Paper. All credit for this research goes to the researchers of this project. Also, feel free to follow us on Twitter and don’t forget to join our 75k+ ML SubReddit.

종이를 확인하십시오. 이 연구에 대한 모든 크레딧은이 프로젝트의 연구원들에게 전달됩니다. 또한 트위터에서 우리를 팔로우하고 75k+ ml 하위 레드에 가입하는 것을 잊지 마십시오.

부인 성명:info@kdj.com

제공된 정보는 거래 조언이 아닙니다. kdj.com은 이 기사에 제공된 정보를 기반으로 이루어진 투자에 대해 어떠한 책임도 지지 않습니다. 암호화폐는 변동성이 매우 높으므로 철저한 조사 후 신중하게 투자하는 것이 좋습니다!

본 웹사이트에 사용된 내용이 귀하의 저작권을 침해한다고 판단되는 경우, 즉시 당사(info@kdj.com)로 연락주시면 즉시 삭제하도록 하겠습니다.