|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Articles d’actualité sur les crypto-monnaies

Tokenskip: Optimisation du traitement de la chaîne de pensées dans des modèles de grande langue

Feb 23, 2025 at 08:50 am

Malgré les avancées révolutionnaires réalisées grâce à une invitation à la chaîne de pensées (COT), les modèles de grands langues (LLM) sont confrontés à des défis importants dans les tâches de raisonnement complexes.

Large Language Models (LLMs) have made substantial progress in handling Chain-of-Thought (CoT) reasoning tasks, but they face challenges in terms of computational overhead, especially for longer CoT sequences. This directly affects inference latency and memory requirements.

Les modèles de grandes langues (LLM) ont fait des progrès substantiels dans la manipulation des tâches de raisonnement en chaîne (COT), mais elles sont confrontées à des défis en termes de frais généraux de calcul, en particulier pour les séquences de COT plus longues. Cela affecte directement les exigences de latence et de la mémoire d'inférence.

Since LLM decoding is autoregressive in nature, as CoT sequences grow longer, there is a proportional increase in processing time and memory usage in attention layers where computational costs scale quadratically. Striking a balance between maintaining reasoning accuracy and computational efficiency has become a critical challenge, as attempts to reduce reasoning steps often compromise the model’s problem-solving capabilities.

Étant donné que le décodage LLM est de nature autorégressive, à mesure que les séquences de COT se développent plus longtemps, il y a une augmentation proportionnelle du temps de traitement et de l'utilisation de la mémoire dans les couches d'attention où les coûts de calcul sont à l'échelle quadratique. La suppression d'un équilibre entre le maintien de la précision du raisonnement et l'efficacité de calcul est devenue un défi essentiel, car les tentatives de réduction des étapes de raisonnement compromettent souvent les capacités de résolution de problèmes du modèle.

To address the computational challenges of Chain-of-Thought (CoT) reasoning, various methodologies have been developed. Some approaches focus on streamlining the reasoning process by simplifying or skipping certain thinking steps, while others attempt to generate steps in parallel. A different strategy involves compressing reasoning steps into continuous latent representations, enabling LLMs to reason without generating explicit word tokens.

Pour relever les défis de calcul du raisonnement de la chaîne de pensées (COT), diverses méthodologies ont été développées. Certaines approches se concentrent sur la rationalisation du processus de raisonnement en simplifiant ou en sautant certaines étapes de réflexion, tandis que d'autres tentent de générer des étapes en parallèle. Une stratégie différente consiste à compresser les étapes de raisonnement en représentations latentes continues, permettant aux LLM de raisonner sans générer des jetons de mots explicites.

Moreover, prompt compression techniques to handle complex instructions and long-context inputs more efficiently range from using lightweight language models to generate concise prompts, employing implicit continuous tokens for task representation, and implementing direct compression by filtering for high-informative tokens.

De plus, les techniques de compression provités pour gérer les instructions complexes et les entrées de contexte à long terme vont plus efficacement de l'utilisation de modèles de langage léger pour générer des invites concises, en utilisant des jetons continus implicites pour la représentation des tâches et en mettant en œuvre une compression directe en filtrant les jetons élevés.

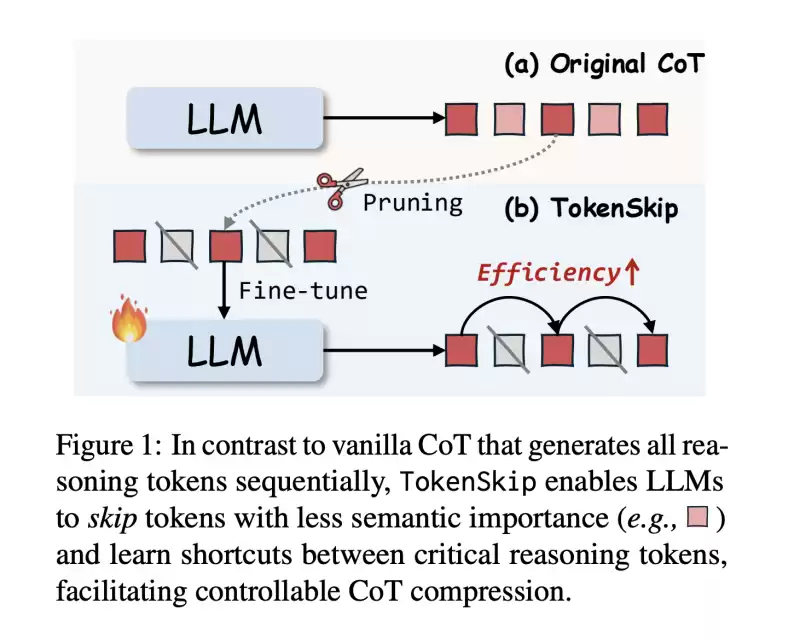

In this work, researchers from The Hong Kong Polytechnic University and the University of Science and Technology of China propose TokenSkip, an approach to optimize CoT processing in LLMs. It enables models to skip less important tokens within CoT sequences while maintaining connections between critical reasoning tokens, with adjustable compression ratios.

Dans ce travail, des chercheurs de l'Université polytechnique de Hong Kong et de l'Université des sciences et de la technologie de Chine proposent Tokenskip, une approche pour optimiser le traitement du COT dans les LLM. Il permet aux modèles de sauter des jetons moins importants dans les séquences de COT tout en maintenant des connexions entre les jetons de raisonnement critiques, avec des rapports de compression réglables.

The system works by first constructing compressed CoT training data through token pruning, followed by a supervised fine-tuning process. Initial testing across multiple models, including LLaMA-3.1-8B-Instruct and Qwen2.5-Instruct series shows promising results, particularly in maintaining reasoning capabilities while significantly reducing computational overhead.

Le système fonctionne en construisant d'abord des données de formation de lit de lit comprimé par l'élagage des jetons, suivi d'un processus de réglage fin supervisé. Les tests initiaux sur plusieurs modèles, y compris les séries LLAMA-3.1-8B-Istruct et Qwen2.5-Istruct, montrent des résultats prometteurs, en particulier pour maintenir les capacités de raisonnement tout en réduisant considérablement les frais généraux de calcul.

The architecture of TokenSkip is built on the fundamental principle that different reasoning tokens contribute varying levels of importance to reaching the final answer. It consists of two main phases: training data preparation and inference.

L'architecture de Tokenskip est construite sur le principe fondamental selon lequel différents jetons de raisonnement contribuent à des niveaux variables d'importance pour atteindre la réponse finale. Il se compose de deux phases principales: la préparation et l'inférence des données de formation.

During the training phase, the system generates CoT trajectories using the target LLM, and each remaining trajectory is pruned with a randomly selected compression ratio. The token pruning process is guided by an “importance scoring” mechanism, which assigns higher scores to tokens that are more critical for the final answer.

Pendant la phase d'entraînement, le système génère des trajectoires de COT en utilisant le LLM cible, et chaque trajectoire restante est élaguée avec un rapport de compression sélectionné au hasard. Le processus d'élagage des jetons est guidé par un mécanisme de «notation d'importance», qui attribue des scores plus élevés aux jetons qui sont plus critiques pour la réponse finale.

At inference time, TokenSkip maintains the autoregressive decoding approach but enhances efficiency by enabling LLMs to skip less important tokens. The structure of the input format is such that the question and compression ratio get separated by end-of-sequence tokens.

Au moment de l'inférence, Tokenskip maintient l'approche de décodage autorégressive mais améliore l'efficacité en permettant aux LLMS de sauter des jetons moins importants. La structure du format d'entrée est telle que le rapport de question et de compression est séparé par les jetons de fin de séquence.

The results show that larger language models are more capable of maintaining performance while achieving higher compression rates. The Qwen2.5-14B-Instruct model achieves remarkable results with only a 0.4% performance drop while reducing token usage by 40%.

Les résultats montrent que les modèles de langage plus importants sont plus capables de maintenir les performances tout en atteignant des taux de compression plus élevés. Le modèle d'instruct QWEN2.5-14B obtient des résultats remarquables avec seulement une baisse des performances de 0,4% tout en réduisant l'utilisation de jetons de 40%.

When compared with alternative approaches like prompt-based reduction and truncation, TokenSkip shows superior performance. While prompt-based reduction fails to achieve target compression ratios and truncation leads to significant performance degradation, TokenSkip maintains the specified compression ratio while preserving reasoning capabilities. On the MATH-500 dataset, it achieves a 30% reduction in token usage with less than a 4% performance drop.

Par rapport aux approches alternatives telles que la réduction et la troncature basées sur une invite, Tokenskip montre des performances supérieures. Bien que la réduction basée sur une invite ne parvienne pas à atteindre des ratios de compression cible et que la troncature entraîne une dégradation significative des performances, Tokenskip maintient le rapport de compression spécifié tout en préservant les capacités de raisonnement. Sur l'ensemble de données MATH-500, il réalise une réduction de 30% de l'utilisation des jetons avec moins d'une baisse de performances de 4%.

In this paper, researchers introduce TokenSkip, a method that represents a significant advancement in optimizing CoT processing for LLMs by introducing a controllable compression mechanism based on token importance. The success of the method lies in maintaining reasoning accuracy while significantly reducing computational overhead by selectively preserving critical tokens and skipping less important ones. The approach has proven effective with LLMs, showing minimal performance degradation even at substantial compression ratios.

Dans cet article, les chercheurs présentent Tokenskip, une méthode qui représente une progression significative dans l'optimisation du traitement du COT pour les LLM en introduisant un mécanisme de compression contrôlable basé sur l'importance des jetons. Le succès de la méthode réside dans le maintien de la précision du raisonnement tout en réduisant considérablement les frais généraux de calcul en préservant sélectivement les jetons critiques et en sautant les moins importants. L'approche s'est avérée efficace avec les LLM, montrant une dégradation minimale des performances même à des ratios de compression substantiels.

This research opens new possibilities for advancing efficient reasoning in LLMs, establishing a foundation for future developments in computational efficiency while maintaining robust reasoning capabilities.

Cette recherche ouvre de nouvelles possibilités pour faire progresser un raisonnement efficace dans les LLM, établissant une base pour les développements futurs de l'efficacité informatique tout en conservant des capacités de raisonnement robustes.

Check out the Paper. All credit for this research goes to the researchers of this project. Also, feel free to follow us on Twitter and don’t forget to join our 75k+ ML SubReddit.

Découvrez le papier. Tout le mérite de cette recherche revient aux chercheurs de ce projet. N'hésitez pas à nous suivre sur Twitter et n'oubliez pas de rejoindre notre Sandredit 75K + ML.

Clause de non-responsabilité:info@kdj.com

Les informations fournies ne constituent pas des conseils commerciaux. kdj.com n’assume aucune responsabilité pour les investissements effectués sur la base des informations fournies dans cet article. Les crypto-monnaies sont très volatiles et il est fortement recommandé d’investir avec prudence après une recherche approfondie!

Si vous pensez que le contenu utilisé sur ce site Web porte atteinte à vos droits d’auteur, veuillez nous contacter immédiatement (info@kdj.com) et nous le supprimerons dans les plus brefs délais.

-

-

-

-

-

-

-

-

- Verdict: immédiate Lura propose une solution de trading intelligente et rationalisée

- Apr 04, 2025 at 04:30 pm

- Entrée: Verdict: immédiate Lura propose une solution de trading intelligente et rationalisée qui combine l'automatisation intelligente avec des fonctionnalités multi-échanges. Son logiciel propulsé par l'IA supprime la conjecture de la négociation, scannera les données du marché et exécuter les transactions à des moments optimaux. La plate-forme, par conséquent, offre une approche de trading stratégique cohérente qui fonctionne en synchronisation avec vos objectifs.

-