|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Nachrichtenartikel zu Kryptowährungen

TOKENSKIP: Optimierung der Gedankenverarbeitung der Kette in Großsprachenmodellen

Feb 23, 2025 at 08:50 am

Trotz der durchbrachenden Fortschritte, die durch die Aufforderung der Kette (COT) erzielt werden, stehen große Sprachmodelle (LLMs) bei komplexen Argumentationsaufgaben vor erheblichen Herausforderungen.

Large Language Models (LLMs) have made substantial progress in handling Chain-of-Thought (CoT) reasoning tasks, but they face challenges in terms of computational overhead, especially for longer CoT sequences. This directly affects inference latency and memory requirements.

Große Sprachmodelle (LLMs) haben erhebliche Fortschritte bei der Umstellung der Kette der Gedanken (COT) Argumentation gemacht, sind jedoch in Bezug auf den Rechenaufwand, insbesondere für längere COT-Sequenzen, Herausforderungen gegenüber. Dies wirkt sich direkt auf Inferenzlatenz- und Speicheranforderungen aus.

Since LLM decoding is autoregressive in nature, as CoT sequences grow longer, there is a proportional increase in processing time and memory usage in attention layers where computational costs scale quadratically. Striking a balance between maintaining reasoning accuracy and computational efficiency has become a critical challenge, as attempts to reduce reasoning steps often compromise the model’s problem-solving capabilities.

Da die LLM -Dekodierung autoregressiv ist, da die COT -Sequenzen länger wachsen, erhöht sich die Verarbeitungszeit und die Speicherverwendung in Aufmerksamkeitsebenen, bei denen die Rechenkosten quadratisch skalieren. Ein Gleichgewicht zwischen der Aufrechterhaltung der Genauigkeit der Argumentation und der Recheneffizienz ist zu einer kritischen Herausforderung geworden, da Versuche, Argumentationsschritte zu reduzieren, häufig die Fähigkeiten zur Problemlösung des Modells beeinträchtigen.

To address the computational challenges of Chain-of-Thought (CoT) reasoning, various methodologies have been developed. Some approaches focus on streamlining the reasoning process by simplifying or skipping certain thinking steps, while others attempt to generate steps in parallel. A different strategy involves compressing reasoning steps into continuous latent representations, enabling LLMs to reason without generating explicit word tokens.

Um die rechnerischen Herausforderungen des Denkens der Kette (COT) zu bewältigen, wurden verschiedene Methoden entwickelt. Einige Ansätze konzentrieren sich darauf, den Argumentationsprozess zu optimieren, indem bestimmte Denkschritte vereinfacht oder überspringen, während andere versuchen, parallele Schritte zu erzeugen. Eine andere Strategie beinhaltet die Komprimierung von Argumentationsschritten in kontinuierliche latente Darstellungen und ermöglicht LLMs, die Argumente ohne explizite Wort -Token zu erzeugen.

Moreover, prompt compression techniques to handle complex instructions and long-context inputs more efficiently range from using lightweight language models to generate concise prompts, employing implicit continuous tokens for task representation, and implementing direct compression by filtering for high-informative tokens.

Darüber hinaus reichen die sofortigen Komprimierungstechniken zum Umgang mit komplexen Anweisungen und den effizienten Langkontext-Eingängen von der Verwendung von leichten Sprachmodellen, um kurze Eingabeaufforderungen zu generieren, implizite kontinuierliche Token für die Aufgabendarstellung zu verwenden und die direkte Komprimierung durch Filterung für hoch informative Token zu implementieren.

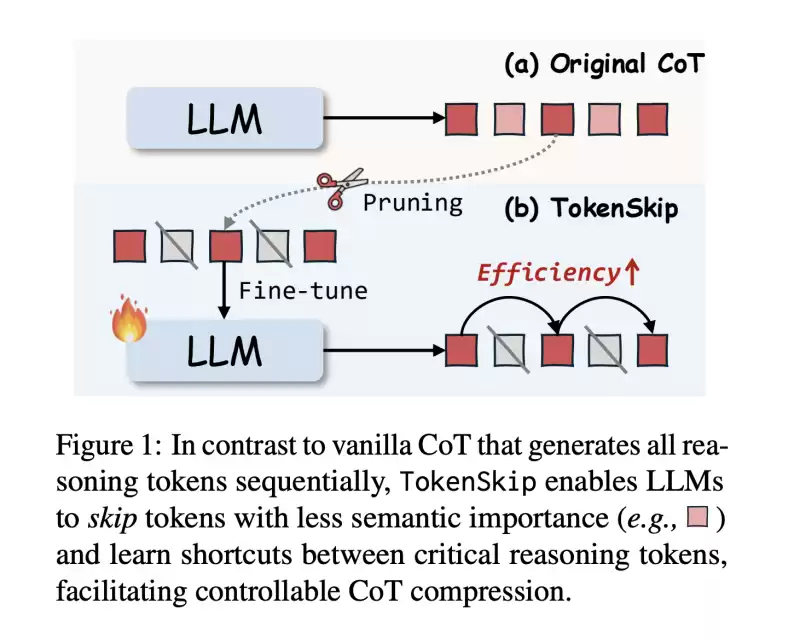

In this work, researchers from The Hong Kong Polytechnic University and the University of Science and Technology of China propose TokenSkip, an approach to optimize CoT processing in LLMs. It enables models to skip less important tokens within CoT sequences while maintaining connections between critical reasoning tokens, with adjustable compression ratios.

In dieser Arbeit schlagen Forscher der Hongkong Polytechnic University und der Universität für Wissenschaft und Technologie Chinas Tkenskip vor, einen Ansatz zur Optimierung der COT -Verarbeitung in LLMs. Es ermöglicht Modellen, weniger wichtige Token innerhalb von COT -Sequenzen zu überspringen und gleichzeitig Verbindungen zwischen kritischen Argumentations -Token mit einstellbaren Komprimierungsverhältnissen aufrechtzuerhalten.

The system works by first constructing compressed CoT training data through token pruning, followed by a supervised fine-tuning process. Initial testing across multiple models, including LLaMA-3.1-8B-Instruct and Qwen2.5-Instruct series shows promising results, particularly in maintaining reasoning capabilities while significantly reducing computational overhead.

Das System erstellt zuerst komprimierte Cot-Trainingsdaten durch Token-Beschneidung, gefolgt von einem beaufsichtigten Feinabstimmungsprozess. Erste Tests über mehrere Modelle hinweg, einschließlich Lama-3,1-8B-Instruction und QWEN2.5-Instruct-Serien, zeigen vielversprechende Ergebnisse, insbesondere bei der Aufrechterhaltung von Argumentationsfunktionen und gleichzeitig die Verringerung der Rechenaufwand.

The architecture of TokenSkip is built on the fundamental principle that different reasoning tokens contribute varying levels of importance to reaching the final answer. It consists of two main phases: training data preparation and inference.

Die Architektur von Tokenskip basiert auf dem Grundprinzip, dass verschiedene Argumentationstoken unterschiedliche Bedeutung für die Erreichung der endgültigen Antwort beitragen. Es besteht aus zwei Hauptphasen: Trainingsdatenvorbereitung und Schlussfolgerung.

During the training phase, the system generates CoT trajectories using the target LLM, and each remaining trajectory is pruned with a randomly selected compression ratio. The token pruning process is guided by an “importance scoring” mechanism, which assigns higher scores to tokens that are more critical for the final answer.

Während der Trainingsphase erzeugt das System COT -Trajektorien unter Verwendung des Ziel -LLM, und jede verbleibende Flugbahn wird mit einem zufällig ausgewählten Komprimierungsverhältnis beschnitten. Der Token -Schnittprozess leitet sich von einem Mechanismus „Wichtigkeitsbewertung“, der Token höhere Ergebnisse zuweist, die für die endgültige Antwort kritischer sind.

At inference time, TokenSkip maintains the autoregressive decoding approach but enhances efficiency by enabling LLMs to skip less important tokens. The structure of the input format is such that the question and compression ratio get separated by end-of-sequence tokens.

Zum Zeitpunkt der Inferenz behält Tokenskip den autoregressiven Dekodierungsansatz bei, erhöht jedoch die Effizienz, indem es LLMs ermöglicht, weniger wichtige Token zu überspringen. Die Struktur des Eingangsformates ist so, dass das Frage- und Komprimierungsverhältnis durch Token am Ende der Sequenz getrennt wird.

The results show that larger language models are more capable of maintaining performance while achieving higher compression rates. The Qwen2.5-14B-Instruct model achieves remarkable results with only a 0.4% performance drop while reducing token usage by 40%.

Die Ergebnisse zeigen, dass größere Sprachmodelle in der Lage sind, die Leistung aufrechtzuerhalten und gleichzeitig höhere Komprimierungsraten zu erzielen. Das QWEN2.5-14B-Instruct-Modell erzielt bemerkenswerte Ergebnisse mit nur einem Leistungsabfall von 0,4%, während die Token-Nutzung um 40% verringert wird.

When compared with alternative approaches like prompt-based reduction and truncation, TokenSkip shows superior performance. While prompt-based reduction fails to achieve target compression ratios and truncation leads to significant performance degradation, TokenSkip maintains the specified compression ratio while preserving reasoning capabilities. On the MATH-500 dataset, it achieves a 30% reduction in token usage with less than a 4% performance drop.

Im Vergleich zu alternativen Ansätzen wie prompt-basierter Reduktion und Kürzung zeigt Tokenskip eine überlegene Leistung. Während die sofortige Reduktion nicht zu einer Zielkomprimierungsverhältnissen führt und die Kürzung zu einem signifikanten Leistungsverschlechterung führt, behält TOKENSKIP das angegebene Komprimierungsverhältnis bei und erhalten gleichzeitig die Argumentationsfunktionen. Im Math-500-Datensatz erreicht es eine Reduzierung der Token-Nutzung um 30% mit weniger als 4% Leistungsrückgang.

In this paper, researchers introduce TokenSkip, a method that represents a significant advancement in optimizing CoT processing for LLMs by introducing a controllable compression mechanism based on token importance. The success of the method lies in maintaining reasoning accuracy while significantly reducing computational overhead by selectively preserving critical tokens and skipping less important ones. The approach has proven effective with LLMs, showing minimal performance degradation even at substantial compression ratios.

In diesem Artikel stellen Forscher Tokenskip ein, eine Methode, die einen signifikanten Fortschritt bei der Optimierung der COT -Verarbeitung für LLMs darstellt, indem ein kontrollierbarer Komprimierungsmechanismus auf der Grundlage einer Token -Bedeutung eingeführt wird. Der Erfolg der Methode besteht darin, die Genauigkeit der Argumentation aufrechtzuerhalten und gleichzeitig die Rechenaufwand durch selektiv kritische Token zu verringern und weniger wichtige zu überspringen. Der Ansatz hat sich bei LLMs als wirksam erwiesen und zeigt auch bei erheblichen Komprimierungsverhältnissen einen minimalen Leistungsverschlechterung.

This research opens new possibilities for advancing efficient reasoning in LLMs, establishing a foundation for future developments in computational efficiency while maintaining robust reasoning capabilities.

Diese Forschung eröffnet neue Möglichkeiten, um effizientes Denken in LLMs zu fördern, eine Grundlage für zukünftige Entwicklungen bei der Recheneffizienz und gleichzeitig robuste Argumentationsfähigkeiten.

Check out the Paper. All credit for this research goes to the researchers of this project. Also, feel free to follow us on Twitter and don’t forget to join our 75k+ ML SubReddit.

Schauen Sie sich das Papier an. Alle Krediten für diese Forschung gilt an die Forscher dieses Projekts. Sie können uns auch gerne auf Twitter folgen und vergessen Sie nicht, unseren 75.000+ ML Subreddit beizutreten.

Haftungsausschluss:info@kdj.com

Die bereitgestellten Informationen stellen keine Handelsberatung dar. kdj.com übernimmt keine Verantwortung für Investitionen, die auf der Grundlage der in diesem Artikel bereitgestellten Informationen getätigt werden. Kryptowährungen sind sehr volatil und es wird dringend empfohlen, nach gründlicher Recherche mit Vorsicht zu investieren!

Wenn Sie glauben, dass der auf dieser Website verwendete Inhalt Ihr Urheberrecht verletzt, kontaktieren Sie uns bitte umgehend (info@kdj.com) und wir werden ihn umgehend löschen.

-

- Duba, VAE, 3. April 2025, Chainwire

- Apr 03, 2025 at 11:00 pm

- Dfusion AI, eine wegweisende dezentrale KI

-

- Memeereum enthüllt Memescan Beta, ein neuer Blockchain-Explorer zur Verbesserung der Transparenz auf Ketten

- Apr 03, 2025 at 11:00 pm

- Memeereum hat die Memescan-Beta offiziell vorgestellt-ein neuer Blockchain-Explorer, der die Transparenz der Onketten verbessern, das Vertrauen der Benutzer stärkt und den Weg für eine verantwortungsivere Defi-Erfahrung ebnet.

-

-

-

-

-

- Jack Dorsey warnt, dass Bitcoin (BTC) sein offenes Ethos verlieren könnte, wenn institutionelle Investitionen wachsen

- Apr 03, 2025 at 10:45 pm

- In einem „21 und 21“ -Rapid-Fire-Interview mit Haley Berkoe im Presidio Bitcoin Workspace von San Francisco-CEO von Block und ehemaliger Twitter-Chef-konnten die wachsende Beliebtheit der BTC unter großen Finanzinstitutionen die offene Kryptokurie der Welt bedrohen.

-

-