|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

チェーンオブ考え(COT)プロンプトを通じて達成された画期的な進歩にもかかわらず、大規模な言語モデル(LLM)は複雑な推論タスクにおいて大きな課題に直面しています。

Large Language Models (LLMs) have made substantial progress in handling Chain-of-Thought (CoT) reasoning tasks, but they face challenges in terms of computational overhead, especially for longer CoT sequences. This directly affects inference latency and memory requirements.

大規模な言語モデル(LLMS)は、チェーンオブ思考(COT)の推論タスクの処理に大きな進歩を遂げていますが、特に長いCOTシーケンスでは、計算オーバーヘッドに関して課題に直面しています。これは、推論の遅延とメモリの要件に直接影響します。

Since LLM decoding is autoregressive in nature, as CoT sequences grow longer, there is a proportional increase in processing time and memory usage in attention layers where computational costs scale quadratically. Striking a balance between maintaining reasoning accuracy and computational efficiency has become a critical challenge, as attempts to reduce reasoning steps often compromise the model’s problem-solving capabilities.

LLMデコードは本質的に自己回帰的であるため、COTシーケンスが長くなるにつれて、計算コストが二次的にスケーリングされる注意層の処理時間とメモリ使用量が比例して増加します。推論の正確性を維持することと計算効率を維持することとのバランスをとることが重要な課題になります。これは、推論ステップを減らす試みがモデルの問題解決機能を妥協することが多いためです。

To address the computational challenges of Chain-of-Thought (CoT) reasoning, various methodologies have been developed. Some approaches focus on streamlining the reasoning process by simplifying or skipping certain thinking steps, while others attempt to generate steps in parallel. A different strategy involves compressing reasoning steps into continuous latent representations, enabling LLMs to reason without generating explicit word tokens.

チェーンオブ考え(COT)の推論の計算上の課題に対処するために、さまざまな方法論が開発されています。一部のアプローチは、特定の思考ステップを簡素化またはスキップすることにより、推論プロセスの合理化に焦点を当てていますが、他のアプローチは並行してステップを生成しようとします。別の戦略には、推論ステップを連続的な潜在表現に圧縮し、LLMが明示的な単語トークンを生成せずに推論できるようにします。

Moreover, prompt compression techniques to handle complex instructions and long-context inputs more efficiently range from using lightweight language models to generate concise prompts, employing implicit continuous tokens for task representation, and implementing direct compression by filtering for high-informative tokens.

さらに、複雑な命令と長いコンテキスト入力を処理するプロンプト圧縮技術は、軽量言語モデルを使用して簡潔なプロンプトを生成し、タスク表現に暗黙の連続トークンを使用し、高情報のトークンのためにフィルタリングして直接圧縮を実装することから、より効率的に範囲に及びます。

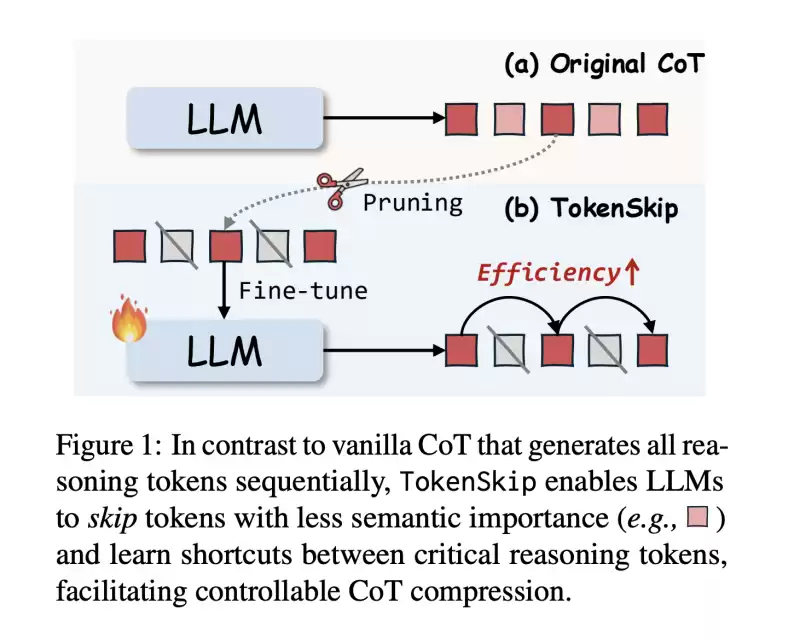

In this work, researchers from The Hong Kong Polytechnic University and the University of Science and Technology of China propose TokenSkip, an approach to optimize CoT processing in LLMs. It enables models to skip less important tokens within CoT sequences while maintaining connections between critical reasoning tokens, with adjustable compression ratios.

この作業では、香港ポリテクニック大学と中国科学技術大学の研究者は、LLMSのCOT処理を最適化するアプローチであるTokenskipを提案しています。これにより、モデルは、COTシーケンス内の重要性の低いトークンをスキップしながら、調整可能な圧縮比を使用して、重要な推論トークン間の接続を維持します。

The system works by first constructing compressed CoT training data through token pruning, followed by a supervised fine-tuning process. Initial testing across multiple models, including LLaMA-3.1-8B-Instruct and Qwen2.5-Instruct series shows promising results, particularly in maintaining reasoning capabilities while significantly reducing computational overhead.

このシステムは、トークンプルーニングを通じて最初に圧縮COTトレーニングデータを構築し、監視された微調整プロセスを使用することで機能します。 LLAMA-3.1-8B-InstructやQWEN2.5-Instructシリーズを含む複数のモデルにわたる初期テストは、特に推論能力を維持しながら計算オーバーヘッドを大幅に削減する際に有望な結果を示しています。

The architecture of TokenSkip is built on the fundamental principle that different reasoning tokens contribute varying levels of importance to reaching the final answer. It consists of two main phases: training data preparation and inference.

Tokenskipのアーキテクチャは、さまざまな推論トークンが最終答えに到達するためにさまざまな重要性のレベルに寄与するという基本原則に基づいて構築されています。これは、データの準備と推論のトレーニングという2つの主要なフェーズで構成されています。

During the training phase, the system generates CoT trajectories using the target LLM, and each remaining trajectory is pruned with a randomly selected compression ratio. The token pruning process is guided by an “importance scoring” mechanism, which assigns higher scores to tokens that are more critical for the final answer.

トレーニング段階では、システムはターゲットLLMを使用してCOT軌道を生成し、残りの各軌道はランダムに選択された圧縮率で剪定されます。トークン剪定プロセスは、最終的な答えにもっと重要なトークンに高いスコアを割り当てる「重要なスコアリング」メカニズムによって導かれます。

At inference time, TokenSkip maintains the autoregressive decoding approach but enhances efficiency by enabling LLMs to skip less important tokens. The structure of the input format is such that the question and compression ratio get separated by end-of-sequence tokens.

推論の時期に、Tokenskipは自己回帰デコードアプローチを維持しますが、LLMがそれほど重要ではないトークンをスキップできるようにすることで効率を向上させます。入力形式の構造は、問題と圧縮比が終了トークンによって分離されるようなものです。

The results show that larger language models are more capable of maintaining performance while achieving higher compression rates. The Qwen2.5-14B-Instruct model achieves remarkable results with only a 0.4% performance drop while reducing token usage by 40%.

結果は、より大きな言語モデルがより高い圧縮速度を達成しながら、パフォーマンスを維持できることを示しています。 QWEN2.5-14B-Instructモデルは、トークンの使用量を40%削減しながら、パフォーマンスが0.4%のパフォーマンス低下しかなく、顕著な結果を達成します。

When compared with alternative approaches like prompt-based reduction and truncation, TokenSkip shows superior performance. While prompt-based reduction fails to achieve target compression ratios and truncation leads to significant performance degradation, TokenSkip maintains the specified compression ratio while preserving reasoning capabilities. On the MATH-500 dataset, it achieves a 30% reduction in token usage with less than a 4% performance drop.

迅速な削減や切り捨てなどの代替アプローチと比較すると、Tokenskipは優れたパフォーマンスを示します。迅速な削減はターゲット圧縮比を達成できず、切り捨てはパフォーマンスの大幅な低下につながりますが、Tokenskipは推論能力を維持しながら、指定された圧縮率を維持します。 Math-500データセットでは、パフォーマンスが4%未満でトークン使用量が30%減少します。

In this paper, researchers introduce TokenSkip, a method that represents a significant advancement in optimizing CoT processing for LLMs by introducing a controllable compression mechanism based on token importance. The success of the method lies in maintaining reasoning accuracy while significantly reducing computational overhead by selectively preserving critical tokens and skipping less important ones. The approach has proven effective with LLMs, showing minimal performance degradation even at substantial compression ratios.

この論文では、研究者はTokenskipを導入します。これは、トークンの重要性に基づいた制御可能な圧縮機構を導入することにより、LLMSのCOT処理を最適化する際の重要な進歩を表す方法です。この方法の成功は、推論の正確性を維持しながら、重要なトークンを選択的に保存し、それほど重要でないトークンをスキップすることにより、計算オーバーヘッドを大幅に削減することにあります。このアプローチはLLMSで効果的であることが証明されており、実質的な圧縮比でもパフォーマンスの低下を最小限に抑えています。

This research opens new possibilities for advancing efficient reasoning in LLMs, establishing a foundation for future developments in computational efficiency while maintaining robust reasoning capabilities.

この研究は、LLMSで効率的な推論を進めるための新しい可能性を開き、堅牢な推論能力を維持しながら、計算効率の将来の開発の基盤を確立します。

Check out the Paper. All credit for this research goes to the researchers of this project. Also, feel free to follow us on Twitter and don’t forget to join our 75k+ ML SubReddit.

論文をチェックしてください。この研究のすべてのクレジットは、このプロジェクトの研究者に送られます。また、Twitterでお気軽にフォローしてください。75K+ ML SubredDitに参加することを忘れないでください。

免責事項:info@kdj.com

提供される情報は取引に関するアドバイスではありません。 kdj.com は、この記事で提供される情報に基づいて行われた投資に対して一切の責任を負いません。暗号通貨は変動性が高いため、十分な調査を行った上で慎重に投資することを強くお勧めします。

このウェブサイトで使用されているコンテンツが著作権を侵害していると思われる場合は、直ちに当社 (info@kdj.com) までご連絡ください。速やかに削除させていただきます。

-

-

-

-

-

- 暗号通貨市場は、ボラティリティの高まりを経験しています

- 2025-04-04 16:40:12

- 暗号通貨市場は、特にトランプ大統領が宣言した最近の貿易関税に続いて、ボラティリティの高まりを経験しています。

-

-

-

-