|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

LLM(대형 언어 모델)은 CoT(사고 사슬)와 같은 방법을 사용하여 복잡한 문제를 관리 가능한 단계로 분류함으로써 추론 작업에서 상당한 잠재력을 보여주었습니다. 그러나 이 기능에는 문제가 따릅니다. CoT 프롬프트는 종종 토큰 사용량을 증가시켜 계산 비용과 에너지 소비를 증가시킵니다. 이러한 비효율성은 정밀도와 자원 효율성을 모두 요구하는 애플리케이션에서 문제가 됩니다. 현재 LLM은 불필요하게 긴 출력을 생성하는 경향이 있으며, 이는 항상 더 나은 정확도로 변환되지는 않지만 추가 비용을 발생시킵니다. 핵심 과제는 추론 성능과 리소스 효율성 사이의 균형을 찾는 것입니다.

A recent development in the field of artificial intelligence (AI) aims to address the excessive token usage and high computational costs associated with Chain-of-Thought (CoT) prompting methods for Large Language Models (LLMs). A team of researchers from Nanjing University, Rutgers University, and UMass Amherst have proposed a novel Token-Budget-Aware LLM Reasoning Framework to optimize token efficiency.

인공 지능(AI) 분야의 최근 개발은 LLM(대형 언어 모델)에 대한 CoT(사고 사슬) 프롬프트 방법과 관련된 과도한 토큰 사용 및 높은 계산 비용을 해결하는 것을 목표로 합니다. Nanjing University, Rutgers University 및 UMass Amherst의 연구원 팀은 토큰 효율성을 최적화하기 위해 새로운 토큰 예산 인식 LLM 추론 프레임워크를 제안했습니다.

The framework, named TALE (standing for Token-Budget-Aware LLM rEasoning), operates in two primary stages: budget estimation and token-budget-aware reasoning. Initially, TALE employs techniques like zero-shot prediction or regression-based estimators to assess the complexity of a reasoning task and derive an appropriate token budget. This budget is then seamlessly integrated into the CoT prompt, guiding the LLM to generate concise yet accurate responses.

TALE(Token-Budget-Aware LLM rEasoning의 약자)라는 프레임워크는 예산 추정과 토큰 예산 인식 추론이라는 두 가지 기본 단계로 작동합니다. 처음에 TALE은 제로샷 예측이나 회귀 기반 추정기와 같은 기술을 사용하여 추론 작업의 복잡성을 평가하고 적절한 토큰 예산을 도출합니다. 그런 다음 이 예산은 CoT 프롬프트에 완벽하게 통합되어 LLM이 간결하면서도 정확한 응답을 생성하도록 안내합니다.

A key innovation within TALE is the concept of “Token Elasticity,” which identifies an optimal range of token budgets that minimizes token usage while preserving accuracy. By leveraging iterative search techniques like binary search, TALE can pinpoint the optimal budget for various tasks and LLM architectures. On average, the framework achieves a remarkable 68.64% reduction in token usage with less than a 5% decrease in accuracy, highlighting its effectiveness and practicality for token efficiency.

TALE의 주요 혁신은 정확성을 유지하면서 토큰 사용을 최소화하는 최적의 토큰 예산 범위를 식별하는 "토큰 탄력성" 개념입니다. TALE은 이진 검색과 같은 반복 검색 기술을 활용하여 다양한 작업 및 LLM 아키텍처에 대한 최적의 예산을 정확히 찾아낼 수 있습니다. 평균적으로 프레임워크는 정확도가 5% 미만으로 감소하면서 토큰 사용량이 68.64%라는 놀라운 감소를 달성하여 토큰 효율성에 대한 효과성과 실용성을 강조합니다.

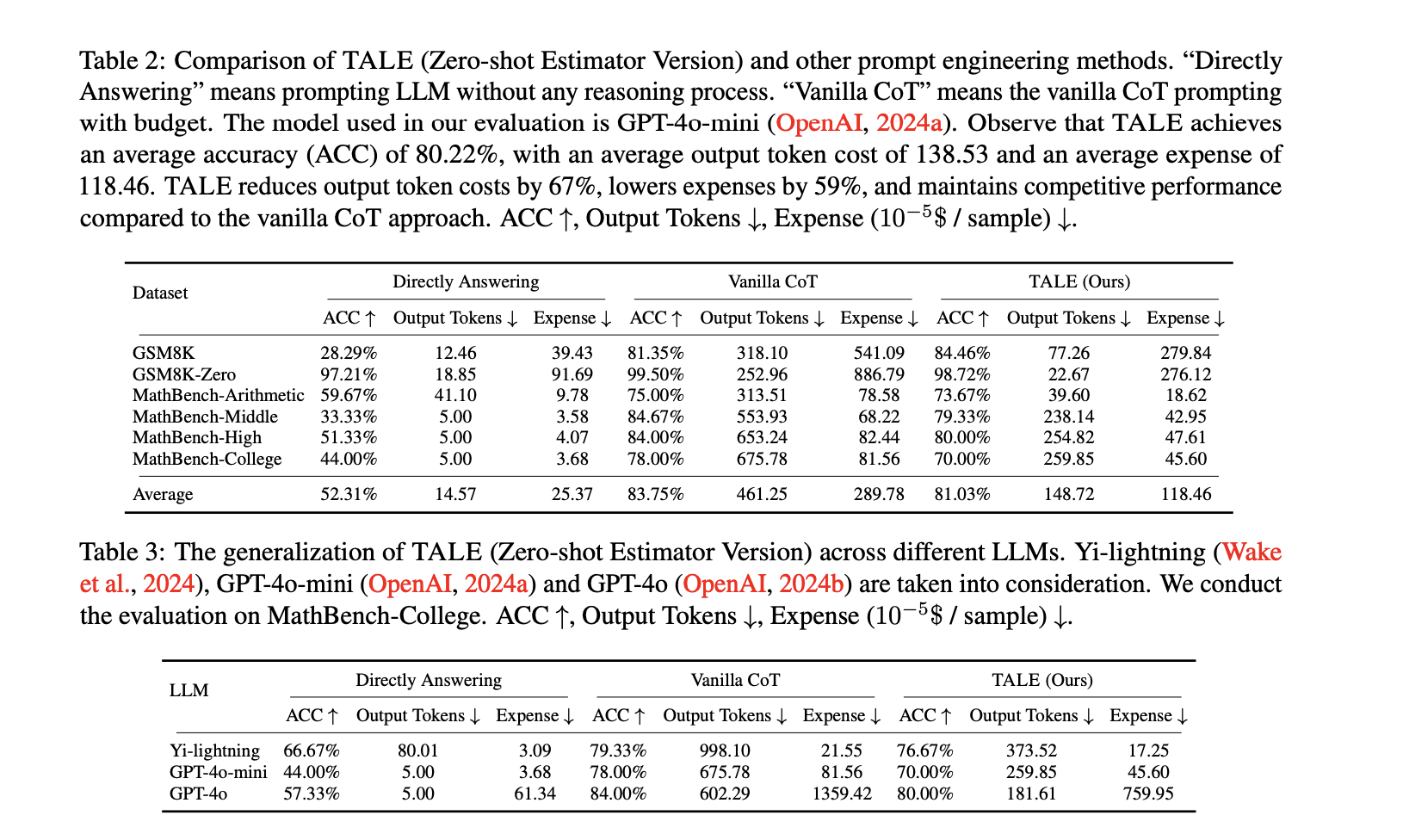

Experiments conducted on standard benchmarks, such as GSM8K and MathBench, showcase TALE's broad applicability and efficiency gains. For instance, on the GSM8K dataset, TALE achieved an impressive 84.46% accuracy, surpassing the Vanilla CoT method while simultaneously reducing token costs from 318.10 to 77.26 on average. When applied to the GSM8K-Zero setting, TALE achieved a stunning 91% reduction in token costs, all while maintaining an accuracy of 98.72%.

GSM8K 및 MathBench와 같은 표준 벤치마크에서 수행된 실험은 TALE의 광범위한 적용 가능성과 효율성 향상을 보여줍니다. 예를 들어, GSM8K 데이터세트에서 TALE은 바닐라 CoT 방법을 능가하는 84.46%의 인상적인 정확도를 달성하는 동시에 토큰 비용을 평균 318.10에서 77.26으로 줄였습니다. GSM8K-Zero 설정에 적용했을 때 TALE은 98.72%의 정확도를 유지하면서 토큰 비용을 91%나 절감했습니다.

Furthermore, TALE demonstrates strong generalizability across different LLMs, including GPT-4o-mini and Yi-lightning. When employed on the MathBench-College dataset, TALE achieved reductions in token costs of up to 70% while maintaining competitive accuracy. Notably, the framework also leads to significant reductions in operational expenses, cutting costs by 59% on average compared to Vanilla CoT. These results underscore TALE's capability to enhance efficiency without sacrificing performance, making it suitable for a diverse range of applications.

또한 TALE은 GPT-4o-mini 및 Yi-lightning을 포함한 다양한 LLM에 걸쳐 강력한 일반화 가능성을 보여줍니다. MathBench-College 데이터 세트에 사용했을 때 TALE는 경쟁력 있는 정확성을 유지하면서 토큰 비용을 최대 70% 절감했습니다. 특히, 이 프레임워크는 바닐라 CoT에 비해 평균 59% 비용을 절감해 운영 비용도 크게 절감합니다. 이러한 결과는 성능 저하 없이 효율성을 향상시키는 TALE의 능력을 강조하여 다양한 응용 분야에 적합하게 만듭니다.

In conclusion, the Token-Budget-Aware LLM Reasoning Framework offers a practical solution to the inefficiency of token usage in reasoning tasks. By dynamically estimating and applying token budgets, TALE strikes a crucial balance between accuracy and cost-effectiveness. This approach ultimately reduces computational expenses and broadens the accessibility of advanced LLM capabilities. As AI continues to rapidly evolve, frameworks like TALE pave the way for more efficient and sustainable use of LLMs in both academic and industrial settings.

결론적으로 토큰 예산 인식 LLM 추론 프레임워크는 추론 작업에서 토큰 사용의 비효율성에 대한 실용적인 솔루션을 제공합니다. TALE은 토큰 예산을 동적으로 추정하고 적용함으로써 정확성과 비용 효율성 사이의 중요한 균형을 유지합니다. 이 접근 방식은 궁극적으로 계산 비용을 줄이고 고급 LLM 기능에 대한 접근성을 확대합니다. AI가 계속 빠르게 발전함에 따라 TALE과 같은 프레임워크는 학술 및 산업 환경 모두에서 LLM을 보다 효율적이고 지속 가능하게 사용할 수 있는 길을 열어줍니다.

부인 성명:info@kdj.com

제공된 정보는 거래 조언이 아닙니다. kdj.com은 이 기사에 제공된 정보를 기반으로 이루어진 투자에 대해 어떠한 책임도 지지 않습니다. 암호화폐는 변동성이 매우 높으므로 철저한 조사 후 신중하게 투자하는 것이 좋습니다!

본 웹사이트에 사용된 내용이 귀하의 저작권을 침해한다고 판단되는 경우, 즉시 당사(info@kdj.com)로 연락주시면 즉시 삭제하도록 하겠습니다.