|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

大規模言語モデル (LLM) は、思考連鎖 (CoT) などの手法を使用して、複雑な問題を管理可能なステップに分解することで、推論タスクにおいて大きな可能性を示しています。ただし、この機能には課題も伴います。 CoT プロンプトは多くの場合、トークンの使用量を増加させ、計算コストとエネルギー消費の増加につながります。この非効率性は、精度とリソース効率の両方を必要とするアプリケーションにとって懸念事項です。現在の LLM は不必要に長い出力を生成する傾向があり、必ずしも精度が向上するとは限りませんが、追加コストが発生します。主な課題は、推論のパフォーマンスとリソース効率のバランスを見つけることです。

A recent development in the field of artificial intelligence (AI) aims to address the excessive token usage and high computational costs associated with Chain-of-Thought (CoT) prompting methods for Large Language Models (LLMs). A team of researchers from Nanjing University, Rutgers University, and UMass Amherst have proposed a novel Token-Budget-Aware LLM Reasoning Framework to optimize token efficiency.

人工知能 (AI) 分野の最近の開発は、大規模言語モデル (LLM) の思考連鎖 (CoT) プロンプト手法に関連する過剰なトークンの使用と高い計算コストに対処することを目的としています。南京大学、ラトガース大学、マサチューセッツ州アマースト校の研究者チームは、トークン効率を最適化するための新しいトークン予算認識 LLM 推論フレームワークを提案しました。

The framework, named TALE (standing for Token-Budget-Aware LLM rEasoning), operates in two primary stages: budget estimation and token-budget-aware reasoning. Initially, TALE employs techniques like zero-shot prediction or regression-based estimators to assess the complexity of a reasoning task and derive an appropriate token budget. This budget is then seamlessly integrated into the CoT prompt, guiding the LLM to generate concise yet accurate responses.

TALE (Token-Budget-Aware LLM rEasoning の略) と名付けられたこのフレームワークは、予算見積もりとトークン予算認識推論という 2 つの主要な段階で動作します。 TALE は当初、ゼロショット予測や回帰ベースの推定器などの手法を使用して、推論タスクの複雑さを評価し、適切なトークン バジェットを導き出します。このバジェットは CoT プロンプトにシームレスに統合され、LLM が簡潔かつ正確な応答を生成するように導きます。

A key innovation within TALE is the concept of “Token Elasticity,” which identifies an optimal range of token budgets that minimizes token usage while preserving accuracy. By leveraging iterative search techniques like binary search, TALE can pinpoint the optimal budget for various tasks and LLM architectures. On average, the framework achieves a remarkable 68.64% reduction in token usage with less than a 5% decrease in accuracy, highlighting its effectiveness and practicality for token efficiency.

TALE の主要な革新は、精度を維持しながらトークンの使用量を最小限に抑える最適なトークン バジェットの範囲を特定する「トークンの弾力性」の概念です。 TALE は、バイナリ検索などの反復検索手法を活用することで、さまざまなタスクや LLM アーキテクチャに最適な予算を正確に特定できます。平均して、このフレームワークは、精度の低下が 5% 未満で、トークン使用量が 68.64% という驚くべき削減を達成しており、トークン効率の有効性と実用性が強調されています。

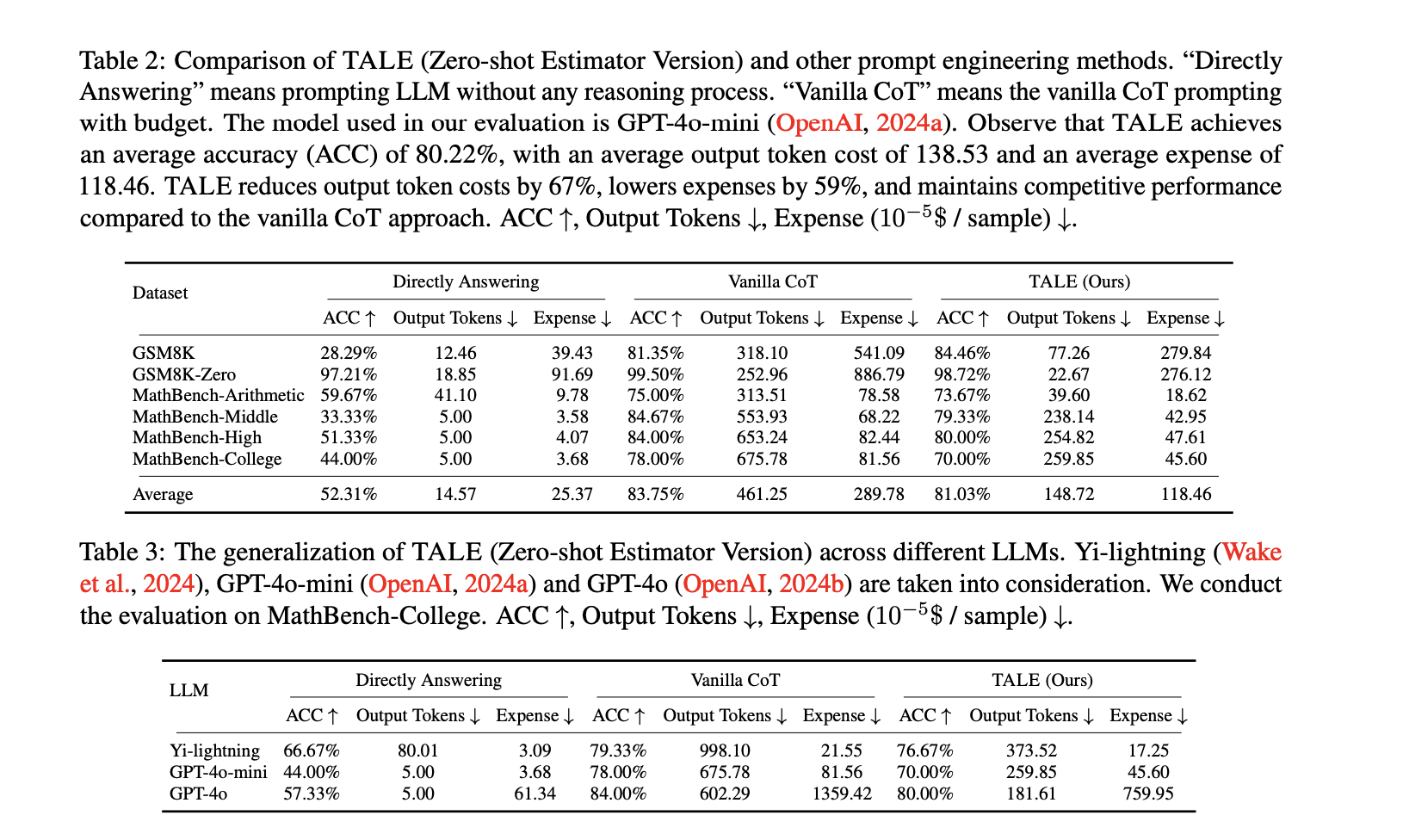

Experiments conducted on standard benchmarks, such as GSM8K and MathBench, showcase TALE's broad applicability and efficiency gains. For instance, on the GSM8K dataset, TALE achieved an impressive 84.46% accuracy, surpassing the Vanilla CoT method while simultaneously reducing token costs from 318.10 to 77.26 on average. When applied to the GSM8K-Zero setting, TALE achieved a stunning 91% reduction in token costs, all while maintaining an accuracy of 98.72%.

GSM8K や MathBench などの標準ベンチマークで行われた実験では、TALE の幅広い適用性と効率の向上が実証されています。たとえば、GSM8K データセットでは、TALE は 84.46% という驚異的な精度を達成し、Vanilla CoT メソッドを上回り、同時にトークン コストを平均 318.10 から 77.26 に削減しました。 GSM8K-Zero 設定に適用すると、TALE は 98.72% の精度を維持しながら、トークン コストの 91% という驚くべき削減を達成しました。

Furthermore, TALE demonstrates strong generalizability across different LLMs, including GPT-4o-mini and Yi-lightning. When employed on the MathBench-College dataset, TALE achieved reductions in token costs of up to 70% while maintaining competitive accuracy. Notably, the framework also leads to significant reductions in operational expenses, cutting costs by 59% on average compared to Vanilla CoT. These results underscore TALE's capability to enhance efficiency without sacrificing performance, making it suitable for a diverse range of applications.

さらに、TALE は、GPT-4o-mini や Yi-lightning など、さまざまな LLM にわたって強力な汎用性を示します。 MathBench-College データセットで採用された場合、TALE は競争力のある精度を維持しながら、トークン コストの最大 70% の削減を達成しました。特に、このフレームワークは運用コストの大幅な削減にもつながり、Vanilla CoT と比較して平均 59% コストが削減されます。これらの結果は、TALE がパフォーマンスを犠牲にすることなく効率を向上させ、さまざまな用途に適していることを強調しています。

In conclusion, the Token-Budget-Aware LLM Reasoning Framework offers a practical solution to the inefficiency of token usage in reasoning tasks. By dynamically estimating and applying token budgets, TALE strikes a crucial balance between accuracy and cost-effectiveness. This approach ultimately reduces computational expenses and broadens the accessibility of advanced LLM capabilities. As AI continues to rapidly evolve, frameworks like TALE pave the way for more efficient and sustainable use of LLMs in both academic and industrial settings.

結論として、Token-Budget-Aware LLM Reasoning Framework は、推論タスクにおけるトークン使用の非効率性に対する実用的な解決策を提供します。 TALE は、トークンの予算を動的に見積もり、適用することにより、精度と費用対効果の間で重要なバランスをとります。このアプローチにより、最終的に計算コストが削減され、高度な LLM 機能の利用可能性が広がります。 AI が急速に進化し続ける中、TALE のようなフレームワークは、学術環境と産業環境の両方で LLM をより効率的かつ持続的に使用する道を切り開きます。

免責事項:info@kdj.com

提供される情報は取引に関するアドバイスではありません。 kdj.com は、この記事で提供される情報に基づいて行われた投資に対して一切の責任を負いません。暗号通貨は変動性が高いため、十分な調査を行った上で慎重に投資することを強くお勧めします。

このウェブサイトで使用されているコンテンツが著作権を侵害していると思われる場合は、直ちに当社 (info@kdj.com) までご連絡ください。速やかに削除させていただきます。

![取引は、[ビデオのレビュー]ゴールドビットコイン原油注文に従うことです。 取引は、[ビデオのレビュー]ゴールドビットコイン原油注文に従うことです。](/uploads/2025/04/26/cryptocurrencies-news/videos/trading-follow-review-video-gold-bitcoin-crude-oil-profits/image-1.webp)